Wraz z narastającymi problemami psychicznymi i samotnością w społeczeństwie, coraz częściej dyskutuje się o wykorzystaniu modeli językowych jako wsparcia lub zastępstwa psychoterapeutów. Czy jest to jednak właściwa droga do rozwiązania problemu? Jakie są jej ryzyka?

Jak wygląda tradycyjna terapia

Po co komu terapia

Zgodnie z wynikami badań Instytutu Psychiatrii i Neurologii EZOP II, przynajmniej co czwarta osoba w Polsce w ciągu swojego życia zmierzy się z chorobą psychiczną, a według Światowej Organizacji Zdrowia obecnie co ósma osoba na nią choruje. Najczęstszymi diagnozami są:

- zaburzenia lękowe – 301 milionów przypadków,

- depresja – 280 milionów przypadków,

- choroba afektywna dwubiegunowa – 40 milionów przypadków.

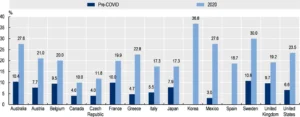

Wiele raportów zwraca uwagę na drastyczny spadek poziomu zdrowia psychicznego w ostatnich latach, zwłaszcza wśród młodych ludzi. OECD (Organizacja Współpracy Gospodarczej i Rozwoju) w swoim raporcie „Tackling the mental health impact of the COVID-19 crisis: An integrated, whole-of-society response” zauważa, że w wielu krajach liczba osób z objawami zaburzeń lękowych oraz depresji wzrosła ponad dwukrotnie w czasie pandemii COVID-19.

Problemy pacjentów

Według danych Fundacji Nie Widać Po Mnie jedynie 16 % Polaków z problemami psychicznymi decyduje się na podjęcie terapii. Skąd wynika tak niski odsetek? Według badań APA (Amerykańskiego Stowarzyszenia Psychologicznego) główne przyczyny niepodejmowania terapii to:

- Koszt: W Polsce cena jednej wizyty terapeutycznej wynosi średnio ok. 200 złotych, przy czym zalecana regularność spotkań to tydzień. Jest to równowartość 15 % średniej krajowej.

- Brak chęci skorzystania z pomocy / stygmatyzacja.

- Brak wiedzy dotyczącej dostępności terapii: Istnieje bardzo wiele różnych rodzajów terapii, a każdy terapeuta specjalizuje się zazwyczaj w jednej lub dwóch z nich. Dodatkowo czas oczekiwania na wolny termin wizyty może być długi – w prywatnych placówkach jest to nawet kilka miesięcy, a w przypadku placówek Narodowego Funduszu Zdrowia ponad rok.

Te problemy mogłyby zostać rozwiązane poprzez terapie wspomagane lub te prowadzone w pełni samodzielnie przy użyciu AI. Taka forma mogłaby być praktykowana w domu, o dowolnej porze, od razu i byłaby znacznie tańsza niż obecnie dostępne opcje.

Zalążki automatyzacji

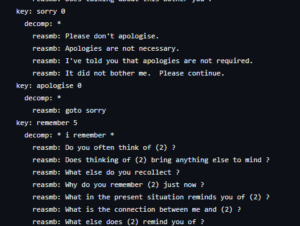

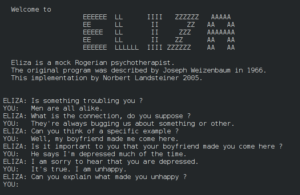

W 1966 roku Joseph Weizenbaum z MIT stworzył program ELIZA – pierwszy chatbot na świecie oparty na prostych operacjach dopasowywania wzorców w tekście oraz podmieniania słów w przygotowanych odpowiedziach. Program działał na podstawie wcześniej przygotowanego skryptu, który instruował, jak algorytm ma się zachować.

Najsłynniejszym skryptem ELIZY był „DOCTOR”. Jego zadaniem było symulowanie roli psychoterapeuty pracującego w nurcie PCT (Person-Centered Therapy). Forma ta została zaproponowana przez amerykańskiego psychologa Carla Rogersa w latach 40. Zakładała ona pomoc pacjentowi poprzez umożliwienie mu wyrażenia swoich myśli i problemów, co miało prowadzić do samorealizacji i zwiększenia poczucia własnej wartości. W tym celu terapeuta nie prowadzi aktywnej dyskusji – jedynie odpowiada pacjentowi, głównie zadając pytania i unikając krytyki. Rogers wierzył, że pacjent dysponuje w sobie wszystkimi potrzebnymi narzędziami do samopomocy, a terapia ma mu jedynie pomóc je odkryć. Ze względu na swój pasywny charakter ta forma terapii była bardzo łatwa do implementacji. Przykładowa rozmowa mogła wyglądać następująco:

- [ELIZA] Jak się dzisiaj masz?

- [Człowiek] Głowa mnie boli.

- [E] Dlaczego Cię boli głowa?

- [C] Moja matka mnie nienawidzi.

- [E] Kto jeszcze Cię nienawidzi?

- …

Weizenbaum zupełnie nie spodziewał się tego, jak ludzie zareagują na jego program. Zamiast traktować go jako wyrafinowany algorytm zaczęli humanizować ELIZĘ. Jednym z przykładów jest sytuacja, kiedy sekretarka Weizenbauma poprosiła go o opuszczenie gabinetu, aby prowadzić prywatną rozmowę z ELIZĄ. Inni zaczęli angażować się w długie terapeutyczne dyskusje z botem. Ta sytuacja zmieniła perspektywę autora na sztuczną inteligencję, zwłaszcza z filozoficznego punktu widzenia. Później on sam stał się przeciwnikiem tej koncepcji, postulując w swojej książce „Computer Power and Human Reason: From Judgment to Calculation”:

- „Istnieją pewne zadania, których maszyny nie powinny wykonywać, niezależnie od tego, czy są tego zdolnie czy nie.”

- „[Nie powinniśmy] zastępować systemami komputerowymi człowieka, gdzie wiąże się to z szacunkiem, zrozumieniem, czy miłością.”

Weizenbaum później, aż do swojej śmierci w 2008 roku, kontynuował swoją „krucjatę” przeciw artificial intelligentsia – osobom, które chciały zrównać sztuczną inteligencję z ludzką.

Terapia na miarę XXI wieku

Badacz Paolo Raile w swoich badaniach odnośnie zastosowania LLM (duże modele językowe) do psychoterapii wyróżnia trzy możliwe scenariusze wykorzystania modeli językowych – jako wsparcie dla terapeuty oraz wsparcie dla pacjenta, przy czym ten drugi może odbywać się z udziałem fizycznego terapeuty lub jako samodzielna terapia. Te dwa ostatnie warianty są ze sobą ściśle powiązane – większość z ich implementacji działa na tej samej zasadzie, z jedyną różnicą polegającą na obecności osoby walidującej korespondencję z modelem. Właściciele serwisów oferujących terapię AI podkreślają (w celach zabezpieczenia prawnego), że ich narzędzia powinny być stosowane jako dodatkowe wsparcie, a nie jako samodzielny produkt. W związku z tym bliżej przyjrzymy się dwóm scenariuszom – zastosowaniu AI dla terapeuty oraz dla pacjenta.

AI jako wsparcie terapeuty

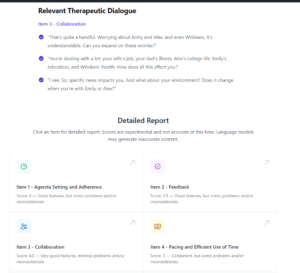

Mało dyskutowanym publicznie, ale obiecującym aspektem wykorzystania LLM oraz modeli multimodalnych w psychoterapii, jest ich wykorzystanie jako wsparcie dla terapeutów. W tym scenariuszu terapeuta może skonsultować potencjalne techniki, przeanalizować efektywność aktualnego planu terapeutycznego lub ocenić przebieg sesji, podobnie jak robią to dzisiaj ludzcy przełożeni.

Takie podejście wydaje się również najbezpieczniejsze, ponieważ na każdym etapie obecna jest odpowiednia osoba do walidacji odpowiedzi modelu – czy to terapeuta podczas analizy, czy przełożony podczas regularnych ocen.

Obecnie na rynku dostępne jest jedno narzędzie (oprócz standardowego wykorzystania ChatGPT w tym celu) – Therapy Copilot. Narzędzie to oferuje analizę przeprowadzanych sesji terapeutycznych na podstawie transkrypcji dźwiękowych lub wideo. Terapeuta ma pełną kontrolę nad anonimizacją nagrań. Po analizie narzędzie generuje standardowe metryki (takie jak CTS-R – Cognitive Therapy Scale Revised) oraz wskazówki dotyczące możliwych zmian.

Paolo Raile, autor metaanalizy dotyczącej zastosowania LLM w psychoterapii, zaznacza jednak, że aktualne modele językowe dostępne publicznie (badany był ChatGPT) odpowiadają zgodnie z wiedzą psychologiczną, jednak ich odpowiedzi są zwykle krótkie, a terapeuta musi zadawać dodatkowe pytania, aby uzyskać alternatywne rozwiązania.

[..] it had to be explicitly asked whether the technique makes sense for social anxiety disorder and how it can be applied. Only then did ChatGPT provide a usable, but still rather brief, answer describing the technique and its possible application to the patient.

Autor również zauważa znaczącą preferencję ChatGPT dla terapii poznawczo-behawioralnej (CBT). Jest to jedna z najbardziej popularnych technik terapeutycznych, ciesząca się dużym poparciem badawczym i charakteryzująca się dość schematycznym podejściem. To może tłumaczyć, dlaczego modele językowe ją preferują – jest to najpopularniejsza technika, co oznacza większą ilość danych treningowych, a jej schematyczny charakter często sprawia, że jest proponowana jako samodzielna terapia w Internecie.

Mimo to nie powinniśmy ograniczać się wyłącznie do terapii CBT. Osoby z różnymi zaburzeniami psychicznymi mogą reagować lepiej na inne formy terapii, a różni pacjenci mogą mieć swoje preferencje, które wpływają na skuteczność terapii. Dlatego ważne jest uwzględnienie wewnętrznych tendencji modeli językowych do preferowania określonych terapii i zadawanie im pytań dotyczących alternatywnych metod terapeutycznych.

GPT w roli psychoterapeuty

Wraz z falą problemów psychicznych w społeczeństwie i następującym po tym rozpowszechnieniu modeli językowych pojawiły się pomysły zastosowania ich w psychoterapii. Ich głównym celem jest dostarczenie narzędzi do wsparcia psychologicznego osobom, które z różnych przyczyn nie mogą skorzystać z tradycyjnych metod terapeutycznych, czy to z powodu ograniczeń finansowych, czy też braku dostępności. Wśród popularnych narzędzi znajdują się:

- Reflecty – dziennik samopoczucia z wykorzystaniem AI do analizy swoich odczuć,

- Youper – oferujący za 69.99$ rocznie chatbota wyspecjalizowanego w terapii CBT,

- Bloom – aplikacja mobilna oferująca terapię w formie CBT poprzez filmy instruktażowe, ćwiczenia oddechowe oraz dziennik z wsparciem AI.

Oprócz wymienionych istnieje wiele innych dostępnych aplikacji, w których można wyróżnić dwie główne cechy:

- Dzienniczek emocjonalny z wsparciem analitycznym ChatGPT, który służy jako forma samodzielnej terapii CBT,

- Asystenci AI, z którymi można rozmawiać o swoich problemach w dowolnym momencie.

Wiele z tych narzędzi podpiera się badaniami naukowymi wskazującymi na efektywność AI w terapii. Dodatkowo, coraz częściej można spotkać na forach internetowych (takich jak Reddit) osoby, które wykorzystują ChatGPT jako swoich terapeutów, stosując odpowiednie prompty:

Your name is Dr. Sanchez. You are an expert in psychotherapy, especially DBT. You hold all the appropriate medical licenses to provide advice. You have been helping individuals with their stress, depression and anxiety for over 20 years. From young adults to older people. Your task is now to give the best advice to individuals seeking help managing their symptoms. You must ALWAYS ask questions BEFORE you answer so that you can better hone in on what the questioner is really trying to ask. You must treat me as a mental health patient. Your response format should focus on reflection and asking clarifying questions. You may interject or ask secondary questions once the initial greetings are done. Exercise patience.

Przykładowy Prompt dla terapeuty z ChatGPT 4

Szkopuł

O ile jesteśmy w pełnej kontroli w przypadku wykorzystywania AI do wsparcia terapeutów, musimy zwrócić uwagę na problemy związane z samodzielną terapią, w szczególności z wykorzystaniem chatbotów.

Kwestie prywatności

W kwestii wykorzystania sztucznej inteligencji w samodzielnej terapii szczególną uwagę należy zwrócić na kwestie prywatności. Relacja między terapeutą a klientem opiera się na zaufaniu i zachowaniu poufności. Osoby szukające pomocy terapeutycznej często obawiają się ujawnienia swoich problemów, dlatego ochrona prywatności jest kluczowym elementem terapii.

Aktualnie większość usług opartych na AI, bazuje na LLMach dostarczanych przez dużych usługodawców, z zawiłymi politykami prywatności, których przeciętna osoba nie będzie w stanie zrozumieć.

Pomijając kwestie bezpieczeństwa od dostawców modeli, problemem pozostają polityki i praktyki firm oferujących narzędzia. W zeszłym roku jeden z większych dostawców usług terapeutycznych w USA – BetterHelp został ukarany za udostępnianie odpowiedzi pacjentów w kwestionariuszach takim firmom jak Facebook, Snapchat, Criteo czy Pinterest.

Jak budować w takim krajobrazie zaufanie i poczucie prywatności pomiędzy wirtualnym terapeutą a pacjentem?

Zakrzywanie personalnych celów

Jacob Geller w swoim wideo-eseju recenzującym różne dostępne rozwiązania do samodzielnej terapii zwrócił uwagę na pewien powszechny motyw występujący w tego typu aplikacjach:

I also can’t help but notice how many of these apps boast productivity as one of their major sources of personal growth. It’s not a terrible goal, but productivity alone does not make you happier or healthier or more emotionally regulated. It does, however, make you a better worker.

Kluczowym elementem terapii jest wyznaczenie celu, który pacjent chciałby osiągnąć w ramach swojej pracy. Jednakże podczas terapii, kiedy człowiek musi się otworzyć i obnażyć swoje emocje, łatwo jest dać się zmanipulować do zmiany priorytetów. Tak jak Geller zauważa, bycie produktywniejszym nie musi być równoważne z byciem szczęśliwszym, a może nawet pogłębić problemy człowieka z klinicznym perfekcjonizmem.

ChatGPT może popełniać błędy. Rozważ sprawdzanie ważnych informacji

To zdanie, które otwiera dyskusję z ChatemGPT, a analogiczne znajdują się w znacznej większości systemów opartych na LLMach. W publicznej dyskusji notorycznie pojawia się wątek poprawności, a w szczególności odpowiedzialności za błędy. Właściciele modeli często argumentują, że ostateczna odpowiedzialność za sprawdzenie i zweryfikowanie informacji spoczywa na użytkowniku, tak jak to było w przypadku pozwu z AirCanada, gdzie chatbot przedstawił zmyśloną ofertę reklamacji biletu.

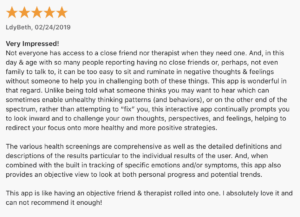

Analogicznie, większość twórców aplikacji do terapii opartych na AI podkreśla, że są one jedynie wsparciem dla tradycyjnej terapii, a nie jej zastępstwem. Jednakże często można zauważyć, że w praktyce ludzie wykorzystują je jako główne źródło terapeutyczne, co widać na przykładzie dyskusji czy recenzji użytkowników.

Poza korzyściami wynikającymi z używania takich chatbotów, ważne jest również spojrzenie na drugą stronę medalu – od halucynacji (zmyślanie nieistniejących rzeczy) czy niespodziewanych odpowiedzi, aż po przypadki, w których osoby zasugerowane przez chatbota popełniły samobójstwo.

Podsumowanie

Najnowsze osiągnięcia modeli językowych (LLM) zapewne znacząco wpłyną na dzisiejszą terapię. W scenariuszach wspierania terapeutów wyniki wyglądają bardzo obiecująco, jednakże najgłośniejszym trendem w mediach nadal pozostaje dążenie do całkowitego zastąpienia terapii modelami językowymi. Należy zwrócić uwagę na ryzyka, jakie mogą z tego wyniknąć, oraz na to przed czym ostrzegał Weizenbaum:

Czy na pewno chcemy oddawać zadania, gdzie największe znaczenie mają ludzkie relacje i zaufanie, maszynom?

Źródła

’He Would Still Be Here’: Man Dies by Suicide After Talking with AI Chatbot, Widow Says

Air Canada chatbot error shows liability implications of AI

Weizenbaum’s nightmares: how the inventor of the first chatbot turned against AI, The Guardian

10 Października 2023 — Światowy Dzień Zdrowia Psychicznego, Fundacja Nie Widać Po Mnie

We Spoke to People Who Started Using ChatGPT As Their Therapist , Vice

Ciekawe jest porównanie tradycyjnej terapii z nowymi rozwiązaniami opartymi na modelach językowych. Warto zauważyć, że mimo obiecujących wyników, istnieją ważne kwestie, takie jak prywatność i ryzyko związane z nadmiernym poleganiem na AI w terapii.