W dzisiejszym świecie granica pomiędzy rzeczywistością a światem wirtualnym zaciera się coraz bardziej. Co więcej, coraz trudniej zorientować się, czy to, na co patrzymy, to rzeczywistość, czy też wytwór komputerowej technologii. Deepfake oraz rosnące możliwości sztucznej inteligencji powodują, iż coraz łatwiej jest nas oszukać. Jak rozpoznać, czy to , na co patrzymy, to deepfake? Jak się przed nimi chronić? To pytania, na które warto znać odpowiedź.

Deepfake – co to takiego?

Nazwa deepfake pochodzi ze zlepku dwóch słów – deep (deep learning – metody uczenia maszynowego wykorzystujące sieci neuronowe do takich zastosowań, jak klasyfikacja tekstu czy generacja obrazów) oraz fake (z angielskiego „fałszywy”). Są to sztucznie wytworzone obrazy lub filmy, w których twarz, sylwetka bądź też głos osoby w nich występującej są zmienione. Proces nakładania twarzy na istniejącą na nagraniu, generacji ruchu oraz mowy dokonywany jest poprzez głębokie sieci neuronowe. Wytworzone w ten sposób materiały, jak np. film pornograficzny bądź nagie zdjęcia, na które nałożona została czyjaś twarz, są często bardzo trudne do odróżnienia od prawdziwych.

Jako, że często obraz jest wart więcej, niż tysiąc słów, intuicyjne zrozumienie, czym jest deepfake, najlepiej będzie osiągnąć poprzez przykłady:

- Twarz Nicolas-a Cage-a wkomponowana w ciało Davida Schwimmera, Ross-a z serialu Przyjaciele

Źródło: https://twitter.com/clapifyoulikeme/status/1092616907340029952

Dla osób niezaznajomionych bliżej z serialem, zdjęcie po prawej może nie budzić żadnych podejrzeń.

2. Filmy z „Tomem Cruisem” popularne na tik toku

Osoby nie mające pojęcia o obecnych możliwościach technologicznych bez mrugnięcia okiem mogłyby uznać, iż patrzą na prawdziwego Toma Cruise-a.

3. Występ „młodej Carrie Fisher” w filmie Star Wars Rouge One

Twarz została oczywiście zmodyfikowana cyfrowo. Reportaż odnośnie powstawania tych scen, jak również przywrócenia Moffa Tarkina możemy obejrzeć w tym filmie:

Technologie wykorzystywane przy tworzeniu deepfake

Deepfake może dotyczyć generowania twarzy, podmieniania twarzy, generowania video, generowania głosów i innych. Aby po krótce opisać jedno z narzędzi wykorzystywanych do ich tworzenia, skupimy się tylko na podmianie twarzy. W tym konkretnym przypadku tworzenia deepfake, bardzo często wykorzystywanym narzędziem jest enkoder- dekoder.

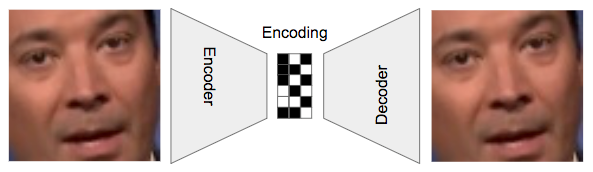

W dużym skrócie, enkoder-dekoder to głęboka sieć neuronowa, podzielona na dwie mniejsze. Jako całość, ma ona za zadanie nauczyć się kompresować zdjęcie do bardzo małej reprezentacji a następnie, na jej podstawie, generować pierwotne zdjęcie z powrotem. Pierwsza część sieci, czyli enkoder, stara się jak najlepiej zakodować zdjęcie w postaci najczęściej krótkiego wektora liczb. Przykładowo zdjęcie 640 na 640 pixeli enkodowane jest poprzez wektor 100 liczb. Druga część sieci, stara się nauczyć jak najlepiej generować pierwotne zdjęcie mając na wejściu jego zakodowaną reprezentację. Diagram przykładowej sieci:

Źródło: https://www.kdnuggets.com/2018/03/exploring-deepfakes.html/2

Za pomocą tego środkowego ograniczenia na wielkość zakodowanego wektora, staramy się nauczyć sieć generowania obrazu na podstawie ogólniejszych wzorów. Np. kilka pierwszych liczb tego wektora może mówić o tym, gdzie należy wygenerować oczy.

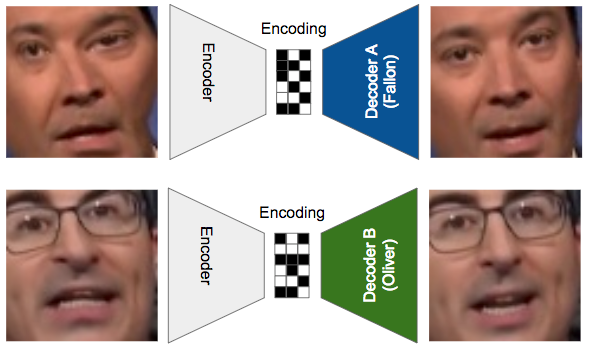

Do wygenerowania deepfake potrzebujemy dwóch takich sieci. Jedną z nich trenujemy na wielu obrazach z twarzą jednej osoby, a drugą na twarzach drugiej. Wśród zdjęć treningowych używamy także nieco zniekształconych i „zaszumionych” obrazów, dzięki czemu nauczymy naszą sieć radzić sobie także z pewnymi zniekształceniami – pomoże nam to w późniejszym etapie. W oby sieciach, pierwsza część, tj. enkoder, jest taka sama – mamy tym samym pewność, iż zakodowane reprezentacje wektorowe będą między sobą „kompatybilne”.

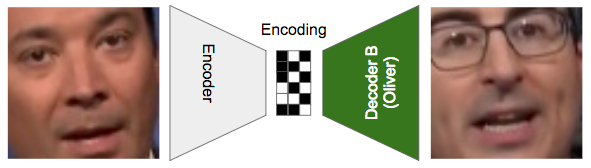

Po nauczeniu sieci, ostatnim krokiem jest zamiana dekoderów. W ten sposób, wrzucając na wejście jedną twarz, sieć będzie starała się „podmienić” twarz w taki sposób, aby przypominała twarz drugiej osoby, na której była uczona. Wykonując do przykładowo dla wielu klatek filmu, możemy stworzyć film z twarzą innej osoby.

Oczywiście cała procedura nie jest tak prosta, jak może się wydawać. Aby uzyskać dobrej jakości wyniki, potrzebujemy dużego zbioru zdjęć obu osób, odpowiednio głęboką sieć neuronową, wystarczająco wydajny sprzęt, który będzie mógł te sieć nauczyć oraz wystarczająco dużo czasu i pieniędzy na rachunek za prąd.

Deepfake wykorzystane w celach oszustwa

Wiedząc, jakie możliwości daje nam wykorzystanie deepfake, nietrudno zorientować się, iż jest ono świetnym narzędziem do oszukiwania ludzi na wszelakie różne sposoby. Chcemy wyłudzić od kogoś pieniądze? Generujemy głos kogoś z rodziny naszej ofiary i dzwonimy do niej, lub nawet generujemy głos wraz z twarzą i aranżujemy wideorozmowę (metoda „na wnuczka” wchodzi na zupełnie inny poziom). Chcemy zwiększyć swoje szanse w wyborach albo upokorzyć nielubianą przez nas osobę? Wykorzystujemy deepfake do wygenerowania kompromitujących zdjęć i materiałów video. Chcemy pochwalić się, że byliśmy na wakacjach w wielu różnych egzotycznych miejscach? Wkomponowujemy własną twarz w czyjeś zdjęcia i chwalimy się swoją szaloną wycieczką na Instagramie.

To wszystko niestety nie są tylko scenariusze filmowe, lecz sytuacje, które mogą wydarzyć się naprawdę. Oto kilka przykładów użycia deepfake do oszustw:

- W 2020 oszuści podszyli się pod dyrektora pewnej firmy i oszukali menedżera banku. Oszuści wytworzyli z pomocą głęokich sieci neuronowych zapis głosu przypominający dyrektora który zmylił menedżera banku i sprawił, iż zaakceptował on przelewy na łączną kwotę 35 milionów dolarów. Źródło: https://www.forbes.com/sites/thomasbrewster/2021/10/14/huge-bank-fraud-uses-deep-fake-voice-tech-to-steal-millions/

- Hakerzy sfabrykowali nagranie z dyrektorem jednego z największych rosyjskich banków w którym „dyrektor” namawiał ludzi do wykorzystania dostępnych w linku narzędzi inwestycyjnych, które miały rzekomo przynieść aż 50% zysk. Ludzie, podając swoje dane na fałszywej stronie, przekazywali oszustom takie informacje, jak imie, nazwisko, email, numer telefonu itp. Źródło: https://slate.com/technology/2021/09/deepfake-video-scams.html

- CEO pewnej firmy w UK został oszukany poprzez stworzony przez sieć neuronową głos, który miał przypominać jego przełożonego, który prosił go o wykonanie przelewu na 220 000 euro. Sam CEO opisał wygenerowany głos, jako „zawierający delikatny niemiecki akcent oraz jego melodia była charakterystyczna dla niego” – niemal dokładne odwzorowanie głosu jego szefa. Źródło: https://www.forbes.com/sites/jessedamiani/2019/09/03/a-voice-deepfake-was-used-to-scam-a-ceo-out-of-243000/?sh=7d440c2b2241

Jak więc widzimy, oszustwa z użyciem deepfake nie są niezwykle rzadkie. Biorąc pod uwagę szybki i ciągły rozwój sieci neuronowych oraz innych komputerowych narzędzi i technologii, możemy się spodziewać, iż liczba takowych oszust będzie tylko rosła.

Jak wykryć Deepfake „w domu”?

Przeglądając Internet można natrafić na wiele porad dotyczących szukania emocji w głosie, mimice, zwracania uwagi na nienaturalne zachowania, monotonny styl mówienia, brak mrugania oczami. Wszystkie te metody opierają się jednak na czysto subiektywnych odczuciach i w miarę rozwoju technologii stojącej za deepfake’ami staną się (lub już teraz są) raczej wątpliwe. Zresztą, przy takich metodach nieuchronnie wystawiamy się na działanie demona zwodziciela, który nieustannie nas oszukuje. Choć to tylko hipotetyczny byt stworzony przez Kartezjusza do innych celów, to jednak nasze zmysły mogą być zawodne i nas oszukiwać. Rozwiązaniem mogą być metody naukowe (jak na przykład Deepfake Detection Challenge) lub odwołanie się do osoby, której dany deepfake dotyczy (chyba jednak nigdy nie uda nam się zrezygnować z zaufania jako głównego czynnika w relacjach międzyludzkich). Jednak przy próbie własnego rozpoznawania deepfake-ów bardzo ważny jest zdrowy rozsądek. Czy prezydent, którego rzekomo właśnie oglądamy, mógłby powiedzieć coś takiego? Czy nasz znajomy na pewno zrobiłby sobie takie zdjęcie? Czy ktoś z rodziny, z którym potencjalnie rozmawiamy właśnie przez telefon, prosiłby nas o pieniądze w taki sposób? Jeśli cokolwiek wzbudzi nasze wątpliwości, warto zwrócić się o pomoc do kogoś, komu jesteśmy w stanie zaufać.

Deepfake Detection Challenge

Deepfake Detection Challenge to projekt zorganizowany przez technologiczny dział Facebooka odbywający się w latach 2019-2020 mający na celu dokonanie postępu w badaniach nad metodami nad wykrywaniem deepfake’ów. Na potrzeby konkursu zaproszono do współpracy 3500 aktorów różnych płci i narodowości i łącznie stworzono 115 tysięcy nagrań, spośród których część była wygenerowana komputerowo. Wartość nagród wyniosła milion dolarów a łączna długość nagrań to prawie 40 dni, co pokazuje, że Facebook potraktował temat bardzo poważnie.

https://www.kaggle.com/c/deepfake-detection-challenge

Konkurs

Samo przygotowanie deepfake’ów odbyło się przy współpracy z badaczami z takich ośrodków akademickich jak MIT, Berkeley, Oxford czy Maryland z wykorzystaniem różnych technik takich jak image enhancement, rozmycia, modyfikacje liczby klatek na sekundę, nakładanie oraz inne.

Do projektu przystąpiło 2,114 uczestników, którzy zgłosili 35,109 modeli. Zbiór walidacyjny stanowiło 10 tysięcy filmików, do których uczestnicy wcześniej nie mieli dostępu. Co ciekawe, w tym zbiorze znajdowały się także filmiki znalezione w Internecie, nie tylko przygotowane przez autorów konkursu.

Wyniki najlepszych modeli na danych dostępnych publicznie były dosyć imponujące – najlepszy uzyskał 82.56 procent dokładności (accuracy). Co ciekawe, po przetestowaniu modeli na wspomnianych wcześniej filmikach niedostępnych publicznie, najlepszy okazał się model Selima Seferbekova z dokładnością na poziomie 65.18 procent (w klasyfikacji na ogólnodostępnych danych znajdował się na 4 miejscu). Osoby, które pierwotnie zajęły pierwsze 3 miejsca na danych publicznych, po przetestowaniu ich modeli ostatecznie znalazły się na pozycjach 37, 6 i 10 co pokazuje jak ważne jest branie pod uwagę przeuczenia w trenowaniu siedzi neuronowych i budowaniu modeli.

Najlepsze modele

Najlepsze modele miały kilka cech wspólnych, które zdecydowanie zwiększały ich skuteczność:

– Odpowiednie generowanie próbek. Najlepsze modele wykorzystywały skomplikowane metody generowania próbek ze zbioru uczącego, często łącząc ze sobą fragmenty twarzy rzeczywistych i tych wygenerowanych przez sztuczną inteligencję. Pojawił się także model WS-DAN (Weakly Supervised Data Augmentation Network)

– Odpowiednie architektury sieci. Z reguły najlepsze modele korzystały z przetrenowanych architektur (głownie wariant B7 EfficientNetu). Z powodzeniem wykorzystywano także ensembling.

– Brak metod kryminalistyki cyfrowej. Co ciekawe, okazało się, że metody takie jak szukanie śladów tworzenia obrazu okazały się całkowicie nieskuteczne, choć są one szeroko stosowane w kryminalistyce

Podsumowanie

Podsumowując konkurs, ostateczne wyniki są raczej rozczarowujące – nawet najlepsze modele nie osiągnęły accuracy na poziomie 70 procent. Problem pozostaje wiec ciągle nierozwiązany – okazało się, że techniczne możliwości walki z deepfake’ami są ciągle zbyt mało zaawansowane.

A może by tak tego zabronić?

Wobec zagrożeń bezpieczeństwa (zarówno finansowego, psychicznego i osobistego) jakiego można doświadczyć w przypadku deepfake’ow w naturalny sposób pojawia się potrzeba odpowiedzi. Oczywiście podstawową formą zabezpieczenie przed technologią jest inna technologia. We wszystkich domenach współczesnego świata trwa nieustający wyścig zbrojeń – od wymyślania coraz bardziej skutecznej broni przeciwpancernej przeciwko systemom ochrony przed takimi środkami do walki w przestrzeni cyber. Czy istnieje inna możliwość poradzenia sobie z zagrożeniami powodowanymi przez deepfake’i?

Zastanawiając się nad tym pytaniem, na myśl przychodzi próba jakieś formy regulacji tego tematu. To właściwie dużo szerszy problem dotyczący relacji między etyką, państwowym aparatem przymusu (no bo przecież któż inny miałby egzekwować domniemywalnie słuszne ograniczenia moralne) oraz nauką.

Etyczna odpowiedzialność badaczy

Podstawą może jednak powinna być etyczna postawa osób pracujących nad modelami. Oczywiście rodzi to wiele kontrowersji i problemów z subiektywną oceną tego, co może przysłużyć się rzeczywistemu rozwojowi, a co stwarzać rzeczywiste zagrożenie.

Bardzo wiele firm w okresie wojny na Ukrainie rezygnuje z prowadzenia działalności gospodarczej w Rosji. Te które tego nie zrobią, muszą liczyć się z bojkotami konsumenckimi w innych krajach zachodu. W tym kontekście chcielibyśmy zauważyć, jak potężną siłę rażenia może mieć branża IT. Nie jesteśmy tylko konsumentami. To my jesteśmy dawcami kapitału, przede wszystkim intelektualnego. Jak może działać państwo bez specjalistów? Być może kiedyś zostaniemy postawieni przed wyborem realizowania projektu dla klienta zarabiającego w państwie, gdzie w rażącym stopniu prawa człowieka są łamane? Co wtedy zrobimy?

Sytuacja ta nie jest jednak tak skomplikowana. W zasadzie sprowadza się do odpowiedzi na dwa pytania: czy mój klient robi coś, co ja uważam za niemoralne oraz, jeśli tak, czy mi właściwie to przeszkadza?

Bardziej subtelnym problemem jest refleksja nad tym, czy to, nad czym pracuję naukowo jest per se dobre, złe lub moralnie obojętne. Tworzenie stronek internetowych jest raczej neutralne, chyba że tworzysz stronkę np. dla Al-Kaidy. To pytanie do ludzi którzy rzeczywiście pracują naukowo, wymyślają nowe rzeczy, próbują przecierać nieprzetarte szlaki. Choć w informatyce (a na pewnym poziomie nawet matematyce) pytanie o to czy dane badanie ogólnie służy dobru być może większości pozostanie bez odpowiedzi może w szczególnych przypadkach trzeba będzie pewne kierunki porzucić.

Alfred Nobel, wybuch i śmierć brata

Warto tutaj przytoczyć niezwykle ciekawą i poniekąd paradoksalną historię wynalezienia dynamitu przez Alfreda Nobla. Po odebraniu starannego wykształcenia i praktykach w Paryżu naukowiec ten postanowił eksperymentować z nitrogliceryną w Szwecji. Podczas eksperymentów z wybuchową substancją doszło tam do tragicznego wypadku, w którym którym zginął młodszy brat Alfreda, Emil. W związku z tym zabroniono jakichkolwiek eksperymentów z gliceryną w obrębie Sztokholmu. Jest to przykład regulacji i ograniczenia wolności, dający się jak najbardziej racjonalnie uzasadnić – zginęli przecież ludzie. Alfred Nobel jednak myślał inaczej i starał się kontynuować swoją pracę poza Sztokholmem. Ostatecznie udało mu się odnieść sukces i opracować dynamit, który miał służyć głównie do celów przemysłowych, dla ułatwienia ciężkiej pracy. Oczywiście nie posłużył on tylko do tego – stał się także śmiercionośnym narzędziem w rękach nieprawych ludzi.

Cenzura

Wracając do tematu nadzoru państwowego nad kierunkami rozwoju nauki, największy problem stanowiłoby kryterium oceny właściwości. Hipotetyczny Urząd Kontroli Modeli musiałby dysponować wiedzą pozwalająca określić, które badania mogą być kontynuowane, a które nie. Przypomina to cenzurę ze słusznie minionej epoki, jednak warto pamiętać, że w imię bezpieczeństwa jesteśmy w stanie poświęcić wiele naszej wolności. Pokazuje to na przykład drastyczne zwiększenie kontroli na lotniskach po zamachach z 11 września lub chociażby obostrzenia związane z pandemią. Nie chodzi o to, żeby zajmować pryncypialne stanowisko i zawsze stawać po stronie wolności czy bezpieczeństwa, tylko być świadomym, że takie dylematy będą się pojawiać, szczególnie w coraz bardziej niespokojnych czasach.

Podsumowanie

Problem deepfake’ów nie ogranicza się jedynie do technologicznego wyścigu zbrojeń. Poza zagadnieniami typowo naukowymi, dotyka kwestii etycznych i wpisuje się w szerszą dyskusję na temat odpowiedzialności badaczy i moralności w prowadzeniu badań naukowych.

Źródła

- https://ai.facebook.com/blog/deepfake-detection-challenge-results-an-open-initiative-to-advance-ai

- https://arxiv.org/abs/2006.07397

- Kartezjusz, Medytacje o filozofii pierwszej

- https://encyklopedia.pwn.pl/materialy-dodatkowe/haslo/Alfred-Nobel-fortuna-samotnosc-i-honor;448851.html

- https://pl.wikipedia.org/wiki/Deepfake

- https://www.kdnuggets.com/2018/03/exploring-deepfakes.html/2

Moim zdaniem z tą cenzurą to bardzo trudny i niejasny temat, bo w jaki sposób można by weryfikować i oceniać wszystkich twórców oraz ich dzieła?

W zastosowaniach komercyjnych wytwory sztucznej inteligencji i tak są tworzone pod konkretne wymagania, a akurat te „negatywne” wykorzystania nie mogą być w żaden sposób kontrolowane, szczególnie że takie rzeczy bardzo łatwo jest przygotować samemu (pomijam kwestie wydajności i dokładności). Nie ma też możliwości automatycznego sprawdzania takich narzędzi, bo można ich tworzyć mnóstwo (studentów też przecież nie sprawdzą).

Może lepszym pomysłem byłoby jednak, tak jak wspominał jeden z kolegów, ograniczanie danych, które mogą zostać wykorzystane?