Wykorzystanie sztucznej inteligencji (AI) oraz data science w systemach wymiaru sprawiedliwości nie jest już tylko przedmiotem debat akademickich – to rzeczywistość, która coraz mocniej kształtuje sposób prowadzenia dochodzeń, analizowania dowodów i wydawania wyroków. Algorytmy analizy obrazu, dźwięku i DNA zaczynają wspierać funkcjonariuszy i ekspertów, oferując szybkie i szczegółowe przetwarzanie danych. Choć pozwala to na zwiększenie skuteczności wymiaru sprawiedliwości, to niesie też szereg pytań natury prawnej i etycznej. Czy można ufać algorytmom? Kto odpowiada za ich błędy? Czy zwiększona kontrola nie prowadzi do ograniczania praw obywatelskich?

Rozpoznawanie twarzy i analiza obrazu: Automatyzacja identyfikacji a przypadki pomyłek

Rozpoznawanie twarzy to jedna z najczęściej stosowanych technologii AI w organach ścigania. Algorytmy analizujące obraz potrafią dopasować twarz z nagrania do zdjęcia z bazy danych w ułamku sekundy. Choć brzmi to jak potężne narzędzie, rzeczywistość pokazuje, że błędy identyfikacji mogą prowadzić do poważnych naruszeń praw.

W 2020 roku Robert Williams, mieszkaniec Detroit, został niesłusznie aresztowany na podstawie wskazania algorytmu rozpoznawania twarzy. Oprogramowanie dopasowało niewyraźne nagranie z monitoringu sklepu do jego zdjęcia z bazy prawa jazdy. Policjanci, opierając się jedynie na tej wskazówce, dokonali zatrzymania. Dopiero podczas przesłuchania Williams zauważył, że osoba na nagraniu nie jest nim. Sprawa zakończyła się odszkodowaniem i zmianą polityki lokalnej policji.

Innym znanym przypadkiem był błąd systemu w stanie New Jersey w 2023 roku, kiedy to technologia rozpoznawania twarzy błędnie połączyła wizerunek mężczyzny z podejrzanym o napaść w centrum handlowym. Sprawa została nagłośniona po tym, jak obrońcy praw obywatelskich zażądali publicznego ujawnienia dokładnych parametrów działania używanego systemu. Sąd ostatecznie uniewinnił mężczyznę po przeprowadzeniu niezależnej ekspertyzy, która wykazała, że materiał dowodowy był zmanipulowany przez słabej jakości algorytm.

Analiza głosu i języka: AI w ocenie wiarygodności i pochodzenia oskarżonych

Systemy oparte na rozpoznawaniu mowy i analizie fonetycznej głosu wykorzystywane są m.in. w sprawach migracyjnych. W Wielkiej Brytanii urzędy migracyjne testowały VoiceID – system, który oceniając akcent mówcy, miał określać, czy dana osoba rzeczywiście pochodzi z kraju, który wskazuje. Choć brzmi to racjonalnie, algorytmy te były krytykowane za wysoką zawodność i uprzedzenia.

W 2022 roku organizacja Refugee Action opisała przypadek Somalijczyka, któremu odmówiono azylu, ponieważ system uznał jego akcent za kenijski. Mężczyzna urodził się jednak w obozie dla uchodźców przy granicy z Kenią i większość życia spędził w kontaktach z językiem suahili. Mimo to, decyzja oparta była niemal wyłącznie na analizie głosu. Dopiero interwencja organizacji pozarządowych doprowadziła do ponownego rozpatrzenia sprawy.

Według raportu Privacy International z 2021 roku, w co najmniej kilkudziesięciu postępowaniach migracyjnych w Europie zastosowano podobne narzędzia AI oceniające język i wymowę. W niektórych z nich osoby pochodzące z terenów wielojęzycznych, takich jak pogranicze Etiopii i Erytrei, były klasyfikowane błędnie, co skutkowało odmowami azylu.

Organizacje zajmujące się prawami uchodźców podkreślają, że akcent to cecha dynamiczna – zależna od otoczenia społecznego, wieku i historii migracyjnej – a nie trwały wskaźnik tożsamości. Krytycy podnoszą również, że większość systemów nie uwzględnia wpływu traumy na mowę, co w przypadku osób ubiegających się o azyl jest szczególnie problematyczne.

W 2023 roku sprawa z Niemiec, opisana przez „Der Spiegel”, dotyczyła kobiety z Iraku, której odmówiono azylu, ponieważ system ocenił jej mowę jako „niezgodną z deklarowanym regionem pochodzenia”. Dopiero po interwencji adwokata oraz niezależnej analizie lingwistycznej okazało się, że kobieta mówi w regionalnym dialekcie z wpływami języka kurdyjskiego, co algorytm błędnie sklasyfikował.

Algorytmy DNA i drzewa genealogiczne: sukcesy i kontrowersje wokół genetycznej analityki

Przełomowy był przypadek tzw. Golden State Killera w Kalifornii. Po latach bezowocnych dochodzeń, śledczy skorzystali z publicznych baz danych genealogicznych.

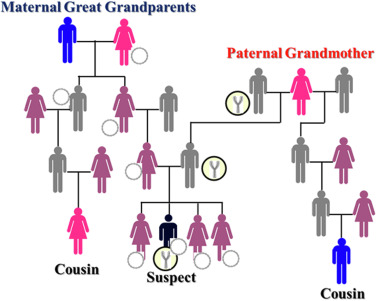

Algorytmy porównały profil DNA sprawcy z danymi tysięcy użytkowników serwisów takich jak GEDmatch. Choć nie znaleziono dokładnego dopasowania, udało się zidentyfikować kuzynów sprawcy. Na tej podstawie zbudowano drzewo genealogiczne, które doprowadziło do aresztowania Josepha DeAngelo – byłego policjanta. Przyznał się do kilkunastu morderstw.

W 2021 roku w podobny sposób zidentyfikowano sprawcę morderstwa z 1984 roku w Wisconsin. Dzięki porównaniom DNA w bazach danych rodzinnych ustalono tożsamość Terry’ego Peder Rassmusena, zwanego „Bear Brook Killer”. Sprawa była przez lata uznawana za nierozwiązaną, a kluczowy przełom nastąpił dopiero po wykorzystaniu technik analizy genealogicznej.

W 2023 roku w stanie Maryland po raz pierwszy w historii USA algorytmy analizujące kod DNA w połączeniu z analizą sztucznej inteligencji zostały użyte do stworzenia tzw. predykcyjnego portretu fenotypowego sprawcy. Na podstawie DNA z miejsca zbrodni wygenerowano komputerowy wizerunek osoby podejrzanej – obejmujący prawdopodobny kolor oczu, skóry i włosów. Portret został rozpowszechniony przez policję, co doprowadziło do otrzymania nowego zgłoszenia, które pomogło zawęzić krąg podejrzanych.

Technologia ta, znana jako „phenotyping forensics”, rozwijana przez firmy takie jak Parabon NanoLabs, otwiera nowe możliwości, ale wywołuje również kontrowersje. Krytycy wskazują na ryzyko stygmatyzacji i uprzedzeń rasowych, a także na pytania dotyczące dokładności takich rekonstrukcji. Eksperci podkreślają też, że predykcyjny fenotyp nie jest dowodem bezpośrednim i nie powinien być wykorzystywany jako jedyna podstawa do aresztowania.

Schemat genealogicznego dopasowania DNA – pokazuje, w jaki sposób podejrzany może zostać powiązany zarówno z bliskimi (rodzice, dzieci), jak i dalszymi krewnymi (np. kuzyni) na podstawie wspólnych markerów genetycznych.

Sposób chodzenia jako dowód? AI w londyńskim metrze

W 2022 roku w londyńskim metrze przetestowano zaawansowany system monitoringu oparty nie na rozpoznawaniu twarzy, lecz na analizie chodu (gait recognition). Kamery wyposażone w algorytmy sztucznej inteligencji rejestrowały trajektorie ruchu ciała, jego ułożenie, tempo poruszania się, mikrogesty oraz odchylenia od normatywnego wzorca motoryki. Celem technologii było wczesne wykrywanie „nienaturalnych” lub podejrzanych zachowań, potencjalnie wskazujących na zagrożenie terrorystyczne lub inne ryzykowne sytuacje w przestrzeni publicznej.

Zasadniczym problemem okazał się jednak brak przejrzystości operacyjnej – pasażerowie nie byli informowani o prowadzeniu eksperymentu, nie uzyskano ich zgody, nie udostępniono również żadnych materiałów informacyjnych na temat celu i zakresu zbieranych danych. Tym samym system ten naruszał podstawowe standardy przejrzystości i autonomii informacyjnej obywateli.

Pojawia się zatem pytanie: czy sposób poruszania się – uznawany za unikalny dla jednostki – należy traktować jako dane biometryczne, a więc podlegające ochronie prawnej? I dalej: czy ruch ciała w przestrzeni publicznej może być przedmiotem przetwarzania bez wyraźnej zgody, w ramach domniemanej walki z zagrożeniami?

Eksperci ds. prywatności i bioetyki podkreślają, że tego typu systemy stanowią przykład tzw. nadzoru ambientowego – dyskretnego, ciągłego i wszechobecnego monitorowania, które może odbywać się poza świadomością obywateli. W dłuższej perspektywie praktyki te mogą prowadzić do erozji zaufania społecznego wobec instytucji publicznych oraz ograniczenia swobody poruszania się i ekspresji jednostki w przestrzeni miejskiej.

Ocena zachowań i predykcja ryzyka: od monitoringu do biopolityki

Jednym z najbardziej kontrowersyjnych zastosowań AI w wymiarze sprawiedliwości są systemy predykcyjnej analizy ryzyka. Algorytmy te analizują dane historyczne, aby przewidywać, kto z dużym prawdopodobieństwem popełni przestępstwo lub złamie warunki zwolnienia warunkowego. W Stanach Zjednoczonych powszechnie stosowany jest system COMPAS (Correctional Offender Management Profiling for Alternative Sanctions), który ocenia „ryzyko recydywy” na podstawie zestawu danych wejściowych, takich jak historia zatrzymań, miejsce zamieszkania, czy status zatrudnienia.

Choć intencją takich systemów jest optymalizacja decyzji sądowych (np. przy przyznawaniu zwolnień warunkowych), badania ProPublica z 2016 roku wykazały, że COMPAS wykazuje znaczne uprzedzenia rasowe – osoby czarnoskóre były częściej klasyfikowane jako „wysokiego ryzyka” niż osoby białe, mimo że nie popełniły później przestępstwa. Ujawnienie tych danych wywołało burzliwą debatę o tzw. algorytmicznej dyskryminacji.

W Chinach, Izraelu i niektórych krajach Unii Europejskiej testowane są natomiast rozwiązania oparte na analizie behawioralnej i monitoringu. Kamery wyposażone w AI mają oceniać „podejrzane zachowania” w czasie rzeczywistym – np. zbyt szybkie poruszanie się, nieskoordynowane gesty czy odstępstwa od typowych wzorców przemieszczania się. Choć technologie te mogą pomóc w szybkim reagowaniu służb, krytycy ostrzegają przed nadużyciami i niejasnością kryteriów „ryzyka”, które bywają arbitralne i nietransparentne.

Problemem pozostaje też kwestia błędnych predykcji. Jeśli system wskazuje daną osobę jako potencjalnie niebezpieczną, to często wystarcza, by wydać surowszy wyrok, nawet jeśli nie istnieją inne dowody. To przesuwa punkt ciężkości z dowodów na „prawdopodobieństwo”, co podważa fundamentalne zasady sprawiedliwości proceduralnej.

Systemy predykcyjne wpisują się również w szerszy paradygmat biopolityki – czyli zarządzania populacją przez technologie oceniające zdrowie, ryzyko, produktywność i zgodność obywateli z normami społecznymi. Takie wykorzystanie AI może prowadzić do utajonej formy kontroli społecznej, gdzie analiza danych zastępuje indywidualne osądy i decyzje sądowe stają się automatyzowane.

Jakie podejście w stosunku do AI prezentuje Unia Europejska?

W związku z nieustannym rozwojem i doskonaleniem AI konieczne stało się szybkie uregulowanie tego obszaru. 15 czerwca 2023 r. Parlament Europejski przyjął akt o sztucznej inteligencji (AI Act), którego głównym celem było zminimalizowanie ryzyk związanych z wykorzystywaniem systemów opartych na AI.

W szczególności w AI Act wprowadzono kontrolę nad tzw. systemami zwiększonego ryzyka, do których m.in. zaliczono oparte o AI systemy stosowane przez administrację publiczną i organy ścigania, poprzez np. wymóg każdorazowej oceny ich wpływu na podstawowe prawa obywateli, a także zabroniono stosowania systemów opartych o AI do predykcji kryminalnej. W akcie przyznano prawo do wniesienia skargi do krajowego organu ds. AI od decyzji wydanej z wykorzystaniem algorytmów sztucznej inteligencji. AI Act nie zezwala na ten moment na podejmowanie przez systemy wykorzystujące sztuczną inteligencję w pełni autonomicznych i niepodważalnych decyzji.

Po poprawkach wprowadzonych przez Parlament Europejski, zakazane mają być także:

- systemy zdalnej identyfikacji biometrycznej „w czasie rzeczywistym” w miejscach publicznie dostępnych;

- wykorzystywanie w przestrzeni publicznej systemów zdalnej identyfikacji biometrycznej post-factum, z jednym wyjątkiem, dotyczącym ścigania poważnych przestępstw, z uprzednią autoryzacją sądu;

- systemy kategoryzacji biometrycznej wykorzystujące cechy wrażliwe (np. płeć, rasę, pochodzenie etniczne, obywatelstwo, religię, orientację polityczną);

- predykcyjne systemy policyjne (oparte na profilowaniu, lokalizacji lub przeszłych zachowaniach przestępczych);

- systemy rozpoznawania emocji wykorzystywane przez organy ścigania, służby graniczne, miejsca pracy i instytucje edukacyjne;

- nieukierunkowane pobieranie obrazów twarzy z Internetu lub nagrań telewizji przemysłowej do tworzenia baz danych rozpoznawania twarzy.

Implikacje etyczne: prywatność, dyskryminacja, „czarne skrzynki” i kontrola społeczna

Z punktu widzenia etyki, wykorzystanie AI w analizie dowodów sądowych stawia pytania, które wykraczają poza skuteczność i efektywność. Jednym z kluczowych problemów jest kwestia prywatności. Jak wskazują naukowcy z Oxford Internet Institute (Lehtiniemi & Ruckenstein, 2019), dane biometryczne i behawioralne przetwarzane przez systemy AI są często zbierane bez świadomej zgody jednostek. Algorytmy analizujące sposób chodzenia, ton głosu czy ekspresję twarzy mogą funkcjonować w sposób całkowicie niewidzialny dla obywateli, co podważa ich autonomię i możliwość sprzeciwu.

Drugi istotny problem to potencjalna dyskryminacja algorytmiczna. Badania MIT Media Lab wykazały, że wiele systemów rozpoznawania twarzy wykazuje znacznie niższą dokładność w przypadku osób o ciemniejszym kolorze skóry i kobiet. Oznacza to, że AI – nawet jeśli nie jest zaprojektowane w sposób stronniczy – może reprodukować i wzmacniać istniejące uprzedzenia społeczne, jeśli dane treningowe są niezrównoważone.

Kolejnym wyzwaniem jest problem tzw. czarnej skrzynki – braku przejrzystości w działaniu algorytmów. W kontekście sądowym oznacza to ryzyko, że sędziowie, obrońcy i oskarżeni nie są w stanie zrozumieć, jak system podjął konkretną decyzję lub do jakich danych się odwołał. Jak podkreślają Mittelstadt et al. (2016), brak możliwości audytu decyzji algorytmicznej zagraża podstawowym zasadom sprawiedliwości proceduralnej.

Pojawia się pytanie o społeczne skutki upowszechnienia AI w wymiarze sprawiedliwości. Czy zamiast wspierać ludzkie decyzje, algorytmy nie staną się nowym narzędziem kontroli populacji? Filozofowie tacy jak Shoshana Zuboff (2019) ostrzegają przed „kapitalizmem nadzoru” – systemem, w którym dane o zachowaniu obywateli stają się surowcem dla władzy technologicznej. W takiej logice systemy AI przestają być narzędziami wspierającymi sprawiedliwość, a stają się technologią zarządzania zachowaniem i ryzykiem społecznym.

Dlatego każda decyzja o wdrożeniu narzędzi AI do praktyki sądowej powinna być poprzedzona oceną etyczną – uwzględniającą nie tylko skuteczność technologii, ale też jej wpływ na prawa człowieka, strukturę społeczną i zaufanie obywateli do państwa prawa.

Źródła

- Yadav, P. K., & Sharma, S. (2024). Challenges in using genetic genealogy in forensics. In Next Generation Sequencing (NGS) Technology in DNA Analysis. Elsevier. https://www.researchgate.net/publication/377298088_Challenges_in_using_genetic_genealogy_in_forensics

- Journal of Data Science (2024). Special Issue on Statistical Frontiers of Data Science.

- Lech, M. (2023). Możliwość wykorzystywania narzędzi opartych o sztuczną inteligencję w postępowaniu karnym w Polsce. Nowoczesne Technologie w Prawie https://repozytorium.uni.wroc.pl/dlibra/publication/150678/edition/141047/mozliwosc-wykorzystywania-narzedzi-opartych-o-sztuczna-inteligencje-w-postepowaniu-karnym-w-polsce-lech-marcelina-orcid-0000-0002-5830-3501

- Natalia Wojciechowska, (2023). Sztuczna inteligencja w prawie: jak AI wpływa na systemy prawne i rozstrzyganie sporów? https://www.dotlaw.co/sztuczna-inteligencja-w-prawie-jak-ai-wplywa-na-systemy-prawne-i-rozstrzyganie-sporow-cz-ii/

- Oliwia Łuczak, (2023). Wykorzystanie sztucznej inteligencji w kryminalistyce – czyli ile prawdy jest w filmach detektywistycznych? https://lgl-iplaw.pl/2023/07/wykorzystanie-sztucznej-inteligencji-w-kryminalistyce-czyli-ile-prawdy-jest-w-filmach-detektywistycznych/