Sztuczna inteligencja pełni coraz większą rolę w naszym życiu i wykorzystywana jest ona w coraz to nowych dziedzinach. Kiedy użytkownik uświadomi sobie jak bardzo wpływa ona na jego codzienność szybko nasunie się mu pytanie: czy powinienem ufać jej sugestiom lub decyzjom? Oczywiste jest, że jedynie twierdząca odpowiedź gwarantuje, że system odniesie sukces. Budowanie zaufania w systemach AI jest złożonym zadaniem, na które składa się wiele aspektów. Najważniejszym lecz również najtrudniejszym jest opracowanie kanału komunikacji między systemem informatycznym, a realnym użytkownikiem, tak aby możliwe było zrozumienie procesu decyzyjnego.

Przy kontakcie z prostymi systemami opartymi na sztucznej inteligencji łatwo jest w pierwszej chwili zachłysnąć się ułatwieniami jakie ona oferuje. Chcąc obejrzeć coś wieczorem możemy wybrać z filmów proponowanych nam na podstawie wcześniej oglądniętych lub ocenionych, a robiąc zakupy przez internet oferowany jest akurat ten produkt o którym całkowicie zapomnieliśmy. Dużym zainteresowaniem cieszą się samochody posiadające funkcje automatycznego parkowania. Dostrzegając mnogość i wzrastającą istotność sytuacji w których nasza codzienność jest determinowana przez sztuczną inteligencję łatwo zacząć kwestionować, czy systemy te są godne naszego zaufania.

Problem zaufania potęgują się sytuacje w których systemy AI zawodziły. W 2016 roku Microsoft powołał do życia bota Tay’a który na Twitterze uczył się robić wpisy na podstawie wpisów użytkowników, a następnie sam udostępniał własne. Tay „pożył” jedynie 16 godzin – musiał zostać usunięty, gdyż samoistnie zaczął publikować niestosowne treści, w tym nazistowskie. Innym przykładnem może być wpadka zaliczona przez Google i ich oprogramowanie do automatycznego rozpoznawania twarzy w galeriach zdjęć. W pierwszej fazie jej działania doszło do sytuacji gdzie u jednego z użytkowników dwie czarnoskóre osoby zostały zidentyfikowane jako „goryle”. Takie sytuacje znacząco nadszarpują reputacje systemów AI i zniechęcają ludzi do ufania im.

Oczywiście poziom zaufania zależy od poziomu ingerencji sytemu w nasze życie. O ile raczej nie będziemy mieć problemu z powierzeniem decyzji o kolejnym filmiku jaki odtworzy nam YouTube sztucznej inteligencji to raczej nie tak łatwo powierzylibyśmy zawiezienie nas do pracy pojazdowi autonomicznemu. W obu sytuacjach, aby system spełnił swoje zadanie konieczne jest abyśmy mu zaufali.

Autonomiczny pojazd Ubera przejeżdżający na czerwonym świetle

Jak stworzyć system któremu użytkownik będzie w stanie zaufać?

Rozumiejąc, że zaufanie użytkownika jest krytyczne dla rozwoju i sukcesu produktu warto podczas procesu planowania i wdrażania przeanalizować aspekty, które mają szansę zwiększać wiarygodność naszego AI.

Integralność

Podstawą zaufania do sytemu AI jest podejmowanie przez niego odpowiednich decyzji. Częstą obawą jest też wymknięcie się spod kontroli systemu AI.

Integralność to zapewnienie, że systemy generują dane wyjściowe zgodnie ze zdefiniowanymi wcześniej przez dewelopera parametrami operacyjnymi i technicznymi. Jeśli system jest integralny to mamy pewność, że działa on zgodnie ze swoim przeznaczeniem. Elementem integralności mogą być również pewne ustanowione ograniczenia, które mogą być wykorzystane do regulowania wykorzystania AI, co przyczyni się do zwiększenia komfortu użytkownika. Sytem ma narzucone jakieś ograniczenia, więc zwiększone jest poczucie kontroli nad rezultatami.

Świadomy rozwój

Innym elementem wpływającym na zaufanie danemu systemowi jest jasno określony dodatni wpływ na rzeczywistość. Użytkownik nie będzie chętnie korzystał z systemu jeżeli nie przynosi mu to żadnych korzyści.

Podczas opracowywania systemów AI programiści muszą mieć pewność, że decyzje podejmowane przez AI będą korzystne dla ludzi. W tym celu systemy muszą być dostosowane do ludzkich zasad i wartości. Dlatego cele sztucznej inteligencji muszą być zgodne z ludzkimi wartościami i koncentrować się na poprawie jakości ludzkiego życia. Takie podejście nazywamy świadomym projektowaniem. Postępowanie zgodnie z tym podejściem na pierwszy rzut oka wydaje się wręcz oczywiste jednak czasami tworząc aplikacje AI w dobrych intencjach, mimo to naruszamy prywatność gromadząc duże ilości poufnych danych. Należy bezwględnie pamiętać by projektować aplikacje, które nie są zbyt inwazyjne i wykorzystują skuteczne protokoły bezpieczeństwa w celu ochrony poufnych danych. Konieczne jest by system zarówno był wysoce funkcjonalny jak i bezpieczny. W kwestii ochrony danych równie ważna jest transparentność ich wykorzystania. Prosząc użytkownika o podanie jaki danych należy jasno określić cel oraz warunki w jakich będą one przez system wykorzystywane.

Decyzje a wyznawane wartości

Innym czynnikiem wpływającym na to w jakim stopniu ufamy innym jest poziom zgodności wyznawanych wartości – o wiele łatwiej zlecimy podjęcie decyzji osobie o zbliżonych poglądach, gdyż ma ona podobne spojrzenie na świat. Przekładająć to na systemy AI, te które potrafią rozróżniać poglądy mają szanse zaadaptować się do użytkownika i stworzyć bardziej spersonalizowany model decyzyjny, cieszą się lepszym poziomem zaufania użytkownika.

W kwestii personalizacji modelu do użytkownika niezmiernie ważną kwestią jest świadomości naszej różnorodności. Aby system działał dobrze konieczne jest pozyskanie danych o jak najszerszym przekroju. Należy zdawać sobie sprawę, że wąskie zbiory danych mogą generować tendencyjne wyniki co może prowadzić do dyskryminacji pewnych grup społecznych. Jednym ze sposobów unikania takich problemów jest zapewnienie by zespół programistów składał się z różnych osób, które podczas projektowania algorytmów mogą zidentyfikować problemy, które mogłyby pozostać niezauważone w mniejszych zespołach.

Wyjaśnianie

Wbrew pozorom w codziennym życiu ufamy dość łatwo. Ufamy, że lekarz przepisze nam odpowiednie leki, taksówkarz przewiezie nas bezpiecznie przez miasto, a doradca finansowy udzieli nam wartościowej porady. Zwykle nasze zaufanie opieramy na założeniach, że osoby te swoje umiejętności rozwinęły poprzez naukę. Systemy AI mają w tym kontekście podobne możliwości – uczą się na zestawie danych i swoją wiedzę mogą wykorzystać w praktyce.

Jak zatem sprawić żeby nasz system w odbiorze był równie wiarygodny co specjalista?

James Davis (2008):

Zaufanie to zdecydowanie się na bycie narażonym na zagrożenie i świadome podjęcie tego ryzyka

Zaufanie w biznesie budowane jest przede wszystkim na dwóch filarach: obserwacji, że dane rozważanie działa i otrzymania wyjaśnienia jak i dlaczego rozwiązanie działa. Kontynuując przykład taksówkarza – jeśli zjedzie on z trasy bez słowa odniesiemy wrażenie że próbuje nasz oszukać. Jednak gdy podczas tego manewru powie, że wie że główna ulica jest dzisiaj zamknięta to już jego wiarygodność nie ucierpi. Do pełnego zaufania nie wystarczy samo pokazanie, że system spełnia swoją rolę. Pokazanie na kilku przypadkach dobrego działania nie gwarantuje niezawodności. Dopiero gdy użytkownik zrozumie jak działa dany system będzie on w stanie mu zaufać.

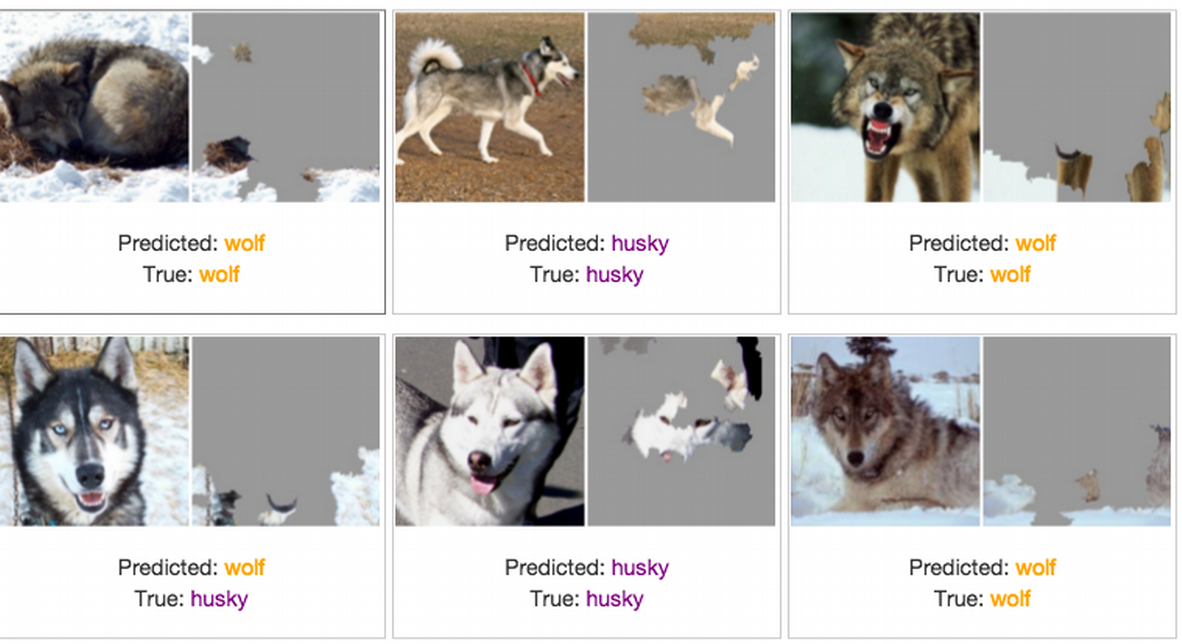

Do budowania zaufania między użytkownikiem a sztuczną inteligencją konieczna jest więc komunikacja między nimi. Z definicji AI posiada inne, bardziej złożone lecz węższe postrzeganie świata niż człowiek. Często decyzja bądź rezultat otrzymywany przez metody uczenia maszynowego wydaje dla człowieka nieuzasadniony. Jeżeli w swoim działaniu proces decyzyjny jest systemem black-box dla użytkownika to bardzo ciężko jest uwierzyć, że działa on dobrze. AI ma znacznie większe możliwości wykrywania schematów i odnajdywania powiązań w dostępnych danych, jednak w tym procesie brak jest interpretacji przystępnej dla człowieka. Jeśli jedyne co system robi to zwraca wynik dopasowywania dla konkretnych warunków użytkownik pozbawiony jest możliwości zrozumienia jego pobudek. W takiej sytuacji ciężko jest zaufać, że system działa napewno poprawnie, a przyczyny podjęcia konkretnej decyzji są racjonalne. Konieczne jest więc zaimplementowanie do sytemu modelu interpretacji do świata rzeczywistego, który pozwoli na zrozumienie przez nas jego działania.

Jest to obecnie jedno z największych wyzwań systemów AI. Pierwszym krokiem jest nauczenie systemu definicji które funkcjonują w naszym świecie, co samo w sobie jest zadaniem trudnym gdyż otaczający nas świat jest bardzo złożony. Kolejną trudnością jest zapewnienie że dla systemu pojęcia mają takie same znaczenie jak dla nas – jeżeli system rozpoznaje na zdjęciu psa to chcemy mieć pewność, że zarówno pies na smyczy jak i bez smyczy zostanie przez system poprawnie zakwalifikowany.

Chat-boty

O ile powyższe zasady w zasadzie odnoszą się do wszelkiego rodzaju systemów AI warto wyodrębnić tutaj grupę chat botów, które pełnią trochę inną funkcję. Ich celem przede wszystkim jest nawiązanie rozmowy z użytkownikiem. Aby uwiarygodnić ten proces ważne jest skupienie się na upodobnieniu doświadczenia rozmowy do tej międzyludzkiej. Pierwszym nasuwającym się pomysłem jest dodanie modelowi pewnej historii – rozmawiając z człowiekiem zdajemy sobie sprawę że ma on swoje doświadczenia, które uwidaczniają się w rozmowie. Jednak takie odgórne narzucenie „przeszłości” sztucznej inteligencji raczej nie zostanie odebrane jako zwiększające zaufanie – ciężko ufać botowi który twierdzi, że ma 34 lata i mieszka w Australii. Rozwiązaniem są próby implementacji kontekstualnych systemów, czyli takich które będą potrafiły prowadzić rozmowę w sposób naturalny dla człowieka (dostosowany do kontekstu jego wypowiedzi). Ważne jest tutaj zwrócenie uwagi na niebezpieczeństwo jakie takie systemy ze sobą niosą. Bot który sprawnie dopasowuje się do potrzeb i zachowań w nieodpowiednich warunkach może stać się niczym oszust, który stosuje techniki manipulacyjne by zdobyć nasze zaufanie.

Dopóki nie opanujemy dobrze technologii uczłowieczania bota, najprostszą metodą zwiększenia zaufania w chat botach jest uczciwe poinformowanie użytkownika, że rozmawia z botem i wskazanie, że jest on nadzorowany/kontrolowany przez ludzi.

Regulacje prawne

Równie powszechnym elementem zaufania jest przeświadczenie o jasno postawionych wytycznych i ustanowieniu przepisów krajowych lub międzynarodowych. Świadomość o odgórnej kontroli normalizuje w społeczeństwie stosowanie takich rozwiązań.

Choć kilka lat temu kwestia budowania zaufania była jedynie potrzebą rozpoznawaną przez firmy dla zwiększenia zadowolenia klientów, to już zaczyna się mówić również o unormowaniu tych kwestii.

Celem takich regulacji jest zapewnienie miedzy innymi aby:

- Systemy AI były budowane w celu wzmocnienia pozycji człowieka i były przez niego kontrolowane

- Systemy AI były bezpieczne i nie naruszały prywatności użytkowników.

- Dane i algorytmy wykorzystywane w systemach AI były całkowicie przejrzyste.

- Systemy AI nie mogły szkodzić środowisku naturalnemu ani innym istotom żywym.

- Zapewnić rozliczalność i odpowiedzialność za systemy AI i ich wyniki.

Unia Europejska w planach na lata 2019 – 2024 postawiła za jeden z celów wystosowanie pierwszych ram prawnych zapewniających wiarygodność systemów sztucznej inteligencji.

Głównym celem projektu jest niedopuszczenie do sytuacji wprowadzenia do użytku systemu AI stwarzającego ryzyko dla praw i bezpieczeństwa obywateli.

Podział systemów AI

W związku z tym oprogramowania dzielone są na kategorie: niedopuszczalne ryzyko – zakaz wprowadzenia, wysokie ryzyko – rygorystyczne normy i kontrole przed wprowadzeniem oraz w trakcie eksploatacji, umiarkowane ryzyko – minimalne wymaganie transparentności i umożliwienie użytkownikowi rezygnacji, minimalne ryzyko – bez określonych wymagań.

Podsumowanie

Wiarygodność systemów AI jest niezmiernie złożonym procesem, który ciągle jest ulepszany. Projektując system warto brać pod uwagę czynniki, które to zaufanie zwiększają. W relacjach międzyludzkich dość łatwo sobie wzajemnie ufam. Chcą polepszyć zaufanie w relacjach człowiek – AI warto rozważyć co powoduje, że ufamy drugiemu człowiekowi i spróbować zaadaptować te aspekty do naszego systemu.

Tekst został stworzony w oparciu o następujące źródła:

- https://capgeminipolska.prowly.com/118309-etyczna-zagadka-ai-czyli-jak-budowac-zaufanie-do-sztucznej-inteligencji

- https://towardsdatascience.com/why-the-world-needs-trustworthy-chatbots-aab5db94dbf8

- https://ec.europa.eu/info/strategy/priorities-2019-2024/europe-fit-digital-age/excellence-trust-artificial-intelligence_pl

- https://www.infoworld.com/article/3184205/danger-danger-10-alarming-examples-of-ai-gone-wild.html#slide9

- Davis, J., Ruhe, J., Lee, M., (2008). Trust: An intercultural comparison of consumer perceptions. International Journal of Commerce and Management, 18:2, 150-165.