Sztuczna inteligencja (SI) to technologia, która w ostatnich latach zyskuje na znaczeniu i wpływa na różne aspekty naszego życia, od medycyny przez edukację po codzienne monotonne zadania. W miarę jak jej zastosowanie staje się coraz szersze, rośnie również ryzyko nadużyć oraz nieprzewidzianych konsekwencji. W odpowiedzi na te wyzwania powstała dyrektywa Parlamentu Europejskiego w sprawie Sztucznej Inteligencji (AI Act), mająca na celu stworzenie ram prawnych dla technologii sztucznej inteligencji (SI) na terenie Unii Europejskiej. Dyrektywa wprowadza szczegółowy podział systemów SI według poziomu ryzyka dla osób fizycznych i ogółu społeczeństwa oraz nakreśla wymogi dotyczące transparentności ich działania i odpowiedzialności. Kluczowym elementem regulacji jest koncepcja wyjaśnialnego SI, która ma na celu zwiększenie zaufania użytkowników do technologii poprzez zapewnienie przejrzystości w procesach decyzyjnych. Jednakże, mimo ambitnych założeń, AI Act budzi kontrowersje i obawy dotyczące jego wpływu na innowacje oraz konkurencyjność Europy na globalnym rynku technologicznym. W artykule przyjrzymy się kluczowym aspektom regulacji oraz przyszłości sztucznej inteligencji w kontekście dynamicznie rozwijającego się świata technologii.

Czym jest SI (AI)

Sztuczna inteligencja (SI) to termin odnoszący się do systemów komputerowych, które mają zdolność do wykonywania zadań, które normalnie wymagają ludzkiej inteligencji. Obejmuje to różnorodne technologie, takie jak algorytmy uczenia maszynowego, sieci neuronowe oraz roboty. SI może analizować dane, uczyć się na ich podstawie i podejmować decyzje, co czyni ją niezwykle wszechstronnym narzędziem w różnych sferach życia społecznego. Istnieją różne rodzaje SI, w tym płytka SI, która wykonuje konkretne zadania w sposób przewidywalny oraz głęboka SI, która naśladuje bardziej złożone procesy myślowe ludzkiego mózgu. Rozwój SI wiąże się z ogromnym potencjałem do poprawy efektywności pracy, edukacji czy szerokiego spektrum obliczeń. Jednakże, wraz z tym rozwojem pojawiają się również poważne wyzwania związane z etyką, bezpieczeństwem oraz odpowiedzialnością prawną sztucznej inteligencji. W miarę jak SI staje się coraz bardziej powszechna, konieczne staje się wprowadzenie regulacji prawnych, które będą chronić użytkowników.

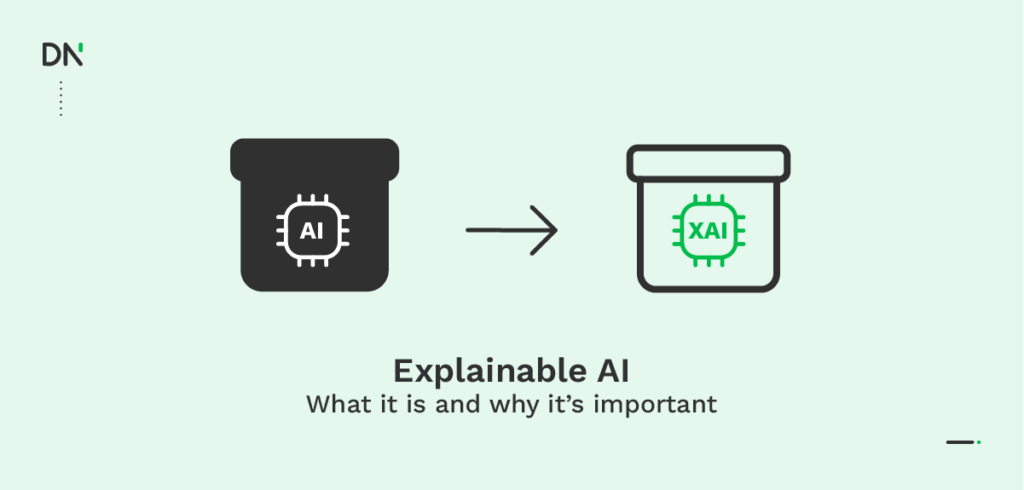

Wyjaśnialne SI

Wyjaśnialne SI (ang. Explainable AI) to koncepcja, która odnosi się do zdolności systemów sztucznej inteligencji do dostarczania zrozumiałych wyjaśnień swoich decyzji i działań. W kontekście SI często mówi się o problemie „czarnej skrzynki”, gdzie użytkownicy mają dostęp tylko do danych wejściowych i wyjściowych, ale sam proces który doprowadził algorytm do do konkretnego wyniku jest niejasny lub niewytłumaczalny. Taki brak przejrzystości może prowadzić do nieufności wobec technologii oraz trudności w dochodzeniu sprawiedliwości w przypadku popełnienia przez nią błędów, lub co gorsza szkód. Dzięki transparentności procesu podejmowania decyzji możliwe jest ustalenie przyczyn ewentualnych błędów oraz identyfikacja osób odpowiedzialnych za stworzenie danego systemu. W kontekście regulacji AI Act, wyjaśnialność staje się jednym z głównych wymogów dla systemów sztucznej inteligencji.

Zjawisko wyjaśnialnego SI jest wyjątkowo ważne w dyskusji dotyczącej dyskryminacji ze strony SI czy też dyskryminacji algorytmicznej. W ramach zapobiegania nierównemu traktowaniu, ważne jest poznanie przyczyny problemu. Przykładem problematycznego użycia systemów SI jest jej wykorzystywanie w sektorze zatrudnienia, gdzie technologia ta ułatwia i automatyzuje procesu rekrutacji. Algorytm przesiewa kandydatów w poszukiwaniu konkretnej cechy lub zestawu cech, które są pożądane przez pracodawcę, w wyniku czego może dojść do systemowego wykluczenia całych grup społecznych, innymi słowy do dyskryminacji. Kandydat może na przykład mieć cechę, która nie jest “szukana” przez SI, co zadziała na jego niekorzyść w porównaniu do innych kandydatów. Pojawia się więc problem braku transparentności, który w procesie rekrutacji oznacza brak jawności danych, na podstawie których programowana i ćwiczona była SI do poszukiwania kandydatów. Ten brak wyjaśnialności, w jaki sposób doszło do podjęcia decyzji na korzyść lub niekorzyść kandydata, uniemożliwia przeciwdziałanie dyskryminacji algorytmicznej.

AI Act – założenia, wdrożenie i poziomy ryzyka SI

Propozycja dyrektywy Parlamentu Europejskiego w sprawie odpowiedzialności za sztuczną inteligencję (tzw. AI Act) została opublikowana w roku 2021, a w czerwcu 2023 r. została przyjęta. Dyrektywa weszła w życie w sierpniu 2024 roku a wszystkie jej założenia wdrożone mają zostać do 2 lat później. AI Act ma być między innymi odpowiedzią na trudny do zdefiniowania status odpowiedzialności za popełnienie błędu lub doprowadzenie do naruszenia dóbr osobistych w wyniku działania sztucznej inteligencji. Celem jest uregulowanie kwestii odpowiedzialności prawnej za szkody wyrządzone przez systemy oparte na SI oraz dostosowanie istniejącego prawa do wyzwań związanych z rozwojem SI, zapewniając ochronę praw konsumentów i obywateli. Dyrektywa określająca zasady stosowania systemów wykorzystujących sztuczną inteligencję, ma charakter rozporządzenia unijnego, co oznacza, że będzie stosowana na poziomie krajowym, bez konieczności wprowadzania innych aktów prawnych.

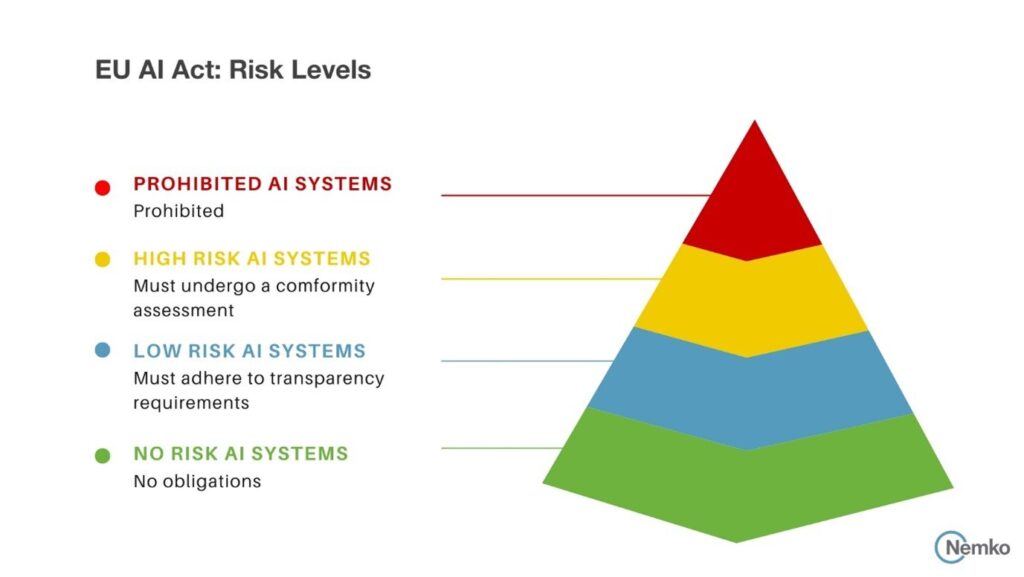

Przepisy dyrektywy nakreślają cztery kategorie poziomów ryzyka związanego ze sztuczną inteligencją, na których opierać będą regulacje. Pierwszy i najbardziej restrykcyjny to poziom niedopuszczalnego ryzyka. W jego skład wchodzi wykorzystywanie SI do pozyskiwania danych wyjątkowo wrażliwych, których prawdopodobieństwo nadużyć jest wysokie. W skład takich danych wchodzą dane biometryczne, pozyskiwane w czasie rzeczywistym, np. w systemach CCTV w przestrzeni publicznej, ale również kategoryzowanie ludzi przez zachowania lub status społeczno-ekonomiczny. Warto zwrócić uwagę, że w dyrektywie zaznaczony został fakt, że pozyskiwanie danych biometrycznych zakazane jest właśnie w czasie rzeczywistym, jednak pozyskiwanie tych danych w inny sposób nie zostało wzięte pod uwagę. Istnieje wiele rodzajów wykorzystywania danych biometrycznych również w celach zabezpieczeń lub jako formy płatności, możliwe więc, że to z tego powodu zakaz pozyskiwania tego typu informacji został tak ściśle określony.

Poziom ryzyka wysokiego dotyczy systemów sztucznej inteligencji, które mogą wpływać negatywnie na bezpieczeństwo lub podstawowe prawa ludzi. W ramach owego poziomu ryzyka SI nie może być odpowiedzialne, chociażby za transport, kształcenie, medycynę czy zatrudnienie. W przypadku popełnienia błędu przez system w którymkolwiek z wymienionych sektorów, dojść mogłoby nie tylko do dyskryminacji lub niesprawiedliwej oceny, ale również do ubytku na zdrowiu lub nawet do utraty życia jednostki. W przypadku systemów SI wykorzystywanych w wymienionych sektorach warto zauważyć, że systemy te mogą być wykorzystywane jako pomoc w usprawnianiu działania różnych placówek, jednak sztuczna inteligencja nie może autonomicznie podejmować decyzji, co oznacza, że ostateczna rozstrzygnięcie sytuacji autoryzowane musi być przez człowieka.

Pozostałe dwa poziomy ryzyka nie są już tak restrykcyjne, jako że wychodzą poza kategorie wysokiego ryzyka. Jednak nie oznacza to w ich wypadku braku regulacji. Poziom ograniczonego ryzyka odnosi się do systemów wykorzystujących SI, które mają obowiązek transparentności. Oznacza to, że w przypadku gdy człowiek ma kontakt z systemem SI musi być o tym poinformowany, dlatego np. w sytuacji pojawienia się na stronie internetowej automatycznego chatu lub elektronicznego asystenta, użytkownik musi być jasno poinformowany o tym, że jest to program sztucznej inteligencji, aby sam mógł zadecydować, czy chce posługiwać się z ową technologią. Natomiast poziom minimalnego ryzyka to programy swobodne w zastosowaniu, do których zaliczyć można gry wideo czy filtr spamu. Co ciekawe większość systemów SI na terenie Unii Europejskiej należy właśnie do kategorii ryzyka minimalnego.

Istnieją jednak wyjątki pozwalające na korzystanie i wdrożenie nawet z systemów SI o niedopuszczalnym poziomie ryzyka. Wykorzystanie zdalnych systemów identyfikacji biometrycznej dopuszcza się w przypadku ścigania poważnych przestępstw, jednak aby do tego doszło niezbędnie jest uzyskanie zgody sądu. Innymi wyjątkowymi sytuacjami pozwalającymi na wykorzystywanie systemów SI wysokiego ryzyka są poszukiwania zaginionych osób lub zapobieganie zagrożeniu życia, lub bezpieczeństwa osób fizycznych czy też zapobieganie atakowi terrorystycznemu. Pomimo że w ramach możliwości wykorzystania systemów do pomiaru biometrycznego potrzebna jest zgoda organów władzy, sformułowanie zapobiegania przestępstwom wydaje się być przynajmniej niepokojące. W przypadku uzasadnienia chęci zapobiegania przewidywanym przestępstwom z jednej strony ważne byłby jawny i udokumentowany proces tego, na jakiej podstawie do spekulacji zbrodni dochodziło. Z drugiej strony trudno zapobiec zbrodni, jeżeli informacje na temat jej przeciwdziałania są jawne. Trudno też nie zauważyć, że jeżeli wiele systemów SI bazuje na pewnych stereotypach, również programy mające na celu zapobieganie zbrodniom nie będą również całkowicie obiektywne. Wydaje się to być kwestią wartą klarownego określenia.

Zdecydowanie ważnym elementem wszystkich rodzajów systemów SI i ich działania na terenie Unii Europejskiej w momencie wdrożenia dyrektywy w życie, jest wspomniana wyjaśnialność aparatów SI. Jawność, transparentność oraz zrozumiałość systemów SI jest kluczowa w zwalczaniu zarówno sytuacji niebezpiecznych, mogących negatywnie wpłynąć na osoby fizyczne, ich zdrowie, jak i życie, ale także zapobiec dyskryminacji. Na platformach takich jak na przykład TIkTok zauważymy już informację, ze dana treść jest wygenerowana przy pomocy systemu SI, co pozwala zarówno na rozwianie wątpliwości co do prawdziwości post’a, ale również skłania do refleksji nad tym jak szalenie rozwinięte i często bardzo realistyczne potrafią być twory generowane prze sztuczną inteligencje.

Postęp a etyka – czy Europa zostanie w tyle?

Jednym z głównych tematów dyskusji wokół AI Act jest obawa przed tym, że Europa może zostać w tyle za innymi regionami świata w zakresie innowacji technologicznych. W kwestiach rozwoju i innowacji technologicznych zarówno Stany Zjednoczone jak i Chiny pozostają na prowadzeniu, jednak UE staje się pionierem w kwestii regulacji oraz etyki związaną z systemami bazującymi na SI. Krytycy podważają sens i potrzebę dyrektywy, przyklaskując równocześnie elastyczności regulacji w Stanach Zjednoczonych czy Chinach, gdzie podejście do rozwoju technologii jest bardziej liberalne i sprzyja innowacjom. Brak rygorystycznych przepisów jak te zawarte w AI Act, pozwala, zdaniem krytyków, na szybsze wdrażanie nowych rozwiązań i adaptację do zmieniającego się rynku. Jednak jakim kosztem?

Obawy dotyczące zahamowania innowacyjności i rozwoju dotyczą szczególnie małych i średnich przedsiębiorstw, które mogą nie mieć zasobów potrzebnych do spełnienia rygorystycznych wymogów, przez krytyków sprowadzanych czasem do “nadmiernej biurokracji”. Kolejnym istotnym zarzutem jest brak wystarczających zabezpieczeń dla praw człowieka. Choć AI Act ma na celu ochronę obywateli przed nadużyciami, niektórzy eksperci wskazują, że regulacje są niewystarczające, aby skutecznie chronić prawa jednostek w kontekście algorytmicznych decyzji, takich jak te dotyczące zatrudnienia czy dostępu do usług publicznych. Krytyka dotyczy także klasyfikacji ryzyka. Mimo, że dyrektywa wprowadza podział systemów AI na różne kategorie ryzyka, system może być zbyt ogólny i nie uwzględniać specyfiki poszczególnych zastosowań AI, co doprowadzić może do zbyt łagodnego traktowania systemów o wysokim ryzyku i prowadzić do potencjalnych nadużyć, zwłaszcza przez dobrze prosperujące i usytuowane firmy gigantów technologicznych. Duże korporacje tworzące systemy oparte na SI, mogą wpływać na kształt regulacji w sposób korzystny dla siebie prowadzić do sytuacji, w której interesy mniejszych graczy zostaną zignorowane, a regulacje będą bardziej sprzyjały renomowanym już firmom. Krytycy zwracają uwagę na potrzebę globalnej koordynacji w zakresie regulacji AI. W miarę jak technologia ta staje się coraz bardziej powszechna, istnieje ryzyko, że zróżnicowane podejścia regulacyjne w różnych krajach mogą prowadzić do fragmentacji rynku, utrudniając współpracę międzynarodową.

Pomimo, że AI Act ma potencjał do ustanowienia standardów dla regulacji AI na świecie jak i do zwiększenia zaufania społecznego przez ochronę konsumentów korzystających z usług sztucznej inteligencji, skuteczność dyrektywy będzie zależała od umiejętności dostosowania przepisów do dynamicznie zmieniającego się krajobrazu technologicznego oraz od równoważenia potrzeb ochrony praw człowieka z koniecznością wspierania innowacji. Kluczowe będzie więc znalezienie równowagi między bezpieczeństwem a rozwojem oraz monitorowanie skutków wdrożenia regulacji dla konkurencyjności europejskiego rynku technologicznego.

Co dalej?

W obliczu szybkiego rozwoju technologii sztucznej inteligencji konieczne jest ciągłe monitorowanie skutków regulacji takich jak AI Act oraz ich wpływu na innowacje i rozwój gospodarczy. Dyrektywa dotycząca Sztucznej Inteligencji stanowi więc krok ku bardziej uregulowanemu i etycznemu podejściu do technologii SI w Europie. Wdrożenie aktu może być odpowiedzią na niskie zaufanie społeczne wobec sztucznej inteligencji, dając użytkownikom poczucie bezpieczeństwa poprzez wdrożenie konkretnych regulacji, jednak pozostają pytania dotyczące tego, jak dostosować przepisy do zmieniającego się krajobrazu technologicznego oraz jakie dodatkowe środki należy podjąć w celu zapewnienia bezpieczeństwa i ochrony praw obywateli. Ważne będzie również angażowanie społeczeństwa obywatelskiego w proces tworzenia regulacji oraz zapewnienie transparentności działań instytucji publicznych.

Bibliografia

- Lübken, J. (2024). The EU’s Artificial Intelligence Act: A golden opportunity for global AI regulation. European Leadership Network.

- IAB Polska. (n.d.). Przewodnik po AI. IAB Polska.

- Lex Digital. (n.d.). Kogo dotyczy i co reguluje AI Act. Lex Digital.

- Rada Unii Europejskiej. (2024). Artificial Intelligence (AI) Act: Council gives final green light to the first worldwide rules on AI.

- Ciosk (2022) Model systemowego przeciwdziałania dyskryminacji algorytmicznej–uwagi na tle projektu aktu w sprawie sztucznej inteligencji. Roczniki Administracji i Prawa, 2, 317-332

- Rojek, Azierski (2023) Wybrane algorytmy uczenia płytkiego w kontekście zastosowania w medycynie, Medycyna Przyszłości: rewolucja sztucznej inteligencji w opiece zdrowotnej, 20.

- Niewęgłowski, Wilczek, Madoń, Palmi, Wasyluk (2021) Applications of Artificial Intelligence (AI) in medicine. Med Og Nauk Zdr., 27(3), 213-219. https://doi.org/10.26444/monz/142085

- Skalski (2023) Rola sztucznej inteligencji w inżynierii społecznej jako podstawa do określenia wadliwości oświadczenia woli w postaci błędu, Prawo przyszłości i przyszłość prawa., 55.

- Gruszko (2021) Prawo do informacji w społeczeństwie czarnej skrzynki

- Otto (2022). Dyskryminacja algorytmiczna w zatrudnieniu. Zarys problemu. Studia z Zakresu Prawa Pracy i Polityki Społecznej, 29(2), 145-160.

- Stawicka (2023) Unijne rozporządzenie o sztucznej inteligencji nie wyeliminuje ryzyka nadużyć

- Padovan, Paulo Henrique, Clarice Marinho Martins, i Chris Reed (2023) Black Is the New Orange: How to Determine AI Liability. Artificial Intelligence and Law 31(1):133–67.

- Pawłowski (2023) Sztuczna inteligencja i jej systemy wysokiego ryzyka

- Komisja Europejska Ustawa o sztucznej inteligencji