Home » 2025

Yearly Archives: 2025

Zapobieganie przemocy domowej z wykorzystaniem danych kontekstowych i dźwięków z urządzeń mobilnych

Przemoc domowa pozostaje poważnym problemem społecznym, często ukrytym za zamkniętymi drzwiami. Według danych polskiej policji, w 2023 roku ofiarami przemocy domowej w Polsce było ponad 77,8 tys. osób, a liczba zidentyfikowanych sprawców przekroczyła 63 tys. – przy czym aż 74% ofiar stanowiły kobiety. Statystyki te pokazują skalę zjawiska i pilną potrzebę skutecznego przeciwdziałania. Jednym z innowacyjnych kierunków jest wykorzystanie nowych technologii – w szczególności powszechnie dostępnych smartfonów, inteligentnych głośników i innych urządzeń mobilnych – do automatycznej identyfikacji sytuacji zagrożenia przemocą domową. Urządzenia te, wyposażone w mikrofony oraz różnorodne czujniki, mogą pełnić rolę „cichych świadków” zdarzeń, wychwytując dźwięki przemocy (np. krzyki, odgłosy uderzeń) i dane kontekstowe (np. gwałtowne przyspieszenia, nietypową lokalizację czy porę zdarzenia) mogące wskazywać na akt przemocy.

Granica między realizmem a dziwacznością w robotach i systemach AI – ponowna analiza teorii „Uncanny Valley”

Zjawisko „uncanny valley” odnosi się do dyskomfortu lub niepokoju, jaki odczuwają ludzie w reakcji na obiekty, które są niemal – ale nie do końca – ludzkie w wyglądzie lub zachowaniu. Termin ten został wprowadzony przez japońskiego badacza Masahiro Moriego w latach 70. XX wieku, opisując wykres reakcji emocjonalnej na różne poziomy podobieństwa do człowieka. Im bardziej robot, animacja czy sztuczna inteligencja przypomina człowieka, tym bardziej jest nam przyjazna – aż do momentu, gdy staje się zbyt podobna, ale nadal nienaturalna. Wtedy reakcja staje się odwrotna – pojawia się niepokój, strach lub obrzydzenie. Efekt ten ma istotne znaczenie w robotyce, animacji komputerowej i projektowaniu interfejsów, ponieważ pokazuje, jak delikatna granica oddziela to, co realistyczne i akceptowalne, od tego, co wywołuje instynktowny lęk.

Quantified Self – wykorzystanie danych i sztucznej inteligencji do poprawy wydajności intelektualnej oraz wspomagania podejmowania decyzji. Architektura technologii, możliwości, wzywania i kwestie etyczne

Quantified Self – zastosowanie danych i sztucznej inteligencji do optymalizacji wydajności fizycznej. Architektura technologii, możliwości, wyzwania oraz dylematy etyczne.

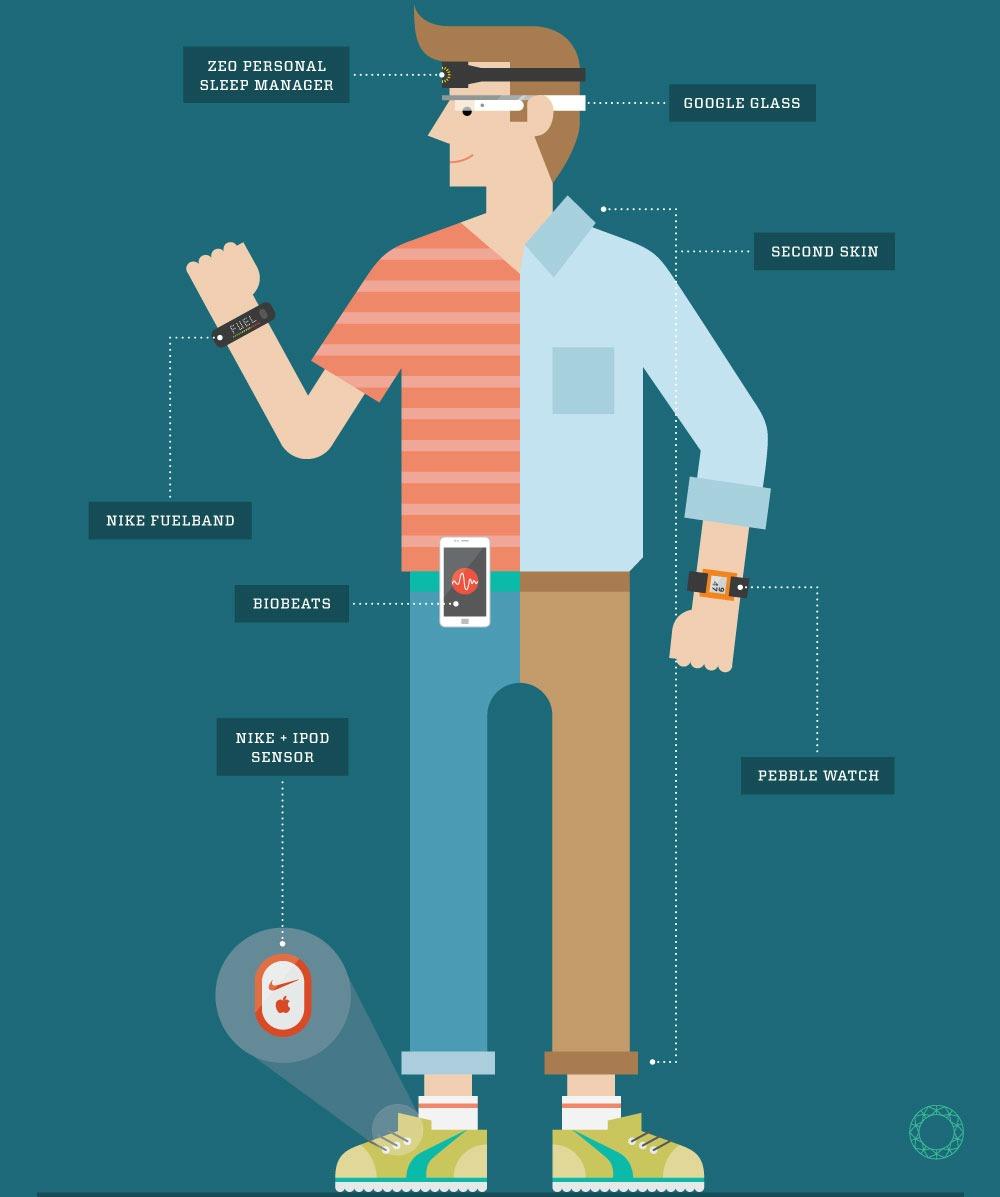

W ostatnich latach obserwujemy rosnące zainteresowanie tzw. Quantified Self – ruchem, który zakłada świadome gromadzenie i analizę danych o własnym ciele i zachowaniach, w celu lepszego zrozumienia siebie i poprawy jakości życia. Dzięki rozwojowi technologii noszonych (wearables), przystępności sensorów biologicznych oraz postępom w dziedzinie sztucznej inteligencji (AI), idea Quantified Self przeradza się z ciekawostki w potężne narzędzie do optymalizacji wydajności fizycznej – zarówno w kontekście sportu wyczynowego, jak i zdrowia codziennego.

Historia Quantified Self

W przeciwieństwie do innych trendów zorientowanych wokół sztucznej inteligencji Quantified Self nie jest czymś zupełnie nowym. Pierwsze opracowania i wystąpienia na temat Quantified Self możemy znaleźć nawet w 2010 roku, jak ten wykład TedTalks prowadzony przez Gary’ego Wolf’a:

Podobnie przeróżne zegarki i czujniki pomiarowe naszego ciała już dosyć dawno stały się częścią codzienności. Duży wpływ miały na to popularyzacja nowych form aktywności sportowej, takich jak squash, nordic walking czy fitness fusion (połączenie jogi, pilatesa i sztuk walki), aplikacje mobilne zorientowane na mierzenie i dzielenie się własnymi wynikami (Endomondo) jak i styl modowy athleisure (zestawianie ze sobą casualowych i sportowych elementów garderoby).

Architektura technologii Quantified Self

Aby zrozumieć, jak działa cały ekosystem QS, warto przyjrzeć się jego warstwowej architekturze technologicznej:

1. Warstwa sensoryczna (Data Capture Layer)

To wszystkie urządzenia i czujniki, które zbierają dane. Do najczęstszych należą:

- zegarki i opaski fitness,

- monitory pracy serca,

- sensory snu i aktywności,

- implanty medyczne i biosensory (np. do pomiaru glukozy),

- aplikacje mobilne do monitorowania nastroju, diety i treningów.

2. Warstwa przetwarzania danych (Data Processing Layer)

Zebrane dane są przesyłane do chmury lub lokalnych aplikacji, gdzie są:

- oczyszczane,

- integrowane z innymi źródłami,

- przetwarzane w czasie rzeczywistym lub wsadowo.

3. Warstwa analityczna (AI/Analytics Layer)

To tutaj pojawia się prawdziwa „magia”:

- modele uczenia maszynowego przewidują reakcje organizmu,

- systemy rekomendacyjne dostosowują plany treningowe i regeneracyjne,

- algorytmy analizują trendy, anomalie i korelacje (np. sen vs. wydolność).

4. Warstwa interfejsu użytkownika (UX Layer)

Użytkownik otrzymuje spersonalizowane informacje w formie:

- dashboardów,

- powiadomień push,

- wizualizacji postępów,

- chatbotów AI doradzających w czasie rzeczywistym.

Możliwości optymalizacji wydajności fizycznej

Dzięki tej architekturze użytkownik może osiągać konkretne korzyści, takie jak:

-

precyzyjne zarządzanie treningiem — urządzenia dostosowują intensywność ćwiczeń do aktualnej formy użytkownika (koniec z przypominaniem sobie własnych rekordów), a dzięki analizie zmienności tętna (HRV) pozwalają uniknąć przetrenowania i dodatkowo personalizują cele treningowe na podstawie historii i potencjału (50 kg na klatę let’s go).

-

optymalizacja snu i regeneracji — analiza faz snu i ich wpływu na wydajność przestaje być przypadkową rolką na Instagramie, a sugerowanie najlepszych godzin zasypiania (rytm cyrkadianowy, niestety koniec z nockami przed kompem), a także dobór diety i suplementacji poprawia regenerację i jakość naszego codziennego życia.

-

biofeedback i świadomość ciała — może to zabrzmieć futurystycznie, ale już teraz zegarek jest w stanie w czasie rzeczywistym monitorować twój poziom stresu, nastroju i reakcji emocjonalnych i zasugerować treningi oddechowe czy medytacje (być może udostępnianie podglądu do takich dashboardów osobom trzecim rozwiązałoby masę nieporozumień międzyludzkich, taka luźna teoria od autora).

Ryzyka i efekty aplikacji Quantified Self

Wiele aplikacji, które zostało stworzone do pomiarów i analizy danych sportowych zaczęło (szczególnie w ostatnich latach) mieć coraz większe zainteresowanie i znaczenie w życiu wielu osób. Spersonalizowane powiadomienia, analizy treningów, sugestie mogą zarówno pozytywnie jak i negatywnie wpływać na nasze samopoczucie i samoocenę. Oczywiście pozytywnym i głównym efektem i celem korzystania z tego typu narzędzi jest motywacja do zdrowszego trybu życia, jednak jest również wiele potencjalnych negatywnych efektów.

Negatywne efekty nadmiernego używania aplikacji Quantified Self:

Technostres i presja cyfrowa

Użytkownicy doświadczają presji wynikającej z porównywania swoich wyników oraz dostępności danych treningowych innych osób – komentarze, segmenty i „kudosy” mogą prowadzić do ambicji, ale też stresu. Świadomość, że inni obserwują naszą aktywność (widoczność cyfrowa), wzmaga chęć zaprezentowania się w jak najlepszym świetle – i często automatycznie podejmujemy działania mające na celu budowanie „digital self-image”, dokładnie ten sam problem jak np. „beauty standards” w innych social mediach tylko ukryty pod maską „sportowego i zdrowego” stylu życia, który jest uważany za „lepszy”. Budowanie poczucia własnej wartości często odbywa się poprzez porównanie z innymi. Takie porównania mogą prowadzić do zazdrości, poczucia niższości, a nawet izolacji społecznej.

„Ślepa wiara” (blind faith) w dane i internalizacja ocen

Aplikacja pokazuje liczby bez kontekstu: pomija czynności uwzględniające okoliczności zdrowotne (np. choroba, kontuzje, menstruacja), co może prowadzić do frustracji i poczucia porażki, gdy dane „nie pasują” do odczuć użytkownika. Użytkownicy traktują dane jak obiektywną prawdę. Jeśli wskaźniki są niskie, obniża się ich samoocena – czasem ignorując własne odczucia z treningu. W dodatku tak jak w social mediach — ludzie pokazują to co chcą pokazać — gorszych treningów, dodatkowych treningów wiele osób nie publikuje co też może u innych, którzy dzielą się wszystkim wywoływać poczucie np. bycia zdecydowanie słabszym/wolniejszym przy „tej samej ilości” treningów. Tak jak wrzucanie zdjęć wyłącznie z makijażem i filtrem.

Uzależnienie od danych

Część użytkowników przyznaje, że staje się zależna od powiadomień i statystyk; z czasem aktywność staje się mniej przyjemnością, a bardziej zdobywaniem kolejnych danych i potwierdzeń, w dodatku gorsze wyniki (starzenie się, kontuzje, wypadki, przerwy w sporcie) nasilają presję na poprawę „bo kiedyś było lepiej”.

Krytyka wzorców w „kwantyfikacji siebie”

Aplikacje jak Strava są projektowane przez młodszych, stale podnoszących wyniki użytkowników. Dla „starszych” mogą być mentalnie trudne – sugerują ciągły progres, stymulują poczucie porażki, przynoszą refleksję nad upływem czasu i utratą „prędkości szczytowej”. To skłania do myślenia o własnej śmiertelności.

W dodatku w wielu przypadkach mogą doprowadzać do uzależnień, niezdrowych przetrenowań i rywalizacji — która na koniec często okazuje się być rywalizacją z samym sobą.

Kampanie i popkultura

RAPP UK i Samsung UK uruchomili kampanię „Samsung Galaxy Watch4 Challenge” we współpracy ze Stravą. Realne osiągnięcia biegaczy ze Stravy zostały wykorzystane na cyfrowych billboardach — pełniły rolę „trenera”, motywując lokalne społeczności do bicia wyników. W akcji wzięło udział ponad 230 000 użytkowników, którzy łącznie zalogowali 4,2 miliona biegów, co znacząco przyczyniło się do wzrostu sprzedaży zegarka

Nieco luźniej powiązanym przykładem jest bieg Rossmanna, w którym w zależności od przebiegniętej trasy mierzonej przez aplikację dostaję się stosowny rabat do sieci drogerii. W całej Polsce w różnych edycjach wystartowało już prawie 190 000 osób, które uzbierały ponad 1,2 miliona złotych na cele charytatywne.

W szeroko rozumianej popkulturze oczywiście mamy całą masę odniesień, zaczynając od superbohaterów (Iron Man, Batman), przez protagonistów gier komputerowych (Cyberpunk 2077, Deus Ex), czy też filmy akcji (Mission Impossible). Największe

Wyzwania technologiczne i dylematy etyczne

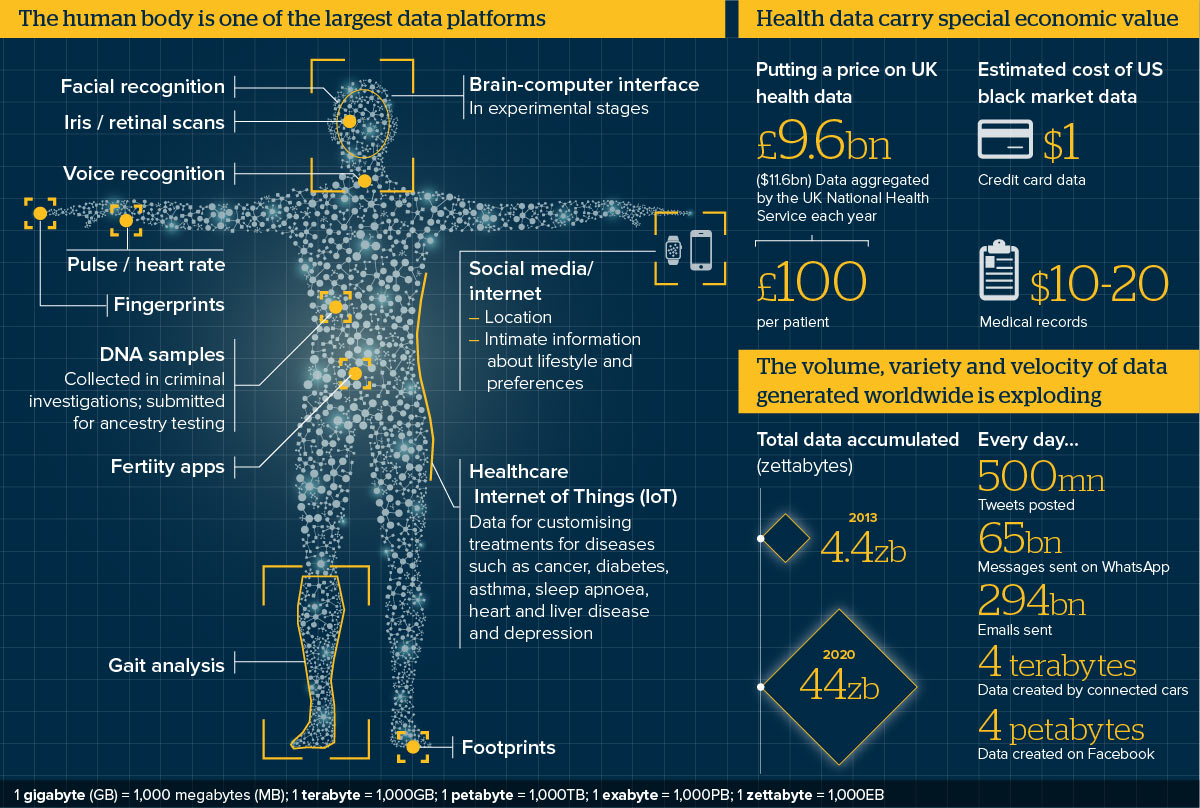

Mimo potencjału technologia QS mierzy się z wieloma barierami. Niemal każdy producent tworzy własne API, utrudniając integrację danych, więc przez brak jednolitych formatów danych ciężko przeprowadzić holistyczną analizę rozwoju branży. Nie jest to gałąź specjalnie oszczędna — zaawansowane sensory i przetwarzanie lokalne zużywają dużo energii, a krótkie czasy pracy urządzeń zniechęcają do regularnego używania. W dobie wprowadzania coraz to większych regulacji i obciążeń fiskalnych wynikających z przechodzenia na odnawialne źródła energii ciężko o korzystną koniunkturę do ekspansji dla tego typu urządzeń. Zupełnie innym problemem jest brak rzetelnej weryfikacji poprawności wskaźników różnych aplikacji: jakie pomiary biorą pod uwagę, jak często odświeżają dane, w jaki sposób tworzone są rekomendacje AI. Również większość użytkowników nie ma odpowiedniej wiedzy i doświadczenia do poprawnej interpretacji części swoich wyników. W dodatku równie istotna pozostaje kwestia prywatności, „podłączając” się do systemu automatycznie godziny się na czytanie i analizę naszych bardzo osobistych danych. Od naszego stanu zdrowia po lokalizację i rutynę dnia codziennego – gdzie i kiedy się przemieszczamy, gdzie mieszkamy itd.

Źródła:

The Beginner’s Guide to Quantified Self (Plus, a List of the Best Personal Data Tools Out There)

https://interconnected.org/home/2025/01/30/strava

https://pl.wikipedia.org/wiki/Quantified_Self

https://stock.adobe.com/search/images?k=teen%20depression

Prawne i etyczne aspekty sprzedaży i użytkowania seks-robotów o cechach nieletnich – czy prawo powinno całkowicie zakazać produkcji i dystrybucji robotów o wyglądzie dzieci i nastolatków, czy też takie praktyki mogą stanowić sposób na redukcję przestępstw na tle seksualnym wobec osób niepełnoletnich.

Seks-roboty same w sobie bywają tematem kontrowersyjnym, a kwestie etyczne i prawne stają się tylko trudniejsze, gdy zamiast dorosłych przypominają kształtem dzieci. Czy odruchowa odraza powinna być podstawą zakazów? Czy istnienie takich robotów może skrzywdzić prawdziwe dzieci, a może ocalić je przed krzywdą? Ten świat nie do końca jeszcze nadszedł, ale już warto się nad nim pochylić.

https://3dprint.com/wp-content/uploads/2015/04/3dp_smartdoll_insides_edit.jpg (więcej…)

Pokémon Go: Złap je wszystkie… z głową!

Rozwój technologii mobilnych i aplikacji opartych na rzeczywistości rozszerzonej, takich jak Pokémon Go, stawia nowe wyzwania w kontekście poszanowania miejsc o szczególnym znaczeniu, takich jak miejsca pamięci, obiekty sakralne czy instytucje edukacyjne, ponieważ obecność elementów gry w tych przestrzeniach może prowadzić do naruszenia ich powagi i funkcji edukacyjnej. W odpowiedzi na te zagrożenia instytucje i twórcy technologii podejmują działania ograniczające ich działanie w takich lokalizacjach.

Gry komputerowe, etyka i sztuczna inteligencja – metody AI do wykrywania nieetycznych, nielegalnych i destrukcyjnych zachowań w świecie gamingu.

Branża gamingowa mierzy się z bezprecedensowym wyzwaniem, gdyż wieloosobowe doświadczenia online stają się coraz bardziej rozbudowane i zaawansowane, jednocześnie jednak pozostają one podatne na złośliwe działania zagrażające bezpieczeństwu graczy i integralności branży. Szacuje się, że straty spowodowane przez oszustwa sięgają 6 miliardów dolarów w skali roku, a liczba przypadków cyberprzemocy wzrosła o 40% podczas pandemii COVID-19, co podkreśla pilną potrzebę wdrożenia zaawansowanych systemów wykrywania i prewencji destrukcyjnych zachowań. Sztuczna inteligencja stała się pierwszą linią obrony przed tym cyfrowym zagrożeniem, wykorzystując algorytmy uczenia maszynowego, przetwarzanie języka naturalnego i analizę behawioralną do identyfikowania wzorców toksyczności, oszustw, nadużyć finansowych i nękania w czasie rzeczywistym. Od systemu ToxBuster firmy Ubisoft, wykorzystującego architekturę transformatorów i uczenia głębokiego do wykrywania negatywnie nacechowanych treści w kontekście wypowiedzi, po rozwiązania AI osiągające 92,6% dokładności w wykrywaniu oszustw finansowych – te technologiczne innowacje wyznaczają nowy paradygmat w ochronie społeczności gamingowych przy zachowaniu immersyjnego charakteru rozgrywki.

Rosnące wyzwanie cyfrowych wykroczeń w grach

Współczesny krajobraz gier komputerowych przekształcił się w złożone wirtualne społeczeństwa, gdzie miliony graczy codziennie wchodzą w interakcje, tworząc zarówno przestrzeń dla pozytywnych relacji, jak i szkodliwych zachowań. Wieloosobowe gry online takie jak League of Legends, Counter-Strike, Call of Duty czy platformy metaverse stały się inkubatorami toksycznych interakcji wykraczających poza zwykłe sprzeczki w trakcie rozgrywki. Konsekwencje niekontrolowanych wykroczeń mają charakter wielowymiarowy, wpływając zarówno na pojedynczych graczy, jak i całe ekosystemy.

Badania przeprowadzone przez organizację Take This ujawniły bezpośrednią korelację pomiędzy toksycznością społeczności a sukcesem komercyjnym gry – tytuły promujące pozytywne środowiska odnotowały 54% wzrost przychodów w porównaniu z produktami dotkniętymi problemami behawioralnymi. Wskazany aspekt finansowy, w połączeniu z wiedzą iż gracze są znacznie bardziej skłonni porzucić grę w obliczu nadużyć, podkreśla kluczowe znaczenie utrzymania zdrowych środowisk gamingowych. Psychologiczne skutki toksycznych interakcji obejmują zwiększony stres, lęk i obniżoną satysfakcję, które mogą wpływać na dobrostan mentalny wykraczający poza kontekst rozgrywki.

Pandemia COVID-19 zaostrzyła te wyzwania, gdy środki dystansu społecznego napędziły rekordową popularność platform gamingowych. Ten wzrost aktywności zbiegł się z 40% zwiększeniem przypadków cyberprzemocy i toksyczności na popularnych platformach takich jak Discord. Objętość treści generowanych przez użytkowników across multiple kanałów komunikacji – czatu tekstowego, głosowego i elementów wizualnych – przytłoczyła tradycyjne metody moderacji oparte na manualnej weryfikacji i podstawowej filtracji słów kluczowych.

Wykrywanie toksyczności napędzane AI: rewolucja w moderacji czatu

Ewolucja systemów wykrywania toksyczności wykorzystujących AI stanowi jeden z najważniejszych postępów w technologiach bezpieczeństwa gamingowego. Współczesne rozwiązania wykraczają daleko poza proste blokowanie słów kluczowych, stosując zaawansowane techniki przetwarzania języka naturalnego analizujące kontekst, intencję i zniuansowane formy komunikacji. Muszą one nawigować w złożonym krajobrazie komunikacji gamingowej, gdzie żartobliwy przekaz konkuruje z autentycznym nękaniem.

System ToxBuster firmy Ubisoft ucieleśnia tę technologiczną ewolucję, wykorzystując algorytmy transformatorowe do analizy kontekstu słów i zwrotów w konwersacjach. To podejście pozwala systemowi odróżnić żartobliwą rywalizację od autentycznie toksycznych zachowań poprzez zrozumienie kontekstu rozmowy, a nie jedynie flagowanie pojedynczych wyrażeń. Architektura oparta na transformatorach umożliwia ToxBuster przetwarzanie czatu w czasie rzeczywistym przy zachowaniu wysokiej dokładności w identyfikacji szkodliwych treści, które mogłyby umknąć ludzkim moderatorom.

Wyzwania czasu rzeczywistego w wykrywaniu toksyczności obejmują rozmaite modalności komunikacji. Opracowany przez Modulate system ToxMod stanowi przełom w analizie komunikacji głosowej, stosując komponenty sztucznej inteligencji do transkrypcji i oceny rozmów między graczami. Zdolność przetwarzania komunikacji głosowej w czasie rzeczywistym wypełnia istotną lukę w tradycyjnych systemach moderacji, gdzie werbalne nadużycia często pozostają niewykryte w kanałach głosowych.

Badania ujawniły znaczące różnice domenowe pomiędzy toksycznością w mediach społecznościowych a zachowaniami specyficznymi dla gier. Benchmark ToxicChat, oparty na rzeczywistych zapytaniach użytkowników do chatbotów, pokazuje, że modele trenowane na treściach z social mediów często zawodzą w kontekście gamingowym. To odkrycie podkreśla konieczność rozwoju gamingowych zestawów danych i modeli zdolnych identyfikować unikalne wzorce toksycznych zachowań w środowiskach rozgrywki.

Zaawansowane systemy AI do wykrywania toksyczności łączą obecnie analizę multimodalną, integrując dane tekstowe, audio i behawioralne dla kompleksowej oceny zagrożeń. Stosują są rozbudowane, wielomodułowe podejścia z wieloma technikami embeddingowymi (GloVe, Emo2Vec, BERT) generującymi reprezentacje semantyczne i kontekstowe. Integracja uczenia ze wzmocnieniem pozwala tym systemom na ciągłą adaptację do nowych form toksycznych zachowań.

Wykrywanie oszustw: AI kontra cyfrowe oszustwa

Wyścig zbrojeń między oszustami a deweloperami osiągnął nowy poziom zaawansowania, gdzie systemy AI stały się najskuteczniejszą odpowiedzią na coraz bardziej wyrafinowane metody oszukiwania. Tradycyjne systemy anti-cheat, choć stanowią fundament wykorzystywanych w najnowszych produktach rozwiązań, okazują się niewystarczające wobec współczesnych technik manipulujących mechaniką gry, wykorzystujących luki bezpieczeństwa i stosujących automatyzację sterowaną przez sztuczną inteligencję.

Systemy wykrywania oszustw oparte na AI analizują wielowymiarowe wskaźniki behawioralne, identyfikując nienaturalne lub niemożliwe wzorce zachowań. Badają one dynamikę ruchów myszy, schematy celowania, czasy reakcji i pozycjonowanie w grze, tworząc unikalne „odciski behawioralne” graczy. Badania porównujące drzewa decyzyjne, maszyny wektorów nośnych i naiwne klasyfikatory bayesowskie wykazały, że dynamika myszy stanowi szczególnie efektywny wskaźnik autentyczności gracza, z drzewami decyzyjnymi osiągającymi najwyższą dokładność w identyfikacji uczciwych zachowań.

Sieci LSTM (Long Short-Term Memory) wykazują ogromny potencjał w wykrywaniu anomalii behawioralnych w konkurencyjnym środowisku gamingowym. Kompleksowe badania z wykorzystaniem danych z Counter-Strike: Global Offensive zademonstrowały, jak sieci LSTM mogą uchwycić zależności czasowe we wzorcach ruchów graczy, umożliwiając wykrywanie subtelnych anomalii wskazujących na oszustwa. Badania obejmowały wstrzykiwanie syntetycznych danych do autentycznych zestawów gameplayowych w celu trenowania modeli rozpoznających nieznane wcześniej wzorce oszustw.

Nowoczesne systemy anti-cheat wykraczają poza prostą analizę statystyczną, stosując podejścia deep learningowe identyfikujące złożone wzorce zachowań. Analizują współrzędne, znaczniki czasowe i informacje kontekstowe, tworząc kompleksowe modele behawioralne odróżniające wykwalifikowanych graczy od wspomagania sztuczną inteligencją. Zdolność do wykrywania anomalii w czasie rzeczywistym pozwala platformom na szybką reakcję, zachowując integralność rozgrywki przy minimalnej ingerencji w doświadczenie graczy.

System BattlEye, jeden z najpowszechniej wdrażanych rozwiązań anti-cheat, ilustruje integrację technik AI z tradycyjnymi środkami bezpieczeństwa. Działa jak ochronna tarcza wokół wspieranych gier, analizując wzorce zachowań i interakcje systemowe w celu wykrycia nieautoryzowanych modyfikacji. Ciągła ewolucja takich systemów odzwierciedla postęp technologiczny niezbędny do utrzymania przewagi nad coraz bardziej zaawansowanymi metodami oszustw.

Wykrywanie przestępstw finansowych w ekosystemach gamingowych

Integracja transakcji pieniężnych, wirtualnych ekonomii i systemów mikropłatności umożliwiła powstanie nowych wektorów nadużyć finansowych, wymagających zaawansowanych systemów detekcyjnych. Szacunkowa wartość rynku gamingowego sięgająca 150 miliardów dolarów czyni go atrakcyjnym celem dla oszustów stosujących metody od kradzieży danych płatniczych po złożone schematy prania pieniędzy.

Systemy AI do wykrywania oszustw finansowych analizują równolegle multiple strumienie danych: wzorce transakcyjne, zachowania gameplayowe, schematy tworzenia kont i fingerprinting urządzeń. Algorytmy uczenia maszynowego identyfikują podejrzane wzorce – szybkie zakładanie kont, duże zakupy, nietypowe geograficzne schematy transakcji czy anomalie behawioralne sugerujące przejęcie konta. Systemy muszą balansować między prewencją oszustw a doświadczeniem użytkownika, minimalizując wpływ na uczciwych graczy.

Integracja blockchaina i kryptowalut w grach wprowadziła dodatkową złożoność do wyzwań detekcyjnych. Framework MetaHate demonstruje synergię między AI a technologią blockchain w tworzeniu przejrzystych systemów moderacji. To podejście wykorzystuje algorytmy gradient boosting osiągające 86% dokładności w wykrywaniu szkodliwych treści, przy jednoczesnym zastosowaniu blockchaina dla transparentności i rozliczalności decyzji moderacyjnych.

Oszustwa chargebackowe stanowią szczególnie trudny rodzaj przestępczości finansowej w grach, gdzie legalne mechanizmy płatności są wykorzystywane do defraudacji. Badania z wykorzystaniem modeli k-NN do analizy historii transakcji i danych gameplayowych osiągnęły wyniki F1-Measure do 0,89 w wykrywaniu złośliwych wzorców chargeback. Systemy te badają schematy wykorzystanie kart pre-paid, częstotliwość chargebacków i timing transakcji w celu identyfikacji kont wysokiego ryzyka.

Zaawansowane systemy AI do detekcji oszustw finansowych stosują rozbudowane metody łączące uczenie nadzorowane, wykrywanie anomalii, widzenie komputerowe i uczenie ze wzmocnieniem do identyfikacji złożonych schematów oszustw takich jak liczenie kart, zmowy pomiędzy graczami czy manipulacje kontami. Badania wykazały 92,6% dokładności detekcji przy tych zintegrowanych podejściach, z istotną poprawą w klasteryzacji zachowań użytkowników dla adaptacyjnych środków bezpieczeństwa.

Mowa nienawiści i nękanie: rola AI w ochronie społeczności

Wykrywanie mowy nienawiści i ukierunkowanego nękania w środowiskach gamingowych wymaga systemów AI zdolnych rozumieć nie tylko explicite szkodliwy język, ale także zakodowane komunikaty, podteksty zawarte w kontekście i niuanse kulturowe różniące się między globalnymi społecznościami. Wyzwanie potęguje wielojęzyczny charakter współczesnych platform, gdzie gracze z różnych języków wchodzą w interakcje poprzez tekst, głos i elementy wizualne.

Framework MetaHate specjalizuje się w wykrywaniu mowy nienawiści w wielojęzycznych kontekstach gamingowych, stosując różne modele ML do analizy zestawów danych mieszających hindi i angielski. Badania pokazują, że algorytmy gradient boosting osiągają wysoką dokładność w detekcji mowy nienawiści, uwzględniając złożone wzorce lingwistyczne charakterystyczne dla wielokulturowych środowisk. Praca ta podkreśla znaczenie rozwoju systemów obsługujących językową różnorodność platform gamingowych.

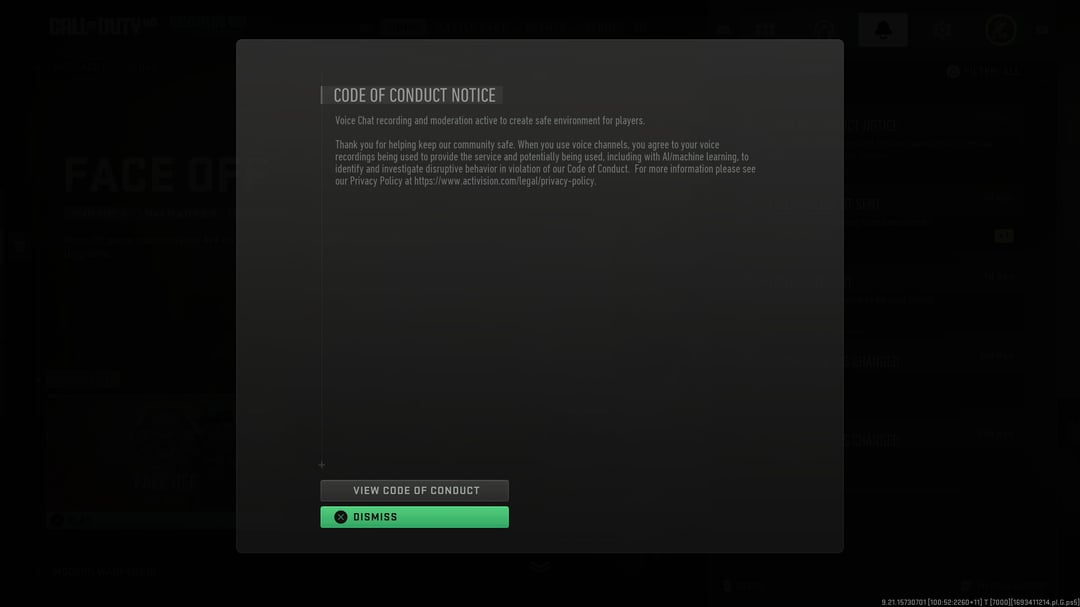

Zdolność przetwarzania w czasie rzeczywistym jest kluczowa dla efektywnego wykrywania mowy nienawiści, gdyż opóźnienia pozwalają szkodliwym treściom rozprzestrzeniać się i wyrządzać szkody. Nowoczesne systemy AI wykorzystują architektury oparte na transformatorach przetwarzające duże wolumeny danych tekstowych i głosowych w czasie rzeczywistym przy zachowaniu wysokiej dokładności. Muszą one odróżniać akceptowalną wymianę zdań w trakcie rywalizacji od autentycznych naruszeń standardów społeczności. System ToxMod, wykorzystywany już w takich grach jak Call of Duty, i GTA Online, stanowi przykład takiego rozwiązania, analizując niuanse głosu, wzorce mowy, stres i inne elementy, aby określić, czy użytkownik mówi coś toksycznego do innych członków lobby.

Integracja analizy behawioralnej z analizą treści okazała się szczególnie efektywna w identyfikacji wzorców nękania niewidocznych w pojedynczych komunikatach. Systemy AI śledzą wzorce komunikacyjne w czasie, wykrywając skoordynowane kampanie nękania, eskalację zachowań lub powtarzające się ataki na określone osoby/grupy. To holistyczne podejście pozwala platformom adresować zarówno oczywistą mowę nienawiści, jak i subtelniejsze formy przemocy.

Nowe technologie i przyszłe trendy

Przyszłość wykrywania zachowań w grach kształtuje kilka wyłaniających się trendów technologicznych obiecujących zwiększenie dokładności i wydajności systemów. Integracja edge computing z AI umożliwia szybszą reakcję i redukcję opóźnień, tym samym pozwalając na zachowanie płynności rozgrywki przy jednoczesnym zwiększeniu bezpieczeństwa.

Patent Sony dotyczący systemu wykrywania „złych aktorów” dla PlayStation 5 ilustruje ruch branży w kierunku kompleksowego monitoringu behawioralnego. System wykorzystujący uczenie maszynowe ma analizować wzorce zachowań graczy w czasie, oznaczając konta wykazujące niepokojące tendencje jak nadmierne opuszczanie rozgrywek, agresywne wiadomości na czacie czy nietypowe interakcje społeczne. Pomimo kontrowersji dotyczących prywatności, takie systemy reprezentują technologiczną granicę prewencyjnej moderacji.

Zastosowanie widzenia komputerowego w analizie rozgrywki wykracza poza tradycyjny monitoring tekstu i głosu. Rozwijane są systemy AI analizujące wizualne elementy rozgrywki, streamów i treści generowanych przez użytkowników w celu identyfikacji nieodpowiednich treści lub elementów wskazujących na potencjalne oszustwa. To multimodalne podejście tworzy kompleksowe możliwości monitoringu, stawiając nowe wyzwania w zakresie mocy obliczeniowej i prywatności.

Kolaboratywne systemy AI wymieniające zanonimizowane dane o zagrożeniach między platformami gamingowymi prezentowane są jako potężne narzędzie poprawy bezpieczeństwa branżowego. Umożliwiają zbiorową odpowiedź na nowe wzorce ataków przy zachowaniu bezpieczeństwa poszczególnych platform. Rozwój standardowych formatów wymiany danych zagrożeń będzie kluczowy dla efektywności tej współpracy.

Modelowanie predykcyjne reprezentuje kolejną granicę w detekcji zachowań, gdzie systemy AI identyfikują potencjalnie problematyczne konta na podstawie wczesnych wskaźników behawioralnych i schematów tworzenia kont. Choć obiecujące dla prewencji, wymagają precyzyjnego kalibrowania aby uniknąć fałszywych pozytywów negatywnie wpływających na graczy.

Wyzwania i kwestie etyczne

Implementacja systemów AI w grach rodzi istotne dylematy etyczne wymagające zbalansowania z korzyściami bezpieczeństwa. Kwestie prywatności są priorytetowe, gdyż kompleksowy monitoring wymaga zbierania i analizy szczegółowych danych o aktywnościach, komunikacji i zachowaniach graczy. Firmy gamingowe muszą opracować przejrzyste polityki dotyczące gromadzenia, przechowywania i wykorzystania danych, dostosowane do ewoluujących regulacji różnych jurysdykcji.

Ryzyko błędów algorytmicznych i biasu w systemach AI stanowi poważne wyzwanie, szczególnie w kontekście globalnych, zróżnicowanych społeczności. Systemy trenowane na danych nieadekwatnie reprezentujących pewne grupy społeczne, bądź niezawierających pełnego spektrum demograficznego mogą wykazywać tendencyjność wobec określonych grup. Badania i rozwój muszą priorytetyzować sprawiedliwość i inkluzywność w projektowaniu systemów i doborze danych treningowych.

Przejrzystość i rozliczalność automatycznych decyzji moderacyjnych pozostaje kontrowersyjna w społecznościach gamingowych. Gracze poddani automatycznym sankcjom często domagają się wyjaśnień i wskazania dowodów, co może być utrudnione jeżeli decyzja została podjęta przez złożony model AI. Rozwój sztucznej inteligencji dla moderacji będzie kluczowy dla utrzymania zaufania społeczności i powstania efektywnych procesów odwoławczych. Explainable AI (XAI) dla transparentnego wykrywania oszustw może pomóc w budowaniu zaufania graczy i zapewnieniu sprawiedliwości procesów moderacji.

Ciągłym wyzwaniem pozostaje również balans między automatyzacją nadzoru a zachowaniem kluczowego czynnika ludzkiego w łańcuchu decyzyjnym. Choć systemy AI przetwarzają ogromne wolumeny danych niemal w czasie rzeczywistym, ludzcy moderatorzy pozostają niezbędni dla skomplikowanych przypadków, niuansów kulturowych i procesów odwołań. Określenie optymalnego poziomu automatyzacji wymaga uwzględnienia możliwości technologicznych, oczekiwań społeczności i wymogów prawnych.

Podsumowanie

Integracja sztucznej inteligencji w systemach moderacji i zabezpieczeń w grach reprezentuje przełomową zmianę w podejściu branży do utrzymania bezpiecznych, sprawiedliwych i przyjemnych środowisk gamingowych. Od zaawansowanych systemów wykrywania toksyczności rozumiejących kontekst komunikacji po algorytmy analizujące biometrię behawioralną – technologie AI dostarczają platformom gamingowym bezprecedensowych możliwości identyfikacji i reagowania na szkodliwe działania w czasie rzeczywistym.

Sukces tych systemów zależy jednak nie tylko od postępu technologicznego, ale także od ich etycznej implementacji respektującej prywatność graczy, promującej sprawiedliwość i utrzymującej zaufanie społeczności. W miarę rozwoju branży, tworzenie etycznych, efektywnych i skalowalnych rozwiązań AI będzie kluczowe dla ochrony zarówno indywidualnych graczy, jak i całego ekosystemu. Kontynuacja współpracy między badaczami, deweloperami i społecznościami gamingowymi będzie niezbędna dla odpowiedzialnego wdrażania tych potężnych technologii.

Współczesne implementacje, takie jak HAWK, ToxMod czy MetaHate, pokazują, że technologia już dziś oferuje skuteczne rozwiązania dla najbardziej palących problemów branży gamingowej. Przyszłość bezpieczeństwa w grach leży w ciągłym udoskonalaniu i odpowiedzialnym zastosowaniu technologii sztucznej inteligencji zdolnych adaptować się do pojawiających się zagrożeń, przy jednoczesnym zachowaniu kreatywnych, konkurencyjnych i społecznych aspektów stanowiących o wartości gier jako formy ludzkiej interakcji i rozrywki. Poprzez odpowiedź na obecne wyzwania i antycypację przyszłych trendów, branża gamingowa może tworzyć środowiska, które będą zarówno bezpieczne, jak i przyjazne dla wszystkich uczestników, niezależnie od ich pochodzenia czy doświadczenia, a technologia służy do ochrony i wsparcia graczy, zamiast niepotrzebnej inwigilacji i ograniczenia.

Źródła:

https://montreal.ubisoft.com/en/ubisofts-new-tool-to-tackle-in-game-toxicity/

https://quix.io/blog/ai-anti-cheat-real-time-data-antidote-ai-driven-cheating-gaming

https://techwireasia.com/2023/08/how-does-unity-battle-toxicity-in-video-games-with-ai/

Cyfrowa nekromancja w polskim radiu

Dnia 22.10.2024 słuchacze Off Radio Kraków mieli przyjemność posłuchać wywiadu z wybitną polską poetką na temat literackiej Nagrody Nobla 2024. Nie byłoby w tym nic dziwnego, gdyby nie fakt, że dziennikarka nie istnieje, a respondentka nie żyje już od ponad dekady. (więcej…)

Revenge porn – jak technologia i prawo mogą chronić ofiary cyfrowej przemocy intymnej

Revenge porn – jak technologia i prawo mogą chronić ofiary cyfrowej przemocy intymnej

W erze wszechobecnych smartfonów i mediów społecznościowych, intymność stała się nie tylko łatwiejsza do uchwycenia, ale i niebezpiecznie podatna na wykorzystanie. Zjawisko znane potocznie jako „revenge porn”, czyli publikowanie prywatnych, intymnych zdjęć lub filmów bez zgody osoby na nich przedstawionej, jest brutalną formą cyfrowej przemocy, która niszczy życie, kariery i poczucie bezpieczeństwa ofiar. Dodatkowo, wraz z coraz bardziej zaawansowanymi i szeroko dostępnymi narzędziami sztucznej inteligencji, pojawiają się kolejne, niespotykane wcześniej zagrożenia, zaś samo ryzyko padnięcia ofiarą tego przestępstwa jest większe niż kiedykolwiek. Ten wpis zagłębia się w istotę problemu, jego historię i kontekst społeczny. Analizujemy również istniejące i potencjalne mechanizmy – zarówno instytucjonalne, jak i technologiczne – mające na celu identyfikację, ograniczanie oraz przeciwdziałanie tej formie nadużycia, a także wskazujemy, jak realnie wspierać osoby dotknięte tą traumą.

Identyfikacja i oznaczanie grafiki generowanej przez AI – od znaków wodnych po zaawansowane algorytmy głębokiego uczenia.

Czy to jeszcze człowiek, czy już maszyna? Po co oznaczać obrazy generowane przez AI i jak działa ich wykrywanie?

W dobie generatywnej sztucznej inteligencji granica między grafiką tworzoną przez człowieka a obrazem wygenerowanym przez algorytmy coraz bardziej się zaciera. W odpowiedzi na to wyzwanie powstaje wiele technologii mających na celu oznaczanie i wykrywanie treści syntetycznych. Dlaczego to takie ważne? Bo chodzi o ochronę praw autorskich, walkę z dezinformacją i budowanie zaufania do cyfrowych treści.

Dlaczego oznaczanie obrazów AI jest potrzebne?

-

Ochrona przed wykorzystaniem do treningu bez zgody

Twórcy nie chcą, by ich prace były wykorzystywane do trenowania AI bez ich wiedzy. Oznaczenia pomagają zidentyfikować pochodzenie grafiki i chronić oryginalność dzieła.

-

Przeciwdziałanie manipulacjom

Obrazy mogą być przerabiane i wykorzystywane do dezinformacji, np. w deepfake’ach czy fałszywych wiadomościach. Informacja o ich sztucznym pochodzeniu zmniejsza ryzyko nadużyć.

-

Oznaczanie i określanie obrazów wygenerowanych przez AI

Wprowadzenie jednoznacznych oznaczeń (np. znaków wodnych) oraz technologii detekcji pozwala odbiorcom rozpoznać treści stworzone przez sztuczną inteligencję i podejmować świadome decyzje jako odbiorcy.

Revenge porn – co zrobić krok po kroku? Wykorzystanie AI do ograniczenia dalszego rozpowszechniania materiałów.

Wprowadzenie

Revenge porn, czyli nieautoryzowane rozpowszechnianie intymnych materiałów (głównie zdjęć lub filmów) bez zgody osoby przedstawionej, to coraz powszechniejszy problem w erze cyfrowej. Termin ten odnosi się zarówno do sytuacji, w których były partner publikuje kompromitujące treści w Internecie z zamiarem zemsty, jak i do szerszych form niekonsensualnej pornografii. W ostatnich latach zjawisko to przybrało na sile z uwagi na rosnącą dostępność technologii, mediów społecznościowych i chmury obliczeniowej, co umożliwia natychmiastowe powielanie i rozpowszechnianie materiałów na całym świecie. (więcej…)

DeepFake jako narzędzie wojny hybrydowej – sposoby wykorzystania, przykłady oraz etyka „sprawiedliwej wojny” w kontekście nowych technologii.

Wojny na miecze ustąpiły miejsca wojnom na karabiny, te z kolei bombom – ale czy nadchodzi era wojen informacyjnych, w których bronią są obrazy i dźwięki, a nie proch i stal? Technologia rozwija się nie tylko w codziennym użytku, lecz również w obszarze konfliktów zbrojnych.

W tym wpisie nie skupimy się na tradycyjnym sprzęcie wojskowym, lecz na nowym, coraz powszechniej wykorzystywanym narzędziu prowadzenia wojny – technologii DeepFake i jej zastosowaniu w dezinformacji oraz propagandzie w kontekście wojny hybrydowej. (więcej…)

Zjawisko „paper mills” a wykorzystanie wielkich modeli językowych w pisaniu prac naukowych – mechanizmy działania i konsekwencje.

Rozwój sztucznej inteligencji postawił świat nauki przed nowym wyzwaniem: ,,fabryki prac’’ (ang. paper mills) zalewają literaturę naukową publikacjami pozorującymi rzetelne badania. Dzięki potędze dużych modeli językowych (LLM) generowanie przekonujących – choć fałszywych – artykułów stało się łatwiejsze niż kiedykolwiek. To zjawisko podkopuje zaufanie do nauki w podobny sposób, w jaki fake newsy i deepfake’i podważają wiarygodność informacji w społeczeństwie. Główny wniosek jest jasny: bez zdecydowanych działań organizacyjnych i technologicznych ryzykujemy kryzys wiarygodności nauki na niespotykaną skalę.

Słaba czy silna AI, AGI i superinteligencja – raj czy zagłada?

Słaba czy silna AI, AGI i superinteligencja – raj czy zagłada?

W dobie eksplozji możliwości AI każdy z nas zadaje sobie pytanie: czy rozwój sztucznej inteligencji poprowadzi nas ku technologicznej zagładzie, czy raczej otworzy drogę do utopijnej przyszłości? W poniższym wpisie omówimy różnicę między „słabą” (wąską) a „silną” sztuczną inteligencją (AGI), wyjaśnimy pojęcie superinteligencji i osobliwości technologicznej, a także zestawimy najbardziej optymistyczne i najbardziej pesymistyczne scenariusze – od rozwiązywania problemów ludzkości po groźbę wymarcia. Bazujemy na najnowszych analizach i raportach (2023–2025), łącząc ich wyniki w wieloaspektową ocenę etycznych i społecznych konsekwencji AI. (więcej…)

Benchmarking w analizie wielkich modeli językowych – wykrywanie biasów dotyczących płci, rasy, narodowości oraz preferencji seksualnych w generowanych treściach

Wielkie modele językowe (LLM – Large Language Models, takie jak GPT, Gemini czy Claude) odgrywają coraz większą rolę w komunikacji, edukacji, biznesie, badaniach naukowych i wielu innych obszarach życia codziennego. Algorytmy sztucznej inteligencji coraz częściej wpływają na decyzje mające realne konsekwencje społeczne. W związku z tym, oprócz oceny ich skuteczności i funkcjonalności, rośnie potrzeba analiza uprzedzeń (biasów) obecnych w generowanych treściach — dotyczących płci, rasy, narodowości oraz preferencji seksualnych.

Deepfake w pornografii — skala zjawiska, konsekwencje prawne i technologie przeciwdziałania

Rozwój sztucznej inteligencji otworzył przed ludzkością nowe możliwości, ale jednocześnie stworzył zagrożenia, których skali jeszcze do niedawna nikt nie przewidywał. Jednym z najbardziej niepokojących zjawisk jest wykorzystywanie technologii deepfake do tworzenia fałszywej pornografii z udziałem niczego nieświadomych osób, zarówno celebrytów, jak i zwykłych ludzi. Skala tego procederu rośnie lawinowo, a prawo w wielu krajach wciąż nie nadąża za tempem zmian.

(więcej…)

Zakłamanie historyczno-kulturowe w treściach generowanych przez AI – metody identyfikacji oraz strategie przeciwdziałania dezinformacji

Wprowadzenie

Wraz z rozwojem sztucznej inteligencji (AI), w szczególności modeli generatywnych, otworzyły się nowe możliwości tworzenia treści tekstowych, graficznych i audiowizualnych na niespotykaną wcześniej skalę. Narzędzia takie jak ChatGPT, DALL·E, Midjourney czy Sora umożliwiają generowanie obrazów, tekstów, a nawet całych filmów, bazując na prostych poleceniach użytkownika. Jednak ta demokratyzacja tworzenia treści wiąże się również z poważnym zagrożeniem — zakłamaniem historyczno-kulturowym i szerzeniem dezinformacji.

W tym artykule przyjrzymy się problemowi fałszywych lub wypaczonych reprezentacji wydarzeń historycznych i kultur w treściach generowanych przez AI. Zbadamy metody identyfikacji takich przypadków oraz strategie, które mogą pomóc w przeciwdziałaniu dezinformacji i zachowaniu integralności przekazu kulturowego.

Identyfikacja fake newsów w sieci na podstawie analizy tekstu – metody wykrywania i oznaczania nieprawdziwych informacji

Czym są fake newsy i dlaczego są niebezpieczne?

Fake newsy, czyli fałszywe informacje rozpowszechniane w formie wiadomości, to celowo wprowadzające w błąd treści, które podszywają się pod wiarygodne źródła. Ich forma może być różnorodna: od całkowicie zmyślonych artykułów, poprzez zmanipulowane cytaty, po wyrwane z kontekstu fakty. (więcej…)

Identyfikacja fake newsów w mediach społecznościowych – strategie wykrywania, klasyfikacji i oznaczania dezinformacji

Fake newsy to fałszywe lub wprowadzające w błąd informacje. Ich publikacja nie jest nowym zjawiskiem. Wraz ze wzrostem znaczenia środków masowego przekazu dezinformacja także zyskała na znaczeniu. W dobie internetu dostępne są bezprecedensowe możliwości rozprzestrzenianiu fake newsów. Sieci botów na mediach społecznościowych mogą z wykorzystaniem sztucznej inteligencji tanio generować rzędy wielkości więcej treści niż normalni użytkownicy w celu wybranym przez osobę lub organizację nimi zarządzającą.

(więcej…)

[…] poprzednim artykule skupiliśmy się na seks robotach w ogólności, a także na najpopularniejszej formie tego […]