Coraz częściej pojawiają się narzędzia oparte na sztucznej inteligencji, które obiecują rozpoznawać ludzkie emocje na podstawie mimiki twarzy. Choć brzmi to atrakcyjnie – warto się na chwilę zatrzymać i zadać pytanie: czy naprawdę da się „odczytać” emocje z twarzy? Większość tych systemów opiera się na analizie powierzchownych zmian mimicznych, a mimika to nie to samo co stan wewnętrzny człowieka. Pojawiają się pytania o prywatność, wiarygodność i potencjalne nadużycia takiej technologii, co rodzi konieczność wprowadzenia odpowiednich zasad, regulacji i standardów.

Inteligencja emocjonalna, a informatyka afektywna

Inteligencja emocjonalna (ang. Emotional Quotient, EQ) to zdolność rozpoznawania emocji – własnych i cudzych – oraz odpowiedniego reagowania na nie. U ludzi wysoka EQ oznacza empatię, umiejętność odczytywania sygnałów niewerbalnych (jak wyraz twarzy czy ton głosu) i zarządzania emocjami w relacjach. W kontekście sztucznej inteligencji, zajmuje się tym zagadnieniem informatyka afektywna (ang. affective computing) – interdyscyplinarna dziedzina na pograniczu informatyki, psychologii i kognitywistyki, która bada i tworzy systemy potrafiące rozpoznawać, interpretować oraz symulować ludzkie emocje. Zapoczątkowana pod koniec lat 90, pracami Rosalind Picard z MIT, informatyka afektywna stawia sobie za cel wypełnienie luki między ludzkimi uczuciami a reakcją maszyn. Jedną z motywacji jest wyposażenie komputerów w zdolność do rozumienia naszych emocji (a nawet symulowania empatii) i reagowania w sposób uwzględniający stan emocjonalny człowieka. Przykładowo, asystent głosowy mógłby wyczuć po tonie głosu frustrację użytkownika i zmodyfikować swój sposób komunikacji.

Aby maszyny mogły „wyczuwać” emocje, muszą najpierw wykrywać sygnały emocjonalne. Ludzie komunikują emocje m.in. poprzez ekspresje twarzy, język ciała, głos (intonacja, tempo mowy) czy reakcje fizjologiczne (np. pocenie się dłoni). Systemy AI mogą zbierać takie dane za pomocą sensorów – kamery rejestrują mimikę i gesty, mikrofony – cechy głosu, a niekiedy sensory noszone mierzą np. puls czy przewodność skóry. Następnie algorytmy uczą się wzorców w tych sygnałach, które odpowiadają określonym emocjom. Przykładowo, marszczenie brwi może zostać zinterpretowane jako oznaka skupienia lub konfuzji, zaś szczery uśmiech – jako radość. Ważne jest jednak zastrzeżenie: etykiety emocji nadane przez algorytm (np. „złość” czy „smutek” na podstawie wyrazu twarzy) nie zawsze muszą odpowiadać rzeczywistemu stanowi wewnętrznemu osoby. Ta niepewność kryje się u podstaw wielu wyzwań omawianych dalej.

Mikroekspresje: obietnica, która przerosła naukę

Paul Ekman w latach 70. zaproponował, że istnieje kilka uniwersalnych emocji podstawowych (np. radość, smutek, strach, złość), a związane z nimi mikroekspresje twarzy są identyczne u ludzi niezależnie od kultury. Jeśli ktoś próbuje ukryć emocję – twierdzi Ekman – mimowolny mikrogrymas i tak „przecieknie” na ułamek sekundy, demaskując prawdę. Ta hipoteza zafascynowała służby i opinię publiczną. Rozwinięto nawet narzędzia treningowe, takie jak Micro Expressions Training Tool (METT), by uczyć funkcjonariuszy rozpoznawania tych sygnałów. Wydawało się, że dzięki temu policjant czy agent bezpieczeństwa stanie się ludzkim wariografem, zdolnym wychwycić kłamstwo z drgnięcia kącika ust.

Przykład zdjęć przedstawiających emocje według teorii Ekmana (źródło)

Niestety, naukowa weryfikacja tej teorii wypada bardzo sceptycznie. Badania nie potwierdzają, by mikroekspresje umożliwiały niezawodne wykrywanie kłamstwa. W 2019 r. zespół pod kierunkiem prof. Lisy Feldman Barrett przeanalizował wyniki ponad 1000 badań dotyczących wnioskowania o emocjach z mimiki. Konkluzja była jednoznaczna:

„Nie da się z wystarczającą pewnością wnioskować o szczęściu na podstawie uśmiechu, o złości na podstawie grymasu gniewu czy o smutku na podstawie grymasu niezadowolenia, wbrew temu, co obecna technologia usiłuje czynić, opierając się na rzekomo naukowych faktach”.

Innymi słowy, założenie o prostym, uniwersalnym „kodzie emocji” na twarzy jest błędne. Ekmanowska wizja zbyt mocno upraszcza złożoność ludzkich uczuć – wyraz twarzy zależy nie tylko od emocji, ale i od kontekstu, kultury czy indywidualnych różnic. Osoby mogą uśmiechać się ze stresu lub zaciskać szczękę z koncentracji – mimika jest zbyt niejednoznaczna, by czytać z niej intencje niczym z otwartej książki.

Negatywne skutki teorii Ekmana

W środowisku naukowym teoria mikroekspresji spotkała się z solidną krytyką. Wielokrotnie podważano jej rzetelność eksperymentalną. Przykładowo, rząd USA zainwestował blisko miliard dolarów w program TSA o nazwie SPOT (Screening Passengers by Observation Techniques), oparty częściowo na założeniach Ekmana. Agenci na lotniskach byli szkoleni, by obserwować podróżnych i na podstawie sygnałów niewerbalnych (np. mikroekspresji, „dziwnego” zachowania) wytypować potencjalnych terrorystów. Rezultaty okazały się katastrofalne: wewnętrzny audyt wykazał, że spośród ~30 tysięcy osób zatrzymywanych co roku w ramach SPOT, zaledwie 1% było aresztowanych – i to głównie za drobne przewinienia (np. posiadanie niedozwolonych przedmiotów), ani jednego terrorysty. Byli pracownicy lotnisk alarmowali, że program stał się usprawiedliwieniem dla profilowania rasowego – na jednym z lotnisk aż 80% typowanych „podejrzanych” stanowili przedstawiciele mniejszości etnicznych. Innymi słowy, SPOT nie wykrywał terrorystów, za to nękał niewinnych ludzi, często kierując się uprzedzeniami zamiast realnych przesłanek.

Co gorsza, analiza ponad 400 badań nad wykrywaniem kłamstwa, przeprowadzona przez amerykańską instytucję GAO (Government Accountability Office), wykazała że przeciętny człowiek wykrywa oszustwo z trafnością ~54%, a więc ledwie powyżej przypadku. Szkolenia z mikroekspresji nie podnoszą istotnie tej skuteczności – niezależne testy METT dowiodły, że osoby po takim treningu nie radzą sobie lepiej niż ludzie po szkoleniu placebo lub bez żadnego. W eksperymencie z 2019 r. grupa badanych po kursie METT osiągnęła wyniki nielepsze od zgadywania, a nawet gorsze – losowy wybór dałby nieco wyższą skuteczność. Badacze komentują wręcz, że trening mikroekspresji „nie maluje optymistycznego obrazu co do jego użyteczności”. Jeden z autorów badań, dr Chris Street, stwierdził wprost:

„Ekipa Ekmana twierdzi, że te mikroekspresje pomagają wykrywać kłamstwa. Ale tak naprawdę brak na to dowodów. Problem w tym, że [mimo to] zostało to wdrożone do użytku rządowego w USA”.

Fałszywe alarmy i niesłuszne oskarżenia są naturalną konsekwencją przeceniania mikroekspresji. Jeśli śledczy czy policjant jest przekonany, że drobny grymas zdradził czyjeś kłamstwo lub złe zamiary, może niesłusznie skoncentrować podejrzenia na niewinnej osobie. Takie błędne wyroki intuicji potrafią eskalować: niewłaściwie oskarżeni bywają poddawani ostrym przesłuchaniom, a nawet niesłusznie skazywani, bo „ekspert od mowy ciała” uznał ich zachowanie za podejrzane. Psycholog Maria Hartwig zauważa, że nie istnieją jednoznaczne oznaki kłamstwa w mimice, a próby ich doszukiwania się to jak szukanie igły w stogu siana – łatwo o pomyłkę. Widzieliśmy to w programie SPOT: zdenerwowanie pasażera mogło wynikać ze strachu przed lataniem lub stresu związanego z kontrolą, a nie z planowania zamach. Gdy błędna teoria zyskuje status dogmatu, ofiarami stają się zwykli ludzie – ofiary niesprawiedliwości wynikłej z naukowej pomyłki.

Sztuczna inteligencja dziedziczy błędne założenia

Mimo wątpliwej wiarygodności koncepcji Ekmana, jej echo pobrzmiewa dziś w dziesiątkach systemów AI do automatycznego rozpoznawania emocji. Wielkie korporacje technologiczne i start-upy ochoczo wdrożyły pomysł, że maszyna z kamerą może czytać nasze uczucia z twarzy. Microsoft oferował w swojej usłudze Face API rozpoznawanie ośmiu emocji ze zdjęcia (m.in. złość, pogarda, strach, szczęście). Podobne funkcje deklarował Amazon w systemie Rekognition. W 2016 r. Apple kupił firmę Emotient, chwalącą się algorytmami „wykrywającymi emocje” na podstawie zdjęć. Startup Affectiva (wywodzący się z MIT) zgromadził ogromną bazę 10 milionów twarzy z 87 krajów, by uczyć AI rozpoznawania reakcji emocjonalnych – m.in. do analiz marketingowych i monitorowania kierowców pod kątem dekoncentracji. Wreszcie w branży rekrutacyjnej pojawiły się systemy, które na podstawie mikroekspresji, tonu głosu i mowy ciała oceniają kandydata do pracy. Głośnym przykładem był system HireVue, używany przez takie firmy jak Goldman Sachs czy Unilever – analizował nagrania wideo z rozmów kwalifikacyjnych, by „obiektywnie” ocenić dopasowanie kandydata. Przez kilka lat HireVue chwaliło się tym rozwiązaniem, zanim pod naporem krytyki naukowców i organizacji praw obywatelskich wycofało w 2021 moduł analizy twarzy (choć wciąż oceniało głos).

Wszystkie te systemy opierają się na tych samych kruchych fundamentach: zakładają istnienie niewielkiej liczby uniwersalnych emocji, które mimowolnie przejawiają się na twarzy, oraz że algorytm potrafi je niezawodnie rozpoznać. To założenia wprost z teorii Ekmana. Niestety, jak już wiemy, są one co najmniej dyskusyjne. A jednak, na fali entuzjazmu wobec AI, przeszły one niemal bezkrytycznie do kodu algorytmów. W efekcie powstają systemy działające jak czarna skrzynka – analizujące nasze twarze w sposób nieprzejrzysty dla użytkownika – i wydające werdykt emocjonalny: „ten uczeń jest znudzony”, „ten kandydat przejawia brak pewności siebie”, „ten pasażer zachowuje się podejrzanie”. Problem w tym, że brakuje dowodów naukowych, by te werdykty były trafne. Wiele firm sprzedających takie rozwiązania twierdzi, że ich AI osiągnęła „skuteczność w rozpoznawaniu emocji”, ale niezależne badania mówią co innego. Lisa Feldman Barrett podsumowuje to dobitnie:

„Firmy mogą twierdzić co chcą, ale dane są jasne: wykryją grymas na twarzy, ale to nie to samo co wykryć złość”.

Innymi słowy, algorytm widzi na twarzy np. zmarszczone brwi i na tej podstawie zgaduje stan wewnętrzny – co bywa niczym wróżenie z fusów.

Ślepa wiara w algorytmiczną wyrocznię

Mamy więc do czynienia z sytuacją, w której technologia odziedziczyła błędy teorii, a mimo to bywa traktowana z nieuzasadnioną ufnością. Istnieje znane zjawisko automatyzacji osądu (ang. automation bias), polegające na tym, że ludzie mają tendencję przeceniać nieomylność komputerów. Skoro „inteligentny system” dał swoją ocenę, to musi to być prawdą – tak rozumuje wiele osób korzystających z AI. Niestety, ta ślepa wiara potrafi mieć opłakane skutki. W eksperymencie naukowym z 2024 r. badani mieli podjąć symulowaną decyzję o życiu i śmierci – i aż 2/3 z nich zmieniło swoją decyzję, gdy robot doradził inaczej, choć uprzedzono ich, że AI może się mylić (w rzeczywistości porady robota były losowe). Badacze określili to jako „niepokojąco nadmierne zaufanie do AI”. Innymi słowy, ludzie często automatycznie przyjmują wyrok algorytmu, rezygnując z własnej oceny sytuacji – nawet gdy stawka jest wysoka.

Gdy przeniesiemy to na grunt systemów rozpoznawania emocji, obraz staje się groźny. Wyobraźmy sobie kandydata, który został odrzucony w procesie rekrutacji, bo algorytm HireVue wyliczył niski „współczynnik entuzjazmu” na podstawie mikroekspresji. HRowiec, ufając technologii, nawet nie kwestionuje wyniku – wierzy, że komputer „obiektywnie” ocenił kandydata. Kandydat nie ma nawet świadomości, że przegrał z algorytmem, więc nie może się odwołać od decyzji. Podobnie student w klasie przyszłości: kamera analizuje jego twarz podczas lekcji i oprogramowanie ocenia, że jest „niecierpliwy” lub „niezaangażowany”. Nauczyciel otrzymuje raport i zaczyna traktować tego ucznia inaczej, może surowiej – w końcu „system widzi, że coś jest z nim nie tak”. Brzmi jak dystopia? To dzieje się już dziś.

Emocje a mięśnie twarzy

Jak wspomniano wcześniej, mikro ekspresje zostały „odkryte” przez Ekman-a i Friesen-a w 1969 r. W jednym z badań, które prowadzili przeprowadzana była analiza prawdziwych uczuć pacjenta. W przeprowadzanej obserwacji pacjent próbował ukryć smutek uśmiechem, dzięki mikro ekspresjom psychologowie zdołali odkryć jego prawdziwe emocje a później nawet fakt, że badany planował popełnić samobójstwo. Takie obserwacje zapoczątkowały rozwój nauki nad związkiem stanów emocjonalnych z ruchami mięśni twarzy. Ustanowili oni także Facial Action Coding System (FACS), system kodowania emocji za pomocą ruchów mięśni twarzy. Poniższa tabela przedstawia przykładowe akcje.

| Numer AU | Opis | Nazwa mięśni twarzy | Przykład |

| 4 | Opuszczenie brwi | Depressor Glabellae, Depressor Supercilli, Currugator |  |

| 2 | Podniesienie brwi zewnętrznej (jednostronne, strona prawa) | Frontalis, pars lateralis |  |

| 6 | Podnoszenie policzków | Orbicularis oculi, pars orbitalis |  |

Kodowanie przykładowych emocji.

| Emocja | AUs | Opis | Przykład |

| Szczęście, radość | 6+12 | Podnoszenie policzków, ściąganie kącików ust |

|

| Pogarda | 12+14 | Ściąganie kącików ust, pogłębianie dołeczków |

|

Mniej znaczy lepiej – Czy 2 klatki wystarczą aby uchwycić emocje?

W pracy z 2018 r. „Less is More: Micro-expression Recognition from Video using Apex Frame” autorzy przedstawiają podejście, w którym odczyt emocji z krótkiego filmu jest podejmowany na podstawie 2 wybranych najważniejszych klatek. Rozróżniają oni makro ekspresje, które są łatwo i naturalnie identyfikowane w codziennych sytuacjach. Taka ekspresja trwa zazwyczaj 2-3 sekundy i obejmuje praktycznie całą twarz. Z kolei mikro ekspresje, trwają krócej (1/5 – 1/25 sekundy), są bardziej subtelne i pojawiają się w kilku rejonach twarzy. Takie drobne, mikro ekspresje są trudne do zauważenia nawet dla ludzi, choć często mogą okazać się kluczowe i odsłonić prawdziwe intencje danej osoby.

Dzięki systemowi FACS (Facial Action Coding System) możliwe jest ustalenie kiedy dana akcja (emocja) (AU – action unit) się zaczyna i kończy. Wyróżniane są 3 najważniejsze klatki AU onset – początek, offset- koniec i apex – klatka o największej intensywności ruchu twarzy. Rozróżnienie emocji jest podejmowane na podstawie pierwszej klatki i klatki apex.

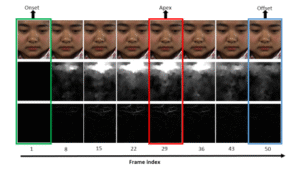

Kolejne klatki przedstawiające mikro ekspresje twarzy.

Ilustracja przedstawia: (górny rząd) oryginalne obrazy; (środkowy rząd) moduł przepływu optycznego obliczony między klatką początkową (onset) a kolejnymi klatkami; oraz (dolny rząd) odkształcenie optyczne obliczone między klatką początkową a kolejnymi klatkami.

Moduł przepływu optycznego (Optical Flow Magnitude) to o technika służąca do obliczania ruchu pikseli między kolejnymi klatkami w sekwencji wideo. Dla każdego piksela określa się wektor ruchu (kierunek i prędkość przesunięcia). Moduł przepływu optycznego to długość (wartość bezwzględna) tego wektora — czyli jak bardzo piksel się przemieścił, niezależnie od kierunku.

Odkształcenie optyczne (Optical Strain) mierzy zmiany w deformacji powierzchni (np. skóry twarzy), wynikające z wektorów przepływu optycznego. Uwzględnia nie tylko przemieszczenie, ale też to, jak sąsiadujące piksele względem siebie się rozciągają, kurczą lub skręcają. Obliczane na podstawie gradientów (pochodnych) składowych przepływu optycznego.

Jak znajdowana jest klatka apex?

-

Wykrycie punktów charakterystycznych twarzy. Wyznaczane są punkty orientacyjne (landmarki) na twarzy w każdej klatce.

-

Wyodrębnienie regionów zainteresowania (ROI). Na podstawie współrzędnych landmarków wybierane są obszary twarzy zawierające najwięcej informacji o mikroekspresji.

-

Ekstrakcja cech każdej klatki. Dla każdej klatki (od onset do offset) obliczane są cechy przy użyciu deskryptora LBP (Local Binary Patterns).

-

Obliczenie różnic cech względem klatki onset. Dla każdej klatki obliczana jest różnica cech względem klatki początkowej (onset) za pomocą współczynnika korelacji.

-

Zastosowanie strategii „dziel i zwyciężaj” (divide-and-conquer)

Jak rozpoznać mikro ekspresję na podstawie tylko dwóch klatek?

- Dla każdego piksela obliczamy przepływ optyczny, jak bardzo i w którą stronę się przemieścił.

- Dla każdego piksela obliczamy odkształcenie optyczne, jak bardzo zmieniła się lokalna struktura, np. rozciąganie, zgniatanie twarzy.

- Budujemy histogram Bi-WOOF

-

- Tworzymy N binów (np. 0–20°, 20–40°, …, 160–180°).

- Wartość każdego bina to suma Hi = M⋅S ( – magnituda piksela, – optical strain piksela).

Taka technika lepiej wyodrębnia mikro ekspresje, które są krótkie i subtelne, ale mają znaczący wpływ na określone obszary twarzy. Lokalne ważenie magnitudą → piksele o większym ruchu mają większy wpływ. Globalne ważenie odkształceniem optycznym → regiony o większym rozciągnięciu/naprężeniu mają większy wpływ na całość.

Porównanie wyników

Zestawienie wyników różnych metod rozpoznawania mikro ekspresji, w zależności od różnych zbiorów danych, metryka f1-score.

Przedstawione wyniki wskazują, że podejścia oparte o analizę tylko 2 klatek przynoszą dobre wyniki. Najlepsze rezultaty daje omawiane metoda, która uwzględnia 2 klatki, przesunięcia pikseli oraz zmianę lokalnych struktur pikseli. Co prawda sam wynik około 0.6 f1-score nie jest zbyt wysoki, aczkolwiek w kontekście dość trudnego zagadnienia jakim są mikro ekspresje jest to całkiem dobry wynik.

Podsumowanie

Analiza mikro ekspresji twarzy i na jej podstawie wnioskowanie o emocjach jest nawet dzisiaj wyzwaniem dla sztucznej inteligencji. Sama złożoność i liczność mięśni i nerwów twarzy pozwala człowiekowi okazywać emocje w bardzo skomplikowany sposób. Taka analiza jest wyzwaniem dla ludzi więc o ile większym musi być dla ai. Ponadto o ileż bardziej złożona jest psychika i sfera emocjonalne człowieka niż jego zdolności mimiczne?

„Wielką tajemniczą przepaścią jest człowiek, o Panie! Tyś policzył włosy na jego głowie i żaden nie spadnie bez Twej woli. Ale łatwiej zliczyć jego włosy, niż jego uczucia i poruszenia jego serca.” – wyznania św. Augustyn.

Wykorzystanie zdolności sztucznej inteligencji do analizy stanów emocjonalnych człowieka jak w wielu podobnych przypadkach wydaje się być mieczem obusiecznym. Udział ai w opiece psychologiczno-psychiatrycznej może wspomóc diagnozowanie i prowadzenie terapii. Natomiast monitorowanie emocji w godzący w prywatność sposób daje przestrzeń do licznych nadużyć.

Bibliografia

- Artificial Intelligence Is Misreading Human Emotion (2021).

The Atlantic - Facial expressions are not universal indicators of emotion (2020).

Wiley Online Library. - Study: People Facing Life-or-Death Choice Put Too Much Trust in AI (2024).

UC Merced – Cognitive & Information Sciences. - Emotion AI and the Problem of Misreading Humans (2025).

AI & Society (Springer). - Behavioral Indicators Used for Spotting Terrorists Are Unreliable (2013).

U.S. Government Accountability Office (GAO-14-159). - HireVue Removes Facial Analysis from AI-Driven Hiring Tools (2021).

Talent Tech Labs. - A Test of the Micro-Expressions Training Tool: Does It Improve Lie Detection? (2019).

Journal of Investigative Psychology and Offender Profiling. - Accuracy of Deception Judgments (2006).

Personality and Social Psychology Review. - How Do People React to AI Failure? (2022).

Journal of Computer-Mediated Communication. - Less is More: Micro-expression Recognition from Video using Apex Frame (2018).

- Facial Action Coding System (FACS), wpis na bogu.