Identyfikacja stronniczości (biasów), nieścisłości oraz błędów w dużych modelach językowych w językach nie opartych na alfabecie łacińskim (np. chińskim, japońskim, arabskim czy hindi). Identyfikacja kulturowych biasów, strategie działania z wykorzystaniem narzędzi AI dla osób nieposługujących się tymi językami

Czy naprawdę wiesz, co AI rozumie, gdy mówisz po arabsku albo japońsku?

Sztuczna inteligencja ma ambicję „rozumieć” każdy język. Ale co się stanie, gdy wpiszesz pytanie po arabsku albo japońsku, a model odpowie… kompletnie nie na temat? Problem nie polega tylko na tym, że AI się myli – ale na tym, że my nie mamy jak zweryfikować, czy ono rozumie pytanie tak, jak my je zadaliśmy.

Większość dużych modeli językowych – GPT, PaLM, Claude – była trenowana głównie na treściach anglojęzycznych. W przeglądzie danych treningowych GPT-3 oszacowano, że ponad 90% tekstów pochodziło z języków opartych na alfabecie łacińskim – głównie z angielskiego. (więcej…)

Chałkoń, Trump jako papież, co następne – wykorzystanie AI w celach satyrycznych i żenujących. Historia, przykłady, przejawy, granica między dobrym gustem a złym gustem

- Wprowadzenie: Satyra i żenada w erze sztucznej inteligencji

Satyra jest jednym z najstarszych narzędzi społecznej refleksji i krytyki. Od wieków pozwalała ludziom spojrzeć na rzeczywistość z dystansem, obnażając absurdy władzy, relacji międzyludzkich czy dogmatów kulturowych. W świecie, gdzie granice między rzeczywistością a fikcją coraz bardziej się zacierają, rola satyry uległa przekształceniu. Dziś, w dobie sztucznej inteligencji, satyra nie tylko komentuje świat, ale również go współtworzy. AI, narzędzie pierwotnie rozwijane z myślą o automatyzacji i analizie danych, niespodziewanie stało się aktorem sceny komicznej, ironicznym narratorem współczesnych absurdów. (więcej…)

Wielojęzykowa identyfikacja stronniczości (biasów), nieścisłości oraz błędów w dużych modelach językowych, w kontekstach kulturowych, obyczajowych i politycznych. Analiza zjawiska i benchmarki

Duże modele językowe (Large Language Models, LLM) rewolucjonizują sposób, w jaki ludzie na całym świecie korzystają z technologii sztucznej inteligencji. Jednak wraz z ich rosnącą popularnością ujawnia się poważny problem: modele te mogą utrwalać i wzmacniać społeczne uprzedzenia, stereotypy oraz stronniczość polityczną i kulturową. Szczególnie niepokojące jest to, że chociaż większość modeli jest trenowana głównie na danych w języku angielskim, są one aktywnie używane przez użytkowników mówiących w co najmniej 150 różnych językach. (więcej…)

Budowanie zaufania do cyfrowych lekarzy – jak projektować systemy AI wspomagające diagnozę medyczną, aby użytkownicy mieli do nich większe zaufanie

Współczesna medycyna znajduje się u progu przełomu, którego siłą napędową jest dynamiczny rozwój sztucznej inteligencji (AI). Systemy AI coraz śmielej wkraczają w obszar opieki zdrowotnej – wspierając proces diagnostyczny, umożliwiając personalizację terapii oraz usprawniając funkcjonowanie całego systemu ochrony zdrowia. Liczba zatwierdzonych do użytku klinicznego urządzeń medycznych opartych na AI systematycznie rośnie – do sierpnia 2024 roku Amerykańska Agencja ds. Żywności i Leków (FDA) wydała zgodę na wdrożenie 950 takich rozwiązań.

Sztuczna inteligencja, której możesz zaufać – wyjaśnialność decyzji w praktyce biznesowej

W erze dynamicznego rozwoju sztucznej inteligencji coraz więcej firm sięga po algorytmy do podejmowania decyzji finansowych, analizy ryzyka czy obsługi klientów. Szczególnie w sektorze bankowym i transakcyjnym AI zaczyna odgrywać kluczową rolę w procesach, które jeszcze niedawno były zarezerwowane wyłącznie dla ludzi. Jednak wraz z rosnącym wpływem maszyn na decyzje o kredytach, inwestycjach czy wykrywaniu nadużyć, pojawia się fundamentalne pytanie: czy możemy zaufać decyzjom podejmowanym przez algorytmy, których działania często nie rozumiemy?

Zaufanie do AI nie powstaje samo – trzeba je aktywnie budować. Kluczowym elementem tego procesu jest wyjaśnialność decyzji podejmowanych przez systemy – czyli zdolność do zrozumienia, dlaczego algorytm podjął taką, a nie inną decyzję. W tym wpisie przyjrzymy się, jak budować transparentne, zrozumiałe i etyczne systemy AI w biznesie, ze szczególnym uwzględnieniem sektora bankowego i finansowego.

Etyczne obawy związane z użyciem AI w dronach

Konwergencja technologii bezzałogowych statków powietrznych (BSP) i sztucznej inteligencji (AI) przekształca drony z narzędzi zdalnie sterowanych w autonomiczne systemy zdolne do samodzielnego podejmowania decyzji. Ta rewolucja otwiera bezprecedensowe możliwości w sektorach cywilnych, takich jak rolnictwo, logistyka czy ratownictwo, obiecując znaczący postęp. Jednocześnie ta sama autonomia generuje głębokie wyzwania etyczne, prawne i społeczne, szczególnie dotkliwe w kontekście zastosowań wojskowych i nadzorczych.

Niniejszy artykuł analizuje kluczowe dylematy etyczne, jakie niesie za sobą integracja AI w dronach. Z jednej strony, technologia ta obiecuje wymierne korzyści. Z drugiej, rodzi widmo w pełni autonomicznych systemów broni (LAWS), masowej inwigilacji oraz erozji fundamentalnych praw człowieka, w tym prawa do prywatności i życia. Tezą przewodnią jest stwierdzenie, że integracja AI w dronach tworzy napięcia w istniejących ramach etycznych i prawnych. Problemy takie jak „luka w odpowiedzialności”, zapewnienie „znaczącej kontroli ludzkiej” nad systemami uzbrojonymi oraz ochrona prywatności wymagają stworzenia nowych, proaktywnych modeli zarządzania, które zapewnią, że rozwój tej technologii będzie przebiegał w sposób bezpieczny i zgodny z fundamentalnymi wartościami. (więcej…)

Nagrywam rolkę z mojego morderczego rajdu – techniki instytucjonalne i informatyczne ograniczania funkcjonowania technologii oraz aplikacji podczas korzystania ze środków transportu.

Wprowadzenie

W dobie dominacji mediów społecznościowych i powszechnego dostępu do urządzeń mobilnych rejestrowanie każdego aspektu życia – również podczas jazdy – stało się normą. Rolki z tras motocyklowych, nagrania z kokpitów samochodowych, filmy z rowerowych eskapad – wszystko to buduje osobisty wizerunek i zaspokaja potrzebę ekspresji. Jednak im bardziej technologia wnika w przestrzeń ruchu drogowego, tym częściej instytucje i producenci reagują, wdrażając ograniczenia: od blokad funkcji w smartfonach, po aktywne zakłócanie działania kamer i aplikacji. Czy można swobodnie nagrywać swoje „mordercze rajdy”? Jakie bariery – technologiczne i instytucjonalne – stoją na drodze? O tym właśnie ten artykuł. (więcej…)

Wydawanie poleceń robotom społecznym w kontekście interakcji międzyludzkich – strategie bezpiecznej współpracy człowieka z robotami w relacjach społecznych

Roboty społeczne coraz częściej pojawiają się w przestrzeniach, które do niedawna były zarezerwowane wyłącznie dla ludzi – szkołach, szpitalach, domach. Ich zadaniem nie jest już tylko pomoc fizyczna, ale także emocjonalna, edukacyjna czy opiekuńcza. Zmienia się rola maszyny – z wykonawcy poleceń staje się ona towarzyszem, a czasem nawet doradcą. (więcej…)

Stosowania technologii rozpoznawania twarzy w wymiarze sprawiedliwości – czy narzędzia biometryczne mogą skutecznie identyfikować sprawców przestępstw, czy też prowadzą do masowej inwigilacji i błędnych oskarżeń wynikających z niedokładności algorytmów. Strategie, architektury i mechanizmy wyjaśniania.

Wprowadzenie

Technologia rozpoznawania twarzy to system zdolny nie tylko do wykrywania charakterystycznych cech twarzy na obrazie lub wideo, ale także do dopasowania badanego obiektu do bazy danych wcześniej zgromadzonych zdjęć. Sprawia to, że jest ona szeroko wykorzystywana w monitoringu oraz śledzeniu przestępców, dając możliwość zwiększenia porządku i bezpieczeństwa społecznego. (więcej…)

Pokemony w kościele, rolka na Insta z Auschwitz, Tik-Tok przy 240 km/h na A4 – jak technicznie przy wykorzystaniu AI i nie tylko oraz instytucjonalnie wpływać na użytkowników by w niektórych sytuacjach nie korzystali z aplikacji

Czy można grać w Pokemony w kościele, kręcić rolki w miejscu pamięci o zagładzie lub nagrywać Tik-Toka na autostradzie, prowadząc z nadmierną prędkością?

Technicznie: tak.

Etycznie i społecznie: problematyczne.

Postęp technologiczny, głównie napędzany przez mobilne aplikacje i sztuczną inteligencję, z jednej strony otwiera nowe możliwości, z drugiej zaś zmusza do refleksji nad granicami wolności i odpowiedzialności. Czy technologia może pomóc nam hamować nasze nieodpowiedzialne impulsy? Jak instytucjonalnie i informatycznie możemy kształtować odpowiedzialne korzystanie z narzędzi cyfrowych?

Zatrzymać patostreaming? Klasyfikacja i identyfikacja zachowań patologicznych na streamach, techniczne i instytucjonalne próby zatrzymywania treści szkodliwych, a wolność nadawania i odbioru.

Patostreaming – narastający problem współczesnego internetu

W dobie cyfrowej rewolucji granica między rzeczywistością a widowiskiem ulega coraz większemu zatarciu. Internet – początkowo postrzegany jako narzędzie komunikacji i wolności – stał się także sceną, na której rozgrywają się ludzkie dramaty, często w formie brutalnej rozrywki. Patostreaming, czyli transmitowanie patologicznych lub kontrowersyjnych zachowań dla zysku i uwagi, nie jest już marginesem sieci. To zjawisko o globalnym zasięgu, obejmujące różne kraje, języki i konteksty społeczne. (więcej…)

Wydawanie poleceń robotom społecznym w kontekście podawania przedmiotów – strategie bezpiecznej interakcji w obszarze Human-Robot Interaction.

1. Wprowadzenie

Roboty społeczne to maszyny zaprojektowane do interakcji z ludźmi w sposób naturalny i zrozumiały, często przypominający relacje międzyludzkie. W przeciwieństwie do robotów przemysłowych, które działają w ściśle kontrolowanych środowiskach, roboty społeczne funkcjonują w przestrzeniach codziennego użytku – takich jak domy, szkoły czy placówki opieki. Przykładami takich urządzeń są Pepper – humanoidalny robot rozpoznający emocje, Nao – mały edukacyjny robot używany m.in. w terapii dzieci z autyzmem, czy Care-O-bot, który pomaga osobom starszym w domowych obowiązkach. (więcej…)

Zapobieganie przemocy domowej z wykorzystaniem danych kontekstowych i dźwięków z urządzeń mobilnych

Przemoc domowa pozostaje poważnym problemem społecznym, często ukrytym za zamkniętymi drzwiami. Według danych polskiej policji, w 2023 roku ofiarami przemocy domowej w Polsce było ponad 77,8 tys. osób, a liczba zidentyfikowanych sprawców przekroczyła 63 tys. – przy czym aż 74% ofiar stanowiły kobiety. Statystyki te pokazują skalę zjawiska i pilną potrzebę skutecznego przeciwdziałania. Jednym z innowacyjnych kierunków jest wykorzystanie nowych technologii – w szczególności powszechnie dostępnych smartfonów, inteligentnych głośników i innych urządzeń mobilnych – do automatycznej identyfikacji sytuacji zagrożenia przemocą domową. Urządzenia te, wyposażone w mikrofony oraz różnorodne czujniki, mogą pełnić rolę „cichych świadków” zdarzeń, wychwytując dźwięki przemocy (np. krzyki, odgłosy uderzeń) i dane kontekstowe (np. gwałtowne przyspieszenia, nietypową lokalizację czy porę zdarzenia) mogące wskazywać na akt przemocy.

Granica między realizmem a dziwacznością w robotach i systemach AI – ponowna analiza teorii „Uncanny Valley”

Zjawisko „uncanny valley” odnosi się do dyskomfortu lub niepokoju, jaki odczuwają ludzie w reakcji na obiekty, które są niemal – ale nie do końca – ludzkie w wyglądzie lub zachowaniu. Termin ten został wprowadzony przez japońskiego badacza Masahiro Moriego w latach 70. XX wieku, opisując wykres reakcji emocjonalnej na różne poziomy podobieństwa do człowieka. Im bardziej robot, animacja czy sztuczna inteligencja przypomina człowieka, tym bardziej jest nam przyjazna – aż do momentu, gdy staje się zbyt podobna, ale nadal nienaturalna. Wtedy reakcja staje się odwrotna – pojawia się niepokój, strach lub obrzydzenie. Efekt ten ma istotne znaczenie w robotyce, animacji komputerowej i projektowaniu interfejsów, ponieważ pokazuje, jak delikatna granica oddziela to, co realistyczne i akceptowalne, od tego, co wywołuje instynktowny lęk.

Quantified Self – wykorzystanie danych i sztucznej inteligencji do poprawy wydajności intelektualnej oraz wspomagania podejmowania decyzji. Architektura technologii, możliwości, wzywania i kwestie etyczne

Quantified Self – zastosowanie danych i sztucznej inteligencji do optymalizacji wydajności fizycznej. Architektura technologii, możliwości, wyzwania oraz dylematy etyczne.

W ostatnich latach obserwujemy rosnące zainteresowanie tzw. Quantified Self – ruchem, który zakłada świadome gromadzenie i analizę danych o własnym ciele i zachowaniach, w celu lepszego zrozumienia siebie i poprawy jakości życia. Dzięki rozwojowi technologii noszonych (wearables), przystępności sensorów biologicznych oraz postępom w dziedzinie sztucznej inteligencji (AI), idea Quantified Self przeradza się z ciekawostki w potężne narzędzie do optymalizacji wydajności fizycznej – zarówno w kontekście sportu wyczynowego, jak i zdrowia codziennego. (więcej…)

Prawne i etyczne aspekty sprzedaży i użytkowania seks-robotów o cechach nieletnich – czy prawo powinno całkowicie zakazać produkcji i dystrybucji robotów o wyglądzie dzieci i nastolatków, czy też takie praktyki mogą stanowić sposób na redukcję przestępstw na tle seksualnym wobec osób niepełnoletnich.

Seks-roboty same w sobie bywają tematem kontrowersyjnym, a kwestie etyczne i prawne stają się tylko trudniejsze, gdy zamiast dorosłych przypominają kształtem dzieci. Czy odruchowa odraza powinna być podstawą zakazów? Czy istnienie takich robotów może skrzywdzić prawdziwe dzieci, a może ocalić je przed krzywdą? Ten świat nie do końca jeszcze nadszedł, ale już warto się nad nim pochylić.

https://3dprint.com/wp-content/uploads/2015/04/3dp_smartdoll_insides_edit.jpg (więcej…)

Pokémon Go: Złap je wszystkie… z głową!

Rozwój technologii mobilnych i aplikacji opartych na rzeczywistości rozszerzonej, takich jak Pokémon Go, stawia nowe wyzwania w kontekście poszanowania miejsc o szczególnym znaczeniu, takich jak miejsca pamięci, obiekty sakralne czy instytucje edukacyjne, ponieważ obecność elementów gry w tych przestrzeniach może prowadzić do naruszenia ich powagi i funkcji edukacyjnej. W odpowiedzi na te zagrożenia instytucje i twórcy technologii podejmują działania ograniczające ich działanie w takich lokalizacjach.

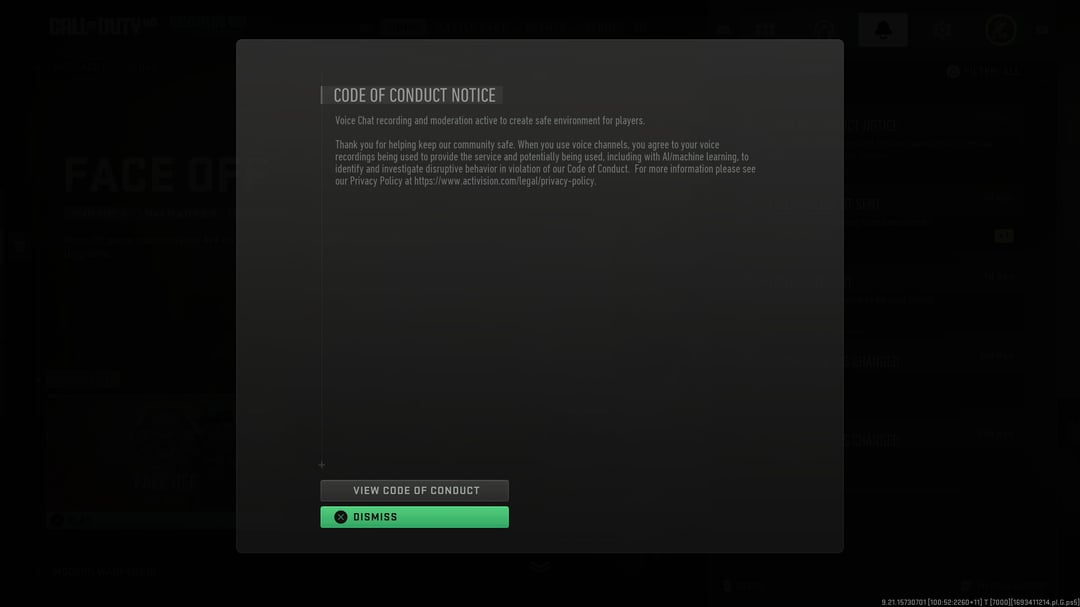

Gry komputerowe, etyka i sztuczna inteligencja – metody AI do wykrywania nieetycznych, nielegalnych i destrukcyjnych zachowań w świecie gamingu.

Branża gamingowa mierzy się z bezprecedensowym wyzwaniem, gdyż wieloosobowe doświadczenia online stają się coraz bardziej rozbudowane i zaawansowane, jednocześnie jednak pozostają one podatne na złośliwe działania zagrażające bezpieczeństwu graczy i integralności branży. Szacuje się, że straty spowodowane przez oszustwa sięgają 6 miliardów dolarów w skali roku, a liczba przypadków cyberprzemocy wzrosła o 40% podczas pandemii COVID-19, co podkreśla pilną potrzebę wdrożenia zaawansowanych systemów wykrywania i prewencji destrukcyjnych zachowań. Sztuczna inteligencja stała się pierwszą linią obrony przed tym cyfrowym zagrożeniem, wykorzystując algorytmy uczenia maszynowego, przetwarzanie języka naturalnego i analizę behawioralną do identyfikowania wzorców toksyczności, oszustw, nadużyć finansowych i nękania w czasie rzeczywistym. Od systemu ToxBuster firmy Ubisoft, wykorzystującego architekturę transformatorów i uczenia głębokiego do wykrywania negatywnie nacechowanych treści w kontekście wypowiedzi, po rozwiązania AI osiągające 92,6% dokładności w wykrywaniu oszustw finansowych – te technologiczne innowacje wyznaczają nowy paradygmat w ochronie społeczności gamingowych przy zachowaniu immersyjnego charakteru rozgrywki. (więcej…)

Cyfrowa nekromancja w polskim radiu

Dnia 22.10.2024 słuchacze Off Radio Kraków mieli przyjemność posłuchać wywiadu z wybitną polską poetką na temat literackiej Nagrody Nobla 2024. Nie byłoby w tym nic dziwnego, gdyby nie fakt, że dziennikarka nie istnieje, a respondentka nie żyje już od ponad dekady. (więcej…)

[…] poprzednim artykule skupiliśmy się na seks robotach w ogólności, a także na najpopularniejszej formie tego […]