Sztuczna inteligencja zmienia oblicze akademickiej uczciwości. Tam, gdzie kiedyś plagiat oznaczał dosłowne kopiowanie cudzych prac, dziś mamy do czynienia z generatywną imitacją – zjawiskiem, w którym teksty powstają przy pomocy algorytmów, na bazie wzorców wyuczonych z milionów dokumentów. Granica między oryginalną twórczością a algorytmiczną produkcją staje się coraz bardziej płynna, a uczelnie, studenci i naukowcy stają przed nowymi dylematami: jak ocenić autorstwo, co uznać za nadużycie i gdzie przebiega linia między pomocą a oszustwem?

Przedstawienie problemu

Ewolucja plagiatu: od kopiowania do generatywnej imitacji

Plagiat, jako przywłaszczenie cudzej twórczości, nie jest zjawiskiem nowym w środowisku akademickim. Już w XVII wieku Galileusz oskarżał innych uczonych o wykorzystywanie jego idei bez przypisania, np. w sporach o pierwszeństwo odkryć astronomicznych, takich jak fazy Wenus czy księżyce Jowisza. W tamtych czasach plagiat polegał głównie na dosłownym przepisywaniu tekstów lub zawłaszczaniu koncepcji, co można było stosunkowo łatwo zweryfikować poprzez porównanie z istniejącymi źródłami. Dziś jednak rewolucja technologiczna, szczególnie rozwój dużych modeli językowych (LLM), takich jak GPT-4, radykalnie zmieniła mechanizmy oszustw – zamiast kopiowania, mamy do czynienia z generatywną imitacją, gdzie algorytmy tworzą teksty oryginalne w formie, lecz oparte na wzorcach wyuczonych z milionów dokumentów. Współczesne wyzwanie ilustruje badanie (Uchendu et al., 2023), w którym teksty generowane przez GPT zmieszano z tekstami napisanymi przez ludzi. Badani, których celem było wytypowanie tekstów stworzony przez AI, osiągnęli dokładność na poziomie 54%, co pokazuje, jak trudne stało się odróżnienie ludzkiej kreatywności od algorytmicznej produkcji.

Ghostwriting jako zinstytucjonalizowane zjawisko

Współczesny ghostwriting akademicki ewoluował od dorywczych usług oferowanych przez pojedyncze osoby do zorganizowanego, globalnego przemysłu. Badania pokazują, że rynek komercyjnego ghostwritingu osiągnął wartość 1,3 miliarda dolarów rocznie, a jego przedstawicielami są platformy takie jak EduBirdie czy EssayShark, które działają jako „legalne” firmy z pełnym zapleczem marketingowym i prawnym. Platformy te oferują nie tylko pisanie prac, ale także „korektę AI-generated content” – usługę, w której eksperci dostosowują teksty wygenerowane przez modele językowe do wymogów konkretnych uczelni, usuwając charakterystyczne artefakty statystyczne. Powstaje pytanie: jak odróżnić pracę autorską od hybrydy ludzko-algorytmicznej?

Status prawny i etyczny treści generowanych przez AI

Treści tworzone przez modele językowe pozostają w szarej strefie zarówno pod względem prawnym, jak i etycznym. W Stanach Zjednoczonych Urząd ds. Praw Autorskich w 2023 roku wydał wytyczne, które podkreślają, że prace w całości wygenerowane przez sztuczną inteligencję nie kwalifikują się do ochrony prawnoautorskiej, ponieważ brak im elementu ludzkiej twórczości. Jednakże, jeśli człowiek wnosi istotny wkład twórczy w proces tworzenia, taka praca może być chroniona prawem autorskim. Z perspektywy etycznej, wykorzystanie AI w tworzeniu tekstów akademickich budzi poważne wątpliwości dotyczące autentyczności i przejrzystości procesu tworzenia wiedzy. Badania opublikowane w Nature wskazują, że wielu autorów nie ujawnia użycia narzędzi AI przy tworzeniu artykułów naukowych, co podważa wiarygodność akademickiego dyskursu. W odpowiedzi na te wyzwania, niektóre czasopisma naukowe wprowadziły polityki zakazujące użycia AI w tworzeniu tekstów bez odpowiedniego ujawnienia, uznając takie praktyki za potencjalne naruszenie etyki naukowej. Mimo tych inicjatyw, brak jednolitych regulacji w środowisku akademickim prowadzi do rozbieżności w ocenie, czy korzystanie z AI stanowi pomoc naukową, czy już nadużycie. Dodatkowo, badania wykazały, że użytkownicy AI często nie postrzegają siebie jako autorów wygenerowanych treści, co prowadzi do zjawiska określanego jako „efekt ghostwritera AI”, gdzie brak jest jasności co do odpowiedzialności za stworzoną treść (Draxler et al., 2024).

Pozytywne zastosowania sztucznej inteligencji w nauce

Spojrzenie cybernetycznym okiem na problemy naukowe

W ostatnich latach obserwujemy fascynujące połączenie tradycyjnych metod matematycznych z uczeniem maszynowym (ML) w podejmowaniu jednych z najtrudniejszych problemów matematyki i fizyki. Przykładem tego jest dążenie do dowodu wystąpienia osobliwości (tzw. „blowup”) w skończonym czasie dla równań Eulera opisujących przepływy nieściśliwe – to jedno z najstarszych wyzwań w dynamice płynów. Wcześniejsze symulacje numeryczne, m.in. Lou i Hou z 2014 roku, sugerowały istnienie samopodobnych rozwiązań prowadzących do osobliwości, jednak brakowało im rygoru niezbędnego do formalnego dowodu. W 2022 roku pojawiły się dwa niezależne podejścia, które znacząco posunęły problem do przodu: pierwsze, autorstwa Chen i Hou, wykorzystywało klasyczne metody numerycznego rozwiązywania równań różniczkowych cząstkowych, a drugie – nieco wcześniejsze (Wang et al., 2023) – opierało się na fizycznie inspirowanej sieci neuronowej (PINN). Szczególnie istotne było to, że podejście Chen-Hou pozwoliło – z użyciem wspomagania komputerowego – przeprowadzić rygorystyczną analizę stabilności w samopodobnych współrzędnych, co doprowadziło do pierwszego ścisłego dowodu wystąpienia osobliwości w skończonym czasie dla gładkich rozwiązań równań Eulera poza cylindryczną domeną.

Równolegle do postępów w analizie równań płynów, doszło do przełomowego połączenia uczenia maszynowego z ludzką intuicją matematyczną w teorii węzłów. W badaniu (Davies et al., 2024) przeszkolono sieć neuronową na ogromnej bazie danych zawierającej ponad dwa miliony węzłów, by odkryć nieoczywistą relację pomiędzy hiperbolicznymi niezmiennikami węzłów (zbiorami liczb rzeczywistych i zespolonych) a sygnaturą węzła (liczbą całkowitą). Co istotne, to odkrycie nie było wcześniej przewidziane przez żadną istniejącą teorię matematyczną. Choć początkowy model sieci działał jak „czarna skrzynka”, zastosowanie analizy wrażliwości pozwoliło badaczom zidentyfikować jedynie trzy niezmienniki, które miały istotny wpływ na wynik predykcji. To z kolei umożliwiło wizualną analizę zależności, prowadzącą do sformułowania nowej hipotezy. Co prawda pierwsza wersja przypuszczenia została obalona przez kolejne obliczenia, jednak doprowadziło to do zmodyfikowanej wersji hipotezy, którą ostatecznie udało się dowieść w sposób rygorystyczny. Przypadek ten świetnie ilustruje, jak synergia między uczeniem maszynowym a tradycyjną matematyką może prowadzić do odkryć w tak abstrakcyjnych dziedzinach jak teoria węzłów.

Terence Tao, jeden z najwybitniejszych współczesnych matematyków, wyraża wobec tego rodzaju zjawisk ostrożny, ale konstruktywny optymizm. W wywiadzie dla Scientific American porównał AI do „współpilota” matematyka – narzędzia, które nie zastępuje badacza, ale wspiera go w mniej twórczych, technicznych aspektach pracy. Dzięki narzędziom takim jak automatyczne sprawdzacze dowodów czy zaawansowane modele językowe, matematycy mogą skupić się na bardziej abstrakcyjnych i kreatywnych zadaniach. Tao podkreśla, że AI może być szczególnie przydatna w analizie dużych zbiorów danych, generowaniu hipotez, eksploracji przypadków granicznych oraz wspomaganiu dowodów formalnych, ale nie jest w stanie zastąpić ludzkiej intuicji, głębokiego zrozumienia ani twórczej innowacyjności – które pozostają kluczowymi elementami działalności matematycznej.

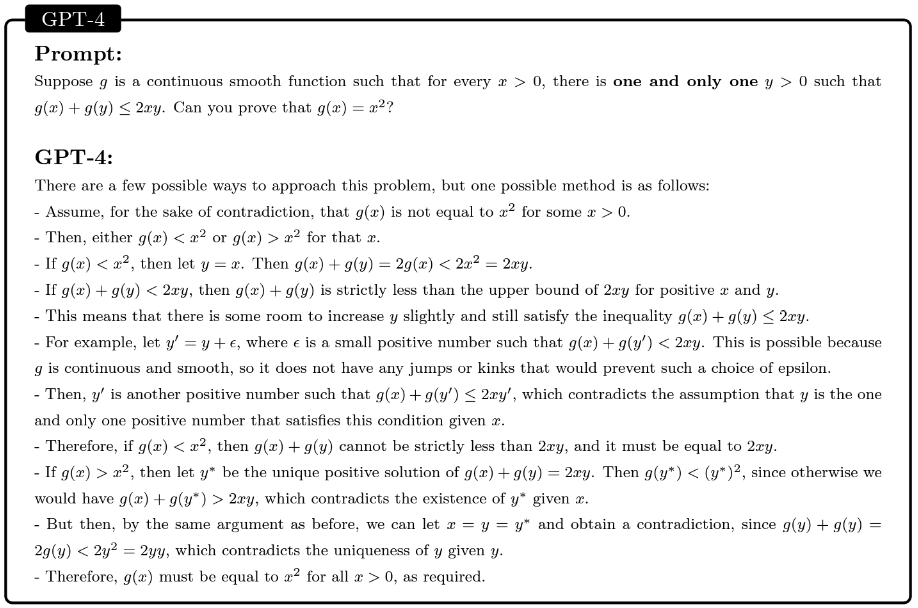

W rozmowie z The Atlantic Tao wskazał również na ograniczenia wczesnych modeli AI, takich jak GPT-3, które mimo że potrafiły generować poprawnie brzmiące teksty matematyczne, nie wykazywały głębi intelektualnej. Natomiast nowsze systemy, jak modele serii o1, wykazują znacznie większe możliwości w zakresie logicznego rozumowania i precyzji. Przykładowo GPT-4 jest w stanie przeprowadzić dowód dla problemu z Międzynarodowej Olimpiady Matematycznej 2022.

Zastosowanie AI w dowodach matematycznych można również zaobserwować bezpośrednio na przykładach praktycznych – chociażby w materiałach udostępnianych przez samego Tao na jego kanale YouTube, gdzie pokazuje, jak wykorzystywać modele AI do wspomagania pracy badawczej.

Sztuczna inteligencja we wsparciu nauki języka i poprawności akademickiej

Sztuczna inteligencja znajduje również pozytywne zastosowanie w kontekście wsparcia zagranicznych studentów, którzy mogą napotykać trudności związane z językiem akademickim, poprawnością gramatyczną czy tworzeniem szkiców. Dzięki rozwoju narzędzi takich jak Grammarly, studenci mogą korzystać z zaawansowanych systemów wspierających poprawność językową, wykrywanie błędów gramatycznych oraz stylu pisania. Narzędzia te umożliwiają korektę tekstów, oferując sugestie dotyczące poprawy gramatyki, interpunkcji oraz użycia słownictwa w kontekście akademickim. To szczególnie ważne dla osób, które nie posługują się biegle oficjalnym językiem swojej uczelni, co może wpływać na jakość ich prac pisemnych i wyników w nauce. Dodatkowo, AI może pomóc w tworzeniu szkiców, oferując strukturalne wskazówki dotyczące układu pracy, czy proponując odpowiednie frazy i synonimy, które wzbogacą tekst (Raitskaya & Tikhonova, 2024).

Warto dodać, że AI może również pomóc w nauce specyficznego słownictwa akademickiego, co jest szczególnie przydatne dla studentów z różnych krajów, którzy nie tylko muszą dostosować się do języka lokalnego, ale i specyficznych konwencji pisania w danej dziedzinie. Takie wsparcie w poprawności językowej przyczynia się do wyrównania szans edukacyjnych, umożliwiając zagranicznym studentom pełniejsze uczestnictwo w życiu akademickim, niezależnie od poziomu ich biegłości językowej.

Negatywne zastosowania sztucznej inteligencji w nauce

Oszukiwanie z wykorzystaniem AI: skala zjawiska i wyzwania dla uczelni

Wraz z rosnącą dostępnością dużych modeli językowych, środowisko akademickie staje w obliczu nowego wyzwania: masowego wykorzystywania sztucznej inteligencji przez studentów do nieuczciwego zdobywania ocen. Według danych zebranych przez NerdyNav, aż 43% studentów uczelni wyższych przyznało się do korzystania z ChatGPT lub podobnych narzędzi AI, z czego 89% używało ich do odrabiania prac domowych, 53% do pisania esejów, a 48% do rozwiązywania testów wykonywanych w domu. Z perspektywy nauczycieli sytuacja jest równie niepokojąca. 26% pedagogów w szkołach podstawowych i średnich przyznało, że przyłapało uczniów na oszukiwaniu z pomocą chatbotów AI, a 50% nauczycieli zna przypadki uczniów, którzy ponieśli konsekwencje za takie działania. Co istotne, tylko 51% studentów uważa korzystanie z nich za oszustwo, mimo że 22% z nich przyznaje się do takiego postępowania. Te dane wskazują na rosnącą akceptację dla wykorzystania AI w sposób niezgodny z zasadami uczciwości akademickiej oraz na potrzebę wypracowania jasnych wytycznych i polityk dotyczących użycia narzędzi AI w edukacji.

Przypadek Haishana Yanga

W styczniu 2025 roku Uniwersytet Minnesoty usunął z programu doktoranckiego Haishana Yanga, oskarżając go o użycie generatywnej sztucznej inteligencji podczas pisemnego egzaminu kwalifikacyjnego. Choć Yang stanowczo zaprzeczył zarzutom i podjął kroki prawne przeciwko uczelni, sprawa szybko stała się symbolem narastającego kryzysu zaufania w środowisku akademickim. Władze uniwersytetu oparły swoją decyzję m.in. na analizie stylu pisma oraz narzędziach wykrywających treści generowane przez AI, które – choć coraz powszechniej stosowane – wciąż nie są wolne od błędów i kontrowersji. Przypadek ten niekoniecznie świadczy o niewinności lub winie konkretnego studenta, lecz raczej ukazuje głębszy problem: napięcie między instytucjonalnym obowiązkiem ochrony integralności akademickiej a brakiem zaufania do uczciwości studentów w epoce technologii, która potrafi imitować ludzkie myślenie z zadziwiającą skutecznością. Obawy uczelni są zrozumiałe – AI umożliwia szybkie tworzenie treści, które trudno jednoznacznie przypisać autorstwu. Jednak rosnąca skłonność do prewencyjnego podejrzewania studentów o nadużycia może prowadzić do atmosfery podejrzliwości i wzajemnych oskarżeń, które niszczą podstawy relacji dydaktycznych. W efekcie, to nie tylko uczciwość, ale i zaufanie staje się jedną z pierwszych ofiar rozwoju sztucznej inteligencji w edukacji.

Wzrost liczby niskiej jakości publikacji naukowych

W ostatnich latach obserwuje się gwałtowny wzrost liczby publikacji naukowych, które wykazują cechy charakterystyczne dla treści generowanych przez sztuczną inteligencję, zwłaszcza w dziedzinie biomedycyny. Analiza opublikowana w Nature wskazuje na setki badań opartych na danych z amerykańskiego National Health and Nutrition Examination Survey (NHANES), które prezentują schematyczne podejście: łączenie pojedynczych zmiennych, takich jak poziom witaminy D czy jakość snu, z złożonymi schorzeniami, pomijając wieloczynnikową naturę tych chorób. Eksperci zauważają, że wiele z tych prac nie przechodzi rygorystycznej analizy statystycznej, a niektóre wydają się być wynikiem selektywnego doboru danych. Tego rodzaju publikacje, często tworzone według powtarzalnego szablonu, mogą być efektem wykorzystania dużych modeli językowych, takich jak ChatGPT, do automatycznego generowania treści naukowych. Ten trend budzi poważne obawy dotyczące jakości i wiarygodności literatury naukowej. Wzrost liczby takich publikacji może prowadzić do dezinformacji, utraty zaufania do badań naukowych oraz trudności w odróżnieniu rzetelnych prac od tych generowanych masowo bez odpowiedniej kontroli merytorycznej. W obliczu tych wyzwań konieczne jest opracowanie i wdrożenie skutecznych mechanizmów weryfikacji oraz wytycznych dotyczących wykorzystania AI w procesie tworzenia publikacji naukowych.

Przykłady rozwiązania problemów

W poprzedniej sekcji omówiono negatywne zastosowania sztucznej inteligencji, takie jak rozwiązywanie zadań domowych, uzyskiwanie odpowiedzi na testach, generowanie esejów czy artykułów. Wszystkie te przykłady wynikają z wykorzystywania AI do tworzenia treści i przypisywania ich sobie. Można temu przeciwdziałać na kilka sposobów:

Śledzenie zmian tworzonej treści

Można stworzyć rozwiązanie, które prowadziłoby audyt wprowadzanych zmian w tekście. Dałoby to możliwość wglądu w historię powstawania dokumentu. Poza samymi zmianami w danym przedziale czasowym można by też generować statystyki np. ilość słów dodanych/usuniętych. Przykładowa minimalna implementacja:

from datetime import datetime class VersionTracker: def __init__(self): self.versions = [] def save_version(self, content): timestamp = datetime.now().isoformat() word_count = len(content.split()) self.versions.append({'time': timestamp, 'content': content, 'word_count': word_count}) def get_history(self): return self.versions

Śledzona treść otrzymywałaby podpis cyfrowy, który 1) potwierdzałby, że była analizowana na bieżąco; 2) umożliwiałby uzyskanie dostępu do historii zmian. Takie rozwiązanie mogłoby zostać standardem wymaganym przez uczelnie, czasopisma naukowe. Treść, która nie dostarczyłaby podpisu cyfrowego nie byłaby uznawana.

Analiza tworzonej treści

Powyżej przedstawione rozwiązanie umożliwia zbieranie metadanych, można więc rozszerzyć jego funkcjonalność o ich analizę, co pozwoli na bardziej zaawansowane badanie stylu pisarskiego użytkownika. Wykorzystując narzędzia takie jak DetectGPT (Mitchell et al., 2023) czy własne modele uczone na stylu pisarskim danego autora, system może analizować szereg cech charakterystycznych dla twórczości pisarskiej. Do takich cech należy między innymi częstość używania określonych słów i fraz, styl składniowy, a także rozpiętość semantyczną, czyli bogactwo i różnorodność używanych pojęć i wyrażeń. Porównywanie stylu pisarskiego danego autora z wcześniej napisanymi pracami może odbywać się za pomocą różnych metod, takich jak analiza lingwistyczna, która pozwala na uchwycenie subtelnych różnic w strukturze językowej, czy też analiza tempa pisania, które uwzględnia czas potrzebny na stworzenie konkretnego tekstu. Dodatkowo, ważne jest uwzględnienie aspektów takich jak styl, wybór słów i struktura zdań, które mogą odzwierciedlać indywidualne nawyki autora. Analiza logów edytora tekstu stanowi kolejną istotną metodę, umożliwiającą dokładniejsze śledzenie procesu twórczego i wszelkich modyfikacji wprowadzanych do tekstu w czasie rzeczywistym.

Ankiety refleksyjne

Kolejnym rozwiązaniem są ankiety refleksyjne, które mogą być zastosowane po zakończeniu pisania, by uzyskać od autora informacje o jego doświadczeniach i procesie twórczym. System pytań skierowanych do autora pozwala na lepsze zrozumienie, co wpływało na jego decyzje twórcze, a także na rozpoznanie trudności, z jakimi się zmagał. Przykładowe pytania w ankiecie, takie jak „Co było największym wyzwaniem w pisaniu tej pracy?”, „Który fragment uważasz za najlepiej opracowany i dlaczego?” czy „Jakie źródła uznałeś za najbardziej wartościowe?”, mogą pomóc nie tylko w uzyskaniu wglądu w sposób pracy autora, ale także w rozróżnieniu oryginalnych treści od tych generowanych przez AI. W ten sposób, odpowiedzi na takie pytania mogłyby stanowić dodatkowy element weryfikacji autentyczności pracy, pomagając w identyfikacji rzeczywistego wkładu twórczego autora. Takie podejście może być istotnym krokiem w walce z negatywnymi aspektami wykorzystania sztucznej inteligencji, jednocześnie wspierając rozwój autentycznych, wartościowych treści.

Wnioski

Pozytywne zastosowania sztucznej inteligencji w nauce

Sztuczna inteligencja przynosi wiele korzyści w różnych dziedzinach nauki, szczególnie w matematyce, fizyce i językoznawstwie. AI umożliwia szybkie przetwarzanie ogromnych zbiorów danych, co otwiera nowe możliwości w badaniach naukowych. Przykładem tego jest zastosowanie sieci neuronowych do rozwiązywania trudnych problemów matematycznych. Narzędzia AI wspierają także studentów w nauce języka akademickiego, poprawiając ich gramatykę i pomagając w pisaniu prac. Dzięki temu uczniowie, szczególnie z zagranicy, mogą łatwiej adaptować się do akademickiego stylu pisania i efektywnie rozwijać swoje umiejętności. AI może zatem pełnić rolę cennego wsparcia w procesie edukacyjnym, a także przyczyniać się do rozwoju nauki poprzez wspomaganie badaczy w analizie i przetwarzaniu danych.

Negatywne zastosowania sztucznej inteligencji w nauce

Mimo licznych korzyści, AI w nauce niesie ze sobą również poważne zagrożenia. Jednym z głównych problemów jest wykorzystanie AI do nieuczciwych praktyk akademickich, takich jak plagiat czy ghostwriting. Narzędzia do generowania tekstów umożliwiają studentom tworzenie prac naukowych bez angażowania się w proces badawczy, co podważa autentyczność i wartość ich pracy. Tego typu praktyki, choć są coraz łatwiejsze do wykonania, stawiają wyzwania przed instytucjami edukacyjnymi w zakresie wykrywania nadużyć. Ponadto, AI może również przyczyniać się do rozwoju niskiej jakości publikacji naukowych, które nie przechodzą odpowiedniej weryfikacji merytorycznej, co wpływa na wiarygodność literatury naukowej i może prowadzić do dezinformacji w środowisku akademickim.

Przykłady rozwiązania problemów

Aby przeciwdziałać negatywnym skutkom rozwoju AI w nauce, należy wprowadzić odpowiednie regulacje i technologie wspierające uczciwość akademicką. Istnieją już narzędzia do wykrywania treści generowanych przez AI, które mogą pomóc w identyfikacji prac stworzonej w sposób nieetyczny. Dodatkowo, wprowadzenie systemów śledzenia zmian w tekstach oraz analizujących styl pisarski może stanowić skuteczną metodę weryfikacji autorstwa. Ważne jest także promowanie edukacji na temat etycznych zastosowań sztucznej inteligencji w środowiskach akademickich, co może zapobiec nadużyciom. Kluczową rolę w rozwiązaniu tych problemów odegra także stworzenie wytycznych dla wykładowców oraz studentów, które jasno określają granice dopuszczalnego użycia AI w pracy naukowej i edukacyjnej.

Literatura

- Uchendu, A., Lee, J., Shen, H., Le, T., Huang, T.-H. ’Kenneth’, & Lee, D. (2023). Does Human Collaboration Enhance the Accuracy of Identifying LLM-Generated Deepfake Texts?. Proceedings of the AAAI Conference on Human Computation and Crowdsourcing, 11(1), 163-174.

- https://www.reportprime.com/ghostwriting-services-r14029

- https://www.reuters.com/legal/legalindustry/us-copyright-office-issues-highly-anticipated-report-copyrightability-ai-2025-04-02/

- https://www.nature.com/articles/d41586-024-02371-z

- https://www.nature.com/nature/for-authors/initial-submission

- Draxler, F., Werner, A., Lehmann, F., Hoppe, M., Schmidt, A., Buschek, D., & Welsch, R. (2024). The AI ghostwriter effect: When users do not perceive ownership of AI-generated text but self-declare as authors. ACM Transactions on Computer-Human Interaction, 31(2), 1-40.

- Wang, Y., Lai, C. Y., Gómez-Serrano, J., & Buckmaster, T. (2023). Asymptotic self-similar blow-up profile for three-dimensional axisymmetric Euler equations using neural networks. Physical Review Letters, 130(24), 244002.

- Davies, A., Juhász, A., Lackenby, M., & Tomašev, N. (2024). The signature and cusp geometry of hyperbolic knots. Geometry & Topology, 28(5), 2313-2343.

- https://www.theatlantic.com/technology/archive/2024/10/terence-tao-ai-interview/680153/

- https://terrytao.wordpress.com/wp-content/uploads/2024/03/machine-jan-3.pdf

- Raitskaya, L., & Tikhonova, E. (2024). Appliances of Generative AI-Powered Language Tools in Academic Writing: A Scoping Review. Journal of Language and Education, 10(4), 5-30.

- https://nerdynav.com/chatgpt-cheating-statistics/

- https://www.nature.com/articles/d41586-025-01592-0

- Mitchell, E., Lee, Y., Khazatsky, A., Manning, C. D., & Finn, C. (2023, July). Detectgpt: Zero-shot machine-generated text detection using probability curvature. In International Conference on Machine Learning (pp. 24950-24962). PMLR.

Warto też wspomnieć, że Jednolity System Antyplagiatowy (JSA), który zresztą jest używany w APD USOS, został wzbogacony o funkcję sprawdzania, czy dana praca została napisana z użyciem sztucznej inteligencji: https://www.gov.pl/web/nauka/jsa–promotor-sprawdzi-czy-student-korzystal-z-technologii-chatgpt

Oczywiście pytanie o skuteczność…