W erze dynamicznego rozwoju sztucznej inteligencji coraz więcej firm sięga po algorytmy do podejmowania decyzji finansowych, analizy ryzyka czy obsługi klientów. Szczególnie w sektorze bankowym i transakcyjnym AI zaczyna odgrywać kluczową rolę w procesach, które jeszcze niedawno były zarezerwowane wyłącznie dla ludzi. Jednak wraz z rosnącym wpływem maszyn na decyzje o kredytach, inwestycjach czy wykrywaniu nadużyć, pojawia się fundamentalne pytanie: czy możemy zaufać decyzjom podejmowanym przez algorytmy, których działania często nie rozumiemy?

Zaufanie do AI nie powstaje samo – trzeba je aktywnie budować. Kluczowym elementem tego procesu jest wyjaśnialność decyzji podejmowanych przez systemy – czyli zdolność do zrozumienia, dlaczego algorytm podjął taką, a nie inną decyzję. W tym wpisie przyjrzymy się, jak budować transparentne, zrozumiałe i etyczne systemy AI w biznesie, ze szczególnym uwzględnieniem sektora bankowego i finansowego.

Dlaczego zaufanie do AI ma znaczenie?

W erze cyfrowej transformacji sztuczna inteligencja (AI) przestaje być tylko wizją przyszłości — staje się realnym narzędziem wpływającym na sposób działania współczesnych firm. Od usprawniania logistyki, przez analizę danych klientów, aż po automatyzację decyzji kredytowych czy transakcyjnych — AI już dziś wspiera codzienne procesy w biznesie. Jednak skuteczność algorytmów to tylko połowa sukcesu. Coraz bardziej decydujące staje się to, czy ludzie ufają technologiom, które podejmują decyzje za nich lub z nimi.

Zaufanie to nie tylko miękki aspekt komunikacji — to konkretna wartość, która przekłada się na akceptację, współpracę i jakość wdrożeń. Gdy użytkownicy nie rozumieją, jak działa AI, lub nie wiedzą, kto ponosi odpowiedzialność za jej decyzje, reagują niepewnością: mogą unikać korzystania z systemów, ignorować ich rekomendacje, a nawet je sabotować. Z kolei gdy wiedzą, dlaczego algorytm działa tak, a nie inaczej, kto za to odpowiada i jak mogą zweryfikować jego decyzję, czują się bezpieczniej i są skłonni aktywnie korzystać z tych rozwiązań.

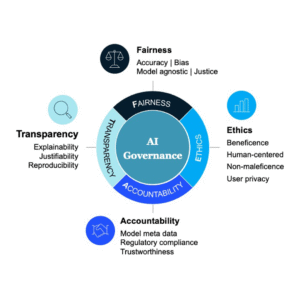

Dlatego tak istotne są cztery filary, na których powinno się opierać projektowanie odpowiedzialnej AI:

- sprawiedliwość (fairness) — czyli równe traktowanie użytkowników niezależnie od ich cech społecznych,

- odpowiedzialność (accountability) — jasno określona odpowiedzialność za działanie i skutki algorytmu,

- przejrzystość (transparency) — dostęp do informacji o tym, jak działa system i na jakiej podstawie podejmuje decyzje,

- etyka (ethics) — działania zgodne z wartościami organizacji i normami społecznymi.

W praktyce oznacza to konieczność projektowania AI tak, aby nie tylko działała skutecznie, ale również była postrzegana jako uczciwa, zrozumiała i przewidywalna. Przykładowo — jeśli algorytm odrzuca wniosek kredytowy, użytkownik powinien nie tylko otrzymać decyzję, ale też uzasadnienie: jakie czynniki miały największy wpływ, oraz co można poprawić. Taka komunikacja nie tylko zwiększa zaufanie, ale też buduje pozytywny wizerunek firmy jako odpowiedzialnej i godnej zaufania.

Zaufanie działa również wewnątrz organizacji. Pracownicy chętniej korzystają z narzędzi AI, jeśli czują, że systemy nie odbierają im kontroli ani nie niosą ryzyka niejasnych konsekwencji. Kiedy projektowanie modeli AI uwzględnia zarówno perspektywę techniczną, jak i społeczną, możliwe staje się stworzenie technologii, która nie tylko przyspiesza procesy, ale też wspiera relacje międzyludzkie i wzmacnia kulturę organizacyjną.

Z perspektywy biznesowej zaufanie do AI oznacza więc większą akceptację wdrożeń, lepsze relacje z klientami, wyższą jakość danych i skuteczniejsze, bardziej odpowiedzialne decyzje. Firmy, które potrafią zadbać o te cztery kluczowe aspekty — sprawiedliwość, odpowiedzialność, przejrzystość i etykę — nie tylko budują wiarygodność, ale też zabezpieczają swoją przyszłość w świecie coraz bardziej opartym na danych.

Przykłady zastosowania AI w biznesach

Sztuczna inteligencja coraz śmielej wkracza do świata biznesu i przestaje być jedynie technologiczną ciekawostką. Firmy wykorzystują ją, by działać szybciej, sprawniej i skuteczniej. Przykładem jest automatyzacja powtarzalnych zadań, takich jak przetwarzanie dokumentów czy obsługa klienta przez chatboty. Dzięki temu pracownicy mogą skupić się na bardziej złożonych i kreatywnych działaniach.

AI odgrywa również kluczową rolę w analizie danych. Umożliwia wykrywanie ukrytych wzorców i przewidywanie trendów, co pozwala podejmować trafniejsze decyzje – na przykład ocenić ryzyko inwestycji, zaplanować produkcję czy przewidzieć potrzeby klientów.

Szczególnie istotna jest także personalizacja. Algorytmy rekomendacyjne, znane z platform takich jak Netflix czy Amazon, pozwalają firmom dopasować ofertę do konkretnych użytkowników, zwiększając sprzedaż i lojalność.

W logistyce i produkcji AI wspiera planowanie tras, zarządzanie zapasami i przewidywanie awarii maszyn, co przekłada się na mniejsze koszty i większą niezawodność. Coraz częściej staje się też inspiracją do tworzenia zupełnie nowych produktów i usług, takich jak inteligentne aplikacje zdrowotne czy systemy edukacyjne dopasowane do stylu uczenia się użytkownika.

W efekcie AI staje się nie tylko narzędziem wsparcia, ale motorem innowacji, który zmienia sposób myślenia o biznesie.

Strategie wyjaśniania decyzji w systemach bankowych, transakcyjnych i decyzyjnych

W sektorze finansowym systemy AI nie tylko wspomagają decyzje – coraz częściej podejmują je samodzielnie, np. zatwierdzając transakcje, wykrywając nadużycia lub analizując zdolność kredytową. W tych zastosowaniach kluczowe staje się wyjaśnianie, dlaczego algorytm uznał daną decyzję za słuszną. Poniżej przedstawiamy cztery główne strategie wraz z przykładami wdrożeń.

Modele interpretable-by-design (zrozumiałe „z natury”)

To modele, których działanie jest łatwe do prześledzenia – każdy etap procesu decyzyjnego można opisać prostymi zasadami lub zależnościami statystycznymi. Systemy te charakteryzują się pełną przejrzystością, co sprawia, że są łatwe do audytowania. Ich działanie jest zrozumiałe zarówno dla użytkowników końcowych, jak i dla instytucji regulacyjnych. Jednak ich wadą jest ograniczona precyzja w przypadku bardzo złożonych scenariuszy, takich jak wykrywanie oszustw finansowych o nietypowym wzorcu.

Przykłady algorytmów:

- Regresja logistyczna:

na przykład w systemach scoringowych do oceny ryzyka kredytowego. Bank może jasno pokazać: „Podstawą negatywnej decyzji był zbyt niski dochód miesięczny oraz wcześniejsze opóźnienia w spłacie rat”. - Drzewa decyzyjne:

używane na przykład w segmentacji klientów dla ofert kredytowych. Klient trafia do jednej z gałęzi drzewa, co pozwala zrozumieć, jakie cechy zadecydowały o ofercie. - Systemy regułowe:

przykładowo w automatycznej weryfikacji tożsamości lub w zatwierdzaniu transakcji poniżej ustalonego progu ryzyka („jeśli klient zalogował się z bezpiecznego urządzenia i nie przekroczył limitu – transakcja zostaje zatwierdzona”).

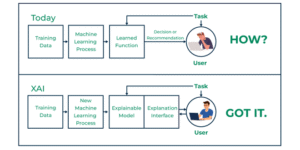

Techniki XAI dla „czarnych skrzynek”

Gdy bank stosuje złożone modele, np. sieci neuronowe lub algorytmy ensemble takie jak chociażby Random-Forest, nie da się już tak łatwo „zobaczyć” jak model podejmuje decyzję. W takich sytuacjach wykorzystuje się narzędzia Explainable AI. Techniki XAI umożliwiają stosowanie skutecznych, złożonych modeli bez konieczności rezygnacji z ich wyjaśnialności, a przy tym są skalowalne i sprawdzają się na dużych zbiorach danych. Ich zastosowanie niesie jednak pewne wyzwania — generowane wyjaśnienia mają charakter przybliżony, co może utrudniać ich interpretację dla klientów. Dodatkowo, skuteczne wykorzystanie tych technik wymaga odpowiednio zaprojektowanego interfejsu oraz przeszkolenia personelu w zakresie interpretacji wyników.

Narzędzia i przykłady zastosowań:

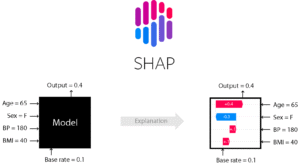

- SHAP (SHapley Additive exPlanations):

SHAP umożliwia również globalne analizy: które czynniki najczęściej wpływają na odmowę kredytu w całej populacji klientów.

Zastosowanie: w ocenie ryzyka kredytowego – bank może pokazać ranking wpływu zmiennych na decyzję dla danego klienta:

„Dochód: -0.35, historia spłat: +0.25, wiek konta: +0.10”

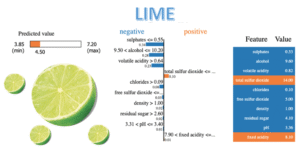

- LIME (Local Interpretable Model-agnostic Explanations):

LIME działa na zasadzie lokalnego „podglądu” modelu, tłumacząc decyzję dla pojedynczego przypadku.

Zastosowanie: przy blokadzie transakcji – np. klient otrzymuje informację:

„Transakcja zablokowana, ponieważ lokalizacja i godzina są nietypowe w porównaniu z Twoją historią”.

- Heatmapy i wizualizacje (np. w fraud detection)

Heatmapy i wizualizacje wskazują, które cechy miały największy wpływ na decyzję algorytmu.

Zastosowanie: analityk AML (Anti-Money Laundering) może zobaczyć, które cechy profilu klienta i transakcji przyczyniły się do zaklasyfikowania jej jako podejrzanej – np. niespójność między deklarowanym zawodem a wartościami przelewów.

Warstwa komunikacyjna – tłumaczenie wyników modelu użytkownikowi

Nawet najlepszy algorytm wyjaśniający nie zwiększy zaufania, jeśli jego wyniki nie zostaną przekazane w sposób zrozumiały, przejrzysty i etyczny. Zastosowanie warstwy komunikacyjnej prowadzi do zwiększenia zaufania klientów, co przekłada się na mniejszą liczbę reklamacji. Dodatkowo, poprawia przejrzystość procesów wewnętrznych, wspierając lepsze zrozumienie podejmowanych decyzji zarówno przez klientów, jak i pracowników organizacji.

Praktyczne zastosowania:

- Komunikaty przy odrzuceniu wniosku o kredyt:

Odrzucenie wniosku o kredyt może być komunikowane w sposób jasny i konkretny, np:

„Twoja historia kredytowa zawiera zaległości w spłacie rat z ostatnich 12 miesięcy, co obniżyło Twój scoring.” - Podpowiedzi w interfejsie:

System może podpowiedzieć użytkownikowi: „Zwiększenie stałych wpływów o 500 zł miesięcznie może poprawić Twój scoring o 15%”. - Pulpity dla pracowników banku:

Analityk lub konsultant może mieć dostęp do wyjaśnienia decyzji modelu w formie czytelnego dashboardu z rankingiem cech, wykresami i rekomendacjami.

Procedury audytu i dokumentowania decyzji algorytmów

Budowanie zaufania to również zapewnienie, że każdą decyzję podejmowaną przez system AI da się odtworzyć i uzasadnić – nawet po dłuższym czasie. W odpowiedzi na te potrzeby coraz więcej instytucji wdraża narzędzia umożliwiające automatyczne logowanie decyzji algorytmicznych, przechowywanie metadanych dotyczących przebiegu procesu decyzyjnego (takich jak wersja modelu, dane wejściowe czy wygenerowany wynik), a także prowadzenie okresowych audytów i walidacji algorytmów. Działania te mają na celu zwiększenie przejrzystości, odpowiedzialności oraz zgodności z regulacjami.

Przykład zastosowania:

- Audyty decyzji kredytowych – jeśli klient zgłasza reklamację, bank może prześledzić decyzję krok po kroku, z wykorzystaniem zapisanych wyjaśnień SHAP/LIME.

- Zgodność z regulacjami (np. RODO) – klient ma prawo do „zrozumiałych informacji o logice podejmowania decyzji” (Art. 22), a system audytowy umożliwia spełnienie tego obowiązku.

Zalety budowania zaufania do AI w biznesie – fundament odpowiedzialnej transformacji

Sztuczna inteligencja (AI) przekształca sposób, w jaki firmy analizują dane, podejmują decyzje i wchodzą w interakcje z klientami. Jednak sama skuteczność algorytmu nie wystarcza. Aby AI mogła realnie przynosić wartość biznesową, musi być również zrozumiała, przejrzysta i godna zaufania. Poniżej przedstawiamy kluczowe korzyści wynikające z budowania zaufania do AI w środowisku biznesowym.

Większa akceptacja decyzji systemów AI

W sytuacjach, w których AI podejmuje decyzje wpływające bezpośrednio na ludzi – takich jak przyznanie kredytu, odrzucenie wniosku, rekomendacja produktu – zaufanie ma kluczowe znaczenie. Jeżeli użytkownik rozumie, dlaczego system zaproponował daną decyzję, jest bardziej skłonny ją zaakceptować, nawet jeśli nie jest ona dla niego korzystna. Wyjaśnialność buduje spójność między człowiekiem a technologią.

Poprawa relacji z klientami

Zaufanie klientów to jeden z filarów silnej marki. Gdy firma pokazuje, że jej systemy AI działają w sposób uczciwy, zgodny z zasadami etycznymi i są otwarte na kontrolę, wzmacnia swój wizerunek jako odpowiedzialnej organizacji. Klienci chętniej powierzają swoje dane, korzystają z usług cyfrowych i są mniej skłonni do składania reklamacji, gdy mają poczucie, że technologia działa transparentnie.

Redukcja ryzyka prawnego i reputacyjnego

Wraz z rosnącą obecnością AI w sektorach regulowanych – takich jak finanse, zdrowie czy administracja – rośnie też presja na spełnianie norm prawnych. Budowanie zaufania poprzez zgodność z regulacjami (np. EU AI Act, NIST RMF, RODO) chroni firmy przed kosztownymi karami, utratą reputacji czy postępowaniami sądowymi. Transparentność i możliwość audytu działania AI stają się dziś nie tyle opcją, co koniecznością.

Wzmocnienie kultury organizacyjnej i zaufania wewnętrznego

Zaufanie do AI nie dotyczy tylko klientów. Równie ważne jest przekonanie pracowników, że algorytmy ich wspierają, a nie zastępują. Jeśli decyzje AI są postrzegane jako arbitralne lub niejasne, pracownicy mogą czuć się marginalizowani lub zagrożeni. Jasne reguły działania systemów, możliwość ich nadzorowania oraz udział człowieka w podejmowaniu decyzji budują poczucie sprawczości i odpowiedzialności.

Lepsze decyzje biznesowe dzięki współpracy człowieka z AI

Sztuczna inteligencja działa najlepiej wtedy, gdy jest częścią hybrydowego modelu decyzyjnego – w którym człowiek i maszyna uzupełniają się nawzajem. Gdy decyzje AI są wyjaśnialne, ludzie mogą je kontrolować, poprawiać lub odrzucać. To pozwala uniknąć błędów systemowych, wykrywać uprzedzenia w danych i podejmować bardziej trafne i odpowiedzialne decyzje.

Szybsze wdrażanie AI na dużą skalę

Organizacje, które już na etapie pilotażu inwestują w przejrzystość i komunikację wokół działania AI, znacznie łatwiej skalują te rozwiązania. Gdy użytkownicy rozumieją zasady działania systemu, szybciej się z nim oswajają i są bardziej otwarci na dalsze automatyzacje. To przyspiesza cyfrową transformację i adaptację nowych technologii.

Przewaga konkurencyjna na rynku

W świecie, gdzie każda firma może kupić podobny algorytm predykcyjny, to zaufanie staje się prawdziwym wyróżnikiem. Firmy, które potrafią wykazać, że ich AI działa uczciwie, odpowiedzialnie i z poszanowaniem wartości klientów, zdobywają lojalność użytkowników i przewagę w oczach partnerów, regulatorów i inwestorów. Zaufanie do AI to dziś część reputacyjnego kapitału firmy.

Wady budowania zaufania do AI w biznesie – gdy dobre intencje mogą przynieść odwrotny skutek

Choć budowanie zaufania do sztucznej inteligencji (AI) w biznesie uchodzi za klucz do jej akceptacji i skutecznego wdrożenia, nie zawsze przebiega bez problemów. Co więcej, w niektórych przypadkach może nieść ze sobą ryzyka i niezamierzone konsekwencje. Warto więc przyjrzeć się również ciemniejszej stronie tego procesu.

Pierwszym zagrożeniem jest zbytnie uproszczenie przekazu. Firmy, chcąc zdobyć zaufanie klientów i pracowników, często prezentują AI jako coś całkowicie bezpiecznego, przejrzystego i obiektywnego. W praktyce jednak technologia ta bywa skomplikowana, nieprzewidywalna i podatna na błędy. Zbyt optymistyczny przekaz może prowadzić do tzw. ślepego zaufania, czyli przekonania, że skoro AI działa, to nie trzeba jej już kontrolować. Tymczasem każdy system – nawet najbardziej zaawansowany – wymaga nadzoru i zdrowego sceptycyzmu.

Drugim problemem jest „AI-washing” — zjawisko polegające na deklarowaniu etycznego podejścia do AI, które w rzeczywistości nie ma pokrycia w działaniach. Firmy mogą używać języka zaufania jako strategii marketingowej, nie wprowadzając realnych mechanizmów odpowiedzialności czy transparentności. W takim przypadku próba budowania zaufania staje się manipulacją, co w dłuższej perspektywie może prowadzić do poważnych kryzysów wizerunkowych.

Kolejnym wyzwaniem są koszty i czasochłonność. Budowanie zaufania do AI wymaga nie tylko jasnej komunikacji i edukacji użytkowników, ale także odpowiednich procedur, testów i audytów etycznych. Dla wielu firm może to oznaczać spowolnienie wdrożeń lub konieczność inwestowania w nowe kompetencje, które trudno zdobyć. W niektórych przypadkach nadmierna ostrożność może nawet zniechęcać do innowacji.

Istnieje też ryzyko konfliktów wewnętrznych. W organizacjach może pojawić się napięcie między zespołami technologicznymi (skupionymi na efektywności algorytmów) a działami odpowiedzialnymi za etykę, komunikację czy zgodność z przepisami. Zaufanie nie zawsze da się zbudować szybko i łatwo – czasem wymaga to kompromisów, które ograniczają funkcjonalność systemów lub opóźniają ich wdrożenie.

Wreszcie, budowanie zaufania może prowadzić do błędnej alokacji odpowiedzialności. Jeśli AI zostanie przedstawiona jako „wiarygodny doradca”, użytkownicy mogą zrzucać na nią odpowiedzialność za swoje decyzje. To szczególnie niebezpieczne w takich obszarach jak medycyna, prawo czy rekrutacja – gdzie ostateczne decyzje powinni podejmować ludzie, nie maszyny.

Konkluzje i przemyślenia

Budowanie zaufania do AI to nie jednorazowy projekt, lecz długofalowy proces, który powinien być integralnym elementem strategii każdej organizacji wdrażającej sztuczną inteligencję. Szczególnie w sektorach takich jak bankowość, finanse czy systemy transakcyjne — gdzie decyzje mają bezpośredni wpływ na ludzi i ich zasoby — transparentność, wyjaśnialność oraz etyczność działania algorytmów są nie tylko pożądane, ale wręcz niezbędne.

Z jednej strony zaufanie do AI przynosi konkretne korzyści: zwiększa akceptację technologii, usprawnia procesy, wzmacnia relacje z klientami i buduje przewagę konkurencyjną. Z drugiej — wymaga świadomych inwestycji, odpowiedzialnego projektowania systemów oraz odwagi w mierzeniu się z ograniczeniami technologii.

Nie wystarczy, że AI działa skutecznie. Musi też działać uczciwie, w sposób możliwy do zrozumienia i zakwestionowania. Firmy, które potrafią przełożyć złożoność algorytmów na zrozumiałe komunikaty i zapewnić użytkownikom poczucie kontroli, stają się liderami odpowiedzialnej transformacji cyfrowej.

Zaufanie to kapitał — ale kapitał, który trzeba codziennie pielęgnować. Dlatego przyszłość biznesu opartego na AI będzie należeć do tych, którzy postawią na transparentność, uczciwość i dialog, a nie jedynie na technologiczną przewagę.

Źródła

- Why Explainable AI in Banking and Finance Is Critical for Compliance. https://www.lumenova.ai/blog/ai-banking-finance-compliance

- Building Trust with Explainable AI. https://ai.plainenglish.io/building-trust-with-explainable-ai-why-transparency-is-the-future-of-intelligent-business-879aa6b20001

- Building AI trust: The key role of explainability. https://www.mckinsey.com/capabilities/quantumblack/our-insights/building-ai-trust-the-key-role-of-explainability

- Explainable AI in Banking. https://blog.transformhub.com/explainable-ai-in-banking-building-customer-trust-in-algorithmic-decisions

- Unleashing the power of machine learning models in banking through explainable artificial intelligence https://www.deloitte.com/us/en/insights/industry/financial-services/explainable-ai-in-banking.html

- Marc Schmitt, 2024. „Explainable Automated Machine Learning for Credit Decisions: Enhancing Human Artificial Intelligence Collaboration in Financial Engineering” Papers 2402.03806, arXiv.org.

- Memarian, B., & Doleck, T. (2023). Fairness, accountability, transparency, and ethics (FATE) in artificial intelligence (AI) and higher education: A systematic review. Computers and Education: Artificial Intelligence, 5, 100152. https://doi.org/10.1016/j.caeai.2023.100152

[…] poprzednim artykule skupiliśmy się na seks robotach w ogólności, a także na najpopularniejszej formie tego […]