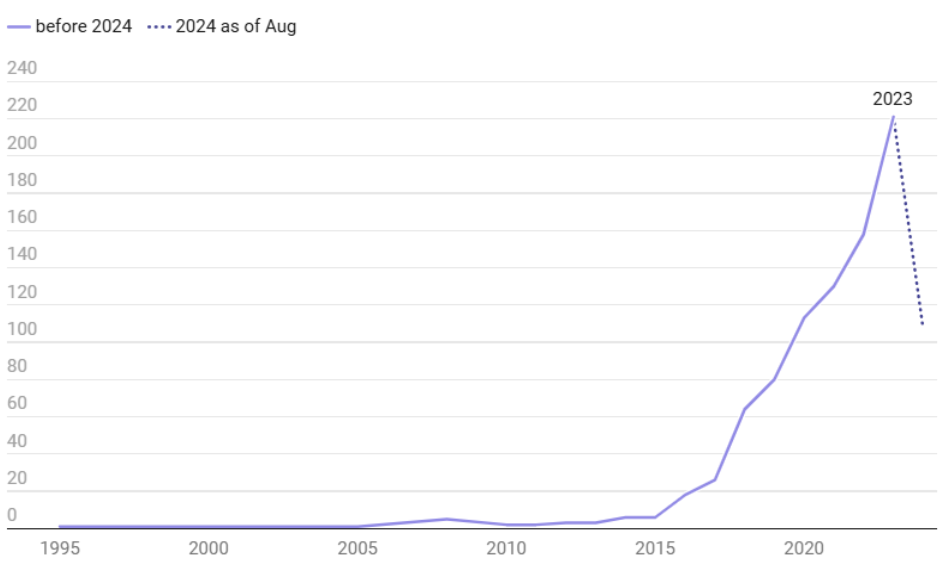

Współczesna medycyna znajduje się u progu przełomu, którego siłą napędową jest dynamiczny rozwój sztucznej inteligencji (AI). Systemy AI coraz śmielej wkraczają w obszar opieki zdrowotnej – wspierając proces diagnostyczny, umożliwiając personalizację terapii oraz usprawniając funkcjonowanie całego systemu ochrony zdrowia. Liczba zatwierdzonych do użytku klinicznego urządzeń medycznych opartych na AI systematycznie rośnie – do sierpnia 2024 roku Amerykańska Agencja ds. Żywności i Leków (FDA) wydała zgodę na wdrożenie 950 takich rozwiązań.

Mimo imponującego postępu technologicznego, ich powszechna adaptacja wciąż napotyka poważną przeszkodę: brak zaufania. Aby sztuczna inteligencja mogła w pełni wykorzystać swój potencjał w medycynie, konieczne jest zbudowanie solidnych podstaw zaufania – na każdym poziomie systemu opieki zdrowotnej.

Zaufanie a poleganie: co to właściwie znaczy w kontekście AI?

Zrozumienie, czym jest zaufanie, ma kluczowe znaczenie dla projektowania systemów sztucznej inteligencji w obszarze opieki zdrowotnej. W relacjach międzyludzkich zaufanie definiuje się jako poleganie na dobrej woli drugiej osoby, często zakładające troskę o dobrostan tego, kto obdarza zaufaniem. Z kolei poleganie oznacza przekonanie o określonych kompetencjach lub dyspozycjach danego podmiotu oraz gotowość do działania w oparciu o to przekonanie.

Ważne jest jednak rozróżnienie tych pojęć w kontekście sztucznej inteligencji. AI nie może być obdarzona zaufaniem w ludzkim, moralnym sensie, ponieważ nie posiada zdolności do troski ani intencjonalności. Brakuje jej rozumienia emocjonalnego i etycznego wymiaru ludzkiego dobrostanu. Oznacza to, że choć możemy polegać na AI – uznając jej zdolność do skutecznego wykonywania konkretnych zadań – nie możemy jej ufać w tym głębszym, interpersonalnym znaczeniu.

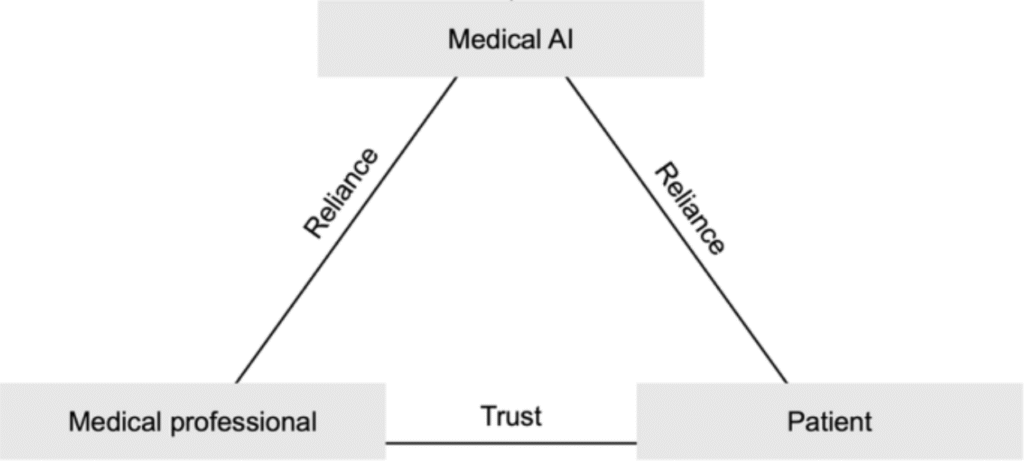

W środowisku medycznym wypracowano tzw. „trójkąt postaw”, obrazujący idealne relacje między trzema kluczowymi interesariuszami: pacjentem, personelem medycznym i systemami sztucznej inteligencji.

- Zaufanie pacjenta do personelu medycznego

To fundament skutecznego leczenia oraz satysfakcji pacjenta. Zaufanie redukuje niepewność i złożoność decyzji medycznych, umożliwiając większe zaangażowanie w proces terapeutyczny. Jego brak – np. spowodowany przekonaniem, że cele finansowe przeważają nad troską o dobro pacjenta – może prowadzić do emocjonalnego napięcia i problemów z przestrzeganiem zaleceń.

- Poleganie personelu medycznego na systemach AI

Podobnie jak w przypadku innych narzędzi medycznych, lekarze muszą mieć uzasadnione przekonanie, że technologia jest skuteczna, bezpieczna i transparentna. Warunkiem koniecznym jest wysoka jakość danych treningowych, walidacja kliniczna oraz możliwość audytu działania systemu.

- Poleganie pacjenta na systemach AI

Gotowość pacjenta do zaakceptowania AI jako elementu opieki zdrowotnej zależy w dużej mierze od zaufania, jakim darzy personel korzystający z tej technologii. Wpływają na nią także poziom wiedzy pacjenta na temat działania AI oraz sposób, w jaki uwzględnia się jego obawy i potrzeby.

Diagnoza medyczna w erze AI

Diagnoza medyczna to fundamentalny element skutecznej opieki zdrowotnej. Jej szybkość i trafność są kluczowe dla zapewnienia efektywnego leczenia.

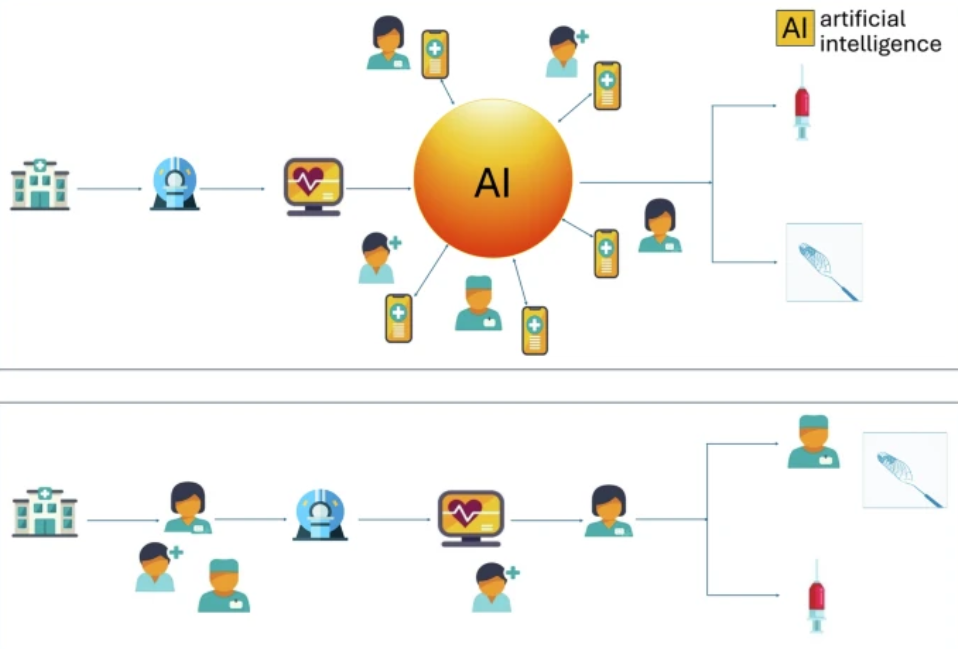

Tradycyjnie, proces diagnostyczny opiera się na badaniu pacjenta, zbieraniu danych i intuicyjnej ocenie stanu zdrowia przez lekarza, a następnie na iteracyjnym udoskonalaniu tej oceny, prowadzącym do postawienia diagnozy.

W Wielkiej Brytanii przeprowadzono badanie przyjęcia systemu AI do wspomagania diagnostyki udaru. W przeciwieństwie do tradycyjnego procesu, gdzie diagnoza jest punktem końcowym, AI dostarcza swoją „diagnozę” w postaci algorytmicznego wyniku już we wczesnych fazach procesu diagnostycznego. Wynik ten, np. obecność okluzji naczynia czy procent uszkodzonego mózgu, jest prezentowany w formie kolorowych map i reprezentacji 3D. Jest to ogromna zmiana, ponieważ rekomendacja AI jest dostępna niemal natychmiastowo i jest szeroko dystrybuowana do całego zespołu lekarzy. Następnie ocenie jej trafności poprzez wielokrotne etapy weryfikacji. Zatem proces diagnostyki rozpoczyna się od sugerowanej diagnozy, która w klasycznym procesie jest ostatnim etapem.

Zaufanie decydentów i właścicieli placówek medycznych do systemów AI

Oprócz personelu medycznego i pacjentów, kluczową rolę w adaptacji technologii AI odgrywają również decydenci – właściciele klinik, dyrektorzy szpitali oraz osoby zarządzające budżetami i strategiami rozwoju placówek medycznych. Ich zaufanie do rozwiązań opartych na sztucznej inteligencji opiera się nie tyle na rozumieniu działania algorytmów, co na ocenie korzyści organizacyjnych, kosztowych oraz reputacyjnych.

W odróżnieniu od lekarzy, którzy koncentrują się na klinicznej skuteczności i kontroli decyzyjnej, zarządzający placówkami zwracają uwagę na takie aspekty jak:

- zgodność z przepisami i uwarunkowaniami prawnymi (compliance),

- bezpieczeństwo danych pacjentów,

- zwrot z inwestycji (ROI),

- wpływ na efektywność operacyjną i jakość usług,

- ryzyko wizerunkowe w przypadku błędów algorytmu.

Brak jasnych wytycznych regulacyjnych, ograniczona przejrzystość modeli oraz niepewność co do zakresu odpowiedzialności prawnej mogą zniechęcać inwestorów i właścicieli placówek do wdrażania nowych rozwiązań. W rezultacie, nawet najlepszy model AI może nie zostać zastosowany w praktyce, jeśli nie zostanie przedstawiony w sposób zrozumiały i bezpieczny z punktu widzenia decyzji biznesowej.

Dlatego budowanie zaufania na poziomie zarządczym powinno obejmować:

- transparentne raportowanie skuteczności i ograniczeń modelu,

- gwarancje wsparcia technicznego i odpowiedzialności po stronie dostawcy,

- zgodność z obowiązującymi przepisami RODO/GDPR i certyfikatami medycznymi,

- materiały onboardingowe ułatwiające zrozumienie ryzyk i korzyści.

Wyzwania w budowaniu zaufania do medycznej AI

Aby zbudować i utrzymać zaufanie do systemów sztucznej inteligencji w opiece zdrowotnej, należy zmierzyć się z szeregiem istotnych wyzwań:

- Problem „czarnej skrzynki” (Black Box Problem)

Wiele systemów AI, zwłaszcza tych opartych na głębokim uczeniu, funkcjonuje jako „czarne skrzynki” – ich wewnętrzne mechanizmy podejmowania decyzji są nieprzejrzyste i trudne do zinterpretowania. Ta luka interpretowalności może prowadzić do braku zrozumienia, a nawet do błędu potwierdzenia (confirmation bias), w którym użytkownicy selektywnie poszukują informacji potwierdzających wcześniejsze założenia. Brak przejrzystości ogranicza możliwość praktycznego zastosowania AI w sytuacjach klinicznych, gdzie lekarze potrzebują wglądu w proces decyzyjny algorytmu. - Uprzedzenia w danych (Bias in Data)

Systemy AI są tak dobre, jak dane, na których zostały wyszkolone. Mogą jednak nieświadomie odtwarzać i wzmacniać istniejące uprzedzenia – np. algorytm szacujący potrzeby pacjenta na podstawie kosztów opieki może odzwierciedlać systemowe nierówności, w których pacjenci czarnoskórzy otrzymują mniej środków mimo gorszego stanu zdrowia. Podobnie, algorytmy wykrywające raka skóry często działają mniej skutecznie u osób o ciemniejszej karnacji, ponieważ dane treningowe są zdominowane przez obrazy skóry osób o jasnej karnacji. Wynika to częściowo z faktu, że czerniak występuje znacznie częściej u osób rasy białej, co przekłada się na dominację zdjęć takich osób w zbiorach treningowych. Jednak brak reprezentatywnych danych prowadzi do gorszej skuteczności diagnozy u pacjentów z innych grup etnicznych, co może pogłębiać istniejące nierówności zdrowotne. Problem ten jest szczególnie istotny w systemach o niskiej interpretowalności, gdzie trudno ustalić, dlaczego model zawodzi.Co istotne, problem ten nie ogranicza się jedynie do projektowania modeli, ale sięga również poziomu regulacyjnego. Jak zauważają autorzy raportu opublikowanego w PLOS Digital Health, część medycznych produktów wykorzystujących AI zostało zatwierdzonych przez FDA mimo niepełnych danych i niewystarczających dowodów skuteczności. W wielu przypadkach dokumentacja nie zawierała kluczowych informacji dotyczących procedur testowych, grup walidacyjnych czy strategii łagodzenia uprzedzeń, a same testy często przeprowadzano na zbyt małych lub jednorodnych próbach. To oznacza, że niektóre z zatwierdzonych narzędzi mogą nie działać poprawnie w zróżnicowanych populacjach pacjentów – na przykład wśród dzieci, seniorów czy przedstawicieli mniejszości etnicznych – co podważa zaufanie do bezpieczeństwa i rzetelności systemów AI w medycynie. - Nadmierne poleganie na AI (Automation Bias)

Wyjaśnienia generowane przez AI mogą paradoksalnie zwiększać zaufanie nawet wtedy, gdy rekomendacje są błędne. W badaniu z użyciem modelu CORONET, który celowo sugerował błędny wypis pacjenta, większość pracowników medycznych mimo to akceptowała decyzję modelu – 65% w scenariuszu bez wyjaśnień i 48% z wyjaśnieniami. Co więcej, decyzje zgodne z rekomendacją AI były podejmowane szybciej, co sugeruje bezrefleksyjne poleganie na technologii. - Niejasna komunikacja niepewności

Brak wyraźnego sygnalizowania poziomu pewności predykcji może podważyć zaufanie użytkowników. Personel medyczny często uznaje informację o niepewności modelu za ważniejszą niż konkretne cechy wpływające na decyzję – 96% badanych HCPs wskazało ją jako istotną, a 43% zdecydowanie się z tym zgodziło. Jasna komunikacja niepewności zwiększa zaufanie i skłonność do podążania za rekomendacjami modelu. - Brak kontroli i autonomii

Brak zaufania często wynika też z obawy przed utratą kontroli. Lekarze chcą mieć realny wpływ na decyzje medyczne, a nie być jedynie wykonawcami zaleceń wygenerowanych przez algorytm. Kluczowe jest więc, by systemy AI dawały możliwość ich nadpisania czy zakwestionowania. Dodatkowo, niejasności co do odpowiedzialności prawnej – czy za ewentualny błąd odpowiada lekarz, twórca systemu czy instytucja – budzą niepokój i mogą zniechęcać do korzystania z takich rozwiązań. - Przeciążenie informacyjne

Zbyt duża ilość danych lub ich nieadekwatna prezentacja może prowadzić do przeciążenia poznawczego, zmniejszając efektywność komunikacji i zrozumienia. W jednym z badań 17% pracowników ochrony zdrowia przyznało, że wyjaśnienia działania modelu doprowadziły u nich do niższego zrozumienia powodów błędnych rekomendacji.

Jak projektować systemy AI, by budować zaufanie?

Aby medyczna AI była skuteczna, jej projektowanie i wdrażanie muszą uwzględniać czynniki sprzyjające budowaniu zaufania pacjentów. Oto najważniejsze zasady:

- Przejrzystość i wyjaśnialność (XAI)

Wyjaśnienia generowane przez system powinny być zrozumiałe, lokalne i specyficzne dla kontekstu, w jakim działa personel medyczny. Przykładowo, dostosowanie formy wyjaśnień do języka wizualnego dermatologów zwiększa ich pewność siebie i zaufanie do AI. Kluczowe jest również, by wyjaśnienia były wierne — czyli rzeczywiście odzwierciedlały proces decyzyjny modelu, a nie jedynie upraszczały go do oczekiwań użytkownika. - Komunikacja niepewności

Lekarze często bardziej cenią informację o stopniu niepewności predykcji niż szczegółowe wyjaśnienia. Systemy AI powinny jasno wskazywać, kiedy model działa z ograniczoną pewnością, aby umożliwić świadome podjęcie decyzji opartej na ryzyku, a nie bezkrytycznym przyjęciu rekomendacji. Prezentowanie niepewności powinno być nie tylko dokładne, ale i czytelne — np. w formie przedziałów ufności, skal prawdopodobieństwa lub prostych etykiet. - Współtworzenie i mechanizmy sprzężenia zwrotnego

Zaufanie można budować poprzez wczesne i aktywne zaangażowanie przyszłych użytkowników — personelu medycznego, pacjentów oraz przedstawicieli grup wsparcia — w projektowanie i testowanie systemu. Ważne jest też stworzenie pętli zwrotnych, w których użytkownicy mogą przekazywać uwagi i obserwacje twórcom systemu, co pozwala na bieżące dopasowywanie modelu do rzeczywistych potrzeb klinicznych. - Przejrzysta i standaryzowana dokumentacja

Każdy system AI musi być opatrzony kartą faktów zawierającą m.in.: opis algorytmu, zakres użycia, ograniczenia, wskaźniki skuteczności i odpowiedzialność prawą. Kluczowe jest jednak, by skład i źródła wszystkich danych treningowych były w pełni jawne — z informacją o ich pochodzeniu i reprezentatywności. Dokumentacja powinna być czytelna przede wszystkim dla personelu, ale również dla pacjentów. - Poszanowanie autonomii decyzyjnej

AI powinna wspierać decyzje medyczne, a nie je zastępować. Lekarz musi mieć możliwość zakwestionowania, modyfikacji lub zignorowania rekomendacji systemu, jeżeli uzna to za zasadne. Systemy AI nie mogą ograniczać czasu ani jakości kontaktu lekarza z pacjentem, nawet jeśli ich wdrożenie ma na celu zwiększenie efektywności. Budowanie zaufania wymaga także jasnego zakomunikowania, że to człowiek ponosi ostateczną odpowiedzialność za decyzję. System powinien być zaprojektowany tak, by nie wywierać presji na użytkownika — np. przez dominujący język - Monitorowanie, aktualizacje i nadzór

Po wdrożeniu systemów AI niezbędne jest ich regularne monitorowanie i audytowanie — szczególnie na wczesnych etapach klinicznego zastosowania. Powinno to obejmować nie tylko ocenę skuteczności i bezpieczeństwa, ale także zbieranie danych o rzeczywistym użytkowaniu, barierach wdrożeniowych oraz poziomie zaufania personelu.

Case studies

Choć wyzwania związane z budowaniem zaufania do medycznych systemów AI są istotne, nie sposób pominąć przykładów, w których sztuczna inteligencja przyniosła wymierne korzyści zarówno dla pacjentów, jak i personelu oraz całych placówek medycznych. Poniżej przedstawiono cztery wybrane przypadki z ostatnich lat, które pokazują, jak AI może realnie usprawnić działanie systemu ochrony zdrowia.

1. Optymalizacja sal operacyjnych – przykład Opmed.ai

Jednym z najbardziej spektakularnych sukcesów AI w ostatnich latach było wdrożenie narzędzia do inteligentnego planowania wykorzystania sal operacyjnych. System ten, wdrożony m.in. w amerykańskich szpitalach, analizuje dane historyczne, bieżące zapotrzebowanie i harmonogramy lekarzy, aby w czasie rzeczywistym optymalizować przydział bloków operacyjnych.

Efekty były spektakularne. Udało się wygenerować dodatkowe przychody rzędu ponad miliona dolarów rocznie na jedną salę operacyjną oraz ograniczyć koszty funkcjonowania o kilkaset tysięcy dolarów. Co istotne, usprawnienia przełożyły się również na zmniejszenie obciążenia personelu – znacznie ograniczono nadgodziny, poprawiono punktualność operacji i zredukowano wypalenie zawodowe wśród anestezjologów oraz pielęgniarek. To jeden z przykładów, gdzie AI nie tylko zwiększa efektywność, ale też poprawia warunki pracy ludzi.

2. Wczesne wykrywanie nowotworów – system C the Signs

W Wielkiej Brytanii sztuczna inteligencja została z powodzeniem wdrożona w praktykach lekarzy rodzinnych w ramach projektu C the Signs. System analizuje dane medyczne pacjentów – w tym objawy, historię chorób, dane demograficzne – i w czasie rzeczywistym sugeruje dalsze kroki diagnostyczne oraz konieczność skierowania na dodatkowe badania w kierunku choroby nowotworowej.

Po wdrożeniu systemu w kilkudziesięciu przychodniach wschodniej Anglii, wykrywalność nowotworów wzrosła o kilka punktów procentowych, co przekłada się na setki uratowanych istnień ludzkich. Skrócono również czas oczekiwania na diagnozę – z kilku tygodni do zaledwie kilkudziesięciu sekund od wprowadzenia danych do systemu. Przykład ten pokazuje, jak AI może wspierać lekarzy pierwszego kontaktu w podejmowaniu szybkich i trafnych decyzji, przy jednoczesnym poszanowaniu ich autonomii.

3. Automatyzacja procesów administracyjnych – doświadczenie Omega Healthcare

Zupełnie inny, lecz równie istotny obszar usprawnień dotyczy automatyzacji procesów administracyjnych, takich jak rozliczenia z ubezpieczycielami, fakturowanie czy wprowadzanie danych do systemów szpitalnych. Firma Omega Healthcare wdrożyła rozwiązanie łączące sztuczną inteligencję z automatyzacją procesów (RPA), dzięki czemu udało się zaoszczędzić tysiące godzin pracy administracyjnej miesięcznie.

System samodzielnie przetwarza dokumenty, weryfikuje poprawność danych, wypełnia formularze i obsługuje korespondencję z płatnikami. W rezultacie zespół administracyjny może skupić się na bardziej złożonych zadaniach wymagających wiedzy i kontaktu z pacjentem. Automatyzacja przyczyniła się także do wzrostu dokładności i przyspieszenia procesów, zmniejszając ryzyko błędów i poprawiając płynność finansową placówek medycznych.

4. Przestroga z przeszłości – katastrofa systemu Therac‑25

Nie wszystkie przykłady wdrożeń systemów komputerowych w medycynie kończyły się sukcesem. Przypadek Therac‑25 to dramatyczna lekcja pokazująca, jak niebezpieczne może być zbyt pochopne zaufanie technologii bez odpowiednich zabezpieczeń i nadzoru.

Therac‑25 był komputerowo sterowanym urządzeniem do radioterapii, produkowanym w latach 80. XX wieku. W przeciwieństwie do poprzednich modeli, które zawierały liczne mechaniczne zabezpieczenia, Therac‑25 opierał się niemal wyłącznie na oprogramowaniu. Błędy w kodzie oraz brak odpowiednich procedur testowania doprowadziły do serii poważnych wypadków. W wyniku tzw. wyścigów warunków (race conditions) urządzenie w niektórych sytuacjach dostarczało pacjentom wielokrotnie wyższe dawki promieniowania niż zaplanowano – bez żadnego ostrzeżenia.

W latach 1985–1987 odnotowano co najmniej sześć przypadków ciężkich obrażeń i kilka zgonów spowodowanych błędnym działaniem systemu. Alarmujące sygnały od operatorów były przez producenta ignorowane, a zgłoszenia problemów uznawano za niemożliwe. Dopiero kolejne tragiczne incydenty doprowadziły do wstrzymania produkcji urządzenia i gruntownej rewizji procedur dopuszczania sprzętu medycznego do użytku.

Historia Therac‑25 przypomina, że bezpieczeństwo pacjenta musi zawsze stać ponad efektywnością czy nowoczesnością rozwiązania. Nawet najbardziej zaawansowana technologia, jeśli nie jest odpowiednio zaprojektowana, testowana i kontrolowana, może stać się źródłem ogromnego zagrożenia.

Jak ChatGPT i Claude wspierają osoby z rzadkimi chorobami

W ostatnich latach ChatGPT, Claude i inne LLM stały się ważnym wsparciem dla pacjentów z rzadkimi, trudnymi do zdiagnozowania schorzeniami:

- Wsparcie w samodiagnozie i edukacji:

Użytkownicy zapisują w serwisach jak Reddit swoją historię objawów. ChatGPT pomaga im zrozumieć możliwe przyczyny, zasugerować zakres testów, tłumaczyć wyniki badań – oczywiście zgodnie z disclaimem „nie zastępuję lekarza”.

- Pomoc w dostępie do specjalistów i badań klinicznych:

Modele LLM mogą sugerować dedykowane ośrodki, zapisy do studiów klinicznych (np. w Stanfordzie, NIH), wskazując procedury i wymagane kryteria.

- Wsparcie psychiczne:

Edukacja na temat choroby, mechanizmów leczenia i praktycznych rad – często na poziomie, którego nie zapewniają czaty pacjentom odciążone placówki.

- Społeczność i współpraca:

Modele pomagają pacjentom odnaleźć odpowiednie grupy wsparcia (Facebook, PatientsLikeMe, r/…), sugerować literaturę czy forum.

Opisane przykłady nie są jeszcze „zatwierdzonymi systemami medycznymi” ani nie zastępują opieki medycznej, ale pokazują, że dostępność wiedzy i wsparcia zwiększa komfort, pewność pacjentów oraz ich zdolność do szukania pomocy – co buduje zaufanie do cyfrowych narzędzi.

Podsumowanie

Budowanie zaufania do medycznej AI wymaga przesunięcia uwagi z samej doskonałości technicznej modeli na ich praktyczne osadzenie w realiach klinicznych. Skuteczność algorytmu to za mało — równie istotne są jego przejrzystość, użyteczność i zdolność do wspierania decyzji w sposób zrozumiały i bezpieczny dla użytkownika. Kluczowe jest tu podejście oparte na współpracy: tylko poprzez aktywne włączenie personelu medycznego, pacjentów oraz twórców technologii w proces projektowania i oceny, możliwe jest stworzenie systemów, które będą nie tylko innowacyjne, ale również godne zaufania, etyczne i szeroko akceptowane w praktyce klinicznej.

Bibliografia

[1] Sagona, M., Dai, T., Macis, M., & Darden, M. (2025). Trust in AI-assisted health systems and AI’s trust in humans. npj Health Systems, 2(1), 10. https://doi.org/10.1038/s44401-025-00016-5

[2] Zuchowski, L. C., Zuchowski, M. L., & Nagel, E. (2024). A trust based framework for the envelopment of medical AI. npj Digital Medicine, 7(1), 230. https://doi.org/10.1038/s41746-024-01224-3

[3] Wysocki, O., Davies, J. K., Vigo, M., Armstrong, A. C., Landers, D., Lee, R., & Freitas, A. (2023). Assessing the communication gap between AI models and healthcare professionals: Explainability, utility and trust in AI-driven clinical decision-making. Artificial Intelligence, 316, 103839. https://doi.org/10.1016/j.artint.2022.103839

[4] Chanda, T., Hauser, K., Hobelsberger, S., Bucher, T.-C., Garcia, C. N., Wies, C., … Reader Study Consortium. (2024). Dermatologist-like explainable AI enhances trust and confidence in diagnosing melanoma. Nature Communications, 15(1), 524. https://doi.org/10.1038/s41467-023-43095-4

[5] Abulibdeh, R., Celi, L. A., & Sejdić, E. (2025). The illusion of safety: A report to the FDA on AI healthcare product approvals. PLOS Digital Health, 4(6), e0000866. https://doi.org/10.1371/journal.pdig.0000866

[6] Reuter, E., & Ye Ha, J. (2024, October 9). The number of AI medical devices has spiked in the past decade. Deep Dive. https://www.medtechdive.com/news/fda-ai-medical-devices-growth/

[7] Tapper, J. (2024, July 21). GPs use AI to boost cancer detection rates in England by 8%. The Guardian. https://www.theguardian.com/society/article/2024/jul/21/gps-use-ai-to-boost-cancer-detection-rates-in-england-by-8

[8] D’Adderio, L., & Bates, D. W. (2025). Transforming diagnosis through artificial intelligence. npj Digital Medicine, 8(1), 54. https://doi.org/10.1038/s41746-025-01460-1

[9] Tu, T., Schaekermann, M., Palepu, A., Saab, K., Freyberg, J., Tanno, R., Wang, A., Li, B., Amin, M., Cheng, Y., Vedadi, E., Tomasev, N., Azizi, S., Singhal, K., Hou, L., Webson, A., Kulkarni, K., Mahdavi, S. S., Semturs, C., Gottweis, J., … Karthikesalingam, A., & Natarajan, V. (2025). Towards conversational diagnostic artificial intelligence. Nature, 642(8067), 442–450. https://doi.org/10.1038/s41586-025-08866-7

[…] poprzednim artykule skupiliśmy się na seks robotach w ogólności, a także na najpopularniejszej formie tego […]