W dobie big data i sztucznej inteligencji media społecznościowe stały się narzędziem biopolityki – władzy nad społeczeństwem poprzez dane. Nasze polubienia, udostępnienia i komentarze służą do śledzenia trendów społecznych, a algorytmy na ich podstawie podsuwają treści, które wpływają na nasze poglądy polityczne. Wpis ten analizuje, gdzie leżą granice etyczne takiego zarządzania społeczeństwem za pomocą technologii: czy analiza danych obywateli dla celów politycznych to jeszcze wsparcie demokracji, czy już strategia manipulacji?

Biopolityka w erze danych i algorytmów

Pojęcie biopolityki wprowadził Michel Foucault dla opisania sposobów, w jakie władza nowoczesnego państwa zarządza życiem populacji – od zdrowia publicznego po kontrolę zachowań społecznych. Zgodnie z tą koncepcją władza przeszła od prostego prawa życia i śmierci do subtelniejszych form nadzoru i regulacji życia zbiorowego. Współcześnie biopolityka przybiera cyfrową formę: dane gromadzone o użytkownikach internetu i mediów społecznościowych pozwalają instytucjom oraz korporacjom monitorować i wpływać na zachowania społeczne na niespotykaną dotąd skalę. Jak ujęła to Shoshana Zuboff, korporacje technologiczne wykorzystują naszą osobistą aktywność w sieci, aby przewidywać i kształtować nasze zachowania, co nazwała kapitalizmem inwigilacji. Ta nowa logika ekonomiczno-polityczna opiera się na masowym gromadzeniu „nadmiarowych” danych o ludziach (naszych kliknięć, lokalizacji, relacji), by następnie przekształcać je w prognozy dotyczące naszych preferencji i działań – również politycznych – a nawet subtelnie kierować naszym wyborem informacji.

Władza dysponująca takimi danymi zyskuje narzędzie „miękkiej” kontroli społecznej. Media społecznościowe stały się współczesnym panoptikonem – miejscem dobrowolnej obserwacji, gdzie ludzie sami dostarczają informacji o swoich upodobaniach, lękach i przekonaniach. Władze państwowe i firmy mogą wykorzystywać te dane do zarządzania populacją: od kampanii informacyjnych (np. promowanie postaw prozdrowotnych) po profilowanie polityczne. Biopolityka cyfrowa rodzi jednak pytania: czy korzystanie z tak zebranych danych do sterowania opinią publiczną nie narusza fundamentów autonomii jednostki i demokracji? Gdzie przebiega granica między legalnym badaniem nastrojów społecznych a ich inżynierią?

Analiza trendów społeczno-politycznych w mediach społecznościowych

Interakcje użytkowników – polubienia, udostępnienia, komentarze, wyszukiwania – stały się surowcem dla analityków danych, pozwalającym na mapowanie trendów społecznych i politycznych w czasie rzeczywistym. Zaawansowane techniki analizy danych (data analytics) i uczenia maszynowego przeszukują olbrzymie zbiory takich informacji, by wychwycić wzorce: rosnącą popularność ruchu społecznego, zmianę sentymentu wobec partii politycznej czy nagłe ogniska dezinformacji. Przykładowo, już w 2013 roku badacze pokazali, że z tak banalnych danych jak polubione strony na Facebooku można trafnie przewidzieć szereg wrażliwych cech danej osoby – włączając w to jej orientację polityczną i poglądy światopoglądowe. Innymi słowy, nasze „lajki” zdradzają nas: algorytmy potrafią przeanalizować historię aktywności użytkownika i na tej podstawie ocenić, czy np. jest on konserwatystą czy liberałem, często lepiej niż bliscy znajomi.

Rysunek 1. Media społecznościowe tworzą złożone sieci powiązań między ludźmi – na podstawie tych połączeń i aktywności można analizować rozprzestrzenianie się idei i trendów politycznych. (źródło: cyberdefence24)

Takie analizy trendów wykorzystywane są zarówno w biznesie, jak i przez sztaby polityczne czy instytucje państwowe. Platformy społecznościowe same monitorują najpopularniejsze tematy i nastroje – np. trendy na Twitterze czy najczęściej udostępniane posty na Facebooku – by zrozumieć czym żyje społeczeństwo. Dane te są cenne dla marketerów politycznych planujących kampanie wyborcze: pozwalają im identyfikować gorące tematy oraz segmentować elektorat według zainteresowań i poglądów. Co istotne, dzięki mediom społecznościowym informacja zwrotna jest niemal natychmiastowa – reakcje użytkowników (np. fala pozytywnych lub negatywnych komentarzy) mogą sygnalizować politykom, jak odebrano daną wypowiedź czy posunięcie rządu.

Jednak granica między obserwacją trendów a ich kształtowaniem bywa płynna. Gdy dane wykorzystywane są nie tylko do biernej obserwacji, ale do aktywnych działań wpływających na odbiorców, wchodzimy na pole manipulacji. Głośnym przykładem było Cambridge Analytica – firma, która bezprawnie pozyskała dane dziesiątek milionów użytkowników Facebooka, by stworzyć ich szczegółowe psychologiczne profile i dopasować pod nie przekazy polityczne. W 2016 roku te techniki wykorzystano w kampanii prezydenckiej w USA i być może wpłynęły one na preferencje wyborców poprzez wyświetlanie im precyzyjnie skrojonych reklam bazujących na ich lękach i pragnieniach. Analiza danych pozwoliła wytypować niezdecydowanych odbiorców i zasypać ich przekazami, na które byli najbardziej podatni – np. akcentując kwestie imigracji tym, którzy wyrażali obawy o bezpieczeństwo, albo ekonomiczne korzyści deregulacji tym, którzy cenili przedsiębiorczość.

Algorytmy kształtujące poglądy: echo chambers i polityka emocji

Większość z nas doświadcza dziś świata informacji przefiltrowanego przez algorytmy personalizujące treści. Portale społecznościowe starają się utrzymać naszą uwagę jak najdłużej, serwując nam treści dopasowane do naszych zainteresowań i zachowań. Ta personalizacja ma jednak efekt uboczny: tworzy bańki informacyjne (tzw. filter bubbles), w których widzimy głównie to, co zgadza się z naszymi dotychczasowymi poglądami. Algorytm Facebooka czy Twittera wybiera spośród tysięcy postów te, które uzna za najbardziej angażujące dla nas – często będą to materiały zgodne z naszym światopoglądem lub budzące silne emocje. W rezultacie użytkownik o określonych sympatiach politycznych dostaje potwierdzenie swoich przekonań zamiast wyzwań intelektualnych. Sprzyja to polaryzacji: lewica i prawica „okopują się” w osobnych przestrzeniach informacyjnych, nie mając wspólnej płaszczyzny faktów do dyskusji.

Rysunek 2. Grafika ilustrująca zjawisko baniek informacyjnych (grafika wygenerowana z wykorzystaniem Canva AI Image Generator)

Badania pokazują, że algorytmy mediów społecznościowych wzmacniają określone typy treści. Szczególnie chętnie promowane są treści wywołujące silne reakcje emocjonalne i moralne, gdyż to one najskuteczniej przykuwają uwagę użytkowników. Jak zauważają naukowcy, powstało pewne „niedopasowanie funkcjonalne” – mechanizmy ewolucyjne sprawiają, że uczymy się od innych zwracając uwagę na kwestie prestiżu, norm moralnych czy silnych emocji, a algorytmy dokładnie te bodźce nam dostarczają w nadmiarze, ponieważ gwarantują one zaangażowanie. W efekcie nasze kanały informacyjne nasycone są treściami skrajnymi lub kontrowersyjnymi, a użytkownik, który nie ma kontaktu z odmiennymi opiniami, może nabrać fałszywego wrażenia, że „wszyscy myślą tak jak ja” lub przeciwnie – że przeciwnicy są niemal odczłowieczeni. Powstaje zjawisko echo chamber, czyli echa własnych poglądów odbijającego się w algorytmicznej komorze.

„Codzienne interakcje ludzi z algorytmami online wpływają na to, jak uczą się oni od innych, przynosząc negatywne skutki, takie jak błędne postrzeganie społeczne, konflikty i rozprzestrzenianie dezinformacji.” (Brady, 2023, Scientific American)

Co znamienne, media społecznościowe stały się dla wielu głównym źródłem informacji o świecie. Według badań Reuters Institute aż 46% ludzi na świecie czerpie newsy przede wszystkim z social mediów, a w USA odsetek ten wynosi ponad 50%. Oznacza to, że dla ponad połowy Amerykanów algorytm Facebooka czy YouTube’a pełni rolę redaktora decydującego, jakie wiadomości trafią do ich świadomości. To ogromna władza nad opinią publiczną w rękach prywatnych firm technologicznych. Jednocześnie, badania Pew Research Center wykazały, że ekspozycja na różne treści w social media potrafi realnie zmieniać poglądy części odbiorców – 14% dorosłych Amerykanów przyznało w 2018 roku, że w ciągu ostatniego roku zmieniło zdanie w jakiejś kwestii społecznej lub politycznej właśnie pod wpływem tego, co zobaczyli w mediach społecznościowych. Dwa lata później odsetek ten wzrósł już do 23% użytkowników, co sugeruje nasilający się wpływ mediów społecznościowych na kształtowanie opinii. Oczywiście większość ludzi twierdzi, że ich poglądy pozostają stabilne, ale prawie co czwarty użytkownik doświadczył na własnej skórze zmiany stanowiska po zetknięciu się z nowymi argumentami czy informacjami w sieci. Może to być efekt pozytywny – np. ktoś zrewidował zdanie w obliczu nowych faktów – ale bywa też wynikiem ulegania jednostronnej propagandzie.

Rysunek 3. Grafika przedstawiająca napis „fake news” (źródło: Canva)

Niebezpiecznym składnikiem tej mieszanki są zjawiska takie jak fake news i dezinformacja. Algorytmy nie zawsze odróżniają prawdę od kłamstwa – kierują się głównie atrakcyjnością treści. W głośnej analizie naukowej stwierdzono, że fałszywe wiadomości na Twitterze rozprzestrzeniają się znacznie szybciej i szerzej niż wiadomości prawdziwe, głównie dlatego, że są bardziej sensacyjne i emocjonalne. Innymi słowy, system zaprojektowany do maksymalizacji zaangażowania może mimowolnie faworyzować treści wprowadzające w błąd, jeśli tylko przyciągną one uwagę odbiorców. To z kolei ma realny wpływ polityczny: wystarczy przypomnieć falę teorii spiskowych i plotek zalewających Facebook podczas wyborów czy pandemii. W ten sposób infrastruktura informacji publicznej została sprywatyzowana i podporządkowana komercyjnym algorytmom, które nie dbają o prawdę, a o klikalność – co stanowi poważne wyzwanie dla społeczeństwa obywatelskiego.

Strategie manipulacji w mediach społecznościowych

Skoro wiemy, że dzięki danym z mediów społecznościowych można zrozumieć odbiorców i wpływać na ich wybory, nic dziwnego, że rozwinął się cały arsenał strategii manipulacji wykorzystujących te platformy. Wśród najważniejszych technik są:

- Microtargeting polityczny – kierowanie sprofilowanych przekazów do wąskich grup lub wręcz pojedynczych osób na podstawie ich cech i zachowań. Kampanie polityczne, dysponując danymi (zakupionymi lub pozyskanymi z social mediów), tworzą dziesiątki wersji reklam politycznych i testują, która wersja najlepiej zadziała na daną podgrupę wyborców. Na przykład, jedna osoba zobaczy w swoim feedzie reklamę skupiającą się na obniżce podatków, a inna – spot wzbudzający lęk przed imigrantami, w zależności od tego, jakie treści wcześniej lajkowała lub udostępniała. Wszystko dzieje się poza jawnym dyskursem publicznym – tzw. „ciemne reklamy” (dark posts) są widoczne tylko dla wybranych, co utrudnia społeczną kontrolę nad przekazem politycznym. Dodatkowo, wykorzystując fałszywe konta, można toczyć wiarygodne rozmowy, udając autentyczne profile, a nawet generować deepfake’i (fałszywe obrazy lub filmy) prezentujące nieprawdziwe wydarzenia lub wypowiedzi polityków.

- Boty i sztuczni „influencerzy” – armie automatycznych kont (botów) na Twitterze, Facebooku czy Instagramie potrafią generować i rozprowadzać przekazy na masową skalę, sprawiając wrażenie, że jakaś opinia cieszy się szerokim poparciem. Trolle internetowe i boty były aktywnie wykorzystywane m.in. przez zagraniczne podmioty próbujące wpłynąć na wybory w innych krajach (np. rosyjska Internet Research Agency podczas wyborów w USA 2016). Poprzez tworzenie pozorów oddolnego ruchu poparcia bądź oburzenia (astroturfing), manipulują one postrzeganiem co jest popularne i akceptowalne społecznie. Dziś, z rozwojem AI, boty stają się coraz trudniejsze do odróżnienia od prawdziwych użytkowników – potrafią toczyć wiarygodne rozmowy, udając autentyczne profile, a nawet generować deepfake’i (fałszywe obrazy lub filmy) prezentujące nieprawdziwe wydarzenia lub wypowiedzi polityków.

Rysunek 4. Zdjęcie influencerki (źródło: Canva)

- Amplifikacja selektywna i cenzura – właściciele platform mogą świadomie lub nieświadomie wpływać na dyskurs poprzez zmiany algorytmów. Wystarczy drobna modyfikacja, by określony typ treści zyskał zasięg (np. posty znajomych kosztem postów stron informacyjnych, co Facebook zrobił w 2018 roku), albo by uciszyć pewne przekazy (np. oznaczanie postów jako dezinformacja, co ogranicza ich widoczność). Choć moderacja treści bywa konieczna (np. usuwanie mowy nienawiści), w rękach autorytarnych rządów bywa wykorzystywana jako narzędzie politycznej cenzury – w Chinach czy Rosji social media są ściśle kontrolowane, a niepożądane informacje znikają z platform. Nawet w demokracjach pojawiają się pytania, czy firmy Big Tech nie nadużywają swojej pozycji jako strażnicy dostępu do informacji.

Rysunek 5. Grafika ilustrująca zjawisko cenzury

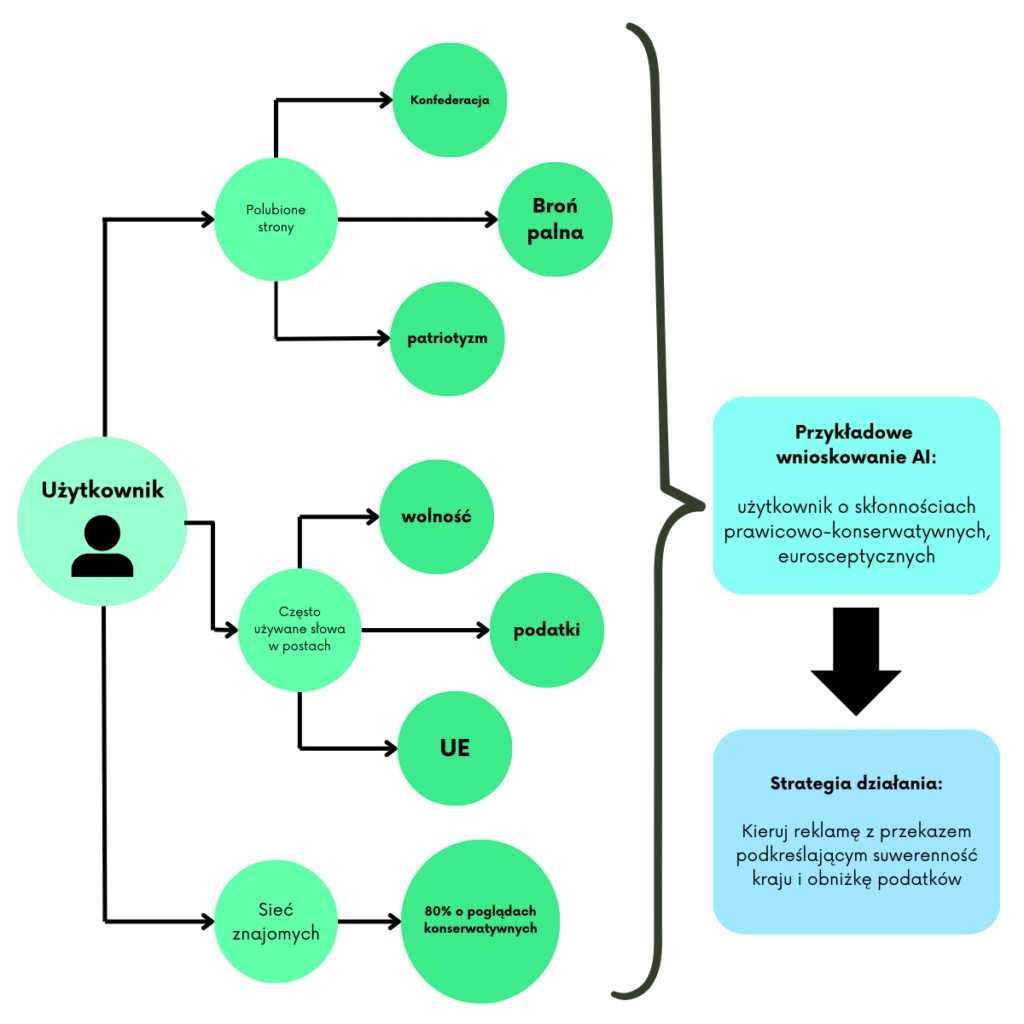

Jak te techniki przekładają się na doświadczenie pojedynczego użytkownika? Oto hipotetyczny przykład profilowania i manipulacji przekazem (rysunek 6):

Rysunek 6. Infografika przedstawiająca przykładową analizę profilu użytkownika przez sztuczną inteligencję

W powyższym scenariuszu na podstawie aktywności algorytm wnioskował preferencje polityczne użytkownika i dobrał dla niego przekaz, który najskuteczniej wywoła pożądany odzew (np. poprze daną partię lub ideę). Takie spersonalizowane komunikaty są niesłychanie skuteczne, bo odwołują się do tego, co dla odbiorcy najbardziej emocjonalnie przekonujące. Jednocześnie jednak budzą poważne kontrowersje etyczne – wyborca staje się celem niewidocznych dla niego działań perswazyjnych, które mogą ograniczać jego zdolność do samodzielnego wyciągania wniosków z pluralistycznego przekazu.

Etyczne granice i obrona przed biopolityką cyfrową

Nasilające się wykorzystanie mediów społecznościowych do kształtowania poglądów publicznych rodzi pytanie: gdzie leżą granice etyczne takich praktyk? W tradycyjnej polityce wpływanie na opinię publiczną odbywało się poprzez otwartą debatę, kampanie w mediach masowych czy programy edukacyjne. Teraz mamy do czynienia z bardziej podstępnymi metodami, operującymi na poziomie jednostkowych psychologii i podprogowych oddziaływań. Kilka kluczowych wyzwań to:

- Prywatność i zgoda – użytkownicy często nie są świadomi skali monitoringu ich działań online ani tego, do czego posłużą zebrane o nich dane. Aprobując regulaminy platform, w praktyce oddajemy ogrom informacji o sobie. Czy obywatel może świadomie wyrazić zgodę na bycie przedmiotem takiej analizy i mikro-targetowania? W odpowiedzi na skandal Cambridge Analytica politycy zaczęli domagać się większej ochrony danych osobowych – w UE przyjęto RODO (GDPR), które wymaga m.in. informowania użytkowników o wykorzystaniu ich danych. Jednak sama zgoda to za mało, bo użytkownicy często klikają „akceptuj” bez zrozumienia konsekwencji. Granicą biopolityki powinna być poszanowanie prywatności jednostki – dane wrażliwe (dotyczące np. poglądów politycznych, zdrowia) nie powinny być wykorzystywane bez wyraźnej i świadomej zgody w celach innych niż te, dla których zostały zebrane.

Rysunek 7. Grafika przedstawiająca kwadrat na kartce, wyrażający zgodę pod dokumentem (źródło: Canva)

- Autonomia i wolność wyboru – demokracja zakłada zdolność obywateli do samodzielnego formowania opinii na podstawie rzetelnych informacji. Gdy jednak informacyjny ekosystem jest manipulowany, autonomia ta staje pod znakiem zapytania. Jeśli algorytm decyduje, co zobaczymy, a czego nie, to w pewnym sensie sprawuje władzę nad naszym postrzeganiem świata. Etyczna granica zostaje przekroczona, gdy celowo zataja się przed użytkownikiem źródło i intencję przekazu (np. gdy propaganda polityczna podszywa się pod spontaniczny post zwykłego użytkownika). Obywatel ma prawo wiedzieć, kiedy jest celem komunikatu perswazyjnego. Dlatego pojawiają się inicjatywy wprowadzające transparentność reklamy politycznej w internecie – np. oznaczanie i publiczne archiwizowanie wszystkich reklam politycznych na Facebooku wraz z informacją, kto za nie zapłacił. To zwiększa kontrolę społeczną i utrudnia potajemne wpływanie na niszowe grupy przekazem sprzecznym z oficjalnym programem.

- Odpowiedzialność platform i regulatorów – powstaje konsensus, że wielkie platformy muszą wziąć na siebie większą odpowiedzialność za skutki społeczne działania ich algorytmów. Skoro Facebook czy YouTube pełnią funkcję infrastruktury informacyjnej niczym dawniej prasa czy telewizja, powinny podlegać pewnym regulacjom zapewniającym, że nie szkodzą demokracji. Możliwe kierunki to audyt algorytmiczny (niezależne sprawdzanie, czy algorytmy nie promują systematycznie szkodliwych treści), wymaganie od platform opcji wyłączenia algorytmicznej personalizacji (aby użytkownik mógł zobaczyć chronologiczny, niefiltrowany strumień treści), czy też ograniczenia mikro-targetowania (np. zakaz kierowania reklamy politycznej po bardzo szczegółowych kryteriach demograficznych/behawioralnych). Takie środki są dyskutowane m.in. w Unii Europejskiej w ramach Aktu o Usługach Cyfrowych (DSA) i regulacji dotyczących kampanii politycznych online.

- Świadomość i kompetencje użytkowników – wreszcie, granicą wpływu jest świadomość obywateli. Im bardziej społeczeństwo zdaje sobie sprawę z istnienia mechanizmów manipulacji w sieci, tym trudniej je bezrefleksyjnie ulegać. Edukacja medialna i cyfrowa stała się niezbędna: każdy internauta powinien znać pojęcia takie jak bańka informacyjna, algorytm rekomendacyjny, dezinformacja czy profilowanie. Uzbrojony w tę wiedzę użytkownik może bardziej krytycznie podchodzić do treści w swoim feedzie – np. celowo szukać alternatywnych źródeł informacji, demaskować fałszywe newsy, instalować wtyczki ograniczające śledzenie reklamowe itp. Odpowiedzialność za obronę przed negatywną biopolityką spoczywa więc także na nas jako użytkownikach, byśmy nie stali się bezwolnym obiektem inżynierii społecznej. Inicjatywy fact-checkerskie, kampanie uświadamiające o metodach manipulacji (np. o tym jak rozpoznawać boty czy deepfake) oraz promocja pluralizmu informacyjnego w sieci są kluczowe dla utrzymania zdrowej debaty publicznej.

Zakończenie

Śledzenie i analiza zachowań użytkowników w mediach społecznościowych otworzyły zupełnie nowe możliwości badania i kształtowania trendów społeczno-politycznych. Z jednej strony daje to szansę lepszego zrozumienia społeczeństwa – politycy i instytucje mogą szybciej reagować na nastroje społeczne, obywatele mogą być lepiej informowani o sprawach, które ich interesują. Z drugiej strony ta sama technologia stwarza pokusę nadużycia: wykorzystania wiedzy o obywatelach do manipulowania nimi, do przekraczania granic prywatności i autonomii jednostki. W ten sposób biopolityka wkracza w wymiar cyfrowy, w którym człowiek staje się zbiorem danych do zarządzania.

Gdzie leżą granice biopolityki? Powinny one być wytyczone przez wartości demokratyczne i prawa człowieka. Technologia nie jest z natury zła – może służyć społeczeństwu, jeśli będzie używana etycznie, transparentnie i z poszanowaniem podmiotowości obywateli. Kluczowe jest, by społeczeństwo obywatelskie, prawodawcy i sami użytkownicy współdziałali w wypracowaniu norm i regulacji zapobiegających najgorszym nadużyciom. Bez tego grozi nam rzeczywistość, w której poglądy polityczne mas kształtują nie otwarta debata i racjonalne argumenty, ale sprytne algorytmy i marketingowy targeting – co byłoby zaprzeczeniem ideałów demokratycznych. Granice biopolityki muszą zatem być aktywnie bronione, aby technologia wspierała, a nie podkopywała świadome społeczeństwo.

Więcej informacji na temat aktualnych problemów biopolityki można znaleźć w wykładzie z 2012 roku.

Literatura

- Bialik, K. (2018, 15 sierpnia). 14% of Americans have changed their mind about an issue because of something they saw on social media. Pew Research Center.

- Brady, W. J. (2023, 25 sierpnia). Social media algorithms warp how people learn from each other. Scientific American. (oprac. The Conversation).

- Cadwalladr, C., & Graham-Harrison, E. (2018, 17 marca). Revealed: 50 million Facebook profiles harvested for Cambridge Analytica in major data breach. The Guardian.

- Foucault, M. (1978). The History of Sexuality, Vol. 1: An Introduction. Nowy Jork: Pantheon Books.

Kosinski, M., Stillwell, D., & Graepel, T. (2013). Private traits and attributes are predictable from digital records of human behavior. Proceedings of the National Academy of Sciences, 110(15), 5802–5805. https://doi.org/10.1073/pnas.1218772110 - Olechowski, K. (2023, 21 listopada). Wpływ mediów społecznościowych na kształtowanie opinii publicznej. Exacto.pl.

- Perrin, A. (2020, 15 października). 23% of users in U.S. say social media led them to change views on an issue; some cite Black Lives Matter. Pew Research Center.

- Vosoughi, S., Roy, D., & Aral, S. (2018). The spread of true and false news online. Science, 359(6380), 1146–1151. https://doi.org/10.1126/science.aap9559

- Zuboff, S. (2019). The Age of Surveillance Capitalism: The Fight for a Human Future at the New Frontier of Power. Nowy Jork: PublicAffairs.

- Laidler, J. (2019, 4 marca). Harvard professor says surveillance capitalism is undermining democracy. Harvard Gazette.

- Stein, M. (2018). Michel Foucault, Panopticism, and Social Media. ResearchGate.

- Kulke, S. (2023, 3 sierpnia). Social media algorithms exploit how humans learn from their peers. Northwestern Now.

[…] poprzednim artykule skupiliśmy się na seks robotach w ogólności, a także na najpopularniejszej formie tego […]