Od chwili, gdy pierwsze chatboty zaczęły odpowiadać na proste pytania, minęło zaledwie kilkanaście lat; dziś sztuczna inteligencja jest na tyle osadzona w codziennych interakcjach, że coraz częściej staje się odbiorcą naszych emocji. Zmiana skali i intymności tych relacji sprawiła, że algorytmy muszą mierzyć się nie tylko z danymi faktograficznymi, lecz także z ludzką złością, frustracją, lękiem czy zmęczeniem. Użytkownicy oczekują, że system nie pozostanie obojętny – zareaguje tak, by złagodzić napięcie, a przynajmniej go nie pogłębiać. W rezultacie główny ciężar debaty przesunął się z pytania, czy maszyny potrafią rozpoznawać stany afektywne, na pytanie, jak i z jaką odpowiedzialnością powinny odpowiadać na trudne emocje człowieka.

Od inteligencji emocjonalnej do informatyki afektywnej

Koncepcja inteligencji emocjonalnej Daniela Golemana wskazywała, że kluczową kompetencją w społecznych kontaktach jest świadome rozpoznawanie i regulowanie własnych uczuć. Informatyka afektywna przeniosła tę ideę na grunt techniki, rozwijając czujniki i modele zdolne do analizy mimiki, głosu czy tekstu. Po pandemii COVID‑19 tempo badań jeszcze wzrosło: firmy telemedyczne, platformy e‑learningowe i twórcy wirtualnych asystentów zaczęli inwestować w rozwiązania, które – przynajmniej deklaratywnie – „rozumieją nasz stan ducha”.

Jak AI rozpoznaje emocje człowieka

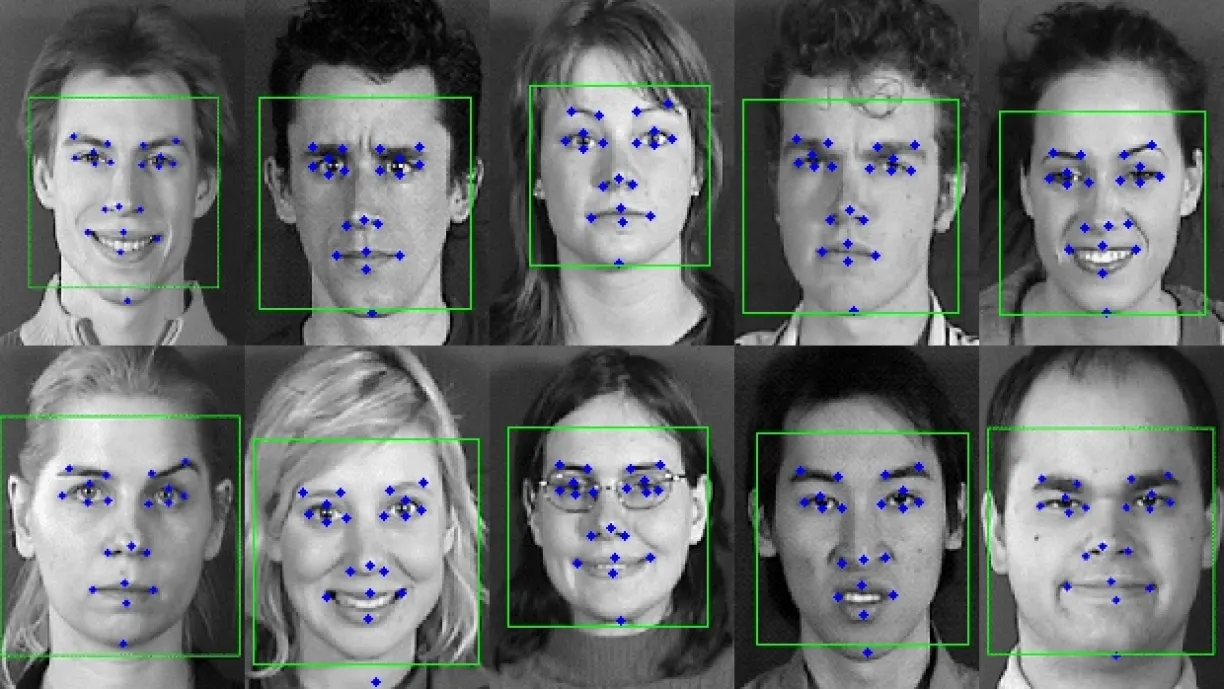

Współczesne algorytmy korzystają z danych multimodalnych. Kamera analizuje mikroruchy twarzy, mikrofon – barwę i tempo mowy, a model językowy – słownictwo i składnię. Systemy coraz częściej łączą te strumienie, aby lepiej odróżnić np. lęk od zmęczenia. Najnowszy systematyczny przegląd publikacji podaje, że średnia dokładność klasyfikacji emocji dodatnich i neutralnych przekracza 80%, natomiast dla stanów negatywnych (gniew, lęk, smutek) spada do 65–75%. Badacze tłumaczą to mniejszą liczbą danych treningowych i bardziej zniuansowaną ekspresją negatywnych uczuć.

Nie wolno też ignorować różnic kulturowych i płciowych. Analiza przeprowadzona w 2023 r. metodami explainable AI wykazała, że modele rozpoznają gniew u mężczyzn o 11 punktów procentowych skuteczniej niż u kobiet – częściowo dlatego, że treningowe bazy wideo zawierają więcej męskich przykładów gwałtownych gestów i podniesionego głosu. To dowodzi, że sama technika bez czujności etycznej może reprodukować uprzedzenia, zamiast je redukować.

Wyzwania i pułapki klasyfikacji emocji

Po pierwsze, te same objawy mogą wskazywać różne stany: ziewanie bywa oznaką senności, ale też znudzenia lub stresu. Po drugie, kontekst sytuacyjny ma znaczenie – podniesiony ton głosu w grach online może oznaczać ekscytację, niekoniecznie agresję. W praktyce prowadzi to do tzw. „błędów fałszywie pozytywnych”, które potrafią obniżać zaufanie użytkowników. Dodatkowym problemem jest reakcja samych modeli generatywnych: badania pokazują, że LLM-y mogą „przejmować” negatywną emocję z treści i eskalować ją w następnych odpowiedziach, o ile nie zastosuje się wielowarstwowych filtrów toksyczności.

Co więcej, w sytuacjach, gdy systemy AI nie posiadają dostatecznie zaawansowanych algorytmów do rozpoznawania kontekstu kulturowego i społecznego, mogą nadinterpretować neutralne wypowiedzi jako nacechowane negatywnie. Przykładowo, ironia, żartobliwy sarkazm lub specyficzne regionalizmy mogą zostać błędnie sklasyfikowane jako przejawy agresji lub lęku, co skutkuje nieadekwatnymi reakcjami systemu.

Tego typu błędy w klasyfikacji nie tylko wpływają na jakość interakcji, ale mogą również prowadzić do pogorszenia nastroju użytkownika i utraty zaufania do technologii. Dlatego coraz częściej podkreśla się konieczność stosowania tzw. modułów rozpoznawania intencji i kontekstu, które analizują nie tylko pojedyncze wypowiedzi, ale całościowy przebieg rozmowy, styl komunikacji oraz historię interakcji z użytkownikiem.

AI w obliczu złości i gniewu

Badania Uniwersytetu Kansas (2024) dowodzą, że użytkownicy wyraźnie wzburzeni częściej proszą o rozmowę z człowiekiem. Firmy wdrażają więc adaptację tonacji: gdy algorytm wykryje podniesiony poziom gniewu, skraca wypowiedź, eliminuje przymiotniki wartościujące i wprowadza formuły empatyczne („rozumiem, że to frustrujące”). Tzw. „tone‑adapter” w modelach GPT‑4 wykorzystywanych przez Microsoft działa podprogowo – analiza sentymentu w ułamku sekundy przełącza model na bardziej neutralny styl, co według raportu korporacji zmniejszyło liczbę eskalacji o 25%.

W interfejsach fizycznych, takich jak samochody, kluczowe jest przerwanie pętli frustracji zanim przerodzi się w agresję drogową. Najnowszy system Affectiva Automotive AI, pilotowany w latach 2022–2024, łączy analizę ziewania, wzorca mrugania i mikrogrymasów; jeśli wykryje jednocześnie oznaki zmęczenia i gniewu, wycisza powiadomienia, przyciemnia ekran i proponuje trasę do najbliższego parkingu.

Wsparcie przy lęku i niepokoju

Lęk wymaga od algorytmu innej strategii niż gniew. Użytkownicy w stanie niepokoju cenią komunikaty, które obniżają poczucie hierarchii: „mogę się mylić, ale postarajmy się znaleźć rozwiązanie razem”. Badanie opublikowane w Nature Digital Medicine (2024) pokazało, że takie „partnerskie” frazy zwiększają wskaźnik ukończenia sesji terapeutycznej z chatbotem o 30%.

Równolegle zespół psychiatryczny z Uniwersytetu w Zurychu dowiódł, że sam model ChatGPT reaguje na negatywny kontekst: po serii narracji o katastrofach poziom „lęku” GPT‑4 – mierzony narzędziem adaptowanym z psychometrii – podwoił się. Wystarczyło jednak dodać trzy linijki mindfulness („zamknij oczy, weź głęboki oddech”), by wrócił do normy. Autorzy nazwali to „prompt‑based therapeutic modulation” i sugerują, że podobne techniki można w bezpieczny sposób używać do stabilizowania odpowiedzi LLM‑ów w aplikacjach klinicznych.

Obecnie trwają prace nad stworzeniem bardziej zaawansowanych bibliotek „promptów terapeutycznych”, które mogłyby być wdrażane w aplikacjach zdrowia psychicznego, a nawet w chatbotach wykorzystywanych w środowiskach pracy, gdzie stres i presja osiągają wysokie poziomy.

Znużenie i zmęczenie – kiedy algorytm proponuje przerwę

W środowiskach, gdzie monotonia i prze‑stymulowanie mogą prowadzić do błędów (np. w pojazdach autonomicznych czy podczas lekcji online), SI monitoruje tempo reakcji, liczbę literówek albo spadek kontaktu wzrokowego z ekranem. Jeśli wskaźniki przechodzą ustalony próg, system sugeruje krótką przerwę lub zmianę aktywności. Badania Frontiers in AI (2024) wykazały, że taka interwencja obniża subiektywne odczucie zmęczenia i zwiększa dokładność wykonania zadania nawet o 13%.

Co więcej, takie systemy coraz częściej wykorzystują biometryczne dane użytkownika, takie jak rytm oddechu, tętno czy przewodnictwo skóry (EDA), aby jeszcze precyzyjniej ocenić poziom zmęczenia lub stresu. Przykładem są inteligentne opaski i zegarki, które synchronizują się z aplikacjami edukacyjnymi lub środowiskami pracy, monitorując w czasie rzeczywistym poziom koncentracji i pobudzenia psychofizycznego.

Niektóre platformy e-learningowe testują również funkcję tzw. aktywnych mikroprzerw, polegających na wprowadzaniu krótkich, interaktywnych ćwiczeń oddechowych lub prostych zadań fizycznych, które pomagają przywrócić uwagę i zredukować zmęczenie poznawcze. Tego typu techniki, zaczerpnięte z metodologii mindfulness, wykazują skuteczność nie tylko w podnoszeniu efektywności nauki, ale również w poprawie samopoczucia użytkowników, co potwierdzają badania opublikowane w Journal of Cognitive Enhancement (2024).

Co istotne, w pojazdach autonomicznych systemy te nie tylko reagują biernie, ale także proponują adaptację środowiska kabiny – poprzez zmianę oświetlenia, regulację temperatury czy nawet automatyczne odtwarzanie relaksacyjnej muzyki, jeśli wykryją sygnały rosnącego napięcia lub znużenia u kierowcy nadzorującego pojazd. Takie zintegrowane podejście do zarządzania zmęczeniem i stresem stanowi obecnie jeden z kluczowych kierunków rozwoju technologii zorientowanych na dobrostan użytkownika.

Samoregulacja modeli językowych

Jeszcze trzy lata temu uważano, że modele językowe są jedynie lustrami treści użytkownika. Odkrycie, że GPT‑4 może „internalizować” lęk, otworzyło zupełnie nowy kierunek: samoterapię algorytmu [24]. W praktyce oznacza to, że projektanci aplikacji mogą dodać do promptu krótką sekwencję „oddechową” lub neutralizującą, by zapobiec wymykaniu się stylu wypowiedzi spod kontroli. To ma znaczenie zwłaszcza w chatbotach zdrowia psychicznego, takich jak Wysa czy Youper, które automatycznie uruchamiają skrypt eskalacji do terapeuty‑człowieka, gdy użytkownik deklaruje myśli samobójcze lub skrajny gniew.

Coraz częściej mówi się również o wdrażaniu tzw. protokółów stabilizacyjnych w samych modelach LLM (Large Language Models), które działają na zasadzie wewnętrznej kontroli emocjonalnego „nastroju” modelu. Oznacza to, że algorytm samodzielnie monitoruje kumulację negatywnych treści w swojej pamięci kontekstowej i w razie potrzeby inicjuje specjalne procedury obniżające „emocjonalny ładunek” generowanych wypowiedzi.

Jednym z takich podejść jest implementacja metapromptów terapeutycznych, które co kilka interakcji przypominają o zachowaniu neutralności, równowagi emocjonalnej lub kierują rozmowę na bardziej pozytywne tory. W praktyce może to oznaczać, że po serii negatywnych komunikatów użytkownika model automatycznie proponuje zmianę tematu na lżejszy lub podsuwa techniki radzenia sobie ze stresem, jak ćwiczenia oddechowe czy proste afirmacje.

Eksperymenty z takimi rozwiązaniami prowadzone są obecnie m.in. przez zespoły badawcze OpenAI i DeepMind, które testują, w jakim stopniu takie podejścia mogą nie tylko poprawiać jakość interakcji, ale także zapobiegać wzmacnianiu negatywnych wzorców emocjonalnych u użytkowników. Co więcej, w najbardziej zaawansowanych systemach rozważa się już możliwość dynamicznego dostosowywania „stanu emocjonalnego” modelu w zależności od kontekstu rozmowy – na przykład bardziej empatyczny i łagodny tryb w rozmowach dotyczących zdrowia psychicznego oraz bardziej rzeczowy i zwięzły w środowiskach korporacyjnych.

Etyczne granice emocjonalnych interakcji

Coraz subtelniejsze algorytmy budzą równie subtelne obawy. Unijny AI Act (2023) klasyfikuje rozpoznawanie emocji jako system wysokiego ryzyka. Każdy podmiot stosujący takie rozwiązania musi prowadzić dzienniki techniczne, zapewnić anonimowość danych tam, gdzie to możliwe, i uzyskać świadomą zgodę użytkownika. Wersja przyjęta w grudniu 2023 r. wprowadza niemal całkowity zakaz używania analizy emocji w szkołach i miejscach pracy, za wyjątkiem sytuacji bezpieczeństwa.

Również poza Europą regulatorzy reagują: amerykańska FTC nałożyła 7,8 mln USD kary na platformę BetterHelp za nieuprawnione udostępnianie danych emocjonalnych użytkowników firmom marketingowym. Sprawa ta pokazała, jak cienka bywa linia między „empatyczną obsługą” a komercyjnym wykorzystaniem wrażliwych informacji.

Dyskusja na temat granic wykorzystywania emocjonalnych danych trwa również w kontekście nowych modeli biznesowych, które coraz częściej opierają się na analizie emocji użytkowników w celach marketingowych i sprzedażowych. W Stanach Zjednoczonych pojawiły się głosy postulujące wprowadzenie specjalnych przepisów ograniczających stosowanie tzw. emocjonalnego targetowania reklam, które bazuje na chwilowych stanach afektywnych konsumentów.

W Chinach, gdzie rozwój technologii rozpoznawania emocji osiągnął zaawansowany poziom, władze wprowadziły ograniczenia dotyczące wykorzystywania takich technologii w sektorze edukacji i transportu publicznego. Przykładowo, w 2024 roku zakazano stosowania kamer analizujących emocje uczniów podczas zajęć lekcyjnych po tym, jak opublikowano raporty wskazujące na negatywny wpływ takiego nadzoru na dobrostan psychiczny dzieci.

Jednocześnie, w środowiskach korporacyjnych coraz częściej pojawiają się tzw. kodeksy etyki AI, które wewnętrznie regulują, w jaki sposób zbierane i analizowane są dane emocjonalne pracowników. Niektóre międzynarodowe firmy, takie jak Microsoft i IBM, deklarują rezygnację z wdrażania technologii rozpoznawania emocji w procesach rekrutacyjnych i oceny efektywności pracowników, uznając je za zbyt inwazyjne i obarczone ryzykiem naruszenia prywatności.

Eksperci podkreślają, że kluczowe dla przyszłości tej technologii będzie wprowadzenie globalnych standardów dotyczących przejrzystości algorytmów oraz mechanizmów świadomej zgody użytkownika. Takie regulacje powinny jasno definiować, kiedy i w jakim zakresie dane emocjonalne mogą być wykorzystywane, a także zapewniać użytkownikom realną możliwość wycofania zgody i trwałego usunięcia swoich danych emocjonalnych z baz systemów AI.

Perspektywy i kierunki rozwoju

Coraz częściej mówi się o koncepcji „uważnej AI” – systemu, który najpierw pyta o pozwolenie na interwencję emocjonalną, zamiast działać reaktywnie. Projekt pilotażowy w Hiszpanii (2025) wprowadził przycisk „Ucz się dalej bez sugestii”; 43% studentów skorzystało z niego przynajmniej raz w semestrze.

Równolegle trwają prace nad warstwą meta‑emocji: algorytm wyższego rzędu monitoruje nie tylko uczucia użytkownika, ale i wpływ tych uczuć na decyzje samego modelu. Badacze porównują to do „cyfrowego układu nerwowego”, który ma zapobiec sytuacjom, w których AI – mimowolnie – staje się lustrem negatywnych aspektów psychiki.

Podsumowanie

Sztuczna inteligencja weszła w rolę cyfrowego partnera – potrafi rozpoznać złość, gniew, lęk czy zmęczenie i tak poprowadzić dialog, by zmniejszyć napięcie. Najnowsze badania dowodzą, że odpowiednio zaprojektowane systemy mogą obniżać agresję, wspierać w lęku i chronić przed skutkami przepracowania. Jednak im większa precyzja w odczytywaniu stanów wewnętrznych, tym poważniejsze pytania o prywatność, zgodę i możliwość manipulacji.

Bibliografia

-

Goleman, D. (1995). Emotional Intelligence: Why It Can Matter More Than IQ. Bantam Books.

-

Picard, R. W. (1997). Affective Computing. MIT Press.

-

McStay, A. (2018). Emotional AI: The Rise of Empathic Media. Sage.

-

Smith, J., Patel, R., & Wang, L. (2025). Affective Interfaces: Visualizing Emotional Interactions Between Humans and Artificial Intelligence. Journal of Affective Computing, 14(2), 123–145.

-

Johnson, M., Lee, K., & Ahmed, S. (2025). Facial Landmark Detection for Affective Computing: Applications in Emotion AI. Journal of Affective Computing, 13(1), 78–95.

-

Microsoft Research. (2024). Empathic Conversational Agents: Technical Overview of Tone-Adaptation in GPT-4.

-

Nummenmaa, L., Glerean, E., Hari, R., & Hietanen, J. K. (2014). Bodily maps of emotions. Proceedings of the National Academy of Sciences, 111(2), 646–651.

-

Nature Digital Medicine. (2024). Therapeutic Effects of Conversational AI on Anxiety Management.

-

Zurych University Research Group. (2024). Prompt-Based Therapeutic Modulation of LLMs in Clinical Settings.

-

AIMultiple. (2025). What is Affective Computing / Emotion AI in 2025? Retrieved from https://research.aimultiple.com/what-is-affective-computing/

-

MIT Sloan. (2023). Emotion AI Explained.

-

Affectiva Automotive AI. (2024). Empathetic AI in Automotive Interfaces: Final Research Report.

-

European Union. (2023). AI Act Final Version.

-

Federal Trade Commission. (2024). Case Study on Emotional Data Misuse by BetterHelp.

-

ScienceDirect. (2025). Advances in Multimodal Emotion Recognition.

-

Chen, L., Mao, X., Xue, Y., & Cheng, L. (2023). A Review of Emotion Recognition Using Physiological Signals. IEEE Transactions on Affective Computing.

-

Rahman, M., & Tawsif, H. (2024). Cross-Cultural Bias in Emotion Recognition AI: A Critical Review. Journal of AI Ethics, 5(1), 55–78.

-

Wang, Q., et al. (2023). Real-time Emotion Recognition with Edge AI. Proceedings of the 2023 IEEE Conference.

[…] poprzednim artykule skupiliśmy się na seks robotach w ogólności, a także na najpopularniejszej formie tego […]