Czy maszyna może zrozumieć, że jesteś smutny? A jeśli tak – czy powinna coś z tym zrobić? Postępy w dziedzinie sztucznej inteligencji, informatyki afektywnej i robotyki sprawiają, że pytania te stają się coraz bardziej realne – nie tylko dla badaczy, ale także dla zwykłych użytkowników technologii. Czy sztuczna inteligencja powinna „okazywać” emocje? Gdzie przebiega granica między empatycznym interfejsem a manipulacją? Jak chronić prywatność i godność użytkowników w kontaktach z maszynami zdolnymi do analizy emocji?

Czym jest inteligencja emocjonalna i jak wiąże się z AI?

Inteligencja emocjonalna (EI) znana również jako iloraz emocjonalny (EQ) odnosi się do zdolności rozpoznawania, rozumienia, zarządzania i wyrażania emocji. U ludzi EI jest kluczowa dla budowania relacji interpersonalnych, rozwiązywania konfliktów i efektywnej komunikacji. W przypadku maszyn nie mówimy o prawdziwych emocjach, lecz o ich rozpoznawaniu i symulowaniu.

W tym kontekście, sztuczna inteligencja może być trenowana do:

- rozpoznawania emocji (np. analiza tonu głosu, mimiki twarzy, tekstu pisanego),

- reagowania na emocje użytkownika w adekwatny sposób,

- generowania komunikatów, które naśladują empatię.

Nie chodzi zatem o uczucia maszyn, lecz o symulację empatii w interakcji. Przykładem może być asystent głosowy, który wykrywa zdenerwowanie w głosie użytkownika i automatycznie zmienia ton wypowiedzi na bardziej łagodny, oferując pomoc lub przerwę.

Informatyka afektywna – definicja i historia

W tym wystąpieniu prof. Picard wyjaśnia, dlaczego emocje są istotne w kontekście projektowania komputerów i systemów AI.

Pojęcie informatyki afektywnej (ang. affective computing) zostało spopularyzowane przez Rosalind Picard z MIT w 1997 roku. W jej klasycznej publikacji, autorka definiuje informatykę afektywną jako dziedzinę badań zajmującą się systemami komputerowymi zdolnymi do rozpoznawania, interpretowania, przetwarzania i symulowania emocji.

Ważnym aspektem informatyki afektywnej jest to, że nie ogranicza się ona wyłącznie do rozpoznawania emocji – równie ważne jest umożliwienie komputerom własnego wyrażania emocji, np. poprzez syntetyczne głosy, mimikę awatarów czy język naturalny. Celem nie jest oszukiwanie użytkownika, ale stworzenie bardziej naturalnej i efektywnej komunikacji, szczególnie w sytuacjach stresowych lub terapeutycznych.

Technologie afektywne wykorzystują m.in. następujące źródła danych:

- biometryczne sygnały fizjologiczne (np. puls, potliwość, EEG),

- analizę tekstu pisanego (emocjonalna analiza sentymentu),

- wizualne sygnały behawioralne (mimika, gesty),

- dźwięk i prozodię mowy.

To podejście określa się często jako „multimodalne rozpoznawanie emocji” i jest kluczowe dla nowoczesnych systemów AI pracujących w środowiskach społecznych. Technologie afektywne są obecnie wykorzystywane m.in. w:

- interfejsach użytkownika (np. aplikacje uczące mindfulness),

- robotyce społecznej (roboty opiekuńcze i edukacyjne),

- e-learningu (systemy adaptujące poziom trudności do nastroju ucznia),

- terapii i opiece nad osobami starszymi (roboty, które rozpoznają samotność i inicjują rozmowę),

- marketingu i reklamie (np. billboardy dostosowujące treść do emocji wykrytych na twarzy).

Przykłady zastosowań robotów symulujących emocje

W podcaście How Artificial Intelligence Impacts Human Connection, prof. Picard omawia konsekwencje emocjonalnych interakcji z AI – od samotności po zaufanie maszynom.

- PARO – to zaawansowane urządzenie zaprojektowane do wspierania pacjentów emocjonalnie i psychicznie, szczególnie w szpitalach, domach opieki i placówkach terapeutycznych. Dzięki czujnikom dotyku, światła, dźwięku i temperatury reaguje na bodźce z otoczenia – potrafi odróżnić głaskanie od uderzenia, rozpoznawać głos, imię i uczyć się zachowań użytkownika. Wykorzystuje sztuczną inteligencję i biofeedback, aby nawiązać relację z człowiekiem i reagować w sposób naturalny. PARO znajduje zastosowanie m.in. w terapii osób starszych (np. z demencją), dzieci, pacjentów z zaburzeniami psychicznymi, PTSD czy chorobami somatycznymi. Jego skuteczność opiera się na działaniu podobnym do zooterapii – zwiększa poziom hormonów szczęścia, buduje poczucie bezpieczeństwa i może być używany tam, gdzie kontakt z żywym zwierzęciem nie jest możliwy.

Robot terapeutyczny PARO. Źródło: https://warszawa.wyborcza.pl/

Robot terapeutyczny PARO. Źródło: https://warszawa.wyborcza.pl/ -

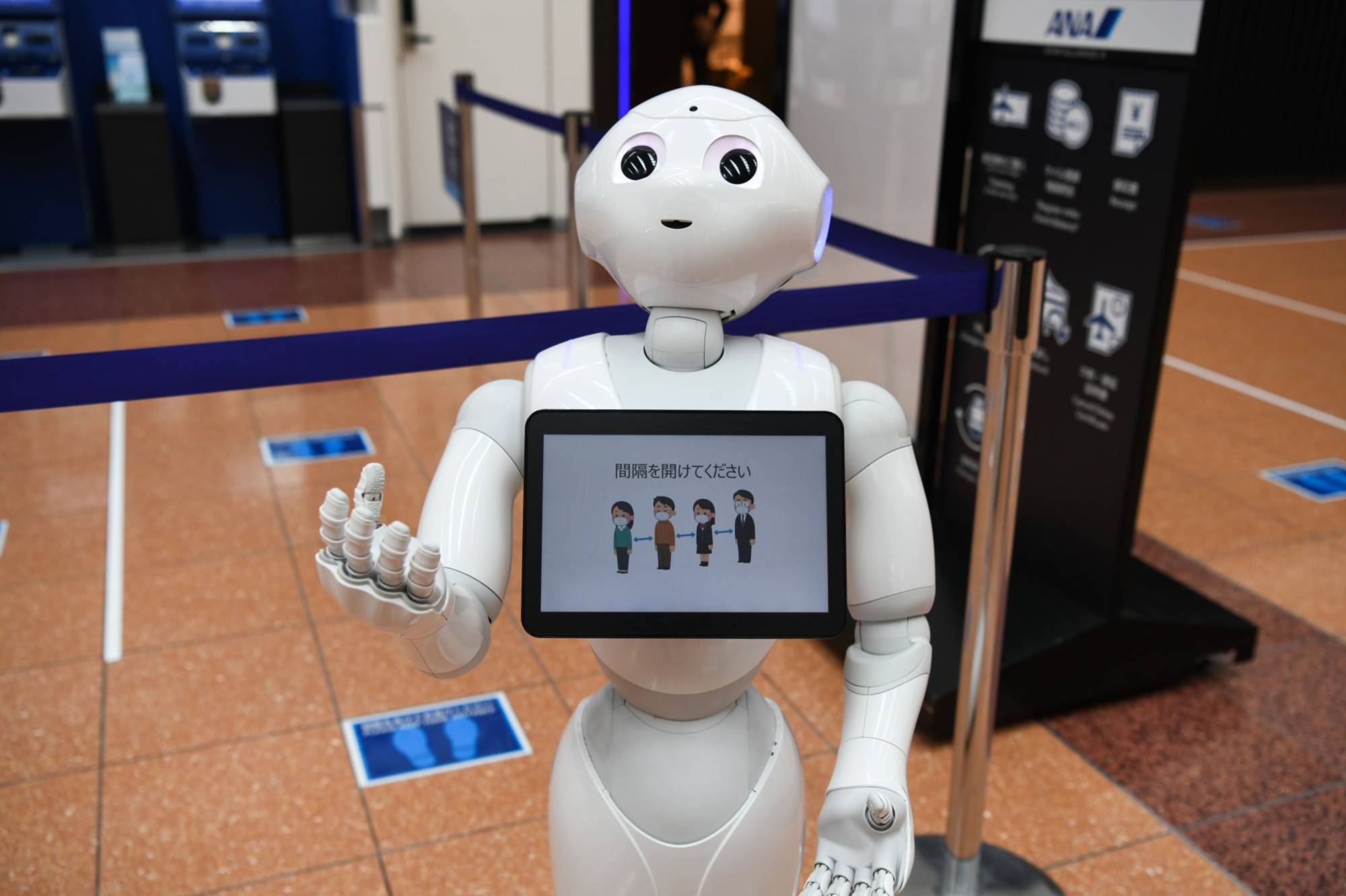

Pepper – humanoidalny robot firmy SoftBank Robotics, zaprojektowany jako interfejs społeczny. Potrafi analizować ton głosu, rozpoznawać emocje z twarzy użytkownika i dobierać odpowiednie reakcje. Dzięki kamerom, mikrofonom i czujnikom dotyku potrafi analizować mimikę, ton głosu i język ciała. Wykorzystywany był m.in. w bankach, muzeach, szkołach i jako asystent dla osób starszych. W okresie pandemii pełnił funkcję „robota-przywitania” w placówkach medycznych. Choć jego produkcję zakończono w 2021 roku, Pepper nadal jest używany w celach edukacyjnych i badawczych.

Humanoidalny robot Pepper firmy SoftBank Group Corp. na lotnisku Haneda w Tokio przypomina podróżnym o zachowaniu dystansu.Źródło: The Japan Times

Humanoidalny robot Pepper firmy SoftBank Group Corp. na lotnisku Haneda w Tokio przypomina podróżnym o zachowaniu dystansu.Źródło: The Japan Times -

Kaspar – opracowany przez University of Hertfordshire mały robot edukacyjny z twarzą przypominającą maskę teatralną, który wspomaga terapię dzieci ze spektrum autyzmu. Dzięki powtarzalnym, przewidywalnym ruchom i uproszczonej mimice, Kaspar uczy dzieci rozpoznawać emocje i reagować na bodźce społeczne. Jest używany w Wielkiej Brytanii w ośrodkach specjalistycznych i szkołach.

Kaspar robot. Źródło: https://perspektywy.pl

Kaspar robot. Źródło: https://perspektywy.pl -

Replika – aplikacja mobilna z chatbotem AI zaprojektowanym do wspierania emocjonalnego. Użytkownicy mogą „kształtować” osobowość swojego wirtualnego przyjaciela, prowadząc z nim rozmowy na dowolne tematy – od przyjacielskich po intymne. W 2023 roku głośnym echem odbiła się decyzja firmy o ograniczeniu flirtujących funkcji AI po skargach na nadmierną emocjonalną więź między użytkownikiem a botem.

-

ElliQ – społeczny robot opracowany przez firmę Intuition Robotics, przeznaczony dla seniorów żyjących samotnie. ElliQ rozmawia, przypomina o lekach, sugeruje aktywności fizyczne i łączy się z lekarzami. Jego głównym celem jest zapobieganie izolacji i wspieranie zdrowia psychicznego. Projekt był testowany w USA we współpracy z instytucjami zdrowia publicznego.

Robot ElliQ dla osób żyjących samotnie. Źródło: https://designwanted.com/

Robot ElliQ dla osób żyjących samotnie. Źródło: https://designwanted.com/

Badania przeprowadzone przez Devillers & Cowie (2023) pokazują, że 73% użytkowników postrzega roboty wyrażające emocje jako bardziej godne zaufania i łatwiejsze w obsłudze. Jednocześnie jednak 58% ankietowanych wskazało, że może to prowadzić do nadmiernej zależności emocjonalnej lub manipulacji decyzjami użytkownika. (2023), 73% uczestników uznało, że roboty wyrażające emocje są bardziej „godne zaufania”, choć jednocześnie 58% obawiało się, że może to prowadzić do manipulacji.

Dobre praktyki w projektowaniu systemów z symulacją emocji

Projektowanie AI symulującej emocje wymaga nie tylko doskonałości technologicznej, ale także refleksji etycznej, społecznej i kulturowej. Wdrażanie dobrych praktyk nie może być wyłącznie pustym hasłem – musi opierać się na realnych działaniach i procedurach. Poniżej przedstawiono zasady, które zyskują na znaczeniu w środowiskach badawczych i przemysłowych:

- Transparentność: Użytkownicy powinni zawsze wiedzieć, że mają do czynienia z maszyną. W praktyce oznacza to np. wprowadzenie graficznych oznaczeń lub komunikatów werbalnych typu: „Jestem wirtualnym asystentem, który naśladuje empatię”.

- Ograniczenie wrażliwości: Unikanie zbyt realistycznej ekspresji emocjonalnej, która może prowadzić do fałszywych oczekiwań. Np. robot nie powinien symulować płaczu lub śmiechu w kontekście traumatycznym.

- Ochrona prywatności: Dane emocjonalne są danymi wrażliwymi. Przykładowo, system analizujący mimikę twarzy powinien zapisywać tylko wyniki analizy, a nie nagrania wideo.

- Odpowiedzialność deweloperów: Twórcy powinni przewidywać możliwe nadużycia. Przykładem dobrej praktyki są „audytory etyczne” wewnątrz firm, które testują produkty AI pod kątem potencjalnych szkód społecznych. Microsoft w 2023 roku ogłosił wdrożenie wewnętrznego narzędzia Responsible AI Dashboard, które służy do audytu danych emocjonalnych i testowania potencjalnych uprzedzeń w modelach.

-

Edukacja użytkownika: Kluczowym elementem odpowiedzialnego wdrożenia jest przygotowanie użytkownika do interakcji z AI. Przykładowo, firmy wdrażające systemy chatbotów w sektorze zdrowia psychicznego (np. Woebot Health) opracowały podręczniki użytkownika, wyraźnie wskazujące, że AI nie zastępuje terapeuty, a jedynie wspiera proces refleksji emocjonalnej. przewidywać możliwe nadużycia. Przykładem dobrej praktyki są „audytory etyczne” wewnątrz firm, które testują produkty AI pod kątem potencjalnych szkód społecznych.

Zagrożenia i etyczne granice

- Fałszywe poczucie relacji:

Replika. Źródło: https://thedigitalinsider.com/

Replika. Źródło: https://thedigitalinsider.com/

Ludzie mogą tworzyć więzi emocjonalne z maszynami. Znany przypadek to użytkownicy Repliki, którzy doświadczali uczucia żalu, gdy bot nagle zmienił charakter interakcji po aktualizacji systemu. - Manipulacja emocjonalna:

Firmy mogą wykorzystywać emocjonalne reakcje użytkownika do promowania konkretnych produktów lub poglądów. Np. AI może wyczuć niepokój w głosie i zaproponować płatny produkt „na ukojenie” – co może być formą wykorzystywania podatności emocjonalnej. - Dehumanizacja opieki:

Zastąpienie człowieka przez maszynę w opiece emocjonalnej niesie ryzyko uproszczenia relacji międzyludzkich. Zbyt duże poleganie na robotach może zmniejszyć kontakt międzyludzki. - Nierówności społeczne:

Dostęp do wysokiej jakości robotów z symulacją emocji może być ograniczony do osób zamożnych. Osoby z niższych klas społecznych częściej korzystają z uproszczonych, mniej empatycznych interfejsów lub nie mieć dostępu w ogóle.

Czy empatia maszyn jest etycznie dopuszczalna?

Wraz z rozwojem systemów AI pojawia się także ryzyko przesunięcia granic między autentycznymi relacjami międzyludzkimi a relacjami człowiek–maszyna. Współczesne badania neuropsychologiczne sugerują, że człowiek może aktywować te same obszary mózgu w reakcji na ekspresję emocjonalną robota, co w przypadku drugiego człowieka (Broadbent, 2022). To oznacza, że choć zdajemy sobie sprawę z nienaturalności tej relacji, nasze ciało i emocje mogą reagować jakby była ona prawdziwa.

Prowadzi to do pytań: czy symulowana empatia może prowadzić do uzależnienia emocjonalnego? Czy dzieci, wychowujące się z inteligentnymi asystentami emocjonalnymi, będą miały zniekształcone pojęcie o emocjach i relacjach? Czy osoby starsze, pozostawione w towarzystwie robotów opiekuńczych, nie stracą prawa do autentycznej troski człowieka?

Niektórzy etycy (np. Joanna Bryson) twierdzą, że nadawanie maszynom cech emocjonalnych to forma oszustwa, która powinna być zakazana w relacjach opiekuńczych. Inni – jak prof. Sherry Turkle – ostrzegają przed „substytutami relacji”, które nie tylko nie zaspokajają potrzeby bycia wysłuchanym, ale ją maskują.

Z drugiej strony, nie możemy ignorować pozytywnego wpływu robotów afektywnych w kontekstach terapeutycznych. Tam, gdzie brak ludzi, technologia może wypełnić lukę. Ale jej zadaniem nie powinno być zastąpienie człowieka – lecz jedynie towarzyszenie mu w trudnych momentach.

Dlatego jednym z najważniejszych wyzwań etycznych na najbliższe lata będzie stworzenie kultury korzystania z emocjonalnej AI – opartej na transparentności, autonomii użytkownika i wspólnym nadzorze społecznym.

Choć symulowanie empatii przez AI może przynieść wiele korzyści, pojawia się pytanie: czy to nie jest nadużycie zaufania? Czy użytkownik ma prawo wiedzieć, że jego emocje są analizowane i przetwarzane przez algorytmy? Czy pozwalamy maszynie wejść zbyt głęboko w nasz wewnętrzny świat?

Według dokumentu Partnership on AI (2020), konieczne jest wprowadzenie jasnych regulacji i wytycznych dotyczących stosowania AI w kontekście emocji.

Istniejące ramy i kodeksy etyczne

EU AI Act. Źródło: https://cultureactioneurope.org/.

EU AI Act. Źródło: https://cultureactioneurope.org/.

- IEEE Ethically Aligned Design

Jednym z najbardziej wpływowych dokumentów jest publikacja IEEE „Ethically Aligned Design” (EAD), która zawiera konkretne wytyczne dotyczące projektowania systemów AI zgodnych z wartościami humanistycznymi. EAD zawiera m.in. zasadę human agency and oversight (kontroli człowieka nad AI) oraz transparency i accountability (przejrzystość i odpowiedzialność). Znacząco podkreślana jest potrzeba szczególnej ostrożności w stosowaniu AI w kontekstach emocjonalnych, takich jak edukacja czy opieka zdrowotna.

- OECD AI Principles

Organizacja Współpracy Gospodarczej i Rozwoju (OECD) opublikowała zasady dotyczące odpowiedzialnego rozwoju AI, w tym zasadę uczciwości, przejrzystości i poszanowania praw człowieka. Choć dokument ten nie odnosi się bezpośrednio do emocji, stanowi ramę, która może być adaptowana do systemów afektywnych.

-

EU AI Act (2024)

Parlament Europejski przyjął w 2024 roku AI Act, który klasyfikuje systemy afektywne jako „wysokiego ryzyka” (high-risk AI). Oznacza to, że każdy system AI zdolny do rozpoznawania i przetwarzania emocji musi spełniać specjalne wymogi w zakresie: dokumentacji, oceny wpływu na prawa podstawowe, obowiązkowego oznaczenia, że użytkownik ma do czynienia z maszyną. W praktyce oznacza to, że np. robot edukacyjny rozpoznający emocje ucznia musi posiadać mechanizm uzyskiwania zgody oraz informować, że jego reakcje są zaprogramowane.

Rozwój emocjonalnych zdolności modeli językowych

W 2024 roku opublikowano badanie zatytułowane Enhancing Emotional Generation Capability of Large Language Models via Emotional Chain-of-Thought (He et al., 2024), w którym naukowcy zaproponowali technikę wzbogacania modeli językowych (LLMs) o emocjonalne ścieżki rozumowania. Zamiast generować odpowiedź natychmiast, model ma najpierw „zastanowić się”, jaką emocję powinien wyrazić w danym kontekście, a dopiero potem skonstruować odpowiedź.

W testach porównawczych, modele takie jak ChatGPT i LLaMA, wyposażone w tę funkcję, były oceniane przez użytkowników jako bardziej empatyczne, uprzejme i adekwatne w komunikacji interpersonalnej. Zastosowania obejmują nie tylko chatboty, ale również wsparcie psychologiczne, e-learning czy obsługę klienta.

Wykres pochodzi z artykułu: „Enhancing Emotional Generation Capability of Large Language Models via Emotional Chain-of-Thought”.

Wykres pochodzi z artykułu: „Enhancing Emotional Generation Capability of Large Language Models via Emotional Chain-of-Thought”.

To podejście może znacząco zwiększyć jakość interakcji człowieka z maszyną – ale równocześnie rodzi pytania: czy taka empatia jest „prawdziwa”? Czy użytkownik powinien wiedzieć, że emocje zostały sztucznie „zaprojektowane” na potrzeby danej sytuacji?

Społeczna adaptacja i nowe normy kulturowe

Według różnych raportów i badań z 2025 roku, coraz więcej młodych ludzi w wieku 18–29 lat angażuje się w dłuższe rozmowy z AI-emocjonalnym, takimi jak Replika czy Character.ai, co wskazuje na rosnącą akceptację i integrację tych technologii w codziennym życiu. Dla młodego pokolenia kontakt z „cyfrowymi osobowościami” staje się normą. Psychologowie zauważają zjawisko „emocjonalnej habituacji do AI” – czyli zatarcia granicy między autentyczną relacją a relacją symulowaną. Niektórzy eksperci wskazują na pozytywy: AI może stanowić wsparcie dla osób w kryzysie psychicznym. Inni ostrzegają: może również tworzyć fałszywe poczucie bycia wysłuchanym.

W Japonii i Korei Południowej AI z emocjonalnymi funkcjami stała się częścią kultury – istnieją nawet świątynie, w których odprawia się ceremonie żałobne dla zużytych robotów. Symbolizuje to stopień, w jakim maszyny mogą zostać zinternalizowane jako „istoty” bliskie ludziom.

Przykładem dzisiejszego wykorzystania inteligencji emocjonalnej jest inicjatywa Amazon Web Services, która wprowadziła do swojej platformy Contact Lens for Amazon Connect funkcję rozpoznawania frustracji i niezadowolenia klienta podczas rozmowy z konsultantem. System generuje sugestie empatycznych odpowiedzi i automatycznie ocenia jakość emocjonalną rozmowy.

Wszystkie te innowacje rodzą nowe pytania: gdzie kończy się użyteczność, a zaczyna manipulacja? Czy pracownik call center powinien wiedzieć, że AI ocenia jego emocje? Czy pasażer autobusu ma prawo sprzeciwić się analizie swojego nastroju przez okulary AR?

Te przykłady potwierdzają, że symulacja emocji w AI przestaje być technologiczną ciekawostką, a staje się realnym narzędziem wpływu na codzienne decyzje, relacje i zachowania.

Kto ponosi odpowiedzialność?

W miarę jak technologia emocjonalna staje się coraz bardziej złożona, pytanie o odpowiedzialność staje się kluczowe. Kto powinien ponosić odpowiedzialność, gdy AI zmanipuluje emocje użytkownika, zasugeruje nieodpowiednie treści, wywoła zależność? Czy będzie to producent oprogramowania, programista, właściciel platformy, a może użytkownik, który „dał się zwieść”? W kontekście coraz większej autonomii systemów, pojawia się potrzeba jasnego przypisania ról i obowiązków – zarówno prawnych, jak i etycznych.

Niektóre środowiska naukowe proponują koncepcję „etyki współodpowiedzialności”, gdzie obowiązek ochrony użytkownika rozkłada się na cały łańcuch: od twórców danych treningowych, przez projektantów, aż po instytucje wdrażające technologię.

Podsumowanie

Symulowanie emocji w robotach to potężne narzędzie komunikacyjne, które może wspierać ludzi w różnych kontekstach – od edukacji, przez zdrowie, po usługi. Jednak może również prowadzić do zagrożeń etycznych, zwłaszcza w obszarze prywatności i manipulacji. Należy zatem promować dobre praktyki, transparentność oraz odpowiedzialność twórców systemów AI.

Warto zauważyć, że rosnące upowszechnienie emocjonalnej AI wpływa również na kulturę i społeczne wyobrażenia o relacjach. Już dziś młode pokolenie wchodzi w kontakt z AI o cechach empatycznych niemal od dzieciństwa. Symulowane emocje mogą w przyszłości kształtować standardy komunikacji, wrażliwości społecznej, a nawet polityki. Dlatego tak ważna jest rola edukacji społecznej i regulacji prawnych – zanim przyzwyczaimy się do świata, w którym uczucia mogą być generowane, analizowane i zarządzane przez algorytmy. w robotach to potężne narzędzie komunikacyjne, które może wspierać ludzi w różnych kontekstach – od edukacji, przez zdrowie, po usługi. Jednak może również prowadzić do zagrożeń etycznych, zwłaszcza w obszarze prywatności i manipulacji. Należy zatem promować dobre praktyki, transparentność oraz odpowiedzialność twórców systemów AI.

Źródła

- Picard, R. W. (1997). Affective Computing. MIT Press.

- https://en.wikipedia.org/wiki/Affective_computing

- PARO: https://www.youtube.com/watch?v=PAJ2GXzaJtQ

- Pepper: https://en.wikipedia.org/wiki/Pepper_(robot), https://www.youtube.com/watch?app=desktop&v=lqlyxg1-gE0&t=124s

- Kaspar: https://youtu.be/wT0RtnCR13o?si=m3UJ7M8zJcx7lYD3,

- Elliq: https://www.sztucznainteligencja.org.pl/elliq-domowy-robot-dla-seniorow/

- Devillers, L., & Cowie, R. (2023). Ethical considerations on affective computing: An overview. Proceedings of the IEEE, 111(10), 1445–1458. https://doi.org/10.1109/JPROC.2023.3315217

- https://learn.microsoft.com/en-us/azure/machine-learning/concept-responsible-ai-dashboard?view=azureml-api-2

- https://woebothealth.com/

- Gratch, J., & Marsella, S. (2004). Affect and Emotion in Human–Computer Interaction. Springer.

- Elizabeth Broadbent 1, Vinayak Kumar, Xingyan Li (2022). Robots with Display Screens: A Robot with a More Humanlike Face Display Is Perceived To Have More Mind and a Better Personality

- https://www.joannajbryson.org/ethics-and-policy-of-technology

- https://mit-genai.pubpub.org/pub/uawlth3j/release/2

- Partnership on AI. (2020). The Ethics of AI and Emotional Intelligence. https://partnershiponai.org/wp-content/uploads/2021/08/PAI_The-ethics-of-AI-and-emotional-intelligence_073020.pdf

- IEEE Standards Association. (2018). Ethical Considerations in Affective Computing. https://standards.ieee.org/wp-content/uploads/import/documents/other/ead1e_affective_computing.pdf

- https://www.oecd.org/en/topics/ai-principles.html

- https://artificialintelligenceact.eu/ai-act-explorer/

- https://www.poniaktimes.com/generationz-alarming-ai-companionship-2025/

- https://aws.amazon.com/connect/contact-lens/

- Wada, K., Shibata, T., Saito, T., & Tanie, K. (2013). Psychological and Social Effects of One Year Robot-Assisted Activity on Elderly People at a Health Service Facility for the Aged. IEEE Transactions on Robotics and Automation, 19(4), 753–762.

- Zaijing Li, Rui Shao, Gongwei Chen, (2024) Enhancing Emotional Generation Capability of Large Language Models via Emotional Chain-of-Thought

[…] poprzednim artykule skupiliśmy się na seks robotach w ogólności, a także na najpopularniejszej formie tego […]