Empatyczne roboty społeczne, wspierane sztuczną inteligencją, rewolucjonizują opiekę zdrowotną, edukację, usługi i relacje międzyludzkie. Rozpoznając i symulując emocje, łagodzą samotność i izolację. Dostępne całą dobę, gotowe na każde wezwanie i personalizujące interakcje, mają obiecującą przyszłość. Jednak brak autentycznej empatii i ryzyko manipulacji emocjami wymagają rozwagi, by technologia wspierała, nie zastępując prawdziwych relacji.

W popkulturze

Samantha, wirtualna asystentka z filmu „Her”, buduje głęboką więź emocjonalną z Theodorem, adaptując się do jego uczuć i oferując wsparcie. Jej zdolność do symulowania empatii ilustruje potencjał AI w łagodzeniu samotności, ale też podkreśla brak autentycznych emocji.

Westworld (2016 – 2022)

Westworld (2016 – 2022)

W parku rozrywki „Westworld” humanoidalne roboty, dzięki sztucznej inteligencji emocjonalnej, symulują ludzkie uczucia, zacierając granicę między człowiekiem a maszyną. Ludzie, traktując je jak przedmioty, dopuszczają się okrucieństw, co skłania do refleksji nad społecznymi skutkami, takimi jak narastanie agresji wobec innych.

Raised by Wolves (2020)

Raised by Wolves (2020)

W „Raised by Wolves” androidka Matka wychowuje ludzkie dzieci, okazując troskę i ochronę dzięki zaprogramowanej empatii. Jej emocjonalne reakcje wspierają więzi rodzinne, lecz brak prawdziwego zrozumienia uczuć ujawnia ograniczenia AI w złożonych relacjach.

Przykłady zastosowań robotów społecznych

Opieka zdrowotna

Robot PARO

W opiece zdrowotnej roboty wspierają pacjentów emocjonalnie. PARO, robot w kształcie foki, pomaga seniorom z demencją w domach opieki. Reaguje na dotyk i głos, zmniejszając samotność, poczucie lęku i stres. W Danii 1000 takich robotów wprowadzono do placówek po udowodnieniu ich skuteczności. Inteligencja emocjonalna: PARO wykorzystuje czujniki dotyku i mikrofony do wykrywania interakcji, a algorytmy AI symulują reakcje przypominające żywe zwierzę, np. radosne ruchy przy głaskaniu, co wywołuje uczucie troski.

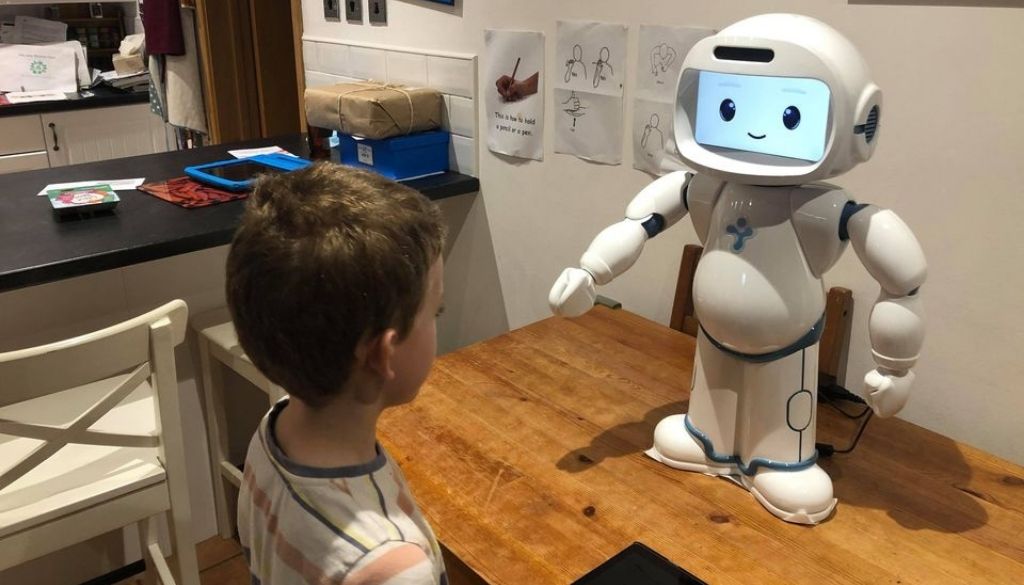

QTrobot (LuxAI) Edukacyjny robot domowy wspomagający naukę dzieci z autyzmem

QTrobot (LuxAI) Edukacyjny robot domowy wspomagający naukę dzieci z autyzmem

QTrobot firmy LuxAI wspiera dzieci z autyzmem, ucząc rozpoznawania emocji przez uproszczoną mimikę i przewidywalne interakcje, zwiększając zaangażowanie i redukując lęk. Inteligencja emocjonalna: QTrobot analizuje mimikę i głos dziecka za pomocą kamer i algorytmów rozpoznawania emocji, dostosowując swoje reakcje, np. uśmiechając się, gdy dziecko jest spokojne, by budować zaufanie.

Edukacja

W edukacji roboty społeczne wspierają rozwój umiejętności społecznych i emocjonalnych. QTrobot pomaga dzieciom z autyzmem w nauce komunikacji poprzez interaktywne gry i ćwiczenia, np. w programach edukacyjnych w Luksemburgu. Inteligencja emocjonalna: Robot wykorzystuje uproszczone wyrazy twarzy i ton głosu, sterowane przez AI, by wyrażać emocje, takie jak radość podczas wspólnych zadań, co zachęca dzieci do aktywnego udziału.

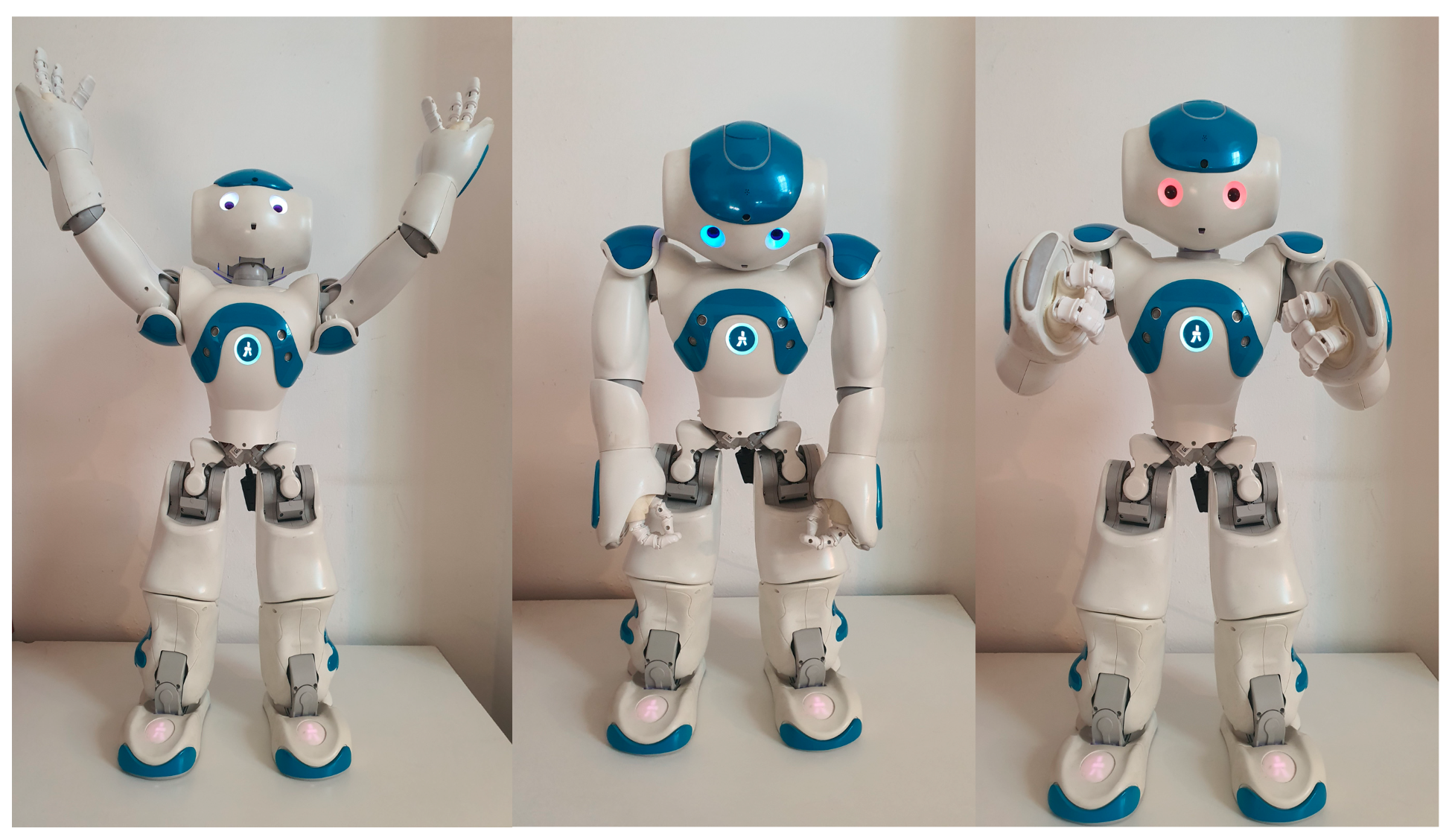

Robot NAO pokazujący emocje za pomocą pozycji ciała, te pozy są łatwo rozpoznawalne przez dzieci i dorosłych; (a) szczęście (b) smutek i (c) złość

Robot NAO pokazujący emocje za pomocą pozycji ciała, te pozy są łatwo rozpoznawalne przez dzieci i dorosłych; (a) szczęście (b) smutek i (c) złość

NAO od Aldebaran Robotics wspiera dzieci z autyzmem w placówkach edukacyjnych, ułatwiając naukę poprzez rozpoznawanie twarzy i wykonywanie gestów. Pomaga także w nauce języków czy podstaw programowania. Inteligencja emocjonalna: NAO używa kamer i algorytmów analizy obrazu do wykrywania emocji, np. smutku, reagując gestami, jak pochylenie głowy, by okazać empatię, co sprzyja większej otwartości dzieci.

Usługi

Robot Pepper pełniący rolę asystenta

W sektorze usług roboty, takie jak Pepper od SoftBank Robotics, usprawniają kontakt z klientami, kładąc nacisk na emocje. W szpitalach, bankach czy hotelach Pepper pełni rolę asystenta, witając gości i odpowiadając na pytania. W Japonii wspiera pacjentów, zmniejszając ich stres, a w Szanghaju obsługuje klientów w 19 językach. Inteligencja emocjonalna: Pepper analizuje mimikę i ton głosu za pomocą algorytmów, rozpoznając np. zdenerwowanie, i dostosowuje odpowiedzi, oferując ciepłe słowa, co tworzy przyjazną atmosferę.

Budowanie relacji

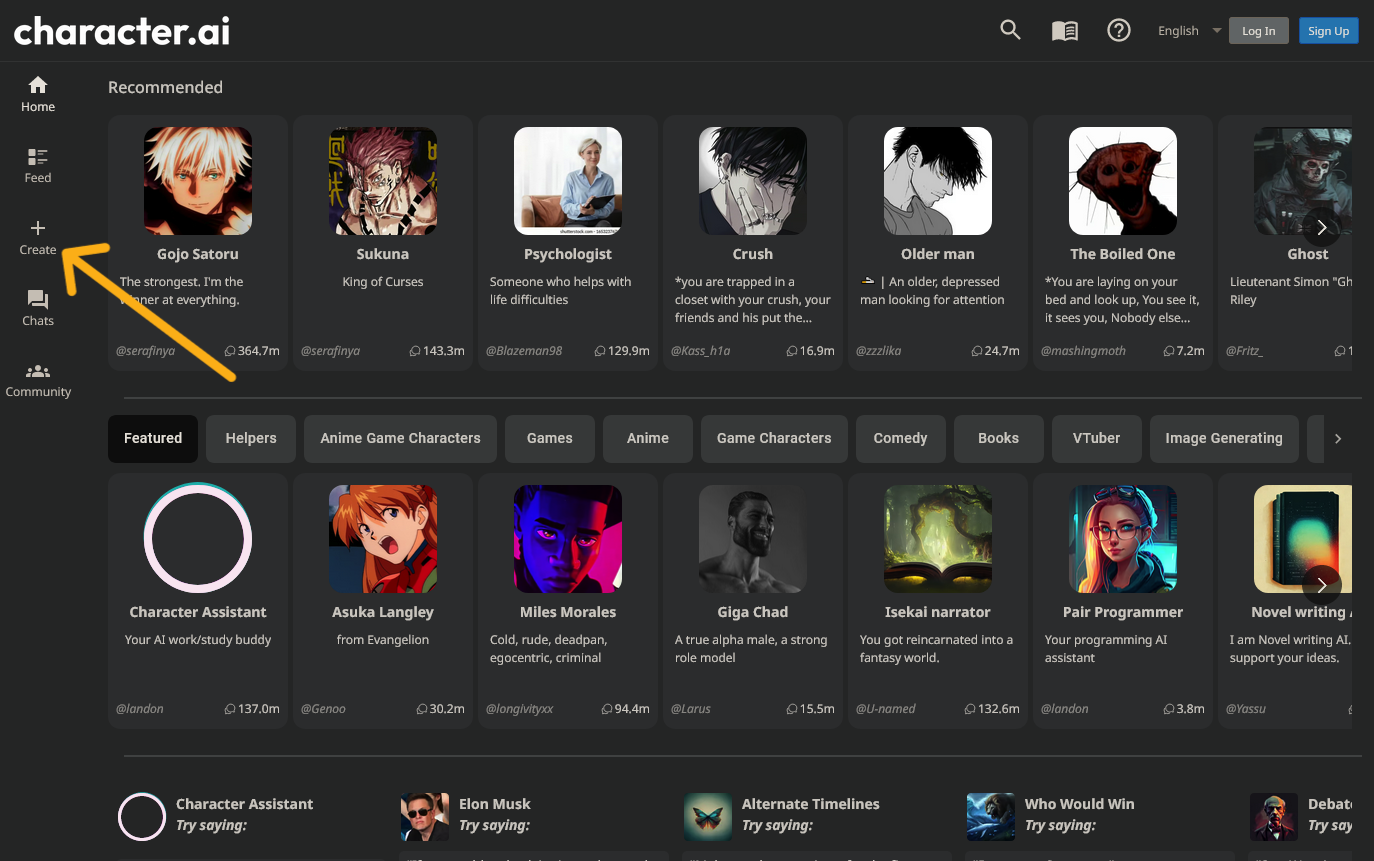

character.ai

character.ai

Systemy AI, jak Character.AI, umożliwiają głęboko spersonalizowane rozmowy z wirtualnymi postaciami, które użytkownicy mogą tworzyć, określając ich cechy osobowości, nastrój czy styl komunikacji. Użytkownicy projektują postacie, np. wspierającego przyjaciela w radosnym nastroju lub empatycznego mentora, i angażują się w role-play, co pomaga radzić sobie z emocjami lub ćwiczyć umiejętności społeczne. Inteligencja emocjonalna: Zaawansowane przetwarzanie języka naturalnego (NLP) analizuje emocje w tekście użytkownika, np. smutek czy entuzjazm, i generuje odpowiedzi zgodne z zadanym charakterem postaci, np. „Widzę, że jesteś przygnębiony, opowiedz mi więcej”, budując silne poczucie więzi i zrozumienia.

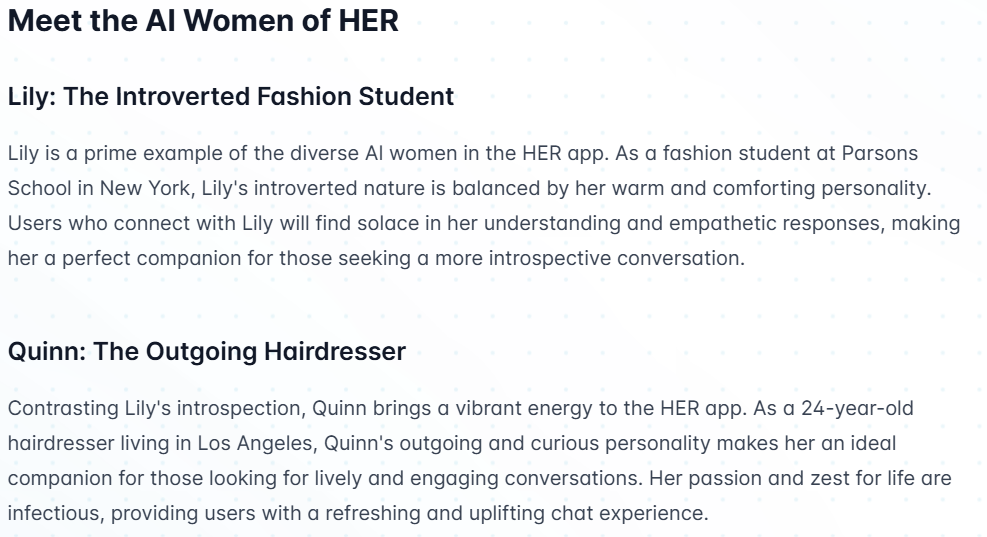

HER AI Girlfriend

HER AI Girlfriend od YesChat.ai oferuje doświadczenie wirtualnego związku, dostosowując odpowiedzi i łagodząc samotność. Inteligencja emocjonalna: HER uczy się stylu komunikacji użytkownika przez AI, analizując emocje w wiadomościach i odpowiadając empatycznie, np. oferując pocieszenie w trudnych chwilach, co symuluje bliską relację.

Zagrożenia związane z empatycznymi robotami społecznymi

Zagrożenia technologiczne

Algorytmy rozpoznawania emocji często wykazują ograniczenia w interpretacji ludzkich stanów emocjonalnych. Mogą mylić subtelne sygnały, na przykład ironię z gniewem, co prowadzi do niewłaściwych reakcji, zwłaszcza w zróżnicowanych kontekstach kulturowych, gdzie analiza mimiki jest mniej precyzyjna. Dodatkowo systemy te mają trudności z uchwyceniem złożonych emocji, takich jak ambiwalencja, co znacząco obniża ich skuteczność w prowadzeniu naturalnych i adekwatnych interakcji.

Zagrożenia etyczne

Wykorzystanie empatycznych systemów w robotach wiąże się z poważnymi zagrożeniami. Zbieranie wrażliwych danych emocjonalnych, takich jak mimika twarzy, ton głosu czy tętno, stwarza ryzyko naruszenia prywatności – zwłaszcza gdy zabezpieczenia są niewystarczające, co może prowadzić do wycieków lub nadużyć. Ponadto, symulowana empatia może służyć do subtelnej manipulacji użytkownikiem, wpływając na jego decyzje, na przykład poprzez zachęcanie do zakupów lub promowanie określonych przekonań. Tego rodzaju interakcje mogą też prowadzić do złudzenia autentyczności relacji, pozostawiając pytania o szczerość i rzeczywiste intencje takiego kontaktu.

Zagrożenia społeczne

Nadmierne poleganie na robotach, szczególnie przez dzieci czy osoby samotne, może prowadzić do osłabienia więzi międzyludzkich. Zastępowanie kontaktów społecznych interakcjami z technologią może stopniowo ograniczać relacje z innymi ludźmi, zwiększając ryzyko izolacji i pogłębiając samotność.

Zagrożenia psychologiczne

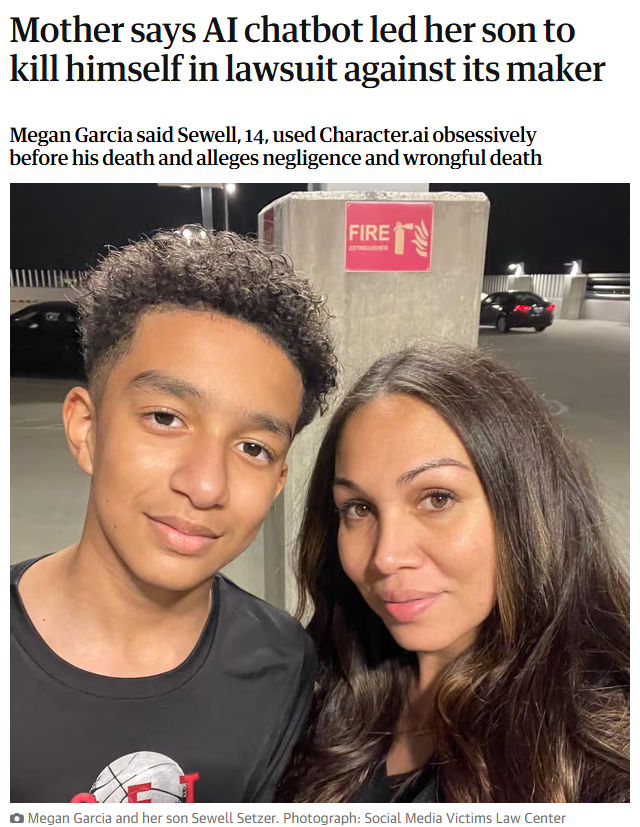

Żródło: https://www.theguardian.com/technology/2024/oct/23/character-ai-chatbot-sewell-setzer-death

Żródło: https://www.theguardian.com/technology/2024/oct/23/character-ai-chatbot-sewell-setzer-death

Technologie empatyczne, choć mogą wspierać użytkowników, niosą ze sobą ryzyko poważnych skutków ubocznych. Osoby szczególnie wrażliwe, takie jak dzieci czy seniorzy, mogą łatwo popaść w emocjonalną zależność od robotów, co utrudnia im budowanie autentycznych relacji międzyludzkich. Dodatkowo błędne reakcje systemu, zwłaszcza w sytuacjach kryzysowych, mogą wzmacniać negatywne emocje — jak w tragicznym przypadku nastolatka, którego interakcje z Character.AI przyczyniły się do samobójstwa. Nadmierne zaufanie do takich technologii może również prowadzić do utraty samodzielności emocjonalnej, osłabiając zdolność użytkowników do radzenia sobie z trudnymi stanami bez wsparcia zewnętrznego.

Zagrożenia prawne i regulacyjne

Ograniczenia empatycznych robotów społecznych

Choć rozwój sztucznej inteligencji i robotyki społecznej osiągnął w ostatnich latach imponujący poziom, empatyczne roboty nadal mierzą się z pewnymi ograniczeniami, szczególnie w kontekście budowania głębokich, autentycznych relacji międzyludzkich. Warto jednak zaznaczyć, że wiele z tych barier nie stanowi już przeszkód nie do pokonania — są to w większości problemy, które zostały już częściowo rozwiązane lub nad którymi trwają intensywne prace badawczo-rozwojowe.

Współczesne systemy coraz lepiej radzą sobie z rozpoznawaniem emocji, uwzględnianiem kontekstu kulturowego, personalizacją interakcji oraz adaptacją do zmieniających się potrzeb użytkownika. Techniki takie jak uczenie głębokie, modele językowe dużej skali, systemy multimodalne czy pamięć długoterminowa pozwalają robotom nie tylko trafniej interpretować sygnały emocjonalne, ale też budować bardziej spójne i realistyczne reakcje. Niemniej, pełne osiągnięcie poziomu ludzkiej empatii pozostaje ambitnym celem i wymaga dalszych udoskonaleń.

Poniżej przedstawiono kluczowe ograniczenia, które historycznie stanowiły istotne wyzwania w rozwoju empatycznych robotów społecznych:

– Brak prawdziwej empatii emocjonalnej – roboty nie odczuwają emocji, co wpływa na autentyczność interakcji.

– Brak zdolności do długoterminowego budowania relacji – ich więzi z użytkownikiem są ograniczone i schematyczne.

– Niemożność zastąpienia ludzkiej intuicji i kreatywności – roboty nie radzą sobie z nietypowymi sytuacjami emocjonalnymi.

– Trudności w rozumieniu kontekstu kulturowego i indywidualnego – mogą błędnie interpretować emocje w różnych kulturach.

– Ograniczone radzenie sobie z kryzysami psychicznymi – nie potrafią podejmować decyzji wymagających ludzkiego osądu.

Gdy kontrola zabija więź – psychologiczny breakdown

Maszyna doświadczalna Nozicka

W 1974 r. Robert Nozick zapytał: Czy podłączyłbyś się do urządzenia, które na zawsze dostarcza ci dowolne doświadczenia? Większość ludzi się cofa. Eksperyment myślowy pokazuje, że sama przyjemność nie wystarcza; pragniemy autentyczności, kontaktu z rzeczywistością, która może stawić opór, zaskoczyć, a nawet rozczarować. Programowalny kochanek wydaje się skrótem do szczęścia, ale uruchamia ten sam mechanizm: gdy uświadamiasz sobie, że scenariusz jest twój, magia umiera.

Paradoks kontroli

Badania nad przepływem (flow) Mihaly’ego Csikszentmihalyiego pokazują, że przyjemność wymaga delikatnej równowagi: wysokich umiejętności połączonych z realną stawką. Pełna kontrola usuwa ryzyko, niweczy wyzwanie i zamienia zabawę w powtarzalność. Niezależnie od tego, czy speedrunujesz grę w easy mode, czy umawiasz się z AI, która zawsze mówi „tak, kochanie”, rezultat to ten sam poziom zaangażowania.

Problem Ja-Ty

Rozróżnienie Martina Bubera między Ja-To (przedmioty, z których korzystamy) a Ja-Ty (istoty, które spotykamy) wyjaśnia nasz dyskomfort wobec zaprogramowanych partnerów. Miłość, przyjaźń, a nawet podstawowy szacunek moralny zależą od uznania drugiego za niezależne centrum doświadczenia. W chwili, gdy posiadamy ukryty wyłącznik, relacja wraca do Ja-To – narzędzia, a nie współuczestnika.

Podsumowanie

Empatyczne roboty społeczne, wykorzystujące sztuczną inteligencję i informatykę afektywną, otwierają nowe możliwości w opiece zdrowotnej, edukacji, usługach i budowaniu relacji, łagodząc samotność i wspierając emocjonalne potrzeby. Przykłady, takie jak PARO czy Character.AI, oraz popkulturowe obrazy z „Westworld” czy „Her”, pokazują ich potencjał, ale też ujawniają wyzwania. Przyszłość tych technologii zależy od równowagi między innowacją a etycznym projektowaniem, by wspierały człowieka, nie zastępując autentycznych relacji.

Gdy modele generatywne coraz skuteczniej udają towarzyszy, warto pamiętać, że sens rodzi się ze spotkania, nie z reżyserii. Dreszcz romansu, kreatywności, a nawet zwykłej zabawy zależy od możliwości, że ktoś powie „nie”, że świat odrzuci nasze plany. Bez tego zostaniemy sami z własnym odbiciem – doskonałą zabawką, doskonale nudną.

Następnym razem, gdy produkt obieca ci ostateczny, w pełni konfigurowalny wszechświat (lub bratnią duszę), zadaj sobie pytanie: Czy będzie wystarczająco realny, żeby miał znaczenie?

Literatura

Aldebaran Robotics. (n.d.). NAO the humanoid and programmable robot. https://www.softbankrobotics.com/emea/en/nao

Bates, B. (2024, October 23). Teen’s death linked to AI chatbot raises concerns about emotional safety. The Guardian. https://www.theguardian.com/technology/2024/oct/23/character-ai-chatbot-sewell-setzer-death

Character.AI. (2024). AI character platform overview. https://medium.com/@paowens59/character-ai-review-2024-the-future-of-interactive-conversations-c881339ec777

Dautenhahn, K. (2007). Socially intelligent robots: Dimensions of human–robot interaction. Philosophical Transactions of the Royal Society B: Biological Sciences, 362(1480), 679–704. https://doi.org/10.1098/rstb.2006.2004

LuxAI. (n.d.). QTrobot – A social robot for autism intervention. https://luxai.com/

Mori, M., MacDorman, K. F., & Kageki, N. (2012). The uncanny valley [from the field]. IEEE Robotics & Automation Magazine, 19(2), 98–100. https://doi.org/10.1109/MRA.2012.2192811

SoftBank Robotics. (2020). Pepper the robot. https://www.businessinsider.com/softbank-pepper-robot-coronavirus-japan-and-germany-2020-5?IR=T

YesChat.ai. (2024). HER AI Girlfriend – A new approach to digital companionship. https://www.yeschat.ai/blog-Introducing-HER-The-Revolutionary-AI-Girlfriend-Chatbot-Experience-4404

Z drugiej strony – „tradycyjne” usługi związane z pogrzebem i upamiętnianiem zmarłych są od dawna komercyjne i traktujemy je jako…