Rozwój sztucznej inteligencji otworzył przed ludzkością nowe możliwości, ale jednocześnie stworzył zagrożenia, których skali jeszcze do niedawna nikt nie przewidywał. Jednym z najbardziej niepokojących zjawisk jest wykorzystywanie technologii deepfake do tworzenia fałszywej pornografii z udziałem niczego nieświadomych osób, zarówno celebrytów, jak i zwykłych ludzi. Skala tego procederu rośnie lawinowo, a prawo w wielu krajach wciąż nie nadąża za tempem zmian.

Źródło: Wygenerowane przez ChatGPT

Deepfake i jego wykorzystanie w pornografii

W ostatnich latach zanotowano znaczący wzrost w wytworzonych fake’owych zdjęć czy filmów o tematyce seksualnej. Do takiego nasilenia sytuacji zdecydowanie przyczyniło się m.in. stworzenie i rozpowszechnienie narzędzi sztucznej inteligencji, które to stają się coraz bardziej przekonujące i prostsze w obsłudze dla szerokiej publiki. Właśnie w sytuacji, gdzie to za pomocą algorytmów AI tworzone są nowe „syntetyczne” media, mamy do czynienia z tzw. deepfake’ami, których nazwa pochodzi właśnie od połączenia słów głębokiego uczenia (deep learning) i podróbki (fake).

Do stworzenia nowego obrazu czy filmu za pomocą sztucznej inteligencji, tak naprawdę wystarczy bardzo niewiele — wyraźne zdjęcie osoby oraz około 25 minut z wybranym darmowym narzędziem AI. Taka dostępność do tworzenia tego typu contentu w połączeniu z naturą ludzką sprawiła, że aż 98% ze wszystkich tworzonych deepfake’ow to właśnie te o tematyce pornograficznej, co jest bardzo martwiącą statystyką. Skala zjawiska niesie za sobą automatyczne wiele problemów prawnych i etycznych, zwłaszcza biorąc pod uwagę, że zdecydowana większość osób będących w centrum generowanych treści nie wyraziła zgody na wykorzystanie w żaden sposób ich wizerunku, a co gorsza, jest nawet nieświadoma tego procesu.

Skala zjawiska

Tworzenie syntetycznych treści znacząco zwiększyło swoją skalę w ostatnich paru latach, dzięki rozwojowi technologii sztucznej inteligencji — między 2019 a 2023 zanotowano aż 550% wzrost w generowaniu tego typu treści, a pomiędzy 2022 a 2023 liczba wygenerowanych filmów o tematyce czysto erotycznej zwiększyła się o 464%. Jednakże tworzenie sztucznych obrazów czy filmów poprzez manipulacje prawdziwych nie jest niczym nowym, zagrożeniem natomiast nie jest oczywiście nowość zjawiska, a samo jego występowanie, oraz skala. Już dawniej tworzone były fałszywe treści na podstawie fotografii celebrytów, przez specyficzne grono fanów.

Dlatego też nie powinno nas dziwić, że w dzisiejszych czasach, gdzie technologia AI ułatwia tego typu działania, 94% z generowanych treści pornograficznych to te zorientowane wokół osób pracujących w przemyśle rozrywkowym, gdyż są to osoby znane przez szerokie grono fanów, a jak wiemy im szersza grupa ludzi, tym więcej tam jednostek o zaburzonych potrzebach, co może manifestować się np. nienaturalnym pożądaniem wybranej osoby, bądź wręcz wyobrażanie sobie posiadania z nią jakiejś relacji, ale to inny, lecz powiązany z naszym temat, czyli kwestia relacji parasocjalnych z celebrytami.

Niestety natomiast, duża część ludzi zainteresowanych potencjalnymi treściami pornograficznymi np. celebrytów nie ma tego typu zaburzeń czy złudzeń relacji, tylko „zwykłą ludzką ciekawość” zobaczenia kogoś sławnego w interesujący ich sposób. Tego typu wniosek mówi sporo o sposobie myślenia i moralności takich ludzi, ale jest to inna kwestia niż również popularne przypadki np. stalkowania celebrytów. Niezależnie od powodów chęci tworzenia czy doświadczania takich treści, ich istnienie wywołuje bardzo dużo negatywnych skutków dla ofiar, ale i dla całego społeczeństwa.

Jedną z ofiar tego typu działań jest znana wielu amerykańska piosenkarka Taylor Swift. W styczniu 2024 na platformie X (dawniej Twitter) z bardzo dużą prędkością rozprzestrzeniło się wiele fałszywych zdjęć artystki o wyraźnej tematyce seksualnej, zyskując ponad 45 milionów wyświetleń, przed ich ostatecznym usunięciem. Całe wydarzenie wywołało szeroką falę oburzenia, szczególnie wśród prawdziwych fanów piosenkarki, próbujących o własnych siłach bronić artystkę zalewając platformę pozytywnymi zdjęciami artystki i zgłaszając konta rozpowszechniające deepfake’i. Dodatkowo niektórzy amerykańscy politycy ponowili apele o pilne wprowadzenie regulacji umożliwiających ofiarom pozywanie sprawców rozpowszechniających tego typu sfałszowane treści na ich temat.

Nie tylko celebryci

Niestety nie tylko osoby świadomie pokazujące swój wizerunek publicznie w celach kariery padają ofiarą generowania pornografii na ich temat. Tak naprawdę każdy może zostać celem tego typu działań. Przykładem może być sytuacja, która zaistniała w Wielkiej Brytanii, gdzie 20 kobiet stało się celem cyfrowego przestępcy seksualnego, Brandona Tylera. Mężczyzna używał AI do wytworzenia pornografii kobiet, które znał, przedstawiając swoją „twórczość” w około 173 postach. Co gorsza, przy niektórych z nich zamieszczał personalne informacje ofiar, jak ich imiona i numery telefonu. Na szczęście, w tamtym casie prawo w Wielkiej Brytanii zostało już zaktualizowane, penalizując rozgłaszanie pornograficznych deepake’ów, przez co przestępca został skazany na 5 lat więzienia.

Źródło: Wygenerowane przez ChatGPT

Problem treści pornograficznych wygenerowanych przez sztuczną inteligencję celujący ściśle w osoby niepubliczne, pojawił się w Korei Południowej w ostatnim czasie na znacząco większą skalę. Warto wspomnieć, że ten kraj już nie pierwszy raz zmierza się z bardzo dużym problemem w kwestii przestępstw i nadużyć seksualnych — w latach 2010’ pojawił się problem ukrytych kamer molka, które były umieszczane w damskich publicznych toaletach czy pokojach motelowych w celu zebrania treści o charakterze seksualnym oczywiście bez wiedzy ofiar. W kwestii pornografii deepfake statystyki są porażające, ponieważ aż 53% treści o tej tematyce tworzonych na całym świecie to te, których centrum to południowo-koreańskie piosenkarki czy aktorki.

South Korea tops the list of these nations with a 53% rate of susceptibility to deepfake adult content. Other countries on the list include America at 20%, Japan at 10%, and England at 6%.

Niestety problem nie tyczy się tylko celebrytek. Jednym z najbardziej pokaźnych przykładów działań tego typu celujących w osoby niepubliczne, są koreańskie chatroom’y na Telegramie (komunikator internetowy), gdzie Koreańczycy, często w wieku szkolnym i studyjnym generowali za pomocą AI pornografię różnych dziewczyn, z danego kampusu, liceum czy nawet gimnazjum, czyli również osób niepełnoletnich. Chaty te, jak odkryto, były podzielone na różne uniwersytety w kraju, tak aby prościej było trafić na szukaną osobę. Często również były tworzone osobne czaty poświęcone właśnie na treści związane ściśle z konkretną ofiarą. Zdarzały się też sytuacje, gdzie osoby z otoczenia potencjalnej ofiary są angażowane w zebranie materiałów, zdjęć na jej temat w celach wykorzystania do wygenerowania pornografii. Niektóre z tworzonych chatroomów miało aż 220, a nawet 400 tysięcy członków. Tak duża skala zjawiska, sprawiła, że wiele kobiet zdecydowało się sprywatyzować bądź usunąć swoje zdjęcia z mediów społecznościowych, z obawy przed zostaniem kolejną ofiarą.

Większość jak nie wszyscy ludzie biorący udział w tym procederze są całkowicie świadomi tego, że to, co widzą, jest wygenerowane, ale nie ma to znaczenia. Istotne jest to, że mogą się nad daną dziewczyną znęcać psychicznie, poniżać ją, czuć się po prostu lepszym, lub najzwyczajniej w świecie zobaczyć taką osobę nago. Warto to podkreślić, gdyż w przypadku tego typu ludzi i sytuacji jakiekolwiek oznaczanie materiałów jako wygenerowane nie ma żadnego znaczenia, oni o tym dobrze wiedzą i im to nie przeszkadza, a nawet czuli się bezkarni. Problemem jest też często stosowane narzędzie do propagacji tego typu treści oraz organizowanie ich, czyli Telegram. Stworzony komunikator, jak mówi jego założyciel, w celu zachowania pełnej prywatności, tak aby ludzie w krajach autorytarnych mogli bezpiecznie komunikować się między sobą, bez narażenia się na odwety rządowe, coraz częściej wykorzystywany jest, dzięki swojemu skupieniu na prywatności, przez organizacje terrorystyczne, zorganizowane grupy przestępcze, czy właśnie przez grupy skupione dookoła deepfake pornografii. Warto wspomnieć, że to nie pierwszy raz w Korei Południowej, gdzie Telegram został użyty w celach przemocy seksualnej — innym przykładem jest sprawa „Nth Room”, gdzie ta platforma była używana do m.in. rozpowszechniania treści seksualnych i szantażowania ofiar.

Kwestie prawne

Kwestie prawne dotyczące tego tematu można podzielić na parę części, prawa dotyczące znieważenia, naruszenia własności intelektualnej, prywatności oraz cyberbezpieczeństwa. Każdy z wymienionych aspektów dotyczy kwestii generowania sztucznej pornografii, jednakże prawa te nie są w większości krajów wycelowane konkretnie w deepfake’s co stawia je w pewnego rodzaju szarej strefie.

W ciągu ostatnich paru lat Chiny wprowadziły nowy zestaw praw i regulacji dotyczący tematów deepfake-ów zatytułowany Personal Information Protection Law (PIPL), regulacje te mają na celu kryminalizację generowania materiałów na czyjejś podstawie bez zgody danej osoby, wymusza oznaczanie tak wygenerowanych materiałów, oraz weryfikację osób je postujących.

Unia Europejska również jest przodownikiem praw i regulacji dotyczących sztucznej inteligencji, większość z nich zawarta jest w Artificial Intelligence Act (AI Act) i Digital Services Act (DSA), jednakże żaden z tych aktów nie zawiera bezpośredniego wspomnienia o deepfake-ach, dotyczą one ogólnego zagrożenia systemów sztucznej inteligencji. Temat deepfake-ów jednak nie jest przez UE ignorowany, już w 2021 roku wydane zostało szeroko zakrojone badanie dotyczące zwalczania fałszerstw (deepfake-ów) w Unii Europejskiej, które przekrojowo przeanalizowało temat, jednakże jak wiemy, technologia idzie do przodu w niesamowitym tempie, więc nie wszystkie wnioski są wciąż tak aktualne jak były w czasie wydania.

Stany Zjednoczone natomiast są krajem który, pomimo swojej potencjalnie najważniejszej pozycji w temacie sztucznej inteligencji, nie ma do dziś federalnych legislacji i regulacji w tym temacie. Niektóre stany takie jak Kalifornia mają własne regulacje, które kryminalizują wytwarzanie oraz rozpowszechnianie deepfake-ów bez zgody osoby, która została do nich wykorzystana, jednakże regulacje te przez naturę federalnego systemu tego kraju nie są w stanie osiągnąć tak wiele, gdyż nie sięgają dalej niż konkretny stan.

Wielka Brytania również posiada własne, odrębne od europejskich regulacje dotyczące tego tematu, między innymi Online Safety Bill. Dotyczą one jednakże ogółu materiałów wytwarzanych w internecie i odpowiedzialności za krzywdę, jaką autor może powodować, co dotyczy również deepfake-ów, ale nie są to regulacje skierowane w nie konkretnie.

Z kolei w odpowiedzi na ostatnie drastyczne doniesienia o skali samego zjawiska w Korei Południowej, zaktualizowano tam Ustawę o szczególnych przypadkach dotyczących karania przestępstw seksualnych (Act on Special Cases Concerning the Punishment of Sexual Crimes). Wprowadzono m.in. ukaranie osób przyłapanych na posiadaniu, kupowaniu, przechowywaniu lub oglądaniu wygenerowanych bez zgody osoby przedstawionej treści seksualnych. Takie czyny będą teraz karane do 3 lat więzienia bądź 30 milionów wonów grzywny. Z kolei za tworzenie i dystrybucja takich treści będzie karana do nawet 7 lat więzienia, gdzie wcześniej było to tylko 5 lat.

Sposoby zapobiegania

Jak wymienione zostało powyżej, problem ten jest bardzo szeroki, coraz powszechniejszy oraz skomplikowany. Wiele krajów czy ich jednostek administracyjnych próbowało już zmierzyć się z problemem istnienia deepfake’ów, jednakże jak widać, efekty wciąż nie są zadowalające, treści pornograficzne korzystające z AI dalej powstają, i jest ich tylko coraz więcej.

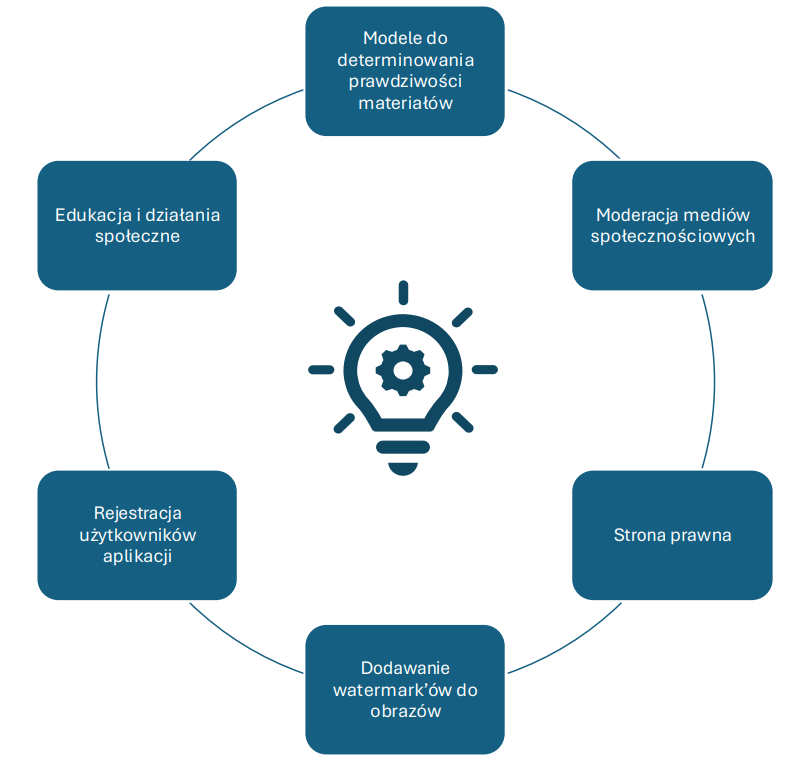

Źródło: Wygenerowane przez ChatGPT

Jedną z możliwych łatek na aktualny problem, to wykorzystanie np. lepszych modeli do determinowania prawdziwości materiałów, jednakże nie rozwiązuje to żadnego problemu. Wykrywanie sztuczności materiału nie jest pewne, musiałoby również być na bieżąco aktualizowane, a jedyne co uzyska, to prawdopodobne określenie, czy dane medium jest wygenerowane. Jednak ta informacja i tak nie dotrze do większości ludzi, którzy widzieli wcześniej dany deepfake, powodując, że straty wizerunkowe danej osoby i tak będą znaczące i trudne do zrekompensowania. Dodatkowo, analizując przytoczone wcześniej sytuacje wykorzystania wygenerowanych treści pornograficznych w celach prześmiewczych, można stwierdzić, że sam fakt tego, że dane medium nie jest prawdziwe, często po prostu nie ma znaczenia. Wielu ludzi jest tego całkowicie świadomych, wykorzystując tego typu materiały do zastraszania i znęcania się nad innymi. Dlatego też wykrywanie sztuczności danego medium nie rozwiązuje niczego, co najwyżej próbuje wylewać wiaderkiem wodę z łódki bez dna.

Kolejną możliwością jest próba ograniczenia dystrybucji takich materiałów, poprzez np. moderację mediów społecznościowych. Nie jesteśmy w stanie zatrzymać tworzenia takich materiałów, więc możemy, chociaż spróbować powstrzymać ich rozpowszechnianie na platformach społecznościowych. Jednakże jedyne co mogłoby to uzyskać to powstrzymanie szerokiej publiki od zobaczenia danego materiału, co nie jest raczej dla ofiar tego typu sytuacji wystarczające, nawet jeśli jest to oczywiście zdecydowanie lepsze niż brak jakiegokolwiek działania. Trzeba też wziąć pod uwagę, że jedyny sposób na niedopuszczenie wygenerowanych mediów do pojawienia się na mediach społecznościowych, to weryfikacja każdego posta przed możliwością upublicznienia, co jest niemożliwe od strony praktycznej, gdyż wymagałoby to niesamowitego nakładu pracy ogromnej ilości ludzi, jak i technicznej, ponieważ trudno jednoznacznie ocenić czy jakiś np. niekontrowersyjny materiał jest wygenerowany. Rozwiązanie to jest więc próbą leczenia efektów, a nie przyczyny, czyli próbą zamiecenia problemu pod dywan.

Kolejną możliwością jest strona prawna, czyli próba nadgonienia cyfrowego postępu technologicznego poprzez legislacje, które uregulowałyby działania przede wszystkim firm, których narzędzia są wykorzystywane do celów tworzenia, lub rozpowszechniania pornografii, jednakże prawo jest do tyłu z technologią cyfrową od lat i do dziś nie potrafi sobie poradzić z wieloma elementami świata cyfrowego, a co dopiero coś takiego jak deepfake-i. Jedną z opcji jest np. wymuszenie dodawania watermark’ów do stworzonych przy użyciu narzędzi deep-learning „dzieł”, a także obowiązkowa rejestracja użytkowników, tak aby prościej dało się zidentyfikować sprawcę, jednakże osoby doświadczone będą wiedzieć, jak coś takiego ominąć, usunąć, lub wykorzystać wcześniejsze wersje oprogramowania, które takich funkcjonalności nie miały. Wielokrotnie widać, że policja nie ma środków ani przeszkolenia do działań w znacząco prostszych sprawach cyfrowych, a co dopiero takich jak te, gdzie wykorzystywane są sztucznie wygenerowane treści pornograficzne do gnębienia ofiar. Wydaje się więc, że w kwestii prawnej jedyne co możemy zrobić to wspierać naszym głosem odpowiednie osoby, zwracając uwagę na istotność sytuacji, a następnie mieć złudną nadzieję, że prawo będzie w stanie nadgonić dekady zaniedbania legislacji cyfrowej, a także co jeszcze nieprawdopodobne w przypadku niektórych, najbardziej znaczących krajów w tym temacie, jak Stany Zjednoczone, postawić się cyfrowym korporacyjnym gigantom, co wydaje się nie być najbardziej prawdopodobną przyszłością.

Wydźwięk zaproponowanych potencjalnych rozwiązań tego problemu nie jest zbyt pozytywny, ale tak aktualnie wyglądają jedyne większe możliwości próby opanowania tego cyfrowego procederu. Jedyna prawdziwa zmiana, jaka byłaby w stanie pozbyć się generowanej sztucznie pornografii, z powodów pożądania, zemsty i każdego innego, to zmiana natury ludzkiej, gdyż to ona, a nie technologia jest winna temu wszystkiemu, bo jak zawsze, to człowiek zabija, a nie pistolet, a narzędzia generujące to dokładnie to, narzędzia.

Źródło: Opracowanie własne

Co więc może być zrobione? Edukacja ludzi i próba uzyskania zmian społecznych, co jest jednak bardzo skomplikowanym tematem, a prawdopodobieństwo uzyskania celowo jakiejś zmiany na skalę całego człowieczeństwa jest nikła, jednakże przy aktualnym zachowaniu społeczeństwa można odnieść wrażenie, że nie tylko prawo nie nadąża za technologią, ale i sam człowiek, a nasze mózgi nie są w żaden sposób przygotowane na życie we współczesnym świecie. Warto jednak nie zapominać, że niezależnie z jak trudnymi problemami mierzy się ludzkość, zawsze są ludzie gotowi zrobić, co tylko mogą, niezależnie jak bez znaczenia wydawać się mogą takie działania, aby walczyć z tym, co uważają za złe. Nie jest inaczej w tym temacie, i powstało wiele grup ludzi skupionych dookoła walki z generowaniem pornografii ludzi, a także z aktywizacją społeczeństwa w celu wywołania presji na rządach światowych w tym temacie. Jedną z takich kampanii jest ta stworzona przez twórców filmu dokumentalnego Another Body. Kampania My Image My Choice stara się właśnie wywrzeć wpływ na władzach i firmach IT w celu wprowadzaniu zmian. W tym celu stara się zwrócić uwagę na problem, poprzez szerzenie historii ofiar przemocy i zwiększanie świadomości w tym temacie oraz próbuje wywierać realny wpływ na tworzone polityki, czego rezultatem było m.in. uwzględnienie problemu przemocy związanej z deepfake’ami w AI Executive Order podpisanego przez byłego prezydenta Stanów Zjednoczonych Joe Bidena. Historie opowiedziane w ramach tej kampanii miały również realny wpływ na Online Safety Bill w Wielkiej Brytanii, wprowadzającym m.in. penalizację rozpowszechniania bez zgody deepfake’ów o charakterze seksualnym. Więcej informacji na temat działania kampanii można znaleźć na stronie MyImageMyChoice.

The problem doesn’t lie with technology, but how we use it.

Podsumowanie

Technologia deepfake, umożliwiająca tworzenie realistycznych, ale całkowicie fałszywych materiałów wideo i zdjęć, stała się narzędziem do masowego tworzenia pornografii bez zgody osób przedstawionych. Zjawisko to dotyka głównie kobiet i rozprzestrzenia się globalnie, poczynając od znanych artystek po w dużej mierze uczennice, studentki i współpracownice. Obecne regulacje prawne są w większości krajów niewystarczające, a technologia rozwija się znacząco szybciej niż prawo. Proponowane środki zaradcze, takie jak moderacja treści, oznaczanie materiałów czy nowe legislacje, napotykają na ograniczenia techniczne i społeczne oraz są po prostu zbyt wolne. Ostatecznie to nie tylko problem technologiczny, lecz także moralny, wymaga on głębokiej zmiany społecznej świadomości, podejścia i edukacji jeśli chcemy mieć jakąkolwiek nadzieję na poradzenie sobie z tą sprawą.

Literatura

- What is deepfake pornography?

- State of deepfakes

- Deepfake porn why we need to make it a crime to create it not just share it

- Legal Protection of Revenge and Deepfake Porn Victims in the European Union: Findings From a Comparative Legal Study

- Deepfake Porn Is Leading to a New Protection Industry Regulations haven’t caught up to this new kind of sexual abuse

- Deepfakes and the Future of AI Legislation: Overcoming the Ethical and Legal Challenges

- Government cracks down on ‘deepfakes’ creation

- South Korea confronts a deepfake crisis

- South Korean Cabinet approves bill revision to punish possessing, watching deepfake porn

- South Korean Cabinet Approves Bill to Criminalize Viewing, Possessing Deepfake Porn

- Dokument Unii Europejskiej „Tackling deepfakes in European policy”

- Dokument Europolu „Facing reality? Law enforcement and the challenge of deepfakes”

- Taylor Swift and the Dangers of Deepfake Pornography

- Deepfake porn is destroying real lives in South Korea

- From spy cams to deepfake porn: fury in South Korea as women targeted again

- EPIDEMIA DEEPFAKE W KOREI POŁUDNIOWEJ

- Man jailed for using AI to create deepfake porn

- #MYIMAGEMYCHOICE

[…] poprzednim artykule skupiliśmy się na seks robotach w ogólności, a także na najpopularniejszej formie tego […]