Fake newsy to fałszywe lub wprowadzające w błąd informacje. Ich publikacja nie jest nowym zjawiskiem. Wraz ze wzrostem znaczenia środków masowego przekazu dezinformacja także zyskała na znaczeniu. W dobie internetu dostępne są bezprecedensowe możliwości rozprzestrzenianiu fake newsów. Sieci botów na mediach społecznościowych mogą z wykorzystaniem sztucznej inteligencji tanio generować rzędy wielkości więcej treści niż normalni użytkownicy w celu wybranym przez osobę lub organizację nimi zarządzającą.

Rys historyczny propagandy i dezinformacji

Pierwsza wojna światowa była pierwszą wojną, w której masowe media i propaganda odgrywały znaczącą rolę w informowaniu społeczeństwa z dala od linii frontu o stanie konfliktu. Ponadto była także pierwszą wojną, w której rządy systematycznie produkowały propagandę skierowaną do szerokiej publiki w celu kształtowania opinii.

Rys. 1. Przykłady propagandy z I wojny światowej: amerykański dehumanizujący plakat straszący nawołujący do wstąpienia do armii oraz niemiecki plakat promujący zakup obligacji wojennych

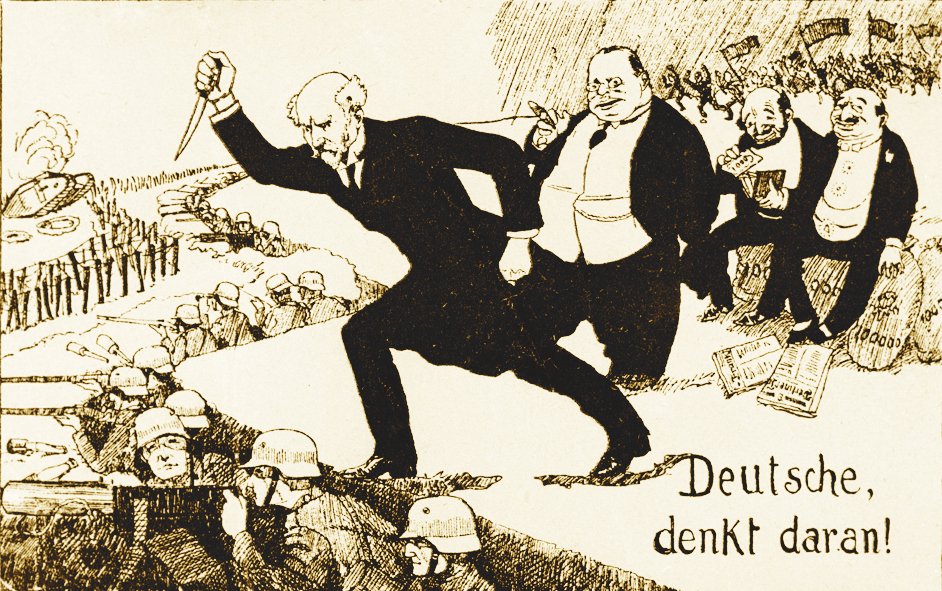

Miało to tragiczne skutki. Przykładowo jednym z głównych celów niemieckiej propagandy było prezentowanie państw centralnych jako wygrywających wojnę, a ich wygranej jako nieuniknionej. Wygrana miała być tylko kwestią czasu. Gdy w ostatnich miesiącach wojny rzeczywistość zapukała do drzwi, niemieckie społeczeństwo nie mogło uwierzyć w to co się dzieje. Dlaczego mimo ciągłych zwycięstw doszło do zawieszenia broni, podpisania traktatu wersalskiego i kapitulacji? Skoro niemiecka armia była niepokonana na polu bitwy, ktoś inny musiał być odpowiedzialny za porażkę. Wskazano na republikańskich polityków, socjalistów i żydów jako winnych i w ten sposób narodził się mit stab-in-the-back. Ta teoria konspiracyjna stała się integralną częścią rewizjonizmu historycznego nazistów i przez powszechną jej akceptację jako prawdziwą pomogła im dojść do władzy w 1933 roku.

Rys. 2. Propaganda niemiecka po I wojnie światowej ukazująca „cios w plecy” zadany walczącym żołnierzom przez polityków, żydów i elity. Napis: „Niemcy, pamiętajcie o tym!”

Źródła informacji i ich odbiór w społeczeństwie polskim

CBOS w badaniu z 2023 roku zapytał Polaków o to skąd przede wszystkim czerpią informacje o tym co dzieje się w kraju i na świecie. 49% z nich wskazało telewizję, a 37% internet.

Rys. 3. Udział poszczególnych źródeł informacji wśród Polaków – dane CBOS 2023

Deklaracje badanych najbardziej różnicuje wiek, gdzie zmienia się częstość wskazywania internetu od 76% w grupie wiekowej 18–24 lata do 7% w grupie wiekowej 65+, oraz telewizji od 9% w grupie wiekowej 18–24 lata do 83% w grupie 65+.

Młodzi charakteryzują się także wyższym odsetkiem osób konsumujących informacje przede wszystkim z mediów społecznościowych.

Tab. 1. Źródła informacji w podziale na grupy wiekowe – dane CBOS 2023

Strategie wykrywania fake newsów

Wykrywanie fake newsów wymaga stosowania różnych strategii – zarówno manualnych, jak i zautomatyzowanych. Jedną z podstawowych metod jest ręczna weryfikacja faktów (fact-checking). Polega ona na analizie treści medialnych i porównywaniu ich z wiarygodnymi źródłami w celu potwierdzenia lub obalenia zawartych w nich twierdzeń. Przykładami organizacji specjalizujących się w tej metodzie są m.in. Demagog, PolitiFact, AFP czy Snopes. Mimo precyzyjności, metoda ta ma poważne ograniczenia – jest czasochłonna, kosztowna i trudna do skalowania.

W odpowiedzi na skalę zjawiska coraz większą rolę odgrywają zautomatyzowane techniki wykrywania dezinformacji:

- Analiza językowa (NLP – Natural Language Processing): Wykorzystywane są modele językowe (np. BERT, RoBERTa) do analizy cech tekstu, takich jak:

- alarmistyczny lub emocjonalny ton wypowiedzi,

- clickbaitowy język,

- brak spójności logicznej lub wewnętrzne sprzeczności,

- użycie określonych słów kluczowych (np. „pilne!”, „nie chcą, żebyś wiedział!”).

- Modele klasyfikacyjne oparte na uczeniu maszynowym: Algorytmy takie jak Random Forest, SVM czy sieci neuronowe uczą się na dużych zbiorach danych oznaczonych jako prawdziwe/fałszywe, aby automatycznie klasyfikować nowe treści. Często korzystają z transfer learningu – przenoszenia wiedzy z dużych modeli językowych.

- Analiza reputacji źródeł: Wykorzystuje się listy zaufanych lub podejrzanych domen (tzw. białe i czarne listy), oceny dostarczane przez niezależnych weryfikatorów lub społeczność, a także metadane źródła (np. czy domena została niedawno zarejestrowana lub zawiera typowo dezinformacyjne frazy).

- Wykrywanie sieci botów i kont fałszywych: Analizując sieci społecznościowe można wykryć konta działające w sposób zautomatyzowany (boty) na podstawie takich cech jak:

- częstotliwość i regularność publikowania,

- brak interakcji z innymi użytkownikami,

- schematy wzajemnego udostępniania treści wśród powiązanych kont.

- Analiza dynamiki rozprzestrzeniania informacji: Fake newsy często rozchodzą się w sposób charakterystyczny – szybko, w zamkniętych grupach i przy udziale tych samych kont. Narzędzia takie jak Hoaxy czy Botometer pozwalają wizualizować ścieżki rozprzestrzeniania treści i identyfikować źródła pierwotne.

- Detekcja emocji i polaryzacji: Treści dezinformacyjne mają tendencję do wywoływania silnych reakcji. Analiza sentymentu i emocji (np. gniew, strach, nienawiść) w tekście może być pomocna w ich wykrywaniu.

W praktyce skuteczne strategie wykrywania fake newsów łączą kilka z powyższych metod w ramach hybrydowych systemów opartych na sztucznej inteligencji. Przykładem może być system, który klasyfikuje treści jako potencjalnie fałszywe, a następnie przekazuje je do ręcznej weryfikacji przez zespół fact-checkerów.

Wyzwania i ograniczenia technik wykrywania dezinformacji

Mimo rosnącej skuteczności narzędzi opartych na sztucznej inteligencji oraz rozwiniętych metod analitycznych, wykrywanie dezinformacji w mediach społecznościowych napotyka szereg istotnych wyzwań:

- Skalowalność a dokładność: Systemy automatyczne pozwalają analizować miliony postów w krótkim czasie, ale często odbywa się to kosztem precyzji. Wysoki odsetek wyników fałszywie pozytywnych (false positives) lub fałszywie negatywnych (false negatives) obniża zaufanie do narzędzi wykrywających.

- Zmienność form dezinformacji: Fake newsy ewoluują. Zamiast jaskrawego kłamstwa coraz częściej spotyka się subtelne manipulacje, półprawdy, wyrwane z kontekstu cytaty lub zmanipulowane obrazy i wideo (deepfakes), które są trudniejsze do wychwycenia.

- Język i kontekst kulturowy: Modele NLP często działają dobrze w języku angielskim, ale znacznie słabiej w innych językach, w tym w polskim. Dodatkowo, algorytmy mają trudność z uwzględnianiem niuansów kulturowych, ironii, sarkazmu czy lokalnych kontekstów politycznych.

- Problemy z etykietowaniem danych: Modele uczone są na oznaczonych zbiorach danych. Jednak ocena, co jest prawdą, a co fałszem, bywa subiektywna – szczególnie w kwestiach politycznych, ideologicznych czy światopoglądowych.

- Etyka moderacji: Zbyt agresywna moderacja treści oznaczonych jako dezinformacja może prowadzić do oskarżeń o cenzurę, tłumienie wolności słowa lub stronniczość polityczną. Platformy społecznościowe balansują między odpowiedzialnością, a zarzutami o ograniczanie debaty publicznej.

- Adaptacja twórców dezinformacji: Twórcy fake newsów aktywnie śledzą i testują algorytmy wykrywające. Używają technik takich jak parafrazowanie, zmiana słownictwa czy maskowanie źródeł, aby obejść systemy detekcji.

- Brak transparentności platform: Firmy technologiczne (np. Meta, X, TikTok) często nie udostępniają szczegółowych danych na temat funkcjonowania swoich algorytmów rekomendacji, zasięgów postów czy mechanizmów moderacji, co utrudnia niezależne badania i ocenę skuteczności wykrywania dezinformacji.

Analiza aktywności botów w mediach społecznościowych na przykładzie Twittera

Analiza interakcji botów i ludzi na Twitterze związanych z procesem impeachmentu Donalda Trumpa podczas pierwszej kadencji ilustruje charakterystykę, działanie i wpływ botów na mediach społecznościowych.

Wybrano konta dyskutujące o tym procesie i podzielono je na grupy: anty- i pro-Trump, czy wierzy w QAnon oraz czy są operowane przez ludzi, czy boty. Do klasyfikacji zebrano ich posty, profile oraz obserwowane konta. Na ich podstawie w 3 krokach przypisywano do grup:

- factor graph decydował o tym czy konto jest operowane przez bota; sprawdzano częstotliwość retweetów oraz sieci powiązań między kontami (boty charakteryzują się wyższą częstotliwością retweetów oraz grupowym działaniem)

- przynależność pro- i anty-Trump określano za pomocą transformatora BERT, gdzie jako źródło prawdy wybrano zbiór tweetów, do których przypisano afiliację polityczną

- poparcie dla QAnon sprawdzano przez słowa kluczowe na profilach

Tab. 2. Odsetek kont i tweetów w zależności od poparcia Trumpa, sposobu prowadzenia konta (tj. bot/człowiek) oraz poparcia QAnon

Dzięki takiej klasyfikacji można wyciągnąć wnioski o działaniu tych grup. Boty stanowią mały procent pro- i anty-Trump użytkowników, jednak wśród wspierających QAnon bot to już co dziesiąty użytkownik, więc o rząd wielkości więcej. Boty publikują także znacznie więcej treści niż ludzie (prawie dwa rzędy wielkości wśród pro- i anty-Trump ludzi i prawie rząd wielkości wśród Qanon ludzi).

Rys. 4. Wykres części użytkowników, które są botami (po lewej) oraz częstotliwości udostępniania tweetów (po prawej) wg. typu konta

Co ciekawe boty udostępniają artykuły o niewiele niższej wiarygodności niż odpowiadająca ich afiliacji grupy ludzi i charakteryzują się niższym poziomem toksyczności niż ludzie. Autorzy artykułu wywnioskowali, że boty skupiają się na rozprzestrzenianiu informacji o niższej jakości niż ich ludzkie odpowiedniki, ale nie agitowały ludzi swoimi postami.

Rys. 5. Porównanie wiarygodności i toksyczności treści udostępnianych przez boty i ludzi

Inne są też źródła repostowanych źródeł wypowiedzi, gdzie wśród botów podszywających się pod Demokratów udostępniane są wpisy politycznych publicystów, a wśród botów Republikańskich duża część wpisów pochodzi od wybranych polityków.

Rys. 6. Źródła tweetów udostępnianych przez boty podszywające się pod Demokratów i Republikanów

Badając sieć obserwujących można zauważyć, że w odróżnieniu od grup pro- i anty-Trump struktura wsperających QAnon jest hierarchiczna. Ludzie followują głównie boty (a nie innych ludzi – nie wchodzą z nimi w interakcję) i boty stanowią główne źródło informacji.

Rys. 7. Struktura sieci społecznościowej użytkowników wspierających QAnon – dominacja botów

Za pomocą analizy generalized harmonic influence centrality (GHIC) można zbadać wpływ botów na opinie ludzi.

Rys. 8. Wpływ botów na kształtowanie opinii użytkowników według metody GHIC

Rys. 9. Skuteczność perswazji botów w zależności od afiliacji politycznej

Boty pro- i anty-Trump zależnie od aktualnych wydarzeń przekonują więcej lub mniej osób do promowanych przez siebie opinii. Jednak boty QAnon mają niewielki wpływ na zmianę opinii – głównie robią kazania dla osób już się z nimi zgadzających.

Przykłady wpływu dezinformacji w praktyce

Wybory prezydenckie 2025 – nowoczesne formy dezinformacji i zagraniczne ingerencje

W trakcie kampanii prezydenckiej w 2025 roku Polska doświadczyła zaawansowanych operacji dezinformacyjnych, które wykorzystywały nowoczesne technologie i strategie wpływu:

- Deepfake’i i generatywna AI: W sieci pojawiły się zmanipulowane nagrania wideo i audio, przedstawiające kandydatów w kompromitujących sytuacjach lub wypowiadających kontrowersyjne opinie. Celem tych materiałów było podważenie wiarygodności polityków oraz wywołanie emocjonalnych reakcji wśród wyborców.

Film 1. Karol Nawrocki grający na harmonijce – wykorzystany kadr z debaty prezydenckiej przed II turą wyborów w 2025 roku

- Operacja „Doppelganger”: Rosyjskie działania dezinformacyjne obejmowały tworzenie fałszywych stron internetowych, podszywających się pod renomowane media, w celu rozpowszechniania zmanipulowanych treści. Często łączono prawdziwe informacje z fałszywymi, aby zwiększyć ich wiarygodność i zasięg.

- Narracje podważające uczciwość wyborów: W mediach społecznościowych rozpowszechniano teorie spiskowe sugerujące, że wybory zostaną sfałszowane lub że udział w głosowaniu jest bezcelowy. Takie działania miały na celu zniechęcenie obywateli do udziału w wyborach i osłabienie zaufania do demokratycznych procesów.

Rys. 10. TVN24 ostrzegający o krążącym w internecie filmiku pokazującym, że w lokalach wyborczych długopisy są rzekomo zmazywalne

- Dezinformacja na temat imigrantów: Wykorzystywano tematykę migracyjną do wzbudzania lęków społecznych, sugerując m.in., że imigranci otrzymują nieuzasadnione przywileje lub że ich obecność zagraża bezpieczeństwu kraju.

Film 2. Wypowiedź Małgorzaty Wasserman, polityk PiS, opowiadająca o akcie terroryzmu w krakowskim tramwaju, którego doświadczyła jej mama

- Wykorzystanie mediów społecznościowych: Platformy takie jak TikTok, Facebook czy X (dawniej Twitter) były wykorzystywane do szybkiego rozpowszechniania fałszywych informacji, często za pomocą botów i fałszywych kont, co utrudniało identyfikację źródeł dezinformacji.

Rys. 11. Rolka na Facebooku z wypowiedzi Grzegorza Brauna, który mówi o ułaskawieniu go w zamian za przekazanie głosów jego wyborców dla Rafała Trzaskowskiego

Te przykłady pokazują, jak zaawansowane i zróżnicowane mogą być współczesne kampanie dezinformacyjne, szczególnie w kontekście wyborów, gdzie stawką jest kształtowanie opinii publicznej i wpływ na decyzje wyborców.

Pandemia COVID-19 – dezinformacja zagrażająca zdrowiu publicznemu

W trakcie pandemii COVID-19 rozpowszechniano wiele fałszywych informacji, które miały bezpośredni wpływ na zachowania zdrowotne ludzi. Przykłady obejmowały twierdzenia, że wirusa nie ma, że szczepionki zawierają mikrochipy lub powodują bezpłodność, czy też że picie wybielacza może zapobiec infekcji. Światowa Organizacja Zdrowia (WHO) i rządy państw określiły to zjawisko mianem „infodemii” – równoległej epidemii dezinformacji. Badania wykazały, że kraje o wyższym poziomie dezinformacji miały niższy poziom wyszczepialności oraz wyższe wskaźniki śmiertelności.

W odpowiedzi na rosnącą skalę dezinformacji, polski rząd uruchomił specjalną sekcję na portalu gov.pl: Dementujemy nieprawdziwe informacje. Strona ta miała na celu obalanie najczęściej powtarzanych mitów na temat szczepień przeciw COVID-19, takich jak rzekome niebezpieczeństwo szczepionek, ich nieskuteczność czy teorie spiskowe dotyczące ich składu. Zawierała również formularz umożliwiający obywatelom zgłaszanie fałszywych informacji znalezionych w internecie. Dzięki temu obywatele mogli aktywnie uczestniczyć w walce z dezinformacją, a rząd miał możliwość szybszego reagowania na pojawiające się nieprawdziwe treści.

Strona była częścią szerszej kampanii informacyjnej „#SzczepimySię”, która miała na celu zwiększenie świadomości społecznej na temat szczepień oraz przeciwdziałanie rozprzestrzenianiu się fałszywych informacji. Inicjatywa ta była istotnym elementem strategii komunikacyjnej rządu w walce z pandemią i dezinformacją.

Farmy botów i trolli – zorganizowane kampanie wpływu

Farmy botów to zautomatyzowane sieci kont wykorzystywane do wzmacniania określonych narracji. Ich działanie nie ogranicza się do udostępniania treści – często angażują się w masowe komentowanie, lajkowanie oraz atakowanie przeciwnych poglądów. Znane są przypadki rosyjskich farm trolli (np. IRA – Internet Research Agency) wpływających na wybory w USA w 2016 roku. W Polsce ujawniono sieci kont związane z próbami manipulowania nastrojami wokół uchodźców i wojny w Ukrainie. Charakterystyczne cechy to m.in. brak aktywności prywatnej, jednorodna tematyka postów i powiązania między kontami.

Fox v. Dominion

W 2023 roku stacja Fox News zgodziła się zapłacić firmie Dominion Voting Systems prawie 800 milionów USD, aby uniknąć rozprawy w procesie sądowym, który wykazałby celowe rozpowszechnianie dezinformacji na temat wyborów prezydenckich w Stanach w 2020 roku. Pozwoliło to stacji uniknąć publicznego zeznawania w sprawie. Wydali jedynie stanowisko, że “niektóre twierdzenia na temat Dominion były fałszywe”, ale nie wydano żadnych przeprosin.

Aby wyobrazić sobie kwotę, którą Fox zdecydował zapłacić można zestawić ją z prawie 3 miliardami USD przychodów (zysk netto – bez kosztów takich jak podatki, pensje pracowników itd.) za poprzedni rok, co stanowi około jednej czwartej tej wartości.

W akcie oskarżenia Dominion twierdziło, że Fox News działało w złej wierze lub z rażącym zlekceważeniem prawdy. Załączono także przykłady wewnętrznej komunikacji pomiędzy pracownikami pokazującymi intencjonalność działania. Dostęp do niej jest publicznie dostępny w akcie oskarżenia.

Była to druga największa kara odszkodowania za zniesławienie w historii. Po Alex Jones v. Sandy Hook families (1.4 miliarda USD), przed ABC News v. Beef Products Inc (177 milionów USD).

Pomimo zapłaconej kwoty stacja Fox nie spotkała się z konsekwencjami jakich możnaby się spodziewać. Zaledwie jedna piąta oglądających stwierdziła, że po ujawnieniu sprawy ufa Fox mniej, a tylko 9% ograniczyło konsumpcję treści od tej stacji, a ponad połowa wśród osób zaznajomionych ze sprawą twierdzi, że ufa Fox tak jak wcześniej. Fox pozostaje najchętniej wybieraną stacją informacyjną.

Rys. 12. Średnia oglądalność głównych stacji kablowych w USA w wieku 25–54 lat (primetime i cała doba)

Podsumowanie i wnioski

W dobie powszechnego dostępu do informacji i dynamicznego rozwoju technologii, dezinformacja stała się jednym z największych wyzwań dla współczesnych społeczeństw. Obecnie, podczas trwających wyborów prezydenckich w Polsce w 2025 roku, obserwujemy nasilone działania dezinformacyjne, które mają na celu manipulowanie opinią publiczną i wpływanie na decyzje wyborców. Przykłady takie jak operacja „Doppelganger”, polegająca na tworzeniu fałszywych stron internetowych podszywających się pod renomowane media, czy rozpowszechnianie zmanipulowanych nagrań wideo i audio z udziałem kandydatów, pokazują, jak zaawansowane i niebezpieczne mogą być współczesne kampanie dezinformacyjne.

W odpowiedzi na te zagrożenia, instytucje takie jak NASK oraz Ministerstwo Cyfryzacji prowadzą działania mające na celu ochronę procesu wyborczego przed dezinformacją. Programy edukacyjne, kampanie społeczne oraz monitoring treści w mediach społecznościowych to tylko niektóre z inicjatyw mających na celu zwiększenie świadomości społecznej i przeciwdziałanie rozprzestrzenianiu się fałszywych informacji. Poniższy film prezentuje ostatnią kampanię Ministerstwa Cyfryzacji i NASKu, w której apelują o aktywne zaangażowanie się w walkę z dezinformacją.

Film 3. Najnowsza kampania NASK i Ministerstwa Cyfryzacji – “Nie bądź internetowym trollem”

Jednakże, niezależnie od działań instytucjonalnych, każdy obywatel ma kluczową rolę w walce z dezinformacją. Weryfikacja źródeł informacji, krytyczne myślenie oraz ostrożność w udostępnianiu treści w internecie są niezbędne, aby chronić się przed manipulacją i fałszywymi narracjami. Pamiętajmy, że nasze decyzje wyborcze powinny opierać się na rzetelnych i sprawdzonych informacjach, a nie na emocjonalnych reakcjach wywołanych przez nieprawdziwe treści.

W obliczu obecnych wyzwań, edukacja medialna i rozwijanie umiejętności cyfrowych stają się fundamentem zdrowej demokracji. Tylko poprzez wspólne działania społeczeństwa, mediów i instytucji państwowych możemy skutecznie przeciwdziałać dezinformacji i chronić integralność naszych procesów demokratycznych.

Literatura

-

CBOS. (2023). Zaufanie społeczne (Komunikat z badań Nr 68/2023). Centrum Badania Opinii Społecznej. https://www.cbos.pl/SPISKOM.POL/2023/K_068_23.PDF

-

Court of Chancery of the State of Delaware. (2023). Redacted version of the Court’s opinion on motions for summary judgment in Dominion Voting Systems v. Fox News Network, LLC. https://courts.delaware.gov/Opinions/Download.aspx?id=345820

-

Fisher, L. (2023, April 12). Bigger libel payouts: Why defamation damages are on the rise. Press Gazette. https://pressgazette.co.uk/media_law/bigger-libel-payouts/

-

Mascaro, L. (2023, April 17). Fox News-Dominion trial: Big stakes for defamation law and media. AP News. https://apnews.com/article/fox-news-dominion-lawsuit-trial-trump-2020-0ac71f75acfacc52ea80b3e747fb0afe

-

Moran, G. (2023, March 30). Fox News viewers trust the network less after Dominion revelations, poll shows. Variety. https://variety.com/2023/tv/news/fox-news-dominion-lawsuit-viewers-less-trust-1235554399/

-

Parks, P. (2023). Weaponized defamation suits: Strategic litigation, press freedom, and the Fox-Dominion case. National Center for Biotechnology Information (NCBI). The Yale Law Journal, 132(5), 1421–1458. https://pmc.ncbi.nlm.nih.gov/articles/PMC10166499/

-

Wilson, C., & Howard, P. N. (2022). Bots, disinformation, and the first impeachment of US President Donald Trump. ResearchGate. https://www.researchgate.net/publication/360062617_Bots_disinformation_and_the_first_impeachment_of_US_President_Donald_Trump