Czym są fake newsy i dlaczego są niebezpieczne?

Fake newsy, czyli fałszywe informacje rozpowszechniane w formie wiadomości, to celowo wprowadzające w błąd treści, które podszywają się pod wiarygodne źródła. Ich forma może być różnorodna: od całkowicie zmyślonych artykułów, poprzez zmanipulowane cytaty, po wyrwane z kontekstu fakty.

Cele fake newsów

Główne motywacje stojące za produkcją fake newsów to:

- Manipulacja opinią publiczną, szczególnie w okresach wyborczych – Fałszywe informacje są wykorzystywane do wpływania na wyniki wyborów poprzez osłabienie wiarygodności przeciwników, wzmacnianie podziałów społecznych i mobilizowanie określonych grup wyborców.

- Zwiększenie ruchu internetowego na stronach – Sensacyjne i emocjonalne fake newsy przyciągają uwagę użytkowników, co zwiększa liczbę odsłon i generuje większe przychody z reklam. Taka motywacja sprawia, że wiele portali publikuje fałszywe treści tylko po to, by zarobić.

- Zmniejszenie wiarygodności do instytucji, mediów czy nauki – Rozpowszechnianie dezinformacji osłabia zaufanie społeczne do rzetelnych źródeł informacji, takich jak instytucje publiczne czy nauka. To prowadzi do chaosu informacyjnego i destabilizacji społecznej.

- Szerzenie ideologii lub propagandy – Fake newsy mogą być narzędziem do promowania określonych ideologii lub przekonań, często w skrajnej formie. Propaganda taka wzmacnia grupy zwolenników i przeciwników oraz może prowadzić do polaryzacji oraz wzrostu nienawiści.

Niebezpieczeństwa fake newsów

W świecie, w którym dostęp do informacji mamy na wyciągnięcie ręki, fałszywe wiadomości rozprzestrzeniają się szybciej niż kiedykolwiek wcześniej. Z pozoru mogą wyglądać niewinnie – mylący nagłówek, przesadna historia, niepotwierdzony cytat. Ale skutki fake newsów mogą być bardzo poważne. Dlaczego?

- Wpływają na to, jak myślimy i głosujemy – Fake newsy bardzo często pojawiają się w okresach wyborczych i są jednym z narzędzi manipulacji opinią publiczną. Przez codziennie sensacyjne „newsy” o kandydatach, których nie sposób od razu zweryfikować można łatwo paść ofiarą dezinformacji. To oznacza, że decyzje podejmowane podczas głosowań wyborczych mogą opierać się nie na faktach, ale na kłamstwach.

- Mogą szkodzić zdrowiu i życiu – Jedna z najgroźniejszych form fake newsów. Może sprawić, że ludzie zrezygnują z leczenia lub podejmą ryzykowne decyzje. Na przykład: W Indiach w 2020 roku rozeszła się plotka, że picie alkoholu chroni przed koronawirusem – przez co wiele osób zatruło się skażonym alkoholem domowej roboty. Dezinformacja na temat szczepień przez co ludzie przestają się szczepić, co prowadzi do powrotu chorób zakaźnych, takich jak odra.

- Polaryzacja społeczna – Fake newsy są często formułowane w sposób emocjonalny i prowokacyjny, co skutkuje wzrostem napięć społecznych. Podsycają one konflikty kulturowe, dzieląc społeczeństwo na przeciwstawne obozy. W skrajnych przypadkach mogą przyczyniać się do agresji werbalnej a nawet do przemocy fizycznej.

- Trwałość fałszywych przekonań – Nawet po jednoznacznym wykryciu fałszywej informacji, jej wpływ może się utrzymywać. Sprawia to, że wielokrotnie powtarzane informacje – nawet jeśli nieprawdziwe – są częściej uznawane za wiarygodne. Oznacza to, że skutki działania fake newsów mogą być trudne do odwrócenia, szczególnie wśród osób mniej krytycznie podchodzących do konsumpcji informacji.

Przykłady

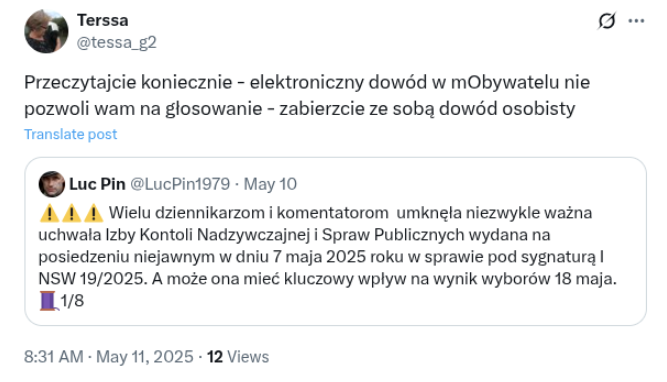

- W wyborach nie można legitymować z aplikacją mObywatel

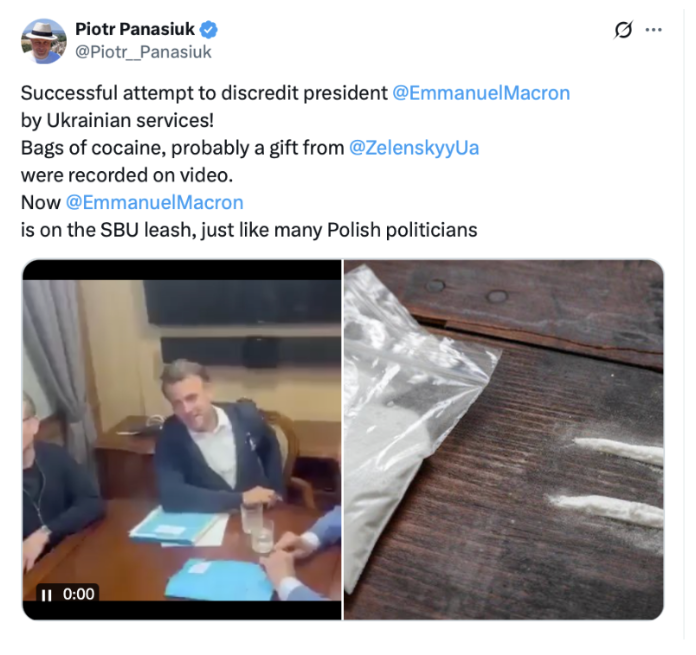

- Europejscy przywódcy zażywają narkotyki w pociągu

Metody lingwistyczne wykrywania fake newsów

Współczesne badania nad dezinformacją coraz częściej zwracają uwagę na charakterystyczne właściwości językowe fałszywych wiadomości. Analiza stylu, składni czy doboru słownictwa pozwala nie tylko lepiej zrozumieć mechanizmy oddziaływania fake newsów, ale także stanowi fundament dla rozwoju narzędzi automatycznej identyfikacji nieprawdziwych treści. Zastosowanie nowoczesnych technik przetwarzania języka naturalnego (NLP) umożliwia wykrywanie subtelnych wzorców stylistycznych i leksykalnych, które często umykają tradycyjnej ocenie. W efekcie metody lingwistyczne stają się jednym z kluczowych elementów skutecznej walki z dezinformacją w środowisku cyfrowym.

Analiza cech językowych i stylu

Teksty zawierające fałszywe informacje często odznaczają się podwyższonym stopniem emocjonalności oraz stosowaniem języka mającego na celu wzbudzenie silnych reakcji odbiorców. Tego rodzaju przekazy charakteryzują się również nadużywaniem ogólników, hiperboli oraz sformułowań o niskiej precyzji. Często występują w nich błędy gramatyczne, ortograficzne lub logiczne, które mogą świadczyć o niskiej jakości źródła informacji.

Nagłówki fake newsów bywają szczególnie manipulacyjne, a ich ton jest zwykle bardziej sensacyjny niż treść, co ma na celu przyciągnięcie uwagi odbiorcy. Na poziomie strukturalnym zaobserwowano różnice w długości zdań, stopniu złożoności składni oraz częstotliwości użycia określonych kategorii słów, takich jak przymiotniki, przysłówki czy wyrażenia oceniające. Analiza tych cech pozwala na efektywne różnicowanie tekstów fałszywych od wiarygodnych.

Zastosowanie uczenia maszynowego i modeli językowych

Współczesne podejścia do wykrywania dezinformacji coraz częściej opierają się na technikach uczenia maszynowego, w tym na głębokich sieciach neuronowych. Szczególnie skuteczne okazują się modele analizujące sekwencje językowe, takie jak dwukierunkowe rekurencyjne sieci neuronowe (BRNN), które umożliwiają uwzględnienie kontekstu słów w obu kierunkach tekstu.

Modele te uczą się wzorców charakterystycznych dla fake newsów, korzystając z reprezentacji takich jak n-gramy, miary częstotliwości (np. TF, TF-IDF) oraz osadzenia słów (word embeddings). Dzięki temu osiągają bardzo wysoką skuteczność klasyfikacji, sięgającą nawet 90–99% dokładności w testach na zbiorach danych zawierających oznaczone przykłady prawdziwych i fałszywych informacji.

Zmiany lingwistyczne w czasie

Wykrywanie fake newsów wymaga także uwzględnienia dynamicznej natury języka dezinformacji. Badania pokazują, że cechy językowe fałszywych informacji ulegają ewolucji w czasie, szczególnie w kontekście nagłówków, które cechują się największą zmiennością. W związku z tym konieczne jest ciągłe aktualizowanie modeli detekcyjnych, aby utrzymać ich skuteczność w zmieniającym się środowisku komunikacyjnym.

Techniki takie jak redukcja wymiarowości danych oraz wykrywanie punktów zmiany (change point detection) umożliwiają monitorowanie tych zmian i dostosowywanie modeli klasyfikacyjnych. Dzięki temu możliwe jest skuteczniejsze przeciwdziałanie dezinformacji, której język coraz lepiej dostosowuje się do oczekiwań i schematów poznawczych odbiorców.

Algorytmy i narzędzia wykorzystywane do identyfikacji fake newsów

Rozpoznawanie i eliminowanie dezinformacji wymaga połączenia zaawansowanych rozwiązań technologicznych z praktykami weryfikacji faktów. Współczesne systemy opierają się na synergii algorytmów sztucznej inteligencji, uczenia maszynowego oraz narzędzi wspierających manualny fact-checking. Takie podejście pozwala skutecznie analizować ogromne ilości danych, identyfikować fałszywe treści w dynamicznym środowisku medialnym i reagować na nowe formy manipulacji informacją. W rezultacie, coraz większe znaczenie zyskują zarówno automatyczne, jak i hybrydowe rozwiązania, które wspierają użytkowników i instytucje w walce z rozprzestrzenianiem się fake newsów.

Algorytmy uczenia maszynowego i sztucznej inteligencji

Wiodącym nurtem w identyfikacji fake newsów są metody klasyfikacji oparte na nadzorowanym uczeniu maszynowym. Do najczęściej wykorzystywanych algorytmów należą: Support Vector Machine (SVM), Naïve Bayes, regresja logistyczna, drzewa decyzyjne, K-Nearest Neighbors (KNN) oraz Stochastic Gradient Descent. Modele te są trenowane na oznakowanych zbiorach danych, gdzie teksty zostały zaklasyfikowane jako prawdziwe bądź fałszywe. Badania wskazują, że niektóre z tych modeli – zwłaszcza SVM – osiągają bardzo wysoką skuteczność, sięgającą nawet 99% w warunkach testowych.

W celu zwiększenia dokładności klasyfikacji stosuje się także modele zespołowe (ensemble methods), które łączą wyniki wielu algorytmów. Takie podejście poprawia stabilność i odporność na błędy pojedynczych klasyfikatorów. Przykładem jest system opracowany na Keele University, w którym zastosowanie głosowania większościowego między modelami umożliwiło osiągnięcie skuteczności detekcji fake newsów na poziomie 99%.

Istotnym elementem analizy tekstu są cechy lingwistyczne i semantyczne, takie jak n-gramy, statystyki TF-IDF, osadzenia słów (word embeddings) oraz analiza sentymentu. Pozwalają one na identyfikację charakterystycznych wzorców językowych występujących w dezinformacji.

Systemy fact-checkingowe i narzędzia wspomagające weryfikację informacji

Obok metod opartych na AI, istotną rolę odgrywają narzędzia służące bezpośredniej weryfikacji treści. Google Fact Check Explorer umożliwia przeszukiwanie globalnych baz danych organizacji fact-checkingowych, wspierając ocenę prawdziwości konkretnych twierdzeń. Również platformy takie jak Snopes, PolitiFact, FactCheck.org oraz Full Fact dostarczają profesjonalnych analiz i ocen wiarygodności przekazów medialnych, często opatrzonych klasyfikacją typu „True”, „False” czy „Misleading”.

W kontekście analizy treści publikowanych w mediach społecznościowych zastosowanie znajdują narzędzia takie jak Botometer, służący do identyfikacji kont botów, oraz Hoaxy – umożliwiający wizualizację rozpowszechniania informacji w sieci. Z kolei narzędzia takie jak FotoForensics oraz wyszukiwarki odwrotne obrazów (reverse image search) pozwalają na ocenę autentyczności materiałów wizualnych, wykrywając m.in. manipulacje graficzne czy błędne przypisania kontekstowe.

Pomocne w codziennej weryfikacji są również rozszerzenia przeglądarek, takie jak InCheck, które umożliwiają szybkie porównanie fragmentów tekstu z bazami zweryfikowanych informacji.

Metody hybrydowe i wyzwania w detekcji dezinformacji

Najbardziej efektywne podejścia do wykrywania fake newsów łączą metody automatyczne z tradycyjnym fact-checkingiem. Takie rozwiązania pozwalają na szybką analizę dużych wolumenów danych, jednocześnie zachowując precyzję oceny eksperckiej. Mimo to, proces ten napotyka istotne bariery. Należą do nich m.in. subiektywność ocen, ryzyko cenzury, stronniczość recenzentów oraz trudności z jednoznaczną oceną wiarygodności niektórych źródeł.

Automatyczne systemy mogą ponadto błędnie interpretować formy wyrazu takie jak ironia, satyra czy kontrowersyjne opinie, które niekoniecznie mają charakter dezinformacyjny. Dlatego rozwój narzędzi wykrywających fake newsy musi uwzględniać kontekst komunikacyjny oraz kulturowy, a także wymaga stałego udoskonalania algorytmów w odpowiedzi na zmieniające się strategie twórców fałszywych treści.

Systemy oznaczania fałszywych treści

W odpowiedzi na rosnącą skalę dezinformacji w internecie, systemy oznaczania (flagowania) potencjalnie fałszywych treści stają się coraz ważniejszym elementem cyfrowego ekosystemu informacyjnego. Ich głównym zadaniem jest nie tylko ostrzeganie użytkowników przed niewiarygodnymi materiałami, ale także ograniczanie zasięgu szkodliwych wiadomości i wspieranie rozwoju kompetencji medialnych odbiorców. Współczesne rozwiązania obejmują zarówno automatyczne mechanizmy oparte na algorytmach, jak i narzędzia umożliwiające społecznościową korektę treści, co pozwala na bardziej kompleksowe podejście do walki z fake newsami.

Automatyczne algorytmy detekcji dezinformacji

Największe platformy społecznościowe, takie jak Facebook, X (dawniej Twitter), Instagram, TikTok czy YouTube, wdrażają zautomatyzowane systemy detekcji oparte na sztucznej inteligencji i uczeniu maszynowym. Technologie te umożliwiają identyfikację treści wykazujących cechy charakterystyczne dla fake newsów. Analizowane są m.in. język, styl, źródła oraz kontekst publikacji. W przypadku wykrycia podejrzanego materiału użytkownikowi prezentowany jest komunikat ostrzegawczy, często w formie adnotacji poprzedzającej wyświetlenie lub udostępnienie treści.

Współpraca z niezależnymi organizacjami fact-checkingowymi

Ważnym uzupełnieniem automatycznych systemów są działania oparte na współpracy z niezależnymi organizacjami zajmującymi się weryfikacją faktów. Różne platformy społecznościowe integrują swoje systemy z podmiotami prowadzącymi profesjonalne analizy treści, takimi jak Snopes, PolitiFact, FactCheck.org, Full Fact czy Demagog. W przypadku gdy dana informacja zostanie oceniona jako fałszywa przez zewnętrznych weryfikatorów, publikacja może zostać oznaczona stosowną adnotacją, a jej zasięg ograniczony, co wpływa na jej dalszą widoczność w ekosystemie platformy.

Zgłoszenia i moderacja treści przez użytkowników

Użytkownicy platform również odgrywają istotną rolę w identyfikacji dezinformacji. Systemy umożliwiają zgłaszanie treści, które mogą być fałszywe, wprowadzające w błąd lub szkodliwe. Takie zgłoszenia są następnie oceniane przez moderatorów lub przetwarzane przez algorytmy. W przypadku potwierdzenia naruszenia polityki informacyjnej platformy, treść może zostać oznaczona, ukryta lub usunięta.

Społecznościowe mechanizmy korekty – „Notatki społeczności” na platformie X

Nowatorskim podejściem do oznaczania treści jest model społecznościowej weryfikacji, którego przykładem są Notatki społeczności (Community Notes) na platformie X. Funkcja ta umożliwia zweryfikowanym użytkownikom dodawanie kontekstu do treści, które mogą wprowadzać w błąd. Notatki zawierają źródła, uzupełniające informacje oraz neutralne wyjaśnienia i są zatwierdzane jedynie wtedy, gdy uznają je za pomocne osoby reprezentujące różne światopoglądy. Takie podejście łączy mechanizmy crowdsourcingu z ideą zaufania społecznego i stanowi alternatywę dla scentralizowanej moderacji.

Oznaczenia w wynikach wyszukiwania i portalach informacyjnych

Systemy oznaczania są również stosowane przez wyszukiwarki internetowe, takie jak Google czy Bing, które w wynikach wyszukiwania prezentują adnotacje wskazujące, że dana informacja została poddana procesowi weryfikacji przez zaufane źródła (np. „Fact-checked by…”). Ponadto niektóre redakcje i portale informacyjne wdrażają własne systemy oznaczania lub nawiązują współpracę z organizacjami fact-checkingowymi.

Użytkownicy mogą również korzystać z narzędzi zewnętrznych, takich jak InCheck, NewsGuard czy Hoaxy, które działają jako rozszerzenia przeglądarki internetowej i oferują dodatkowe warstwy oceny wiarygodności treści.

Polityka usuwania treści a problematyka wolności słowa

W przypadku treści rażąco naruszających regulaminy platform, takich jak nawoływanie do przemocy, mowa nienawiści czy dezinformacja zagrażająca zdrowiu publicznemu, stosowane są sankcje w postaci usunięcia materiałów. W pozostałych przypadkach, gdy treść budzi kontrowersje lub niejednoznaczność interpretacyjną, stosuje się zazwyczaj oznaczenia i ograniczenia zasięgu. Praktyki te rodzą debatę na temat potencjalnej cenzury, stronniczości moderatorów oraz granic dopuszczalnej ingerencji w wolność wypowiedzi.

Wyzwania i ograniczenia

Mimo postępu w dziedzinie wykrywania fake newsów, proces ten napotyka wiele barier, zarówno technologicznych, jak i etycznych. Automatyzacja i sztuczna inteligencja z jednej strony umożliwiają szybką analizę ogromnych ilości danych, z drugiej jednak strony wiążą się z ryzykiem błędów, nadinterpretacji i ingerencji w wolność wypowiedzi. Poniżej przedstawiamy główne wyzwania i ograniczenia związane z identyfikacją i oznaczaniem fałszywych informacji w internecie:

- Wiarygodność i dostępność źródeł – Weryfikacja informacji wymaga porównania jej z zaufanymi źródłami. Problem pojawia się, gdy takie źródła nie istnieją, są trudno dostępne lub same budzą kontrowersje. Co więcej, różne kraje i kultury mogą mieć różne standardy uznawania źródeł za wiarygodne, co utrudnia globalną unifikację systemów wykrywania fake newsów.

- Ryzyko cenzury i ograniczenia wolności słowa – Jest to jedno z największych zagrożeń związanych z automatycznym oznaczaniem i usuwaniem treści. Zarówno AI mogą błędnie oznaczyć takie treści jako dezinformację jak i rządy mogą wykorzystywać narzędzia wykrywania fake newsów do tłumienia wolności mediów, krytyki politycznej czy informacji niezgodnych z linią władzy.

- Stronniczość fact-checkerów – Nawet organizacje zajmujące się weryfikacją faktów mogą być oskarżane o brak bezstronności. Wybór tematów do sprawdzenia, sposób ich oceny, a także sposób przedstawienia wyników może sugerować preferencje polityczne. Krytycy wskazują, że fact-checkerzy – mimo deklarowanej niezależności – często działają w ramach określonych środowisk medialnych, co może wpływać na ich decyzje.

- Trudność oceny informacji – Ocena prawdziwości informacji często wymaga interpretacji kontekstu, intencji nadawcy oraz tła sytuacyjnego. Wiele wiadomości nie jest jednoznacznie prawdziwych lub fałszywych – mogą zawierać fragmenty prawdy, ale być przedstawione w sposób wprowadzający w błąd. Co więcej, tematy takie jak polityka, religia czy ideologia wzbudzają różne emocje i interpretacje, co sp, że odbiorcy mogą zupełnie inaczej ocenić tę samą informację.

Podsumowanie i rekomendacje

W dobie powszechnego dostępu do informacji i błyskawicznego tempa ich rozpowszechniania, umiejętność odróżniania prawdy od fałszu staje się jedną z kluczowych kompetencji. Fake newsy podszywające się pod rzetelne wiadomości, nie są już jedynie marginesem internetowej rzeczywistości – stały się narzędziem wpływu, manipulacji, a nawet bronią w wojnach informacyjnych.

Mimo zaawansowanych technologii wykrywania nieprawdziwych treści, takich jak algorytmy sztucznej inteligencji czy systemy fact-checkingowe, to użytkownik końcowy wciąż pozostaje najważniejszym ogniwem w walce z dezinformacją. Dlatego warto wykształcić w sobie pewne nawyki, które pozwolą skuteczniej rozpoznawać fake newsy i nie dać się zmanipulować.

Jak rozpoznawać fake newsy?

- Sprawdzaj źródło informacji – Zawsze warto zweryfikować, kto opublikował daną wiadomość. Czy to uznana redakcja, organizacja dziennikarska, czy może anonimowy blog lub profil społecznościowy? Im mniej przejrzyste źródło, tym większa szansa na dezinformację.

- Porównuj informacje w wielu źródłach – Rzetelne wiadomości są najczęściej powtarzane przez wiele niezależnych mediów. Jeśli informacja pojawia się tylko w jednym miejscu, może to być sygnał ostrzegawczy.

- Zachowuj ostrożność wobec emocjonalnych nagłówków – Fake newsy często posługują się językiem wzbudzającym silne emocje: strach, gniew, oburzenie. Ich celem jest zmuszenie do kliknięcia i szybkiego udostępnienia, bez zastanowienia.

- Zwracaj uwagę na język i błędy – Często fake newsy zawierają błędy ortograficzne, gramatyczne lub logiczne. Język pełen ogólników i emocjonalnych wyrażeń może również sugerować niską wiarygodność.

Co robić, jak żyć?

- Nie udostępniaj niesprawdzonych informacji tylko dlatego, że zgadzają się z Twoimi poglądami.

- Nie zakładaj, że coś jest prawdą tylko dlatego, że „wszyscy o tym mówią”.

- Unikaj źródeł, które regularnie publikują sensacyjne i niezweryfikowane treści.

- Nie ulegaj emocjom – fake newsy często celują w emocje, dlatego ważne jest, by reagować spokojnie i z rozwagą.

- Korzystaj z narzędzi fact-checkingowych – Strony takie jak Demagog, AFP Sprawdzam czy PolitiFact pomagają szybko ocenić wiarygodność danej informacji.

Walka z fake newsami to nie tylko zadanie dla rządów, mediów i technologii. To codzienne wyzwanie każdego internauty. Tylko świadome i krytyczne podejście do informacji może powstrzymać falę dezinformacji, która zagraża demokracji, bezpieczeństwu i zaufaniu społecznemu. W świecie, w którym każdy może być nadawcą treści, każdy z nas ma też odpowiedzialność za to, co przekazuje dalej.

Źródła:

- Allcott, H., & Gentzkow, M. (2017). Social Media and Fake News in the 2016 Election. Journal of Economic Perspectives, 31(2), 211–236.

- Bovet, A., & Makse, H. A. (2019). Influence of fake news in Twitter during the 2016 US presidential election. Nature Communications, 10(1), 7.

- Conroy, N. J., Rubin, V. L., & Chen, Y. (2015). Automatic deception detection: Methods for finding fake news. Proceedings of the Association for Information Science and Technology, 52(1), 1–4.

- Granik, M., & Mesyura, V. (2017). Fake news detection using naive Bayes classifier. 2017 IEEE First Ukraine Conference on Electrical and Computer Engineering (UKRCON), 900–903.

- Pérez-Rosas, V., Kleinberg, B., Lefevre, A., & Mihalcea, R. (2018). Automatic Detection of Fake News. Proceedings of the 27th International Conference on Computational Linguistics, 3391–3401.

- Shu, K., Sliva, A., Wang, S., Tang, J., & Liu, H. (2017). Fake News Detection on Social Media: A Data Mining Perspective. ACM SIGKDD Explorations Newsletter, 19(1), 22–36.

- Vosoughi, S., Roy, D., & Aral, S. (2018). The spread of true and false news online. Science, 359(6380), 1146–1151.

- Zhou, X., & Zafarani, R. (2020). A Survey of Fake News: Fundamental Theories, Detection Methods, and Opportunities. ACM Computing Surveys, 53(5), 1–40.

- Qiao, Y., Wiechmann, D., & Kerz, E. (2023). A Language-Based Approach to Fake News Detection Through Interpretable Features and BRNN.

- Petrou, N., Christodoulou, C., Anastasiou, A., Pallis, G., & Dikaiakos, M. D. (2023). A Multiple change-point detection framework on linguistic characteristics of real versus fake news articles.

- Mahyoob, M., Algaraady, J., & Alrahaili, M. (2023). Linguistic-Based Detection of Fake News in Social Media.

- Ahmed, A. A. A., Aljarbouh, A., Donepudi, P. K., & Choi, M. S. (2023). Detecting Fake News using Machine Learning: A Systematic Literature Review.

- Huang, L. (2023). Deep Learning for Fake News Detection: Theories and Models. College of Engineering and Computer Science and College of Business and Economics, Australian National University, Australia.

[…] poprzednim artykule skupiliśmy się na seks robotach w ogólności, a także na najpopularniejszej formie tego […]