Czy można grać w Pokemony w kościele, kręcić rolki w miejscu pamięci o zagładzie lub nagrywać Tik-Toka na autostradzie, prowadząc z nadmierną prędkością?

Technicznie: tak.

Etycznie i społecznie: problematyczne.

Postęp technologiczny, głównie napędzany przez mobilne aplikacje i sztuczną inteligencję, z jednej strony otwiera nowe możliwości, z drugiej zaś zmusza do refleksji nad granicami wolności i odpowiedzialności. Czy technologia może pomóc nam hamować nasze nieodpowiedzialne impulsy? Jak instytucjonalnie i informatycznie możemy kształtować odpowiedzialne korzystanie z narzędzi cyfrowych?

Mobilne technologie na rozdrożu etyki i użyteczności

Mobilne aplikacje i media społecznościowe stały się nieodłączną częścią codzienności. W 2024 roku przeciętny użytkownik smartfona spędza w aplikacjach ponad 4 godziny dziennie (WEB1), a na przestrzeni lat wartość ta systematycznie rośnie, co jest związane ze zwiększonym uzależnieniem społeczeństwa od komunikacji mobilnej, rozrywki cyfrowej i pracy zdalnej. Coraz częściej smartfon staje się nie tylko narzędziem, ale wręcz przedłużeniem świadomości użytkownika, z którego trudno zrezygnować nawet na chwilę.

Poniższa tabela przedstawia średni dzienny czas korzystania ze smartfona w 2024 roku w podziale na pokolenia:

| Pokolenie | Średni dzienny czas korzystania ze smartfona |

|---|---|

| Pokolenie Z | 6 godzin i 5 minut |

| Milenialsi | 4 godziny i 36 minut |

| Pokolenie X | 4 godziny i 9 minut |

| Baby Boomers | 3 godziny i 31 minut |

Widoczna jest tutaj zależność: im młodsze pokolenie, tym dłuższy czas spędzany przed ekranem smartfona. Nie chodzi już tylko o komunikację i rozrywkę, ale o całą gamę funkcji: nawigację, zarządzanie zdrowiem, zakupy, edukację czy tworzenie treści. Jednak tak wszechobecna technologia stawia nas przed poważnymi pytaniami: czy umiemy odpowiednio korzystać z jej możliwości? Czy technologia, która daje dostęp do wszystkiego, powinna czasem również mówić „stop”?

Popularność aplikacji takich jak TikTok, Instagram, YouTube czy Pokemon Go przekracza granice pokoleń, narodowości i kontekstów kulturowych. To już nie są tylko platformy rozrywki, ale narzędzia wpływu kulturowego i emocjonalnego, które operują na naszych przyzwyczajeniach, lękach, a często także uzależnieniach. Problem zaczyna się tam, gdzie technologia wchodzi w przestrzenie symboliczne, niebezpieczne lub sakralne, nie oferując użytkownikowi żadnych barier ani refleksji. Aplikacja nie rozpoznaje znaczenia miejsca, w którym się znajdujemy, ale może powinna?

Studium przypadków: Gdy aplikacja wygrywa z rozsądkiem

Pokemon Go w kościele

W 2016 roku gra mobilna Pokemon Go zyskała ogromną popularność, zmuszając użytkowników do fizycznego przemieszczania się po świecie w celu łapania wirtualnych stworków. W teorii była to forma aktywizacji fizycznej i integracji społecznej. W praktyce jednak gracze pojawiali się w miejscach takich jak kościoły, cmentarze, muzea Holokaustu czy nawet miejsca katastrof, traktując je jako „areny gry”, co wywoływało kontrowersje i krytykę ze strony społeczności lokalnych (Pew Research Center, 2017).

Instagram z Auschwitz

Influencerzy publikujący sesje zdjęciowe i rolki z obozów koncentracyjnych to zjawisko, które wywołuje wyjątkowo silne emocje. Uśmiechy, modne stylizacje i artystyczne kadry w miejscu, gdzie zginęły miliony, są odbierane jako skrajna ignorancja, komercjalizacja cierpienia i brak elementarnego szacunku (Huffington Post, 2021). Brakuje mechanizmów, które mogłyby powstrzymać użytkownika przed takimi publikacjami – choćby ostrzeżeń kontekstowych czy komunikatów edukacyjnych.

TikTok na A4 przy 240 km/h

Niektórzy użytkownicy TikToka publikują filmy rejestrujące jazdę samochodem z prędkością znacznie przekraczającą dozwolone limity. Trend zdobywa popularność wśród młodych kierowców, jednocześnie powodując realne zagrożenie na drogach. WHO alarmuje, że nieodpowiedzialne korzystanie z urządzeń mobilnych podczas jazdy jest jedną z głównych przyczyn wypadków drogowych (WHO, 2022). TikTok, jak wiele innych platform, nie posiada obecnie mechanizmów wykrywających i reagujących na takie treści w czasie rzeczywistym.

Live streaming z pogrzebów

Nowy trend, jaki zaobserwowano w USA i Ameryce Południowej, to transmisje na żywo z pogrzebów, prowadzone na Facebooku, YouTube czy TikToku. Choć część z nich ma charakter wspólnotowy i umożliwia bliskim uczestnictwo zdalne, niektóre przeradzają się w autopromocję. Prowadzenie transmisji z żałobnikami w tle bez ich zgody to naruszenie prywatności i brak taktu, któremu technologia, jak dotąd nie stawia granic.

Filmy z wypadków i katastrof

Zdarzają się przypadki, gdzie użytkownicy aplikacji nagrywają miejsca wypadków chwilę po zdarzeniu, lub nawet w jego trakcie zamiast pomóc ofiarom. Niektóre materiały trafiają na Instagram, TikTok czy YouTube z clickbaitowymi tytułami. W takich sytuacjach technologia sprzyja dehumanizacji i uprzedmiotowieniu tragedii (RMF24 2025).

Te przypadki pokazują, że samoistna etyka użytkownika nie wystarcza. Presja społeczna, chęć zdobycia popularności, brak wiedzy o kontekście kulturowym i łatwy dostęp do narzędzi cyfrowych prowadzą do zachowań, które przekraczają granice rozsądku i etyki. Dlatego potrzebujemy rozwiązań, które nie tylko edukują, ale też technologicznie i instytucjonalnie ograniczają możliwość podejmowania nieodpowiedzialnych działań.

Technologia jako cyfrowy etyk: Jak systemy wpływają na nasze decyzje?

Lawrence Lessig (1999), w swojej przełomowej pracy „Code is Law”, zauważył, że to nie tylko przepisy prawne czy normy społeczne kształtują zachowania ludzi w przestrzeni cyfrowej, ale także sam kod, czyli architektura oprogramowania. Oznacza to, że projektując systemy cyfrowe, de facto tworzymy struktury normatywne: coś, co zachęca użytkownika do określonych działań lub wręcz ogranicza ich możliwość.

Dziś, przy dostępności technologii takich jak sztuczna inteligencja, uczenie maszynowe, widzenie komputerowe, systemy rekomendacyjne czy geolokalizacja, możliwości te są jeszcze większe. Aplikacje mogą nie tylko sugerować, ale również profilować, filtrować, nadzorować i oceniać zachowania użytkowników. Projektowanie z myślą o „etycznym kodzie” staje się realną odpowiedzialnością inżynierów i projektantów UX.

B.J. Fogg (2002) z Uniwersytetu Stanforda, wprowadził pojęcie „persuasive technology” – technologii, która wpływa na ludzkie zachowania bez użycia przemocy, przymusu czy nakazu. Zamiast tego wykorzystuje subtelne bodźce, przypomnienia, nagrody, schematy interakcji. Zegarki Apple Watch, Garmin czy Polar, które regularnie przypominają o konieczności wstania i poruszenia się, są jednym z najbardziej znanych przykładów. Podobnie aplikacje zdrowotne przypominające o nawodnieniu, medytacji czy śnie.

W tym duchu możemy myśleć również o technologiach przeciwdziałających nieetycznym lub niebezpiecznym zachowaniom. Jeśli smartfon wykryje, że użytkownik porusza się z prędkością wskazującą na jazdę samochodem, może automatycznie zablokować możliwość nagrywania filmów. Jeśli aplikacja rozpozna, że użytkownik znajduje się w miejscu pamięci o ludobójstwie, może ograniczyć możliwość publikacji lub wprowadzić edukacyjne komunikaty.

Perswazyjny design, odpowiednio zastosowany, nie musi ograniczać wolności, a może ją wzbogacać o refleksję. Przy założeniu transparentności, zgody użytkownika i dostępności informacji, możemy mówić o technologii, która nie tylko wspiera komfort, ale również kształtuje dojrzałość cyfrową.

Co więcej, coraz częściej mówi się o potrzebie implementacji tzw. „digital nudges”, czyli cyfrowych szturchańców, które prowadzą użytkownika do etycznych decyzji, podobnie jak fizyczne „nudges” w projektowaniu urbanistycznym (np. schody zamiast windy jako domyślna opcja). Dlaczego nie miałoby to działać w kontekście publikowania w sieci treści z Auschwitz, czy nagrywania podczas jazdy?

Technologia może więc nie tylko umożliwiać działania, ale też odpowiedzialnie je kształtować. Projektowanie aplikacji z myślą o bezpieczeństwie społecznym, pamięci historycznej i godności ludzkiej to wyzwanie, które już dziś powinno być standardem a nie opcją.

Rozwiązania techniczne: Jak projektować aplikacje odpowiedzialnie?

Geofencing i kontekstowa dezaktywacja

Zastosowanie technologii geofencingu, czyli wirtualnych granic wyznaczanych na podstawie danych GPS, pozwala aplikacjom dynamicznie zmieniać swoje funkcje w zależności od lokalizacji użytkownika. Przykładowo, w obrębie muzeów, miejsc pamięci narodowej, sakralnych czy stref katastrof, można automatycznie ograniczyć działanie aparatu fotograficznego, funkcji nagrywania wideo czy transmisji na żywo.

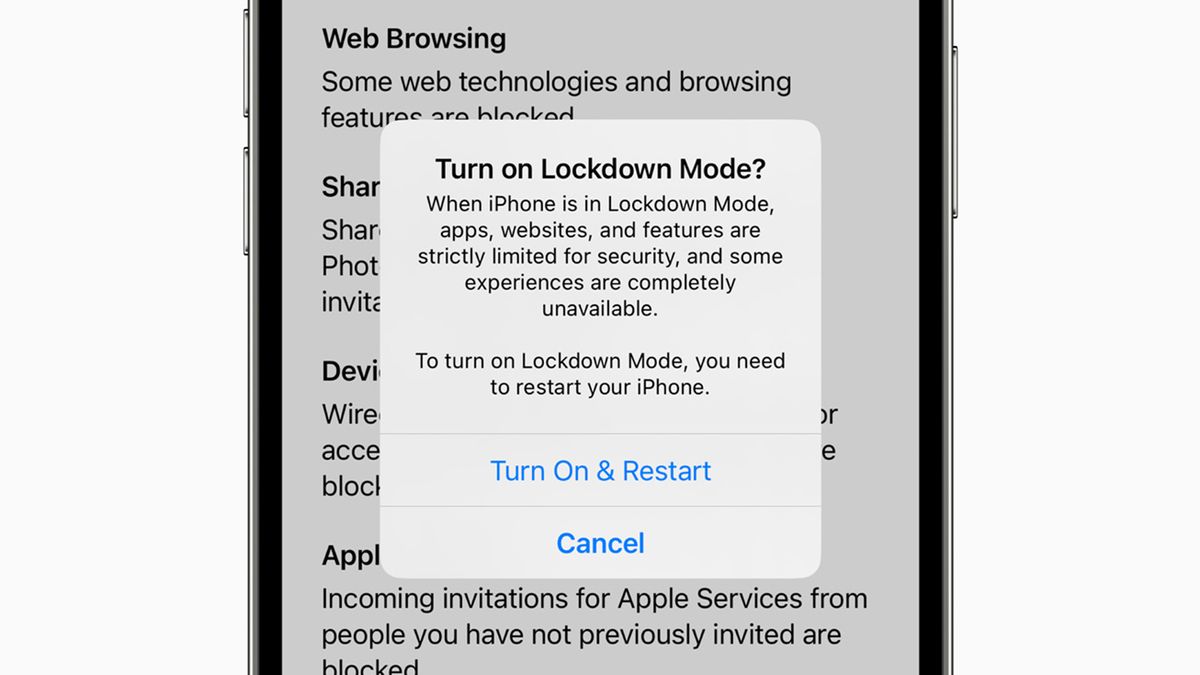

Apple już od lat stosuje podobne rozwiązania, blokując niektóre funkcje w strefach militarnych. Możliwość taka istnieje również dla twórców aplikacji, gdzie mogą oni dodać własne warunki działania zależne od lokalizacji, zwłaszcza w środowisku Android i iOS. W przyszłości takie mechanizmy mogłyby być obowiązkowym standardem dla aplikacji z dużym zasięgiem społeczno-kulturowym.

Analiza kontekstu za pomocą AI

Współczesne modele sztucznej inteligencji pozwalają na analizę obrazu w czasie rzeczywistym. Algorytmy mogą rozpoznawać kontekst sytuacyjny np. czy użytkownik porusza się samochodem, czy pieszo; czy w tle obrazu znajdują się znane obiekty historyczne, symbole religijne, miejsca o szczególnym znaczeniu. Jeśli AI wykryje, że użytkownik porusza się z prędkością wskazującą na prowadzenie pojazdu, może tymczasowo wyłączyć możliwość nagrywania, a nawet ostrzec użytkownika o ryzyku.

Dodatkowo AI może klasyfikować obrazy pod kątem ich charakteru: czy są sensacyjne, czy mogą przedstawiać wypadek, przemoc, lub miejsce katastrofy. W zależności od klasyfikacji, system może wysłać ostrzeżenie, wymusić akceptację specjalnych zasad publikacji lub zablokować niektóre funkcje.

Integracja z API lokalizacji kulturowych

Istnieją publiczne i prywatne bazy danych, które zawierają informacje o lokalizacjach o szczególnym znaczeniu kulturowym, religijnym i historycznym. Przykładem może być UNESCO World Heritage API, Google Arts & Culture czy krajowe rejestry zabytków i miejsc pamięci. Twórcy aplikacji mogą integrować te dane z funkcjami aplikacji, aby automatycznie zmieniać ich działanie np. ograniczać publikowanie, przypominać o zasadach szacunku lub inicjować edukacyjne okna pop-up. Takim przykładem w Polsce jest chociażby współpraca między muzeum Auschwitz-Birkenau a Google Arts & Culture.

Interfejsy edukacyjne

Nie zawsze potrzebna jest twarda blokada. W wielu przypadkach wystarczy, by aplikacja zachęciła użytkownika do refleksji. Przykładowo: jeśli użytkownik otwiera Instagram w Auschwitz, może pojawić się pełnoekranowe ostrzeżenie: „Znajdujesz się w miejscu pamięci ofiar Holocaustu. Prosimy o powściągliwość i szacunek. Czy na pewno chcesz kontynuować?”.

Takie interfejsy mogą zawierać linki do materiałów edukacyjnych, wideo lub krótkich tekstów historycznych. Co więcej, można je personalizować w zależności od wieku użytkownika, języka czy historii wyszukiwania.

Tryb „Silent Respect”

Jest to specjalny tryb działania aplikacji, który automatycznie aktywuje się w określonych lokalizacjach takich jak cmentarze, miejsca katastrof, muzea historyczne czy świątynie. W jego ramach aplikacja:

-

przełącza się w tryb cichy (brak dźwięków powiadomień),

-

blokuje transmisje na żywo,

-

uniemożliwia nagrywanie zdjęć i filmów,

-

wyświetla informacje o znaczeniu danego miejsca.

W przeciwieństwie do tradycyjnych blokad, tryb „Silent Respect” działa tymczasowo i lokalnie a użytkownik otrzymuje komunikat o jego aktywacji i może go rozumieć jako formę kulturowego minimum empatii, a nie ograniczenie wolności.

Takie rozwiązania, choć technicznie wykonalne, wymagają współpracy: między deweloperami aplikacji, instytucjami publicznymi, społecznościami lokalnymi i organizacjami kultury. Technologia już dziś pozwala na ich wdrożenie pytanie tylko brzmi:

czy znajdziemy wolę, by to zrobić?

Rozwiązania instytucjonalne: Kto powinien reagować?

Producenci aplikacji

Firmy technologiczne takie jak Meta, Google czy ByteDance odgrywają kluczową rolę w kształtowaniu norm cyfrowych. To one projektują i wdrażają mechanizmy, które mogą zapobiegać niewłaściwemu użytkowaniu aplikacji w kontekście kulturowym, etycznym czy prawnym. Powinny one powoływać wewnętrzne zespoły ds. etyki technologicznej, składające się z ekspertów w dziedzinach takich jak psychologia, etyka, prawo, historia i design UX. Obowiązkiem tych zespołów byłoby projektowanie funkcji takich jak ostrzeżenia kontekstowe, geofencing w miejscach pamięci, czy systemy wykrywania niebezpiecznych zachowań (np. użycia aplikacji podczas prowadzenia pojazdu).

Co więcej, platformy mogłyby współtworzyć otwarte standardy API, które ułatwią instytucjom kultury czy państwom definiowanie lokalizacji i kontekstów wymagających specjalnych zabezpieczeń. Przykładowo, podobnie jak istnieją „safe browsing APIs”, mogłyby istnieć „digital dignity zones APIs”.

Instytucje kultury i pamięci

Muzea, instytuty historyczne, kościoły, fundacje i organizacje pozarządowe dysponują unikalną wiedzą o znaczeniu miejsc i wydarzeń. Powinny one aktywnie uczestniczyć w definiowaniu tzw. „cyfrowych stref szacunku” i przekazywać je twórcom aplikacji w formie geolokalizacyjnej, wizualnej lub semantycznej (np. słowa kluczowe, obrazy). Mogą również tworzyć własne aplikacje edukacyjne lub współpracować z influencerami i platformami w celu promowania dobrych praktyk.

Współpraca między muzeum Auschwitz-Birkenau a Google Arts & Culture jest przykładem pozytywnego sojuszu technologii i pamięci. W przyszłości takie instytucje mogłyby posiadać uprawnienia do zgłaszania treści naruszających godność danego miejsca i inicjowania lokalnych ograniczeń funkcji w aplikacjach.

Organizacje międzynarodowe

Organizacje takie jak UNESCO, WHO, Rada Europy czy Komisja Europejska mogą tworzyć międzynarodowe standardy i regulacje. Ich rola to nie tylko rekomendacje etyczne, ale również legislacyjne. Przykładowo, Unia Europejska w ramach AI Act może ustanowić obowiązek implementacji funkcji kontekstowych w aplikacjach o masowym zasięgu.

UNESCO mogłoby stworzyć światowy rejestr „miejsc wrażliwych cyfrowo” podobnie jak Lista Światowego Dziedzictwa, z której deweloperzy mogliby korzystać, tworząc funkcje ochronne.

|

|

|

Edukacja medialna

Techniczne ograniczenia nie zastąpią świadomości. Dlatego niezbędna jest powszechna edukacja medialna i etyczna już od szkoły podstawowej. Użytkownicy muszą rozumieć, dlaczego dane ograniczenia istnieją, w jakich kontekstach publikowanie treści może być szkodliwe, oraz jak korzystać z mediów społecznościowych z szacunkiem wobec innych.

Edukacja ta powinna obejmować:

- zajęcia z etyki cyfrowej i historii wrażliwości kulturowej,

- warsztaty tworzenia odpowiedzialnych treści w internecie,

- analizy przypadków nadużyć i ich społecznych konsekwencji.

Pracodawcy i uniwersytety również powinni włączać edukację cyfrową do programów onboardingowych i szkoleń rozwojowych.

Wnioski i polemika

Mobilne technologie nie tylko przekształciły sposób, w jaki komunikujemy się i konsumujemy treści, ale także to, jak odczuwamy, pamiętamy i interpretujemy rzeczywistość. Ich wszechobecność sprawiła, że granica między światem cyfrowym a fizycznym zaczyna się zacierać. Smartfon, będący dla wielu przedłużeniem ich tożsamości, otwiera nie tylko świat wiedzy i rozrywki, ale również stwarza ryzyko nieetycznych zachowań w newralgicznych sytuacjach nie zawsze z premedytacji, ale często z ignorancji, przyzwyczajenia lub potrzeby autoprezentacji.

Przykłady takie jak Pokemon Go w kościele, Instagram w Auschwitz czy TikTok przy 240 km/h pokazują, że nawet dobrze zaprojektowana aplikacja może zostać użyta w sposób rażąco niewłaściwy, jeśli nie towarzyszy jej świadoma architektura normatywna. Technologia, pozostawiona jedynie w rękach wolnej woli użytkownika, zbyt często przegrywa z instynktem zysku, sensacji i braku refleksji.

Jednocześnie, współczesna wiedza o projektowaniu systemów cyfrowych pokazuje, że nie jesteśmy bezradni. Rozwiązania takie jak geofencing, analiza kontekstu przy pomocy AI, edukacyjne interfejsy i tryby wyciszenia w miejscach pamięci pokazują, że technologia może działać jak subtelny doradca – nie jak cenzor. Klucz tkwi w zrównoważeniu: między ochroną wolności a odpowiedzialnością społeczną.

Co ważne, odpowiedzialność ta nie spoczywa wyłącznie na barkach użytkowników. Powinna być współdzielona przez producentów aplikacji, instytucje kultury, organizacje międzynarodowe i system edukacji. W przeciwnym razie grozi nam sytuacja, w której przestrzeń cyfrowa stanie się dzikim polem pozbawionym empatii i granic, w którym nawet miejsca cierpienia i śmierci staną się tłem dla selfie.

Zaprojektowanie aplikacji, która potrafi powiedzieć „stop” nie jest zamachem na wolność. Przeciwnie, jest to inwestycja w dojrzałość cyfrową. To wyraz szacunku wobec historii, społeczności i samego użytkownika, który dzięki temu może świadomie wybierać, kiedy i jak korzystać z cyfrowych narzędzi.

Literatura

- Lessig, L. (1999). Code and Other Laws of Cyberspace. Basic Books.

- Fogg, B. J. (2003). Persuasive Technology: Using Computers to Change What We Think and Do. Morgan Kaufmann.

- Sunstein, C. R., & Thaler, R. H. (2008). Nudge: Improving Decisions About Health, Wealth, and Happiness. Yale University Press.

- Zuboff, S. (2019). The Age of Surveillance Capitalism. PublicAffairs.

- Floridi, L. (2013). The Ethics of Information. Oxford University Press.

- Pew Research Center (2017). The Future of Free Speech, Trolls, Anonymity and Fake News Online.

https://www.pewresearch.org - WHO (2023). Global Status Report on Road Safety.

https://www.who.int - Huffington Post (2021). Instagram Influencers Slammed for Posing at Auschwitz.

https://www.huffpost.com - Google Arts & Culture & Auschwitz-Birkenau Museum.

https://artsandculture.google.com - RMF24 (2025). Brutalne zabójstwo na UW. Nowe fakty ws. Mieszka R.

https://www.rmf24.pl - Norman, D. A. (2013). The Design of Everyday Things (Revised and Expanded Edition). Basic Books.

[…] poprzednim artykule skupiliśmy się na seks robotach w ogólności, a także na najpopularniejszej formie tego […]