Sztuczna inteligencja (SI) odgrywa coraz większą rolę w naszym społeczeństwie, wpływając na wiele dziedzin życia, od zdrowia i edukacji po przemysł i usługi. Jednak wraz z rosnącym zainteresowaniem SI pojawią się coraz częściej pytania o jej nieprzewidywalne konsekwencje, w szczególności związane z potencjalną stronniczością. Wykorzystywanie systemów AI, które nie tylko generują wyniki niestosowne lub niesprawiedliwe, ale także pogłębiają nierówności społeczne, staje się obiektem trudnej debaty dodatkowo utrudnionej przez brak możliwości wyjaśnienia decyzji podejmowanych przez SI .Czy istnieje rozwiązanie, które pozwoli nam ostatecznie zrozumieć i weryfikować systemy SI?

Brak zrozumienia mechanizmów decyzyjnych sztucznej inteligencji

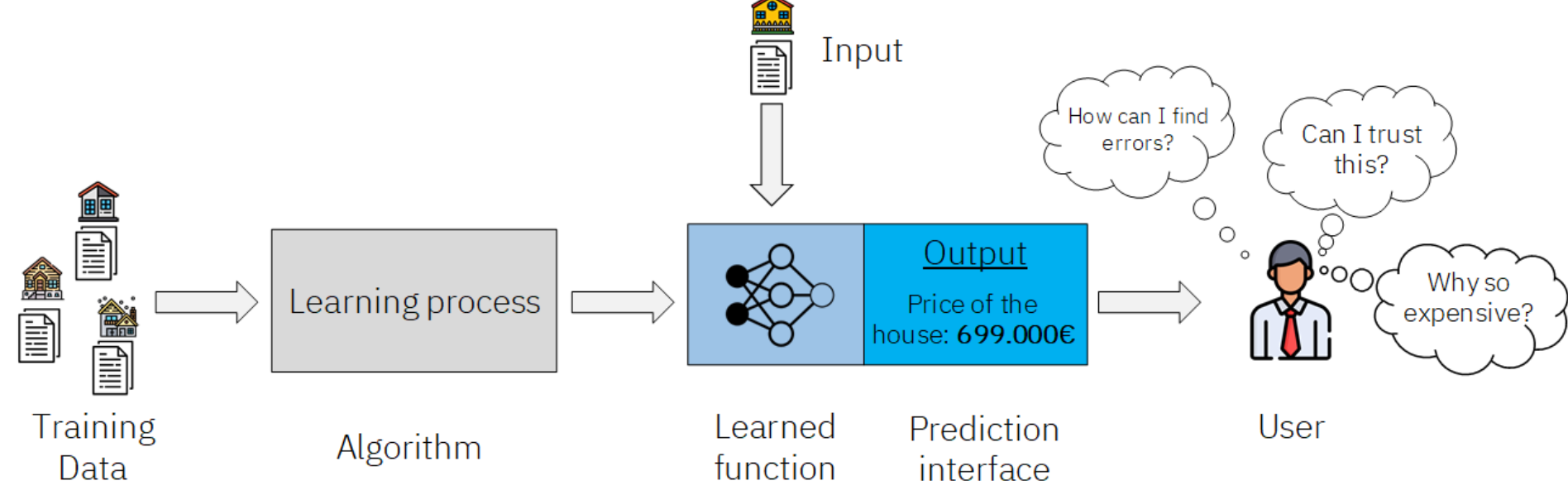

Korzystanie z SI do zautomatyzowania podejmowania decyzji bez możliwości zrozumienia przyczyn uzyskania konkretnego rezultatu stwarza poważne wyzwania i ryzyko dla naszego społeczeństwa. W ostatnich latach obserwujemy coraz większe zaufanie i uzależnienie od systemów SI w podejmowaniu kluczowych decyzji. Firmy, organizacje i instytucje korzystają z zaawansowanych algorytmów i modeli SI, które analizują ogromne ilości danych i generują rekomendacje lub podejmują decyzje w imieniu ludzi. Jednak w tej automatyzacji kryje się potencjalne zagrożenie dla transparentności i odpowiedzialności. Problemy z weryfikacją wyników systemów SI wynikają z kilku czynników. Jednym z nich jest złożoność i nieliniowość samych modeli SI, które często są oparte na zaawansowanych technikach uczenia maszynowego, takich jak głębokie sieci neuronowe. Te modele mają zdolność do wykrywania zależności i wzorców, które nie są łatwo interpretowalne przez człowieka. W rezultacie, proces weryfikacji staje się trudny, interpretacja wyników niejasna, a możliwość dopuszczenia złego SI do podejmowania decyzji wysoka.

Skutki złych systemów sztucznej inteligencji

Szkolenie SI na złych danych, mogą generować błędne lub stronnicze wyniki. Możliwe skutki uczenia systemu na złych danych np. zawierających uprzedzenia, może prowadzić do generowania wyników, które faworyzują lub dyskryminują pewne grupy społeczne. Stronnicze SI może powstać z kilku głównych powodów. Jednym z nich jest niedostateczna reprezentacja różnorodności w zbiorach danych uczących. Jeśli dane uczące są niewystarczająco różnorodne lub nie odzwierciedlają rzeczywistości w pełnym zakresie, systemy SI mogą mieć trudności z generalizacją i mogą produkować wyniki stronnicze. Inną przyczyną stronniczości w SI jest obecność uprzedzeń w danych. Uprzedzenia schowanie w danych uczących np. na podstawie płci, rasy czy pochodzenia etnicznego systemy SI bez problemu mogą wyłapać i reprodukować w swoich wynikach.

Jednym z najbardziej znanych przykładów stronniczości SI jest algorytm COMPAS (Correctional Offender Management Profiling for Alternative Sanctions) używany w amerykańskich systemach sądowych do przewidywania prawdopodobieństwa, że oskarżony będzie recydywistą. Algorytm ten ze względu na użyte dane, wybrany model i ogólny proces tworzenia algorytmu, przewidywał dwa razy więcej fałszywych pozytywnych wyników dla recydywy u czarnoskórych oskarżonych (45%) niż u białoskórych oskarżonych (23%).

Innym przykładem odkrytego w październiku 2019 roku złego SI jest algorytm używany w ponad 200 milionach przypadków w amerykańskich szpitalach do przewidywania pacjentów, którzy prawdopodobnie będą potrzebowali dodatkowej opieki medycznej. Wykorzystane SI wyraźnie faworyzowało białych pacjentów w porównaniu do pacjentów czarnoskórych. Chociaż sama rasa nie była zmienną uwzględnianą w tym algorytmie, to inna zmienna, będąca silnie skorelowana z rasą została użyta – była to historia kosztów opieki zdrowotnej. Korelacje historii kosztów opieki zdrowotnej z rasą osoby wykazano po analizie że z różnych powodów pacjenci czarnoskórzy generowali na ogół niższe koszty opieki zdrowotnej niż pacjenci biali z tymi samymi chorobami. Na szczęście w tym przypadku badacze współpracowali z firmą Optum, aby zmniejszyć poziom stronniczości o 80%. Gdyby nie przeprowadzili początkowych analiz, stronniczość SI mogłaby mieć poważny negatywny wpływ na życie wielu ludzi.

Przypadkiem związanym z niewystarczająco różnorodnymi danymi wykorzystanymi do uczenia SI jest złe SI wykorzystywane przez jakiś czas przez firmę Amazon. W 2015 roku Amazon zdał sobie sprawę, że ich algorytm używany do rekrutacji pracowników jest stronniczy wobec kobiet. Powodem tego był fakt, że algorytm opierał się na liczbie złożonych przez lata życiorysów, a ponieważ większość aplikujących była mężczyznami, algorytm był uczony faworyzować mężczyzn.

Explainable AI jako próba rozwiązania problemu

Wprowadzenie pojęcia Explainable AI (XAI), czyli SI, które potrafi wytłumaczyć swoje decyzje w zrozumiały sposób, otwiera nowe perspektywy dla transparentności i zaufania w systemach SI. Explainable AI stawia sobie za cel rozwiązanie tego problemu poprzez dostarczanie wytłumaczeń i uzasadnień dla podejmowanych decyzji. Przykładowymi aplikacjami XAI są techniki:

- Feature Importance – polegającą na ocenie znaczenia poszczególnych cech dla wyników modelu AI.

- LIME (Local Interpretable Model-Agnostic Explanations) – dostarczającą lokalnych wyjaśnień dla decyzji podejmowanych przez modele AI.

- SHAP (SHapley Additive exPlanations) – będąca techniką opartą na teorii gier, która dostarcza wyjaśnień opartych na wkładzie poszczególnych cech w wyniki modelu AI pozwalając identyfikować które cechy mają największy wpływ na podejmowane decyzje

Głównymi zaletami XAI jest przejrzystość, wiarygodność, etyczne i sprawiedliwe podejmowanie decyzji, zgodność z przepisami w branżach regulowanych, pozwalając np. w branży finansowej wytłumaczyć dlaczego system SI odrzucił wniosek o kredyt co jest istotne dla zapewnienia uczciwości i uniknięcia stronniczości.

Istotną kwestią w na którą należy zwrócić uwagę jest zwiększona złożoność i trudność we wdrożeniu technik XAI szczególnie dla zaawansowanych modeli AI, takich jak głębokie sieci neuronowe. Dodatkowo możliwy jest problem w którym będziemy musieli podczas wprowadzania XAI pogodzić się z potrzebą obniżenia dokładności systemu, gdyż w niektórych przypadkach osiągnięcie interpretowalności przeszkadza w uzyskaniu lepszej dokładności. Jednocześnie w zależności od techniki XAI zapewni ona większa interpretowalność wyników uzyskanych przez SI jednak techniki te posiadają także ograniczony zakres możliwych do przedstawienia wyjaśnień.

Alternatywy dla Explainable AI

Pomimo wielu korzyści, które niesie ze sobą XAI, istnieją pewne sytuacje, w których wady XAI lub specyfika rozwiązywanego problemu powoduje, że wprowadzenie tego podejścia jest niemożliwe lub nieefektywne. W takich przypadkach istnieją inne podejścia umożliwiające weryfikacje systemu SI takie jak:

- Audyt SI czyli przeprowadzenie audytu modeli SI mające na celu sprawdzenie, czy decyzje podejmowane przez systemy Si są zgodne z określonymi zasadami i kryteriami. Powinien on obejmować analizę danych, procesu uczenia modelu, a także ocenę wyników predykcji w porównaniu z rzeczywistymi wynikami.

- Wprowadzenie procedur weryfikacji pozwalających na sprawdzenie i potwierdzenie, czy modele Si działają zgodnie z oczekiwaniami i spełniają określone kryteria. Procedury te powinny zawierać wykonywanie testów statystycznych , porównanie wyników z innymi niezależnymi źródłami czy wykorzystanie istniejących benchmarków.

- Human-in-the-Loop polegającym na wprowadzeniu człowieka w proces podejmowania decyzji SI poprzez integrację interakcji człowieka z systemem SI. Umożliwia on użytkownikom monitorowanie, zrozumienie i ewentualne korygowanie decyzji podejmowanych przez systemy SI na podstawie wiedzy i intuicji użytkownika.

- Procesy dokumentacji: Dokumentowanie procesu tworzenia, uczenia i wdrażania modeli AI w celu zapewnienia przejrzystości i możliwości śledzenia decyzji podejmowanych przez systemy AI.

Podsumowanie

Wraz z coraz powszechniejszym wykorzystaniem SI do podejmowania znaczących decyzji potrzebna jest możliwość wytłumaczenia powodów konkretna decyzja została podjęta. Możliwości SI do wykrywania zależności i wzorców, które nie są łatwo interpretowalne przez człowieka szczególnie utrudnia to zadanie. Jednocześnie niemożliwe jest wykluczenie błędów ludzkich podczas pracy nad SI czy też podczas zbierania danych co wyklucza możliwość tworzenia zawsze idealnych systemów którym można zaufać. Dlatego wyjaśnienie na jakiej zasadzie uzyskany konkretny rezultat przez SI jest potrzebny do zaufania jej lub też do jej poprawy.

Techniki tworzenia Explainable AI zapewniają przynajmniej częściowe rozwiązanie tego problemu jednak nie zawsze są możliwe do wprowadzenia np. poprzez zwiększenie wymaganych zasobów obliczeniowych krytyczne systemy których skuteczność działania zależy od prędkości podjęcia decyzji nie będą działać optymalnie jeżeli wykorzystano by w nich XAI. W takich sytuacjach dostępne są inne opcje takie jak Audyty AI. Pozwalają one zweryfikować działanie SI bez ingerencji w działanie samej systemu SI zachowując ja w optymalnie stworzonej wersji.

Ostateczna decyzja dotycząca zastosowania XAI w konkretnym przypadku zależy od wielu czynników, takich jak rodzaj modelu AI, kontekst biznesowy, priorytety i dostępne zasoby. Jeżeli istnieje możliwość wprowadzenia tych technik do systemu SI i nie istnieją żadne oczywiste przeciwskazania zastosowanie ich powinno przynieść pozytywny skutek podczas weryfikacji działania systemu oraz zmniejszy koszty jego utrzymania.

Literatura:

- https://towardsdatascience.com/real-life-examples-of-discriminating-artificial-intelligence-cae395a90070

- https://www.softwareimprovementgroup.com/unraveling-the-incomprehensible-the-pros-and-cons-of-explainable-ai/#:~:text=An%20area%20gaining%20significant%20attention,unwanted%20bias%2C%20manipulation%20and%20unfairness.

- https://www.ibm.com/watson/explainable-ai

- https://www.pewresearch.org/internet/2021/06/16/experts-doubt-ethical-ai-design-will-be-broadly-adopted-as-the-norm-within-the-next-decade/