Rośnie ilość informacji, metody jej przetwarzania, interpretacji i wizualizacji. Maleje jednocześnie możliwość jej analizy z poziomu jednostki. Dostęp do nieograniczonej ilości danych z jednej strony wydaje się pozwalać na ‘dotarcie do prawdy’; wszakże każdy ma możliwość szybkiego zapoznania się z niezliczonymi informacjami na dowolny temat. Z drugiej strony ten sam dostęp nas ‘oddala od prawdy’; bo w zatrzęsieniu informacji jak łzy w deszczu rozpływają się informacje nierzetelne, niesprawdzone, błędne, czy wręcz po prostu sfałszowane. Duża ilość informacji skazuje jednostkę, której zależy na rzetelności na niekończące się filtrowanie informacji i ich przyswajanie. Ta obserwacja prowokuje pytanie, czy ów dostęp do informacji zasadniczo ułatwia naukę i usprawnia procesy myślowe, czy raczej komplikuje wszelkie inicjatywy rozwoju i uświadamia tylko, jak niewiele ostatecznie wiemy na pewno, i że żyjemy zaledwie w świecie narracji? Wolny dostęp do informacji to nasza niemierzalna korzyść, czy raczej wyrok niepewności?

Pojęcia Big Data oraz sieci semantycznej

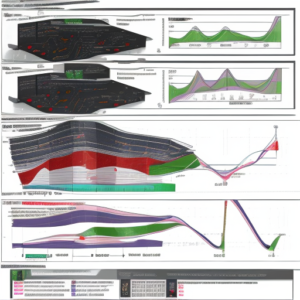

Big Data to nic innego niż zbiór danych. Dane te mogą dotyczyć czegokolwiek, co jesteśmy w stanie uchwycić, skonceptualizować i opisać słowami, oczywiście zapisane w formie cyfrowej na odpowiednim nośniku. Big Data posiada strukturę na tyle złożoną, że nie istnieje jego jedna, zamknięta, zupełna definicja. Ta złożoność wynika z faktu ciągłego rozwoju technologii, do której stale dołączane są nowe techniki przetwarzania danych. Popularnym sposobem definiowania Big Data jest definicja deskryptywna poprzez podanie najistotniejszych parametrów zbiorów danych. Mowa jest o łącznie sześciu określeniach na ‘V’: volume, variety, velocity, veracity, variability oraz value (Gondomi, Haider 2015). Innymi słowy dane w tych zbiorach cechuje kolejno duża ich ilość, wysoka różnorodność oraz duża częstotliwość aktualizacji, dosłownie szybkość, a także wiarygodność, zmienność przepływu danych oraz wartość danych.

Przyjmuje się obecnie, że o Big Data jest mowa gdy wielkość zbioru danych mierzona jest przynajmniej w terabajtach, jednak granica ta może się przesunąć dalej w przyszłości wraz z rozwojem technologii przechowywania danych.

Różnorodność dotyczy struktury zbioru i jest uznawana za wysoką, gdy ten składa się z danych o różnym stopniu ustrukturyzowania. Zdjęcia, filmy i muzyka to dane nieustrukturyzowane, które muszą być reprezentowane przez meta-dane albo reprezentacje ustrukturyzowane w postaci na przykład wektorów. Natomiast do ‘bazowo’ ustrukturyzowanych danych zaliczymy jedynie tabele i relacyjne bazy danych, które stanowią 5% istniejących danych w ogóle.

Szybkość bazy danych odnosi się do szybkości z jaką nowe dane są generowane, analizowane i z jaką algorytmy mają podejmować określone działania w reakcji na przyrost ilości treści.

Wiarygodność to parametr definiujący jak bardzo na zbiorze danych ‘można polegać’ w konkretnym celu, określa możliwość występowania nieprawdziwych danych. Zbiór opinii rozsierdzonych klientów biura płatnego parkowania może nie być reprezentatywnym zbiorem danych dla rekonstrukcji nastawienia przeciętnego posiadacza samochodu do pracowników biurowych. Emocjonalne nastawienie wpłynęło negatywnie na ocenę rzeczywistości.

O zmienności zbioru danych decydujemy w zależności od tego jak bardzo równomiernie w czasie rozłożone są wpłynięcia nowych danych do zbioru. Zbiór danych giełdy papierów wartościowych będzie cechował się szalenie wysoką zmiennością, obfitującą w okresowe spadki i wahania.

Wartość danych jest wypadkową ich treści i ilości. Jest rozumiana jako potencjał biznesowy, możliwość generowania zysków z bazy dzięki informacjom z niej wydobytym. Może rosnąć w miarę przetworzenia bazy danych.

Poza Big Data możemy mówić także o tworze Tima Bernersa-Lee, twórcy standardu World Wide Web, który opracował nową technologię o nazwie sieci semantycznej. W swoim zamyśle jest to rozszerzenie www oparte o semantyczne metadane, czyli tagi, które algorytmy sztucznej inteligencji są w stanie przeanalizować, aby trafniej podpowiadać odpowiednie wyniki dla choćby zapytań w wyszukiwarkach. Można powiedzieć, że dzięki nim algorytm będzie w stanie transkontekstualnie ‘kojarzyć’ układy pewnych danych z innymi w skomplikowanej siatce relacji (WEB1).

Podsumowując ten paragraf: struktura Big Data jest tak złożona, że tradycyjne, oparte jedynie o ludzką ingerencję metody przeglądania informacji, ich filtrowania i interpretowania zawodzą. Jednocześnie sektory medycyny, nauki, marketingu wymagają przetwarzania takiej ilości danych. Stąd rodzi się popyt na przetwarzanie danych w oparciu o efektywniejsze technologie, które na podstawie odpowiednich danych wejściowych szybko i niezawodnie mogłyby zaopatrzyć daną grupę odbiorców w odpowiednią prognozę epidemiologii, dostosowanie oferty handlowej, czy też personalizację treści w serwisie filmowym. Internetowe agregaty przechowują informacje na temat zdarzeń, osób, odkryć naukowych i osiągnięć technologicznych w ogromnej sieci, w której każdy element jest ze sobą powiązany.

Rozwój Big Data i sieci semantycznych: niewątpliwe korzyści

Powiedzmy sobie krótko o kilku wybranych przeze mnie korzyściach płynących z rozwoju technologii sieci semantycznych i Big Data, z których zapewne każdy z czytelników zdaje sobie sprawę. Big Data wymaga rozwoju algorytmów uczenia maszynowego i sztucznej inteligencji, tym samym jednocześnie napędzając związane z nimi innowacje technologiczne. Usprawnienie w zbieraniu, przechowywaniu oraz przetwarzaniu danych wymaga stworzenia miejsc w pracy w sektorze produkcji, marketingu, zarządzania i projektowania technologii. Pojawia się więcej nowych urządzeń codziennego użytku, które pozwalają na ułatwienie do tej pory karkołomnych zadań. Rośnie także wydajność i funkcjonalność już istniejących urządzeń. Rosną możliwości badawcze naukowców i pojedynczych zainteresowanych jednostek, które łatwiej mogą znaleźć stosowną literaturę do sproblematyzowania swojej pracy naukowej lub przeprowadzić globalne badanie online. Poza tym pojawiają się nowe metody edukacji – na odległość w czasie rzeczywistym, czy w oparciu o wcześniej przygotowane materiały tekstowe i wideo. Relacyjna struktura danych w internecie pozwala przeciętnemu użytkownikowi mimo wszystko jako poruszać się po ich zmiennym ogromie. Łatwo znaleźć specjalistyczne strony poświęcone wąskiej dziedzinie życia, nowe książki, czy artykuły; łatwo jest znaleźć więcej informacji, a więc, zdawałoby się, wydać kompetentną i poinformowaną opinię na dowolny temat, który tylko zapragniemy w zależności od potrzeby. Wszystko to w dopracowanej estetyce skrupulatnie zaprojektowanego interfejsu użytkownika, który każdy z nas doceni za ułatwienia w dostępie, przejrzystość i nie angażowanie już i tak przeładowanego umysłu.

Z tego ustępu wynika, że Big Data i sieci semantyczne pozwalają na oszczędność czasu, zwiększają nasze kompetencje operacyjne, a ponadto sprawiają, że jesteśmy lepiej poinformowani.

Ciemna strona rozwoju technologii: niepoprawny optymizm technologiczny?

W 2017 roku ukazała się metaanaliza 81 artykułów naukowych, których autorzy starali się opisać wpływ technologii na styl życia człowieka. Jedynie kilka z nich zawierało komponent krytyczny, to znaczy poruszało także negatywne konsekwencje wpływu technologii na ludzkie życie (Hanafizadeh, Ghandchi, Asgarimehr, 2017). Wydaje się więc, że istnieje pewien deficyt w technologicznym dyskursie, przez który łatwo można popaść w ignorancję. Jak wcześniej wspomniałem podejrzewam, że każdy z nas posiada w swojej wiedzy tła możliwe racjonalizacje użytkowania każdego swojego elektronicznego narzędzia oraz gadżetu. Dlatego poniżej poświęcam sporo uwagi jedynie możliwym negatywnym konsekwencjom ich używania.

Artykuły w popularnych internetowych czasopismach zdradzają powoli rosnący niepokój w stosunku do technologii, którą chyba możemy już określić w naszym społeczeństwie wszechobecną. Coraz częściej mowa o przebodźcowaniu czy przeładowaniu informacyjnym. W jednym z artykułów przeczytamy:

Przeciążenie informacyjne to stan, w którym czujemy się przytłoczeni ilością informacji do tego stopnia, że czujemy się bardziej zdezorientowani niż posiadamy wiedzę na dany temat. Przeładowanie informacjami może objawiać się mgłą mózgową i trudnościami w podejmowaniu decyzji. (WEB2)

Neuronaukowiec Daniel J. Levitin pisze, że nadmiar informacji jest spowodowany nieumiejętnością priorytetyzacji zadań i aktywności. Ta niepewność sieje spustoszenie w naszym systemie szybkiej kategoryzacji percepcyjnej, powoduje stres i prowadzi do przeciążenia decyzyjnego – pisze. Rezultatem jest kognitywne przeładowanie; przeciążenie i nadmierna stymulacja mózgu, która niesie poważne psychologiczne skutki, od wydzielania hormonu stresu, po nieumiejętność podejmowania ważnych decyzji w codziennym życiu (WEB3). Mózg ma ograniczoną umiejętność chłonięcia informacji oraz ograniczone zdolności do utrzymania selektywnej uwagi. Przyzwyczaja się do ignorowania ogromnej ilości niepotrzebnych mu danych zmysłowych i ciągłego zmieniania obiektu skupiania uwagi. W rezultacie informacje istotne mogą zostawać zignorowane podobnie jak migający LED-owy panel informacyjny wyświetlający reklamy w galerii handlowej. Jednocześnie ilość przyswajanych informacji średnio rośnie co roku o 5% w stosunku do roku poprzedniego (WEB4).

Gubimy w się semantycznej sieci internetu. Informacje, którymi się przeciążamy w serwisach społecznościowych, telewizji, czy nawet na ulicy mają to do siebie, że nie możemy być ich przy tym pewni. Załóżmy, że chcemy uczestniczyć w ambitnej dyskusji, gdzie jednak pewnego rodzaju rzetelność byłaby wymagana. Chęć budowania rzetelnej wiedzy prowokuje więc do skierowania uwagi na artykuły naukowe, których metodologia badawcza musiała przecież zapewnić im formułę pewnych wniosków. Używamy więc jednego z narzędzi AI i na zapytanie o prace naukowe na konkretny temat otrzymujemy wykaz dziesięciu tekstów, które wystarczy ze zrozumieniem przeczytać, aby osiągnąć ten już niemal mistyczny stan wiedzy, ‘znania się’ na temacie. I tu jednak kryje się problem, który dla przeciętnej osoby nie jest możliwy do samodzielnego rozstrzygnięcia: w nauce już od półtorej dekady mowa jest o tak zwanym kryzysie replikowalności. W 2006 roku wykazano, że spośród 141 autorów publikacji dla American Psychological Association (APA) aż 103 nie udzieliło odpowiedzi na prośbę o udostępnienie dokładnej dokumentacji badawczej, która mogłaby pomóc zweryfikować, czy nie dopuszczono się przewinień metodologicznych (Wicherts, Borsboom, Kats, Molenaar, 2006). W 2009 roku ukazał się artykuł, według którego 2% zapytanych badaczy dopuściło się sfabrykowania, sfalsyfikowania lub modyfikacji wyników swoich badań. 33% przyznało się do innych niezgodnych ze sztuką praktyk. Jednocześnie na pytanie, czy inni badacze dopuścili się falsyfikacji udzielono odpowiedzi twierdzącej w 14% przypadków, a w 72% mowa była o wątpliwych praktykach badawczych (Fanelli 2009). Zachodzi swoisty dysonans między wartościami procentowymi dotyczącymi samych badaczy a ich kolegów po fachu. W roku 2015 ponowiono prośbę i znów poproszono badaczy APA o udostępnienie dokumentacji, którą spośród 394 badaczy aż 246 zignorowało (Vanpaemel, Vermorgen, Deriemaecker, Storms, 2015). W tym samym roku w czasopiśmie Science ukazało się badanie, które podjęło próbę zreplikowania stu badań psychologicznych opublikowanych w prestiżowych czasopismach naukowych z roku 2009. Wnioski takie same jak 6 lat wcześniej zaobserwowano jedynie w 36% przypadków (Open Science Collaboration 2015). Według kwestionariusza, który ukazał się w Nature rok później 70% naukowców medycyny przyznaje się, że chociaż raz nie udało się im zreplikować cudzej pracy. Taki sam procent reprezentuje problem replikowalności w dziedzinie fizyki i inżynierii. Dla biologii jest to 80%, natomiast dla chemii – już 90% (Baker 2016). Zachodzi domniemanie, iż wielu badaczy i wydawców artykułów naukowych celowo dopuszcza się naruszenia zasad metodologii aby przekroczyć próg wyniku istotnego statystycznie, a w rezultacie – opublikować badanie i odnieść korzyści finansowe, lub po prostu nadać sens swojej pracy jako badacza. Większość wyników nie jest testowana ponownie, a te, do których próby zreplikowania dochodzi, często okazują się nie dać się powtórzyć. Co to oznacza? Otóż systematycznie niedopełniana jest formalna podstawa dla rzetelności metody naukowej, a nauka nie spełnia swojej roli w przekazywaniu nie-naukowcom wiedzy, na której mieliśmy móc polegać. Mamy do czynienia z natłokiem informacji niepotrzebnych i nierzetelnych, natomiast te, które chcielibyśmy powszechnie uznawać za przynajmniej dążące do prawdy – nie mogą być traktowane z pełnym zaufaniem. Niemożność sformułowania kryteriów, na podstawie których można by rozróżnić prawdę od nieprawdy powoduje uczucie niepewności nawet w najbardziej podstawowych kwestiach, wymusza na człowieku zachowanie postawy ostrożności i bardzo instrumentalne używanie tego pojęcia, nie wspominając o konieczności podjęcia prawdziwie ekstensywnych poszukiwań, jeśli chcemy móc mówić o szczerej pewności co do jakiegokolwiek stwierdzenia.

Big Data jest używane do profilowania określonych grup ludzi w oparciu o informacje zebrane o ich upodobaniach. Interfejsy użytkownika są projektowane tak, aby były jak najwygodniejsze dla docelowej grupy odbiorców i minimalnie angażowały funkcję myślenia. Łatwo dostrzegamy korzyści tego podejścia – życzymy sobie, aby forma w której poruszamy się w materii sieci była możliwie jak najbardziej praktyczna. Tutaj wyobrażam sobie jednak stronę jednego z dużych producentów sprzętu elektronicznego, elegancki minimalny design i niemal podprogowy przekaz retoryki nagłówków „kup teraz”, czy „twoje korzyści”. Być może czytelnik uzna to za śmiałe wyobrażenie, ale w mojej głowie okraszone jest to kulturą wygodnej ignorancji (bo mam wrażenie, że tak często objawia się ta wygoda) i cichego przyzwolenia na wydatkową impulsywność oraz idealizowanie emocji, to znaczy traktowanie ich jako przesłanki w procesie decyzyjnym. Producenci tak projektują swoje produkty, aby te były jak najbardziej interesujące, innowacyjne, wygodne w obsłudze – nie dyskutujemy o zasadności tych dążeń i pozytywach stojących za tą praktyką. Ale ‘ułatwienia’ i ‘wygody’ to hasła, które coraz częściej kojarzą mi się z wyrachowaną generacją popytu na nową technologię samym faktem tego, że jest ona nowa w stosunku do poprzedniej generacji. Znów ośmielę się twardo stwierdzić, że kultura o której mówię ochoczo szerzy bezkrytyczny technologiczny optymizm, a to ku uciesze największych korporacji. Specyfikacje techniczne sprzętów kuszą pobudzającymi umysł opisami, objaśnieniami w czym pomaga 4% wydajniejszy procesor, a na koniec tłumaczą perswazyjnie karygodnie wysoką cenę za produkt. Istnienie rachunku strat często uświadamiany jest dopiero przez rodzinę lub, w gorszych przypadkach, przez psychiatrów, którzy podejrzewają uzależnienie od kupowania nowych gadżetów i zbyt wysoką podatność na reklamową sugestię. Rachunek strat zawiera: rosnący udział wydatków na technologię w miesięcznej estymacji finansowej przeciętnego konsumenta, deprywację snu, wyższe ryzyko otyłości, wrażliwość na chroniczne choroby, utratę sprawności poznawczej, pogorszone umiejętności podejmowania decyzji, potencjalnie problemy w życiu towarzyskim, a ponad to wszystko problemy psychiczne, w tym zaburzenia osobowości, niskie poczucie własnej wartości, derealizację i depresję (WEB7, WEB8, WEB9).

Z tego ustępu wynika, że technologia pomniejsza nasze kompetencje intelektualne, a ponadto sprawia, że jesteśmy gorzej poinformowani, jesteśmy chorzy i przez to nie żyje się nam wygodnie.

Podsumowując

Wszystko to ma wpływ na kondycję współczesnego człowieka, jego umiejętność do podejmowania decyzji, poczucie bycia wartościowym składnikiem społeczności. Wzrastająca ilość danych to, poza oczywistymi korzyściami stojącymi za hasłem „możliwość dostępu”, także konsekwencja jaką jest przebodźcowanie. Przez ‘mózgową mgłę’ staramy się odszukać stabilny grunt w nauce, która jednak sama boryka się z konsekwencjami problemu masowości niskiej jakości badań. Na koniec ukaja nas wymagająca jedynie odbiorczości i minimalnej reakcyjności forma aplikacji zaprojektowanych tak, aby spędzić w nich jak najwięcej czasu. Mózgowa mgła otrzymuje pozytywne sprzężenie zwrotne i zamyka się w błędnym kole. Szczęścia upatrujemy się w pojedynczych zdaniach niezłożonych zawierających imperatyw nawołujący do poświęcania większej ilości czasu wspaniałym funkcjom swojego nowo zakupionego sprzętu mobilnego, którego pełnych możliwości zazwyczaj nie będziemy w stanie wykorzystać. Nie powinniśmy dawać sobie zasugerować narracją przyzwalająca na bezkrytyczne podejście do wydawania, że ostatecznego szczęścia w życiu mamy się dopatrywać w posiadaniu. Im więcej technologii – tym więcej pieniędzy wydajemy i tym bardziej obligujemy się do poświęcania uwagi jej konserwacji. Dostęp do dużej ilości informacji stanowi szansę na lepsze poinformowanie się i zwiększenie kompetencji poznawczych, ale też zagrożenie gorszego poinformowania i zmniejszenia się kompetencji umysłowych. Truizmem jest stwierdzenie, że rola edukacji i krytycznego myślenia jest kluczowa – to oczywiste. Aby wyrwać się z błędnego koła potrzebujemy przede wszystkim świadomości problemu, a potem pierwszego postanowienia przybrania krytycznej postawy. Od pierwszego postanowienia rozpoczyna się dążenie do samodyscypliny. Technologia to narzędzie. Dobrze, jeśli używa jej się nam wygodnie, jednak co to za wygoda, która absorbuje całe nasze pokłady uwagi? Celem nadrzędnym nie powinna być wygoda użytkowania, tylko spokój użytkowania.

Literatura

Źródła ogólne:

Tegmark, M. (2018). Life 3.0: Being human in the age of artificial intelligence. Vintage.

Metaanaliza 81 tekstów na temat IT:

Hanafizadeh, P., Ghandchi, S., & Asgarimehr, M. (2017). Impact of information technology on lifestyle: A literature review and classification. International Journal of Virtual Communities and Social Networking (IJVCSN), 9(2), 1-23.

Big Data:

Gandomi, A., & Haider, M. (2015). Beyond the hype: Big data concepts, methods, and analytics. International journal of information management, 35(2), 137-144.

Sieci semantyczne:

WEB1: https://dhosting.pl/pomoc/baza-wiedzy/czym-jest-semantyczna-siec-semantic-web/

Przebodźcowanie i przeciążenie mózgu:

WEB2:https://medium.com/@tunikova/are-we-consuming-too-much-information-b68f62500089

WEB3: https://lesley.edu/article/why-brain-overload-happens

WEB4: https://kids.frontiersin.org/articles/10.3389/frym.2017.00023

Problem replikowalności:

Baker, M. (2016). 1,500 scientists lift the lid on reproducibility. Nature, 533(7604).

Open Science Collaboration. (2015). Estimating the reproducibility of psychological science. Science, 349(6251), aac4716.

Fanelli, D. (2009). How many scientists fabricate and falsify research? A systematic review and meta-analysis of survey data. PloS one, 4(5), e5738.

Vanpaemel, W., Vermorgen, M., Deriemaecker, L., & Storms, G. (2015). Are we wasting a good crisis? The availability of psychological research data after the storm. Collabra, 1(1), 3.

Wicherts, J. M., Borsboom, D., Kats, J., & Molenaar, D. (2006). The poor availability of psychological research data for reanalysis. American psychologist, 61(7), 726.

WEB5: https://pl.wikipedia.org/wiki/Odtwarzalno%C5%9B%C4%87_(badania_naukowe)

WEB6: https://en.wikipedia.org/wiki/Reproducibility

Problem zbyt dużej roli technologii:

WEB7: https://www.techbusinessnews.com.au/how-much-technology-is-too-much/

WEB8: https://time.com/6174510/how-much-screen-time-is-too-much/