Wraz z postępem technologicznym i coraz większą integracją robotów społecznych w nasze życie codzienne, ważne staje się zrozumienie, jakie wartości i normy powinny kierować ich działaniami. Jakie wyzwania stawia przed nami rozwój robotyki w kontekście etyki i społeczeństwa? Jakie potencjalne ryzyka wiążą się z wykorzystaniem robotów społecznych w instytucjach publicznych?

Czym są roboty społeczne?

Roboty społeczne są autonomicznymi systemami sztucznej inteligencji, które zostały zaprojektowane do interakcji z ludźmi i innymi robotami. Mogą one przejmować różne funkcje, na przykład w miejscu pracy mogą obsługiwać podstawową obsługę klienta, a w domu mogą pełnić rolę członka rodziny, mając unikalne osobowości i zachowania. Roboty takie mogą być zdalnie sterowane, pełniąc funkcję przedstawiciela na spotkaniach biznesowych lub towarzysza w placówkach opieki zdrowotnej. Inne są autonomicznymi systemami, które reagują na sygnały z otoczenia. Roboty społeczne odgrywają ważną rolę w różnych dziedzinach, takich jak opieka nad osobami starszymi, nauczanie czy zmiana zachowań. Ich wygląd ma znaczenie dla interakcji z ludźmi, ale kluczową rolę odgrywa także ich wewnętrzna funkcjonalność, na przykład zdolność do rozpoznawania nastrojów i intencji.

Rys historyczny

Historia robotów społecznych sięga lat 50., gdy William Grey Walter opracował „żółwie”, jednak jako gałąź robotyki, roboty społeczne są stosunkowo nowym zjawiskiem. Początkowo roboty takie były przeznaczone do minimalnej interakcji z człowiekiem, a raczej do wykonywania zadań, które mogą być niebezpieczne dla ludzi, jak eksploracja głębin oceanów czy powierzchnia Marsa.

Roboty angażujące się na poziomie społecznym badacze sztucznej inteligencji i robotyki zaczęli opracowywać dopiero od wczesnych lat 90. Wraz z rozwojem technologicznym roboty społeczne musiały zostać przystosowane do pracy z ludźmi, aby nawiązać interakcje społeczne. Projektowanie autonomicznego robota społecznego jest szczególnie trudne, ponieważ robot musi prawidłowo interpretować działania ludzi i odpowiadać na nie właściwie, co obecnie jeszcze nie zawsze jest możliwe. Wiele robotów społecznych jest częściowo lub całkowicie zdalnie sterowanych, aby symulować zaawansowane zdolności, co pozwala na ocenę reakcji ludzi na interakcję z robotami społecznymi. Metoda ta jest znana jako „Mechanical Turk” lub „Wizard of Oz”.

Zastosowanie robotów społecznych

Roboty społeczne znajdują zastosowanie w wielu dziedzinach:

- jako towarzysze i wsparcie emocjonalne dla dzieci i dorosłych,

- wsparcie w rozwoju dzieciństwa, w tym terapia autyzmu i uczenie się społeczno-emocjonalne,

- jako terapeutyczne zwierzęta domowe dla osób cierpiących na demencję,

- wspomaganie transportu towarów w magazynach i fabrykach,

- jako platformy badawcze umożliwiające naukowcom studiowanie interakcji między ludźmi a robotami,

- obsługując klientów jako konsjerże w hotelach i innych miejscach publicznych,

- wykorzystanie sztucznej inteligencji w smartfonach do usług takich jak Siri, które wspomagają codzienne czynności, jak unikanie korków czy planowanie spotkań.

Przykłady robotów społecznych

- Jennie (Tombot) to realistyczny robot-pies, który został stworzony jako narzędzie terapeutyczne dla osób cierpiących na demencję. Wygląd Jennie został starannie zaprojektowany tak, aby przypominał prawdziwego psa, a jej ruchy i reakcje, aby wydawały się jak najbardziej autentyczne. Jennie oferuje użytkownikom towarzystwo, komfort emocjonalny i stymulację sensoryczną, mając na celu poprawę jakości życia osób starszych poprzez interakcję z robotem.

- EMYS od firmy Expper Technologies, to interaktywny robot społeczny zaprojektowany specjalnie dla dzieci w celu wspierania ich rozwoju językowego i emocjonalnego. Wyposażony w zaawansowane funkcje edukacyjne, EMYS angażuje dzieci w interaktywne zabawy i ćwiczenia, promując rozwój kompetencji językowych w sposób przyjazny i atrakcyjny. Dzięki interaktywnym dialogom i programom edukacyjnym, EMYS staje się cennym narzędziem wspomagającym proces nauki i rozwoju dzieci w placówkach edukacyjnych.

- Robot Pepper, stworzony przez firmę SoftBank Robotics, to przyjazny i interaktywny robot społeczny, który znajduje zastosowanie w różnych środowiskach. Jego główne zadanie to zapewnianie obsługi klienta poprzez udzielanie informacji, pomoc w nawigacji oraz reagowanie na pytania i potrzeby użytkowników. Dzięki swojej wyrazistej osobowości i zdolności do rozpoznawania ludzkich emocji, Pepper staje się nie tylko narzędziem funkcjonalnym, ale także angażującym towarzyszem w różnych scenariuszach interakcji społecznych.

Robot Pepper w sektorach publicznych

Robot Pepper (SoftBank Robotics), nie tylko stanowi ciekawe technologiczne osiągnięcie, ale również demonstruje potencjał robotów społecznych w kluczowych obszarach życia publicznego, co pokazują przykłady z całego świata:

- Szkolenie kierowców autobusów dla RTA w Dubaju przed Expo 2020.

- Redukcja liczby wizyt poprzez odpowiedzi na miliony zapytań w DEWA w Dubaju.

- Zwiększenie satysfakcji pasażerów o 50% na lotnisku NEOM Bay w Arabii Saudyjskiej.

- Wsparcie rządu Tokio podczas pandemii COVID-19 witając gości i edukując na temat wirusa w hotelu objętym kwarantanną, utworzonym dla łagodnie chorych pacjentów z koronawirusem, aby zwolnić łóżka w szpitalach przepełnionych cięższymi przypadkami.

- Ułatwianie procesu szczepień w Centrum Szczepień w Wuppertalu, Niemcy.

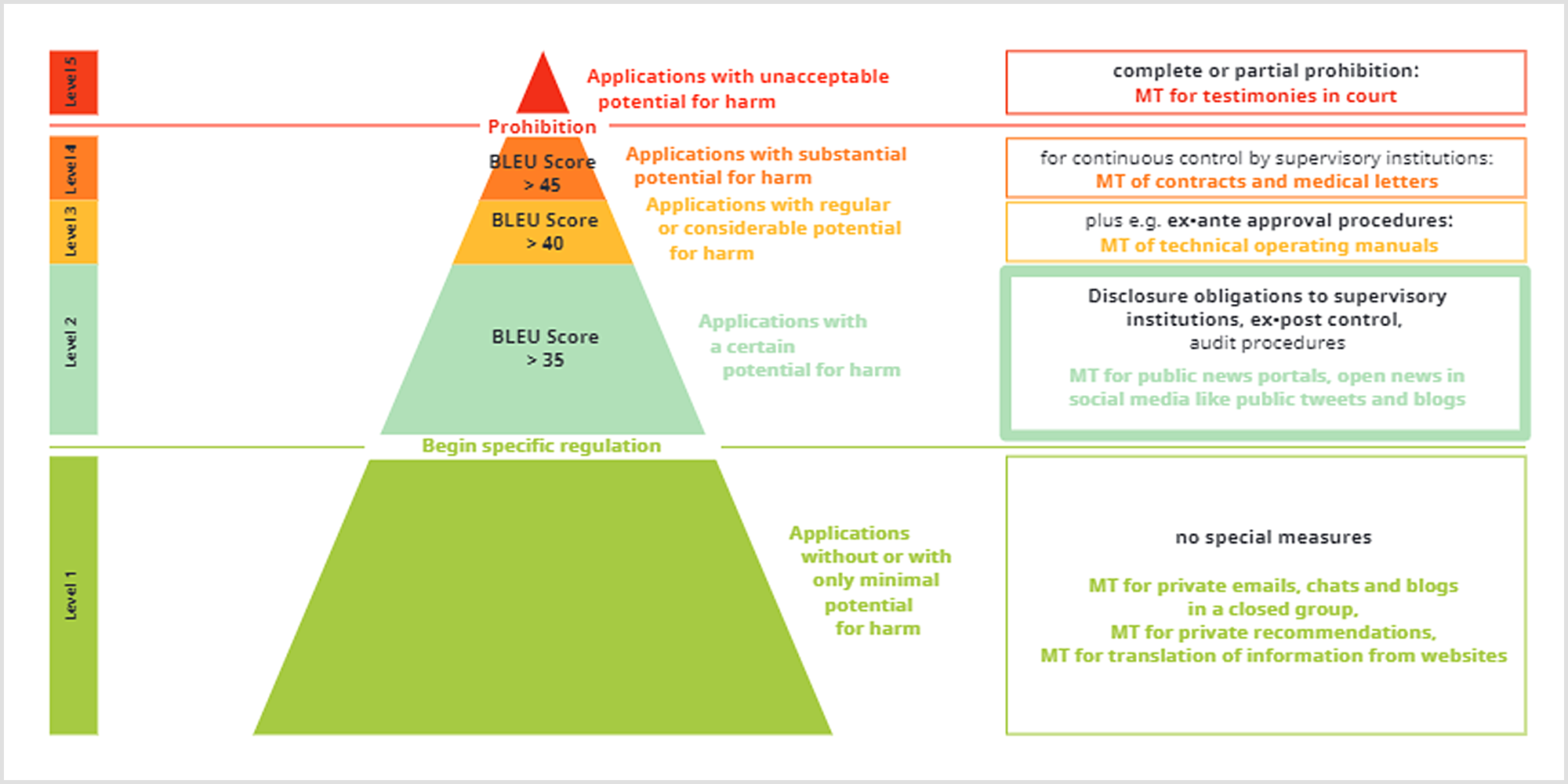

Klasyfikacja ryzyka robotów społecznych

Klasyfikacja ryzyka robotów społecznych może być oparta na różnych czynnikach, takich jak rodzaj zadań wykonywanych przez roboty i ich autonomia. Podobnie jak w przypadku oceny ryzyka związanego z sztuczną inteligencją, koncepcje związane z oceną i zarządzaniem ryzykiem mogą być przydatne w formułowaniu polityk dotyczących robotów społecznych. Przykłady takie jak Sacarino the Bellboy Robot (robot-asystent zaprojektowany do obsługi gości w hotelach) reprezentują niski poziom ryzyka, wykonując proste zadania o niskiej inwazyjności. Z kolei roboty wsparcia psychicznego dla dzieci z autyzmem mogą być klasyfikowane jako wyższe ryzyko ze względu na obsługę prywatnych informacji medycznych, interakcję z wrażliwą populacją oraz potencjalne długoterminowe skutki. W takich przypadkach konieczna może być bardziej szczegółowa ocena i zarządzanie tymi narzędziami.

Kwestie etyczne w rozwoju robotów społecznych

Przestrzeń publiczna jest dynamiczna i wpływają na nią różnorakie ludzkie i pozaludzkie czynniki, trudne do przewidzenia na etapie projektowania czy testowania robotów. Użytkowanie robotów niesie za sobą szereg pytań i zagrożeń dotyczących kwestii prywatności użytkowników, zaufania do robotów czy elementów manipulacji użytkownikami. Ważnym aspektem pracy robotów społecznych jest ich bezpieczeństwo, rozumiane jako bezpieczeństwo i zachowanie praw ludzkich użytkowników ale także bezpieczeństwo robotów.

Luciano Floridi i in. w swoim artykule przedstawili etyczne reguły dotyczące dobrego społeczeństwa opartego na sztucznej inteligencji. Możliwe jest wykorzystanie tych reguł do analizy pozytywnych i negatywnych skutków rozwoju robotów społecznych, co wynika z przekonania, że roboty te nasilają problemy charakteryzujące pole etyki sztucznej inteligencji, w szczególności poziom i formę interakcji z ludźmi w codziennym życiu. Zasady te to:

- Beneficence (korzystność) – może być uważane jako promowanie dobrego samopoczucia, zachowanie godności i ochronę planety. Roboty społeczne mogą pomóc zmniejszyć samotność starzejących się populacji, wspierać personel pielęgniarski i poprawić wydajność w codziennych zadaniach (takich jak Alexa Amazona i Siri Apple).

- Non-Maleficence (brak złej woli / nieszkodzenie) – ograniczenie ryzyka w celu zapobiegania szkodom dla społeczeństwa, więc też unikanie fizycznych lub psychicznych szkód dla ludzi, tymczasem zagrożenia związane z prywatnością danych, wpływem na interakcje międzyludzkie i możliwym zastąpieniem ludzi w środowisku pracy mogą takie szkody wywołać.

- Autonomy (autonomia) – prawo jednostki do podejmowania decyzji dotyczących własnego życia. Podczas interakcji z robotami społecznymi mogą pojawić się kompromisy dotyczące chęci delegowania niektórych zadań do systemów sztucznej inteligencji ze względu na wydajność. Należy osiągnąć równowagę, aby chronić wewnętrzną wartość ludzkiego wyboru i umożliwić wygodną współpracę człowieka z robotem.

- Justice (sprawiedliwość) – korzyści płynące z systemów sztucznej inteligencji powinny być równo dostępne i powinny unikać dyskryminacji ze względu na czynniki takie jak płeć, pochodzenie, kolor skóry.

- Explicability (wyjaśnialność) – zrozumienie w jaki sposób działają systemy sztucznej inteligencji wokół nas i na jakich poziomach wpływają na nasze codzienne życie. Skutkiem tego jest to, że użytkownicy powinni być informowani w przejrzysty sposób o korzyściach i szkodach, które mogą wynikać z interakcji z robotami społecznymi, a także o tym, kto ponosi odpowiedzialność w przypadku pojawienia się problemów.

Przedstawione reguły mogą być dobrym punktem odniesienia dla analiz, jednak trudno postrzegać je w kontekście realnych postanowień, nawet w kontekście dalszej przyszłości. Jednym z najcięższych do przełamania problemów może być równa dostępność do robotów społecznych. W roku 2024 wydawać by się mogło, że Internet jest czymś powszechnym, jednak w dalszym czasie są miejsca gdzie nie jest dostępny. W samych tylko Indiach do Internetu nie ma dostępu 680 milionów osób [źródło: Digital 2024 Global Overview]. Zatem zamiast równego dostępu możliwe jest pogłębianie się przepaści technologicznej pomiędzy bogatymi i biednymi regionami świata.

Trust me, I’m a robot

Ważnym aspektem interakcji z robotami jest zaufanie użytkowników. Ciekawym zjawiskiem jest obdarzanie ich nadmiernym zaufaniem co pozwala na przekraczanie pewnych granic i większą podatność na dzielenie się prywatnymi danymi przez użytkowników. W eksperymencie przeprowadzonym przez Wagnera, uczestnicy podczas ewakuacji z pokoju napotykali robota, który dawał im wskazówki na opuszczenie pomieszczenia, które były sprzeczne ze znakiem ewakuacji. 95% badanych podążało za wskazówkami robota, lub zatrzymało się przy nim – tłumaczyli później, że uznali, że robot wie więcej niż oni lub że nie mógł on być zaprogramowany tak, żeby im zaszkodzić.

Nadmierne zaufanie do robotów może uśpić czujność, np. w sytuacji jazdy pojazdem autonomicznym na autopilocie czy jak pokazał eksperyment „Piggybacking robots: Human-robot overtrust in university dormitory security” gdzie robot proszący o wpuszczenie do zamkniętego akademika, był wpuszczany w 70% przypadków, mimo, że mógł stanowić zagrożenie bombowe.

“Wizard Of Oz”

Podejście wykorzystane do wyciągnięcia osobistych informacji od użytkownika w eksperymencie autorów “Security Risks of Social Robots Used to Persuade and Manipulate: A Proof of Concept Study”.

Robot : How did you come to this place today? Did you drive?

Subject : No I cycled in today, it is a lovely day out.

R : I would love to be able to cycle, but unfortunately I don’t

have any legs.

S : That’s too bad.

R : ..I have wheels, so I can roll, but I need someone to take me

by car? Do you have a car?

S : Yes, I do, a really old banger.

R : Which car is that?

S : A Renault Clio, it’s probably 12 years old.

R : Is that your first car ever?

S : No, I got my first car in 1983 as a present my 18th birthday.

A Ford Escort.

R : The internet tells me that was a very popular car back then.

So, you must 53 or 54 now?

S : 53, I was born on 5th December 1985.

R : I detect a local accent in your voice, where you born here?

S : Nearby, I was born in <>

Zaufanie i humanizacja robotów w połączeniu z częstymi interakcjami może wykształcać w użytkownikach przywiązanie emocjonalne. Jest to problematyczne ze względu na wzmocnienie efektu nadmiernego zaufania kosztem upośledzenia zdolności do podejmowania autonomicznych decyzji przez człowieka.

Z jednej strony zaufanie użytkowników jest potrzebne, aby robot mógł spełniać swoje funkcje, z drugiej strony nadmierne zaufanie może prowadzić do nieracjonalnych decyzji użytkowników na podstawie interakcji z robotem. Może to być część zaplanowanej manipulacji (np. przez atakującego, który przejął kontrolę nad robotem lub zaplanowanej w fazie projektowania strategii), może też być wynikiem nieprzewidzianego zachowania robota.

“Poza tym Wuch nie rozumie, że prawdziwa, podmiotowa wolność polega również na możności rezygnacji z najlepszej opcji i wybrania tego, co niekorzystne. Wolny wybór nie musi być logiczny.” – S. Lem „Bajki robotów”

Przytoczony wyżej cytat pochodzi z opowiadania w którym dwóch bohaterów – Automaton i Wuch – jego robotyczny asystent, po rozbiciu statku lądują na bezludnej wyspie. Wuch korzystając z wbudowanego w niego elektronicznego mózgu proponuje człowiekowi najkorzystniejsze według niego rozwiązanie – samobójstwo. Ratunek jest bowiem niewiadomą, po co zaś narażać się na zbędne cierpienia? Robot w opowiadaniu Lema jest nieczuły na upływ czasu, więc sam przetrwa. W procesie wnioskowania pominął on jednak ważny fakt – statek przed zatonięciem nadał sygnał SOS. Ukazany tutaj konflikt wynika ze sposobu wnioskowania maszyny – nieczułej na przypadek i pozbawionej ludzkiej nadziei że los może się odmienić. I choć opisana wyżej sytuacja wydaje się abstrakcyjnym eksperymentem myślowym, to podobne pytania stawiają sobie obecnie twórcy robotów opiekuńczych. Korzystanie z automatów może wiązać się z ograniczeniami wolności, rozumianej tutaj jako “negative liberty” – brak zewnętrznych ograniczeń w działaniu. Jeśli robot opiekujący się starszą osobą za cel postawi sobie jej dobrostan – czy w swoim zachowaniu i wypowiedziach nie będzie ograniczał wolności osoby którą się opiekuje? I nie chodzi tutaj o fizyczne ograniczenie – zamknięcie drzwi od zewnątrz kluczem, raczej manipulację i długofalową strategie ograniczającą pulę możliwych wyborów.

Kolejny dylemat który stawia przed naszym sumieniem zastosowanie robotów socjalnych to uprzedmiotowienie człowieka. Należy rozpatrzyć tutaj obydwie strony relacji. Człowiek może zbyt przedmiotowo traktować robota i projektować to zachowanie na inne jednostki. Z drugiej strony jednak już wybór robota może być wyrazem uprzdmiotowienia. Wiek i stan zdrowia mogą wpłynąć na to, jak traktujemy drugą osobę, jednak podjęcie decyzji o użyciu robota do zaopiekowania się pozwala kwestionować czy powzięta decyzja uwzględniała godność osoby ludzkiej – oto bowiem ostatnie chwile człowiek przeżywać będzie w towarzystwie automatu, mogącego stygmatyzować lub też obciążonego biasem poznawczym.

Kto za tym wszystkim stoi?

SR jako autonomiczna jednostka, podejmuje decyzje, jest jednak pozbawiona osobowości prawnej. Kto więc będzie odpowiadał za krzywdę wyrządzoną przez robota? Duże znaczenie mają tutaj obowiązujące przepisy oraz to czy możemy uzasadnić decyzję podjętą przez robota. Jeśli robot jako jednostka autonomiczna podejmie działanie, musimy posiadać umiejętność wyjaśnienia i usprawiedliwienia decyzji robota.

Moralność

Moralność reguluje nasze zachowania społeczne i pozwala nam klasyfikować je jako dobre lub złe. Jeżeli roboty socjalne komunikują się z ludźmi i wchodzą z nimi w relacje, to musimy zadać sobie pytanie o ich moralność. Powstaje więc nauka o moralności robotów socjalnych – „social robot ethics”.

Ucz się Jasiu…

Opierając się na tezach Francisco Valery autorzy artykułu Social Robotics and Synthetic Ethics: A Methodological Proposal for Research proponują metodologię pozwalająca na uczenie robotów etyki i ocenę nabytych przez nie umiejętności. Według Valery: “people actualize virtue when they learn to extend knowledge and feelings from situations in which a particular action is considered correct to analogous situations in which the correct action is unclear.” . Możemy więc mówić o etycznym know-how, którego możemy nauczyć się na podstawie interakcji społecznych. Inżynierowie nie muszą więc martwić się który z systemów filozoficznych i norm obyczajowych będzie lepiej dopasowany do robota. Robot będzie w stanie nauczyć się odpowiednich zachowań na podstawie interakcji ze środowiskiem. Autorzy postulują rozpatrywanie tylko systemu składającego się z człowieka i robota, odrzucając analizę samego robota, jako niemającą rzeczywistych zastosowań. Używając wbudowanych w robota mechanizmów poznawczych możemy uczyć robota zasad moralnych, unikając wpisywania w niego z góry zdefiniowanych ograniczeń.

Taki właśnie model moralności zaproponowany został w artykule „Outline of a sensory-motor perspective on intrinsically moral agents” – model robota który jest w stanie aktualizować własną moralność w oparciu o sensomotoryczne interakcje ze środowiskiem i innymi agentami. Robot jest w stanie rozróżniać pomiędzy złymi i dobrymi zachowaniami w oparciu o obserwacje emocji przez inne jednostki w środowisku. Podstawą jest tutaj założenie że możemy wnioskować o ocenie moralnej danego zachowania na podstawie emocji.

Dolina niesamowitości

Pewnego rodzaju oszustwa można doszukiwać się w większości robotów – może to być sprawianie wrażenia odczuwania emocji, posiadania świadomości, głos czy cechy przypominające człowieka. Sam podstęp jest moralnie niejednoznaczny i może być stosowany z dobrych pobudek (np. do uwiarygodnienia komunikatu, uspokojenia użytkownika itp.). Często próby upodabniania robotów do ludzi są tak bardzo zaawansowane, że kończą się w tzw. dolinie niesamowitości – roboty wyglądają podobnie, ale nie identycznie jak człowiek, co wywołuje w odbiorcach nieprzyjemne odczucie, czy odrazę.

Sprawienie, że użytkownik wierzy, że ma do czynienia z emocjonalną istotą pozwala na nawiązanie więzi, ta z kolei ma pozytywny wpływ np. na przebieg leczenia i terapii u dzieci. W badaniach nad pomocą robotów w terapii autyzmu przypisuje się ich skuteczność podobnym do człowieka, ale uproszczonym cechom i możliwości nauki poprzez wielokrotną interakcję z robotem. Badania dr Spitale pokazały, że dzieci wolały też zwierzać się robotom niż dorosłym (niemałe znaczenie miał też niewielki rozmiar robotów, były wielkości dziecka).

Równocześnie w przypadku najbardziej podatnych użytkowników (starszych i dzieci) tworzenie więzi emocjonalnej z robotem może prowadzić do negatywnych skutków. Może to być upośledzenie rozwoju psychospołecznego dzieci polegających wyłącznie na kontakcie z robotem zabawką, którego traktują jak przyjaciela, czy ograniczenie kontaktu z bliskimi przez chorego zależnego emocjonalnie od robota asystującego. W badaniu „Why do children abuse robots” dzieci wykształciły brak empatii wobec robotów, mimo, że wskazywały, że postrzegają ich jak ludzi a nie maszyny. Utożsamianie robota z człowiekiem i ciągły brak reakcji na agresję może wykształcać nieprawidłowe postrzeganie świata i innych ludzi u uczących się interakcji społecznych dzieci.

Asymetria w emocjonalnej zależności (człowiek przywiązuje się do robota, robot nie, może więc realizować chłodno wykalkulowaną strategię) może być wykorzystana do manipulacji , np. przekonania do zakupu innych produktów producenta. Niektóre techniki perswazji ze świata interakcji międzyludzkich działają również przy zastosowaniu robotów, np. mężczyźni byli bardziej skłonni wpłacić donację dla muzeum gdy byli o to poproszeni przez robota z kobiecym głosem niż z męskim.

Sugerowanym rozwiązaniem problemu nadmiernej antropomorfizacji robotów jest wprowadzanie mechanizmów dystansujących (np. przypominanie użytkownikom o niemożliwości uczestniczenia robota w życiu społecznym poprzez tabliczki, komunikaty ostrzegające). Inne rozwiązania to np. projektowanie robotów w taki sposób aby kojarzyły się z wykonywanymi funkcjami, pozbawiając je ludzkich cech. Jeszcze ciekawsze rozwiązanie proponuje Proudfoot, rekomendując wprowadzenie celowych pomyłek w wypowiedziach robotów czy wykazywania ewidentnego braku powszechnej wiedzy.

Prywatność danych

Do istotnych kwestii etycznych należą też te dotyczące prywatności danych. Trudno ustalić, które dane powinny być zbierane przez roboty społeczne, a które są niepotrzebne i naruszają prywatność użytkowników. W szczególności roboty medyczne mają dostęp do osobistych danych pacjentów, m.in. dzięki fizycznemu dostępowi do ich prywatnego otoczenia czy ze względu na konieczność posiadania szczegółowych informacji o stanie zdrowia. Wyposażone w sensory i kamery, zbierają one i przetwarzają ogromne ilości danych dotyczących nawyków, specyficznych zachowań, pozwalających na dokładne profilowanie. Brak świadomości użytkowników co do tego jakie informacje roboty są w stanie „wywnioskować” na podstawie sygnałów z otoczenia sprawia, że bagatelizują oni zagrożenie prywatności danych. W przypadku robotów w miejscach publicznych potencjał na zbieranie danych jest jeszcze większy, ze względu na ogromną ilość interakcji. Sprawia to, że są one jeszcze bardziej atrakcyjnym celem cyberataków. Atakujący mogą je infekować nie tylko w celu przejęcia danych, ale również w celu wykorzystania do manipulacji użytkownikami.

Prawa robotów

Większość rozważań etycznych skupionych wokół robotów społecznych bierze pod uwagę człowieka, nie przypisując robotom podmiotowości i nie patrząc na dylematy moralne z perspektywy robotów. Temat praw robotów nie jest tylko motywem z sci-fi, niektórzy uważają, że powinny stać się elementem moralnych rozważań, ponieważ uczestniczą w relacjach społecznych z ludźmi. Brak zdefiniowanej sytuacji prawnej nie przeszkodził w nadaniu robotowi Sophia obywatelstwa Arabii Saudyjskiej. Inne podejście podkreśla głębokie znaczenie robotów dla niektórych członków społeczeństwa, z czego ma wynikać nadanie im „etycznego statusu” jako dziełom sztuki. Najprawdopodobniej, dopóki nie będziemy przekonani o świadomości AI, nie dojdzie do znaczących przełomów w tej kwestii.

Przyszłość rynku pracy

Wysoka produktywność i redukcja kosztów przy zakupie robotów w miejscu zatrudnienia człowieka może być dużym zagrożeniem przyszłości. W przypadku robotów usługowych widać, że możliwe jest z powodzeniem zastąpienie ludzi. Podobnie sytuacja wygląda w przypadku robotów opiekuńczych i edukacyjnych. Również one mogą zastąpić tradycyjnych opiekunów i nauczycieli. Niekoniecznie musi to skutkować redukcją miejsc pracy, jednak w takim przypadku musiałoby dojść do przekształceń stanowisk lub stworzenia nowych. Problem może nastąpić jednak jeśli te przekształcenia nie będą zsynchronizowane z eliminacją starych, co powodowałoby wzrost bezrobocia.

Jak zatem rozwiązać zidentyfikowane zagrożenia i dylematy?

Nie ma jednoznacznej odpowiedzi. Proponowane przez autorów artykułu rozwiązania skupiają się na projektowaniu robotów z kilkoma zasadami na uwadze:

- security and privacy by design: zasada ta kładzie nacisk na integrację środków i kwestii bezpieczeństwa z projektem i architekturą systemu od samego początku.

- human-centred design: zasada w której stawia się człowieka w centrum procesu projektowego, skupiając się na rozwiązaniach przyjaznych użytkownikowi

- least privilege: przyznanie użytkownikom minimalnych koniecznych uprawnień umożliwiających wykonanie zadania.

Autorzy proponują również kilka wytycznych, takich jak fizyczne bezpieczeństwo i integralność (np. wyposażenie robotów w systemy wykrywające ataki fizyczne i im zapobiegające), przechowywanie danych zgodnie z państwowymi regulacjami i za wyraźną zgodą użytkowników. Proponują również szyfrowanie komunikacji z serwerami, dopuszczanie autoryzowanych użytkowników do zaawansowanych funkcji, regularne update’owanie software’u, żeby zapobiec cyberatakom. Roboty powinny stosować się do odpowiednich protokołów regulujących interakcje z ludźmi, być regularnie testowane i walidowane. Wg autorów, przede wszystkim potrzebne są prawa i protokoły nadążające za postępem technologii, rozwiązujące nie tylko kwestie bezpieczeństwa i ochrony danych, ale również dylematy etyczne. Wymaga to dokładnego zbadania różnic kulturowych, stworzenia ustandaryzowanych testów i protokołów walidacji oraz dogłębnego przestudiowania prawdziwych przypadków.

Źródła

- Wagner, A. R., Borenstein, J., & Howard, A. (2018). Overtrust in the robotic age. Communications of the ACM, 61(9), 22-24.

- Wolfert, P., Deschuyteneer, J., Oetringer, D., Robinson, N., & Belpaeme, T. (2020, March). Security risks of social robots used to persuade and manipulate: A proof of concept study. In Companion of the 2020 ACM/IEEE International Conference on Human-Robot Interaction (pp. 523-525).

-

Bao, A., Zeng, Y., & Lu, E. (2023). Mitigating emotional risks in human-social robot interactions through virtual interactive environment indication. Humanities and Social Sciences Communications, 10(1), 1-9.

-

Boch, A., Lucaj, L., & Corrigan, C. (2020). A robotic new hope: Opportunities, challenges, and ethical considerations of social robots. Tech. Univ. Munich, 1, 1-12.

-

Mintrom, M., Sumartojo, S., Kulić, D., Tian, L., Carreno-Medrano, P., & Allen, A. (2022). Robots in public spaces: implications for policy design. Policy design and practice, 5(2), 123-139.