Branża gamingowa mierzy się z bezprecedensowym wyzwaniem, gdyż wieloosobowe doświadczenia online stają się coraz bardziej rozbudowane i zaawansowane, jednocześnie jednak pozostają one podatne na złośliwe działania zagrażające bezpieczeństwu graczy i integralności branży. Szacuje się, że straty spowodowane przez oszustwa sięgają 6 miliardów dolarów w skali roku, a liczba przypadków cyberprzemocy wzrosła o 40% podczas pandemii COVID-19, co podkreśla pilną potrzebę wdrożenia zaawansowanych systemów wykrywania i prewencji destrukcyjnych zachowań. Sztuczna inteligencja stała się pierwszą linią obrony przed tym cyfrowym zagrożeniem, wykorzystując algorytmy uczenia maszynowego, przetwarzanie języka naturalnego i analizę behawioralną do identyfikowania wzorców toksyczności, oszustw, nadużyć finansowych i nękania w czasie rzeczywistym. Od systemu ToxBuster firmy Ubisoft, wykorzystującego architekturę transformatorów i uczenia głębokiego do wykrywania negatywnie nacechowanych treści w kontekście wypowiedzi, po rozwiązania AI osiągające 92,6% dokładności w wykrywaniu oszustw finansowych – te technologiczne innowacje wyznaczają nowy paradygmat w ochronie społeczności gamingowych przy zachowaniu immersyjnego charakteru rozgrywki.

Rosnące wyzwanie cyfrowych wykroczeń w grach

Współczesny krajobraz gier komputerowych przekształcił się w złożone wirtualne społeczeństwa, gdzie miliony graczy codziennie wchodzą w interakcje, tworząc zarówno przestrzeń dla pozytywnych relacji, jak i szkodliwych zachowań. Wieloosobowe gry online takie jak League of Legends, Counter-Strike, Call of Duty czy platformy metaverse stały się inkubatorami toksycznych interakcji wykraczających poza zwykłe sprzeczki w trakcie rozgrywki. Konsekwencje niekontrolowanych wykroczeń mają charakter wielowymiarowy, wpływając zarówno na pojedynczych graczy, jak i całe ekosystemy.

Badania przeprowadzone przez organizację Take This ujawniły bezpośrednią korelację pomiędzy toksycznością społeczności a sukcesem komercyjnym gry – tytuły promujące pozytywne środowiska odnotowały 54% wzrost przychodów w porównaniu z produktami dotkniętymi problemami behawioralnymi. Wskazany aspekt finansowy, w połączeniu z wiedzą iż gracze są znacznie bardziej skłonni porzucić grę w obliczu nadużyć, podkreśla kluczowe znaczenie utrzymania zdrowych środowisk gamingowych. Psychologiczne skutki toksycznych interakcji obejmują zwiększony stres, lęk i obniżoną satysfakcję, które mogą wpływać na dobrostan mentalny wykraczający poza kontekst rozgrywki.

Pandemia COVID-19 zaostrzyła te wyzwania, gdy środki dystansu społecznego napędziły rekordową popularność platform gamingowych. Ten wzrost aktywności zbiegł się z 40% zwiększeniem przypadków cyberprzemocy i toksyczności na popularnych platformach takich jak Discord. Objętość treści generowanych przez użytkowników across multiple kanałów komunikacji – czatu tekstowego, głosowego i elementów wizualnych – przytłoczyła tradycyjne metody moderacji oparte na manualnej weryfikacji i podstawowej filtracji słów kluczowych.

Wykrywanie toksyczności napędzane AI: rewolucja w moderacji czatu

Ewolucja systemów wykrywania toksyczności wykorzystujących AI stanowi jeden z najważniejszych postępów w technologiach bezpieczeństwa gamingowego. Współczesne rozwiązania wykraczają daleko poza proste blokowanie słów kluczowych, stosując zaawansowane techniki przetwarzania języka naturalnego analizujące kontekst, intencję i zniuansowane formy komunikacji. Muszą one nawigować w złożonym krajobrazie komunikacji gamingowej, gdzie żartobliwy przekaz konkuruje z autentycznym nękaniem.

System ToxBuster firmy Ubisoft ucieleśnia tę technologiczną ewolucję, wykorzystując algorytmy transformatorowe do analizy kontekstu słów i zwrotów w konwersacjach. To podejście pozwala systemowi odróżnić żartobliwą rywalizację od autentycznie toksycznych zachowań poprzez zrozumienie kontekstu rozmowy, a nie jedynie flagowanie pojedynczych wyrażeń. Architektura oparta na transformatorach umożliwia ToxBuster przetwarzanie czatu w czasie rzeczywistym przy zachowaniu wysokiej dokładności w identyfikacji szkodliwych treści, które mogłyby umknąć ludzkim moderatorom.

Wyzwania czasu rzeczywistego w wykrywaniu toksyczności obejmują rozmaite modalności komunikacji. Opracowany przez Modulate system ToxMod stanowi przełom w analizie komunikacji głosowej, stosując komponenty sztucznej inteligencji do transkrypcji i oceny rozmów między graczami. Zdolność przetwarzania komunikacji głosowej w czasie rzeczywistym wypełnia istotną lukę w tradycyjnych systemach moderacji, gdzie werbalne nadużycia często pozostają niewykryte w kanałach głosowych.

Badania ujawniły znaczące różnice domenowe pomiędzy toksycznością w mediach społecznościowych a zachowaniami specyficznymi dla gier. Benchmark ToxicChat, oparty na rzeczywistych zapytaniach użytkowników do chatbotów, pokazuje, że modele trenowane na treściach z social mediów często zawodzą w kontekście gamingowym. To odkrycie podkreśla konieczność rozwoju gamingowych zestawów danych i modeli zdolnych identyfikować unikalne wzorce toksycznych zachowań w środowiskach rozgrywki.

Zaawansowane systemy AI do wykrywania toksyczności łączą obecnie analizę multimodalną, integrując dane tekstowe, audio i behawioralne dla kompleksowej oceny zagrożeń. Stosują są rozbudowane, wielomodułowe podejścia z wieloma technikami embeddingowymi (GloVe, Emo2Vec, BERT) generującymi reprezentacje semantyczne i kontekstowe. Integracja uczenia ze wzmocnieniem pozwala tym systemom na ciągłą adaptację do nowych form toksycznych zachowań.

Wykrywanie oszustw: AI kontra cyfrowe oszustwa

Wyścig zbrojeń między oszustami a deweloperami osiągnął nowy poziom zaawansowania, gdzie systemy AI stały się najskuteczniejszą odpowiedzią na coraz bardziej wyrafinowane metody oszukiwania. Tradycyjne systemy anti-cheat, choć stanowią fundament wykorzystywanych w najnowszych produktach rozwiązań, okazują się niewystarczające wobec współczesnych technik manipulujących mechaniką gry, wykorzystujących luki bezpieczeństwa i stosujących automatyzację sterowaną przez sztuczną inteligencję.

Systemy wykrywania oszustw oparte na AI analizują wielowymiarowe wskaźniki behawioralne, identyfikując nienaturalne lub niemożliwe wzorce zachowań. Badają one dynamikę ruchów myszy, schematy celowania, czasy reakcji i pozycjonowanie w grze, tworząc unikalne „odciski behawioralne” graczy. Badania porównujące drzewa decyzyjne, maszyny wektorów nośnych i naiwne klasyfikatory bayesowskie wykazały, że dynamika myszy stanowi szczególnie efektywny wskaźnik autentyczności gracza, z drzewami decyzyjnymi osiągającymi najwyższą dokładność w identyfikacji uczciwych zachowań.

Sieci LSTM (Long Short-Term Memory) wykazują ogromny potencjał w wykrywaniu anomalii behawioralnych w konkurencyjnym środowisku gamingowym. Kompleksowe badania z wykorzystaniem danych z Counter-Strike: Global Offensive zademonstrowały, jak sieci LSTM mogą uchwycić zależności czasowe we wzorcach ruchów graczy, umożliwiając wykrywanie subtelnych anomalii wskazujących na oszustwa. Badania obejmowały wstrzykiwanie syntetycznych danych do autentycznych zestawów gameplayowych w celu trenowania modeli rozpoznających nieznane wcześniej wzorce oszustw.

Nowoczesne systemy anti-cheat wykraczają poza prostą analizę statystyczną, stosując podejścia deep learningowe identyfikujące złożone wzorce zachowań. Analizują współrzędne, znaczniki czasowe i informacje kontekstowe, tworząc kompleksowe modele behawioralne odróżniające wykwalifikowanych graczy od wspomagania sztuczną inteligencją. Zdolność do wykrywania anomalii w czasie rzeczywistym pozwala platformom na szybką reakcję, zachowując integralność rozgrywki przy minimalnej ingerencji w doświadczenie graczy.

System BattlEye, jeden z najpowszechniej wdrażanych rozwiązań anti-cheat, ilustruje integrację technik AI z tradycyjnymi środkami bezpieczeństwa. Działa jak ochronna tarcza wokół wspieranych gier, analizując wzorce zachowań i interakcje systemowe w celu wykrycia nieautoryzowanych modyfikacji. Ciągła ewolucja takich systemów odzwierciedla postęp technologiczny niezbędny do utrzymania przewagi nad coraz bardziej zaawansowanymi metodami oszustw.

Wykrywanie przestępstw finansowych w ekosystemach gamingowych

Integracja transakcji pieniężnych, wirtualnych ekonomii i systemów mikropłatności umożliwiła powstanie nowych wektorów nadużyć finansowych, wymagających zaawansowanych systemów detekcyjnych. Szacunkowa wartość rynku gamingowego sięgająca 150 miliardów dolarów czyni go atrakcyjnym celem dla oszustów stosujących metody od kradzieży danych płatniczych po złożone schematy prania pieniędzy.

Systemy AI do wykrywania oszustw finansowych analizują równolegle multiple strumienie danych: wzorce transakcyjne, zachowania gameplayowe, schematy tworzenia kont i fingerprinting urządzeń. Algorytmy uczenia maszynowego identyfikują podejrzane wzorce – szybkie zakładanie kont, duże zakupy, nietypowe geograficzne schematy transakcji czy anomalie behawioralne sugerujące przejęcie konta. Systemy muszą balansować między prewencją oszustw a doświadczeniem użytkownika, minimalizując wpływ na uczciwych graczy.

Integracja blockchaina i kryptowalut w grach wprowadziła dodatkową złożoność do wyzwań detekcyjnych. Framework MetaHate demonstruje synergię między AI a technologią blockchain w tworzeniu przejrzystych systemów moderacji. To podejście wykorzystuje algorytmy gradient boosting osiągające 86% dokładności w wykrywaniu szkodliwych treści, przy jednoczesnym zastosowaniu blockchaina dla transparentności i rozliczalności decyzji moderacyjnych.

Oszustwa chargebackowe stanowią szczególnie trudny rodzaj przestępczości finansowej w grach, gdzie legalne mechanizmy płatności są wykorzystywane do defraudacji. Badania z wykorzystaniem modeli k-NN do analizy historii transakcji i danych gameplayowych osiągnęły wyniki F1-Measure do 0,89 w wykrywaniu złośliwych wzorców chargeback. Systemy te badają schematy wykorzystanie kart pre-paid, częstotliwość chargebacków i timing transakcji w celu identyfikacji kont wysokiego ryzyka.

Zaawansowane systemy AI do detekcji oszustw finansowych stosują rozbudowane metody łączące uczenie nadzorowane, wykrywanie anomalii, widzenie komputerowe i uczenie ze wzmocnieniem do identyfikacji złożonych schematów oszustw takich jak liczenie kart, zmowy pomiędzy graczami czy manipulacje kontami. Badania wykazały 92,6% dokładności detekcji przy tych zintegrowanych podejściach, z istotną poprawą w klasteryzacji zachowań użytkowników dla adaptacyjnych środków bezpieczeństwa.

Mowa nienawiści i nękanie: rola AI w ochronie społeczności

Wykrywanie mowy nienawiści i ukierunkowanego nękania w środowiskach gamingowych wymaga systemów AI zdolnych rozumieć nie tylko explicite szkodliwy język, ale także zakodowane komunikaty, podteksty zawarte w kontekście i niuanse kulturowe różniące się między globalnymi społecznościami. Wyzwanie potęguje wielojęzyczny charakter współczesnych platform, gdzie gracze z różnych języków wchodzą w interakcje poprzez tekst, głos i elementy wizualne.

Framework MetaHate specjalizuje się w wykrywaniu mowy nienawiści w wielojęzycznych kontekstach gamingowych, stosując różne modele ML do analizy zestawów danych mieszających hindi i angielski. Badania pokazują, że algorytmy gradient boosting osiągają wysoką dokładność w detekcji mowy nienawiści, uwzględniając złożone wzorce lingwistyczne charakterystyczne dla wielokulturowych środowisk. Praca ta podkreśla znaczenie rozwoju systemów obsługujących językową różnorodność platform gamingowych.

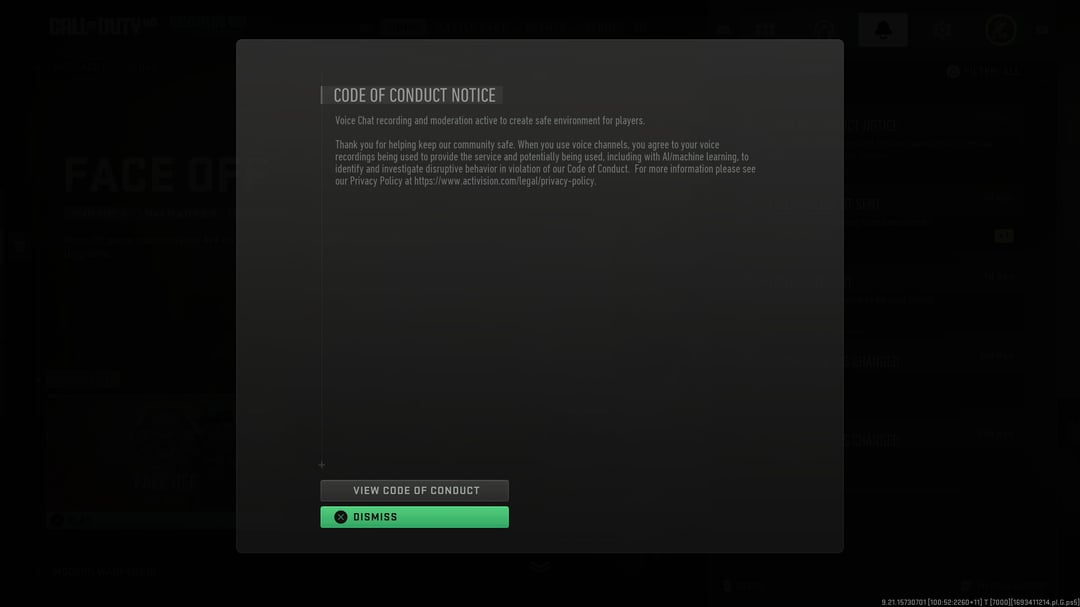

Zdolność przetwarzania w czasie rzeczywistym jest kluczowa dla efektywnego wykrywania mowy nienawiści, gdyż opóźnienia pozwalają szkodliwym treściom rozprzestrzeniać się i wyrządzać szkody. Nowoczesne systemy AI wykorzystują architektury oparte na transformatorach przetwarzające duże wolumeny danych tekstowych i głosowych w czasie rzeczywistym przy zachowaniu wysokiej dokładności. Muszą one odróżniać akceptowalną wymianę zdań w trakcie rywalizacji od autentycznych naruszeń standardów społeczności. System ToxMod, wykorzystywany już w takich grach jak Call of Duty, i GTA Online, stanowi przykład takiego rozwiązania, analizując niuanse głosu, wzorce mowy, stres i inne elementy, aby określić, czy użytkownik mówi coś toksycznego do innych członków lobby.

Integracja analizy behawioralnej z analizą treści okazała się szczególnie efektywna w identyfikacji wzorców nękania niewidocznych w pojedynczych komunikatach. Systemy AI śledzą wzorce komunikacyjne w czasie, wykrywając skoordynowane kampanie nękania, eskalację zachowań lub powtarzające się ataki na określone osoby/grupy. To holistyczne podejście pozwala platformom adresować zarówno oczywistą mowę nienawiści, jak i subtelniejsze formy przemocy.

Nowe technologie i przyszłe trendy

Przyszłość wykrywania zachowań w grach kształtuje kilka wyłaniających się trendów technologicznych obiecujących zwiększenie dokładności i wydajności systemów. Integracja edge computing z AI umożliwia szybszą reakcję i redukcję opóźnień, tym samym pozwalając na zachowanie płynności rozgrywki przy jednoczesnym zwiększeniu bezpieczeństwa.

Patent Sony dotyczący systemu wykrywania „złych aktorów” dla PlayStation 5 ilustruje ruch branży w kierunku kompleksowego monitoringu behawioralnego. System wykorzystujący uczenie maszynowe ma analizować wzorce zachowań graczy w czasie, oznaczając konta wykazujące niepokojące tendencje jak nadmierne opuszczanie rozgrywek, agresywne wiadomości na czacie czy nietypowe interakcje społeczne. Pomimo kontrowersji dotyczących prywatności, takie systemy reprezentują technologiczną granicę prewencyjnej moderacji.

Zastosowanie widzenia komputerowego w analizie rozgrywki wykracza poza tradycyjny monitoring tekstu i głosu. Rozwijane są systemy AI analizujące wizualne elementy rozgrywki, streamów i treści generowanych przez użytkowników w celu identyfikacji nieodpowiednich treści lub elementów wskazujących na potencjalne oszustwa. To multimodalne podejście tworzy kompleksowe możliwości monitoringu, stawiając nowe wyzwania w zakresie mocy obliczeniowej i prywatności.

Kolaboratywne systemy AI wymieniające zanonimizowane dane o zagrożeniach między platformami gamingowymi prezentowane są jako potężne narzędzie poprawy bezpieczeństwa branżowego. Umożliwiają zbiorową odpowiedź na nowe wzorce ataków przy zachowaniu bezpieczeństwa poszczególnych platform. Rozwój standardowych formatów wymiany danych zagrożeń będzie kluczowy dla efektywności tej współpracy.

Modelowanie predykcyjne reprezentuje kolejną granicę w detekcji zachowań, gdzie systemy AI identyfikują potencjalnie problematyczne konta na podstawie wczesnych wskaźników behawioralnych i schematów tworzenia kont. Choć obiecujące dla prewencji, wymagają precyzyjnego kalibrowania aby uniknąć fałszywych pozytywów negatywnie wpływających na graczy.

Wyzwania i kwestie etyczne

Implementacja systemów AI w grach rodzi istotne dylematy etyczne wymagające zbalansowania z korzyściami bezpieczeństwa. Kwestie prywatności są priorytetowe, gdyż kompleksowy monitoring wymaga zbierania i analizy szczegółowych danych o aktywnościach, komunikacji i zachowaniach graczy. Firmy gamingowe muszą opracować przejrzyste polityki dotyczące gromadzenia, przechowywania i wykorzystania danych, dostosowane do ewoluujących regulacji różnych jurysdykcji.

Ryzyko błędów algorytmicznych i biasu w systemach AI stanowi poważne wyzwanie, szczególnie w kontekście globalnych, zróżnicowanych społeczności. Systemy trenowane na danych nieadekwatnie reprezentujących pewne grupy społeczne, bądź niezawierających pełnego spektrum demograficznego mogą wykazywać tendencyjność wobec określonych grup. Badania i rozwój muszą priorytetyzować sprawiedliwość i inkluzywność w projektowaniu systemów i doborze danych treningowych.

Przejrzystość i rozliczalność automatycznych decyzji moderacyjnych pozostaje kontrowersyjna w społecznościach gamingowych. Gracze poddani automatycznym sankcjom często domagają się wyjaśnień i wskazania dowodów, co może być utrudnione jeżeli decyzja została podjęta przez złożony model AI. Rozwój sztucznej inteligencji dla moderacji będzie kluczowy dla utrzymania zaufania społeczności i powstania efektywnych procesów odwoławczych. Explainable AI (XAI) dla transparentnego wykrywania oszustw może pomóc w budowaniu zaufania graczy i zapewnieniu sprawiedliwości procesów moderacji.

Ciągłym wyzwaniem pozostaje również balans między automatyzacją nadzoru a zachowaniem kluczowego czynnika ludzkiego w łańcuchu decyzyjnym. Choć systemy AI przetwarzają ogromne wolumeny danych niemal w czasie rzeczywistym, ludzcy moderatorzy pozostają niezbędni dla skomplikowanych przypadków, niuansów kulturowych i procesów odwołań. Określenie optymalnego poziomu automatyzacji wymaga uwzględnienia możliwości technologicznych, oczekiwań społeczności i wymogów prawnych.

Podsumowanie

Integracja sztucznej inteligencji w systemach moderacji i zabezpieczeń w grach reprezentuje przełomową zmianę w podejściu branży do utrzymania bezpiecznych, sprawiedliwych i przyjemnych środowisk gamingowych. Od zaawansowanych systemów wykrywania toksyczności rozumiejących kontekst komunikacji po algorytmy analizujące biometrię behawioralną – technologie AI dostarczają platformom gamingowym bezprecedensowych możliwości identyfikacji i reagowania na szkodliwe działania w czasie rzeczywistym.

Sukces tych systemów zależy jednak nie tylko od postępu technologicznego, ale także od ich etycznej implementacji respektującej prywatność graczy, promującej sprawiedliwość i utrzymującej zaufanie społeczności. W miarę rozwoju branży, tworzenie etycznych, efektywnych i skalowalnych rozwiązań AI będzie kluczowe dla ochrony zarówno indywidualnych graczy, jak i całego ekosystemu. Kontynuacja współpracy między badaczami, deweloperami i społecznościami gamingowymi będzie niezbędna dla odpowiedzialnego wdrażania tych potężnych technologii.

Współczesne implementacje, takie jak HAWK, ToxMod czy MetaHate, pokazują, że technologia już dziś oferuje skuteczne rozwiązania dla najbardziej palących problemów branży gamingowej. Przyszłość bezpieczeństwa w grach leży w ciągłym udoskonalaniu i odpowiedzialnym zastosowaniu technologii sztucznej inteligencji zdolnych adaptować się do pojawiających się zagrożeń, przy jednoczesnym zachowaniu kreatywnych, konkurencyjnych i społecznych aspektów stanowiących o wartości gier jako formy ludzkiej interakcji i rozrywki. Poprzez odpowiedź na obecne wyzwania i antycypację przyszłych trendów, branża gamingowa może tworzyć środowiska, które będą zarówno bezpieczne, jak i przyjazne dla wszystkich uczestników, niezależnie od ich pochodzenia czy doświadczenia, a technologia służy do ochrony i wsparcia graczy, zamiast niepotrzebnej inwigilacji i ograniczenia.

Źródła:

https://montreal.ubisoft.com/en/ubisofts-new-tool-to-tackle-in-game-toxicity/

https://quix.io/blog/ai-anti-cheat-real-time-data-antidote-ai-driven-cheating-gaming

https://techwireasia.com/2023/08/how-does-unity-battle-toxicity-in-video-games-with-ai/