W roku 2022 OpenAI zaprezentowało światu ChatGPT – model językowy oparty na sztucznej inteligencji, który przybrał formę czatu. Niemal od razu został on obiektem masowej fascynacji. W bardzo intuicyjny i przyjazny użytnikowi sposób ułatwiał wykonywanie codziennych czynności w życiu prywatnym i pracy: od prostych porad praktycznych, po analizowanie danych, czy pisanie tekstów o wszelakiej tematyce (Liebrenz et al., 2023). Na ten moment, z ChatuGPT aktywnie korzysta 10% populacji dorosłych na świecie. (Sor, 2025) W wziązku z tak gwałtownym wzrostem popularności tego urządzenia, bardzo szybko zaczęły pojawiać się, wynikające z możliwości zastępowania przez ChatGPT wielu czynności w szkole lub pracy – problemy prawne i etyczne, polegące m.in. na sporze, komu powinny zostawać przyznawane prawa autorskie za wykonaną pracę (Dupps, 2023). Pomimo wstępnych prób poradzenia sobie z tym konfliktem, jest to wciąż temat niezwykle żywej i trudnej debaty na całym świecie. W tym wpisie zgłębimy temat używania przez studentów ChatuGPT do pisania prac dyplomowych i postaramy się znaleźć poszlaki, jak potencjalnie można byłoby podejść do rozwiązywania dylematu akredytacji osiągnięć akademickich w tym zakresie.

Kontekst: skąd wziął się „Mgr ChatGPT”

ChatGPT to duży model językowy (Large Language Model). Rozmawia on z ludźmi w sposób przybliżony do ludzkiego. Nie myśli, nie ma ani swiadomości, ani opinii, ale potrafi bardzo dobrze potrafi przewidywać, jakie słowa powinny paść jako następne. Został on wytrenowany na ogromnych ilościach tekstu: książkach, arykułach, dialogach, stronach internetowych i nauczył się wzorców językowych – tego, jak ludzie formułują myśli, argumenty, pytania i odpowiedzi (Liebrenz et al., 2023). Obecnie każdy jego model jest również podłączony do internetu i potrafi wyszukiwać informacje w sieci. Robi to lepiej lub gorzej, w zależności od sytuacji.

Bardzo szybko możliwości chatu zostały dostrzeżone przez uczniów, zarówno w edukacji szkolnej, jak i akademickiej. Już w pierwszym półroczu 2023 pojawiły się badania i ankiety dokumentujące szybkie przyjęcie chatu przez studentów i wykładowców na różnych uczelniach (Ngo, 2023). Studia w ogólnym założeniu wymagają od studentów dużego nakładu własnej pracy, aby zrealizować podstawy programowe zakładane przez tok ich kierunku. Sprawozdania, referaty, prezentacje, czy eseje to tylko mały urywek zadań, z którymi studenci mogą się potencjalnie mierzyć na swojej ścieżce akademickiej. Badania pokazują, że studenci poza wykorzystywaniem chatu do wytłumaczenia im trudnych zaganień, bardzo często uciekają się również do pomocy właśnie przy pisanu wszelakiej różnorodności tekstów (Ngo, 2023). Nie jest to dziwne – stawiając się w pozycji studenta, który po całym dniu zajęć wraca do domu i musi jeszcze napisać artykuł X, tym bardziej z przedmiotu, który może nie specjalnie go interesuje, bardzo kuszącym wydaje się spędzenie 20 minut promptując chatem, zamiast poświęcać cały swój cenny wieczór na użeranie się z tematem. Oczywiście, w takiej sytuacji można postawić bardzo oczywiste pytanie – skoro idziesz na studia, to czy nie powinieneś/powinnaś aktywnie brać udziału w zdobywaniu wiedzy i umiejętności, które te studia oferują? W zależności od osoby, odpowiedź na to pytanie może być różna. Niektórzy mogą iść na studia tylko po to, aby zdobyć „papierek”, inni mogą twiedzić, że przy korzystaniu z chatu tę wiedzę mimo wszystko zdobywają, a jeszcze inni mogliby zasugerować, że należy wprowadzić rozróżnienie pomiędzy użyciem chatu jako pomocy dydaktycznej przy redagowaniu tekstu, czy poszukiwaniu źródeł, a pozwoleniu narzędziu zrobić całą robotę za nich (przy czym oczywiście opcja pierwsza ma niwelować wspomniany problem) (Da Silva et al., 2024).

Reakcje na powszechne użycie ChatuGPT przez studentów można podzielić na dwa główne nurty. Piewszy, twierdzący, że trzeba zwyczajnie zakazać korzystania z chatu i kontrolować wszelkie próby potencjalnego nadużycia przez studentów oraz drugi, proponujący zmianę metody weryfikacji wiedzy i umiejętności studentów tak, aby móc wciąż oceniać ich rzetelnie z założeniem, że każdy z tego narzędzia może korzystać (Liebrenz et al., 2023). Przy opcji pierwszej najpopularniejszym rozwiązaniem zdaje się zmodyfikowanie istniejących do tej pory narzędzi antyplagiatowych tak, aby potrafiły też wykrywać użycie narzędzi AI w tekście. Jest to jednak, przynajmniej na ten moment, rozwiązanie nierzetelne, które w niektórych przypadkach może działać na szkodę studenta (Erol et al., 2025). Z racji, że modele językowe trenowane są na istniejących juz materiałach (w tym naukowych), to przy sprawdzaniu potencjalnego użycia ChatuGPT przy pisaniu pracy, pojawia się duże ryzyko błędu, że praca napisana przez studenta zostanie błędnie oceniona jako wygenerowana przez sztuczną inteligencję (Erol et al., 2025). Ocena autentyczności napisanej pracy pozostawałaby w finalnym rozrachunku doświadczeniu i intuicji wykładowcy, co jest niesatysfakcjonującym wynikiem – jest to człowiek, który zawsze może się zwyczajnie pomylić. Przy opcji alternatynej zakładamy, że nawet jeżeli studenci używają ChatuGPT, to wciąz pozostają aspekty ich nauki i pracy, które da się rzetelnie oceniać. Mogłyby być to umiejętności, takie jak formułowania hipotez, przedstawiania refleksji czy wyciągania wniosków. Na tej podstawie należałoby zrestrukturyzować instniejące do tej pory formy zaliczeniowe na studiach i problem zostałby w ten sposób rozwiązany (Da Silva et al., 2024).

Gdzie kończy się pomoc, a zaczyna oszustwo? Plagiat, ghostwriting, AI-writing – przejrzystość i deklaracja uzycia AI

Plagiat to przywłaszczenie cudzej pracy lub pomysłu bez odpowiedniego wskazania autorstwa, a ghostwriting – zlecenie napisania pracy przez kogoś innego, której to autorstwo przypisuje sobie student. W kontekście narzędzi generatywnej sztucznej inteligencji pojawia się pytanie: czy praca, która w znaczącej części została wygenerowana przez AI, a student tego nie ujawnia – nie jest nową formą ghostwritingu? Uczelnie właśnie temu zagadnieniu pojświęcają uwagę. Przykładowo, University of Kent (2025) stwierdza, że narzędzia sztucznej inteligencji mogą wspierać uczenie, ale tylko, jeżeli są użyte etycznie, tj. Jeżeli AI ma wkład w twojej pracy, trzeba to wyraźnie zaznaczyć i zacytować tam, gdzie potrzeba. Nigdy nie należy prezentować wygenerowanego tekstu jako swojego. Vanderbilt University dodaje, że prowadzący mają jasno komunikować czy i w jakim zakresie narzędzia AI są dozwolone i jakie są oczekiwania względem ich użycia (Hardia, 2023). Kluczowymi aspektami więc są dwa elementy: zakres udziału studenta w pracy i transparentność użycia AI. Gdy student używa AI jedynie jako narzędzia wspierającego, np. do organizacji tekstu, podpowiedzi lub korekty, jego główny wkład intelektualny pozostaje. Jeżeli natomiast narzędzie wygeneruje tekst, a student ograniczy się do jego minimalnej modyfikacji, wchodzimy na terytorium ghostwritingu, sfery etycznie niedozwolonej.

Efekt czy proces? Co tak naprawdę mierzy edukacja?

Jeszcze dekadę temu praca dyplomowa była zwieńczeniem procesu edukacyjnego studenta – procesu, który miał na celu nie tylko wiedzę przekazać, lecz także nauczyć refleksji, krytycznego myślenia, swoistej syntezy różnych umiejętności. Była symbolem drogi przebytej od niewiedzy do kompetencji. Dzisiaj, w czasach modeli językowych, nad tą rolą pojawia się ogromny znak zapytania. Tygodnie spędzone w bibliotece na przeszukiwaniu literatury zostały zastąpione przez parę szybko napisanych promptów. Zamiast konfrontacji z własnymi ograniczeniami, teraz studenci mają do dyspozycji bardzo prostą optymalizację. Fakt ten powoduje u wielu ludzi pytanie: „Czy dyplom dalej jest symbolem wykształcenia? Czy studia jako takie nie tracą wtedy sensu? W mojej własnej opinii wcale nie musimy iść jednoznacznie w stronę przekreślenia systemu edukacyjnego takiego jaki znamy dziś. Warto zastanowić się nad tym jak wyglada teraźniejszy proces edukacyjny i jak możemy go dostosować do obecnych warunków. W tradycyjnym modelu akademickim praca dyplomowa była oceniana głównie pod kątem efektu końcowego. Oczywiście, poza oddaniem gotowej pracy, należy ją jeszcze obronić do czego niezbędne jest dogłębne zbadanie tematu. Tekst ma być nie tylko poprawny, lecz odzwierciedlać też wiedzę autora. Jednak osiągniecie tego gotowego produktu, jakim jest obroniona praca, jest w czasach modeli językowych dużo prostsze i szybsze niż jeszcze pare lat temu (Zdravkova & Ilijoski, 2025) (Meyer et al., 2023). Dlatego moim zdaniem, w rozważaniach nad sensem wartości dyplomu, należy się zastanowić co ten dyplom ma mierzyć. Czy ma być tylko i wyłącznie produktem końcowym etapu edukacyjnego czy może czymś więcej? Wiele badań wskazuje na wpływ edukacji na różne aspekty ludzkiego życia, takie jak większe zaangażowanie społeczne, czy szersza tolerancja (Egerton, 2002). Powodem takich wyników może być właśnie fakt, ze studenci podczas ścieżki akademickiej uczą się krytycznego myślenia, spotykają się z wieloma opiniami i światopoglądami (Tuononen & Parpala, 2021) (Gómez et al., 2025) (Hermita et al., 2025). I właśnie to jest esencja procesu edukacyjnego i to powinien pokazywać dyplom.

Wpływ AI na pisanie pracy – możliwości dużych modeli językowych

Aby w ogóle rozważać wpływ sztucznej inteligencji na edukacje studenta i wartość dyplomu akademickiego, należy się najpierw zastanowić co tak w ogóle potrafią duże modele językowe. Sztuczna inteligencja stała się narzędziem używanym w każdym etapie pracy – od jej planowania do końcowych poprawek redakcyjnych. AI generuje szerokie spektrum wsparcia w pisaniu prac, które znacząco usprawnia pisanie tekstów przez studenta (Zdravkova & Ilijoski, 2025) (Meyer et al., 2023) (Malik et al., 2023). Duże modele językowe:

- generują pomysły i koncepty

- przyspieszają przegląd literatury

- automatyzują zadania techniczne

- redukują i przyspieszają poprawki tekstu

Jednak skuteczność takich modeli ma swoje wyraźne granice. Najczęstszymi problemami są (Meyer et al., 2023) (Sohail & Zhang, 2025):

- halucynacje – podawanie przekonująco brzmiących, lecz nieprawdziwych/nieprecyzyjnych informacji

- podawanie fałszywych cytowań i nieistniejący źródeł

- brak transparentności – trudno ocenić na jakich bazach danych pracuje dany model językowy co utrudnia weryfikacje źródeł

- powierzchowność – generowany tekst jest poprawny ale brakuje w nim głębokiej analizy i refleksji

- ryzyko plagiatu

AI może więc znacząco usprawnić proces pisania pracy, lecz nie jest w stanie zastąpić umiejętności akademickich takich jak krytyczne myślenie, analiza, czy etyczna odpowiedzialność (Malik et al., 202). Rzeczywista wartość pracy ujawnia się w procesie intelektualnym autora, a tego duże modele językowe nie są w stanie zastąpić.

Próba zmodelowania procesu decyzyjnego oceny etycznej poprawności użycia AI w pracy.

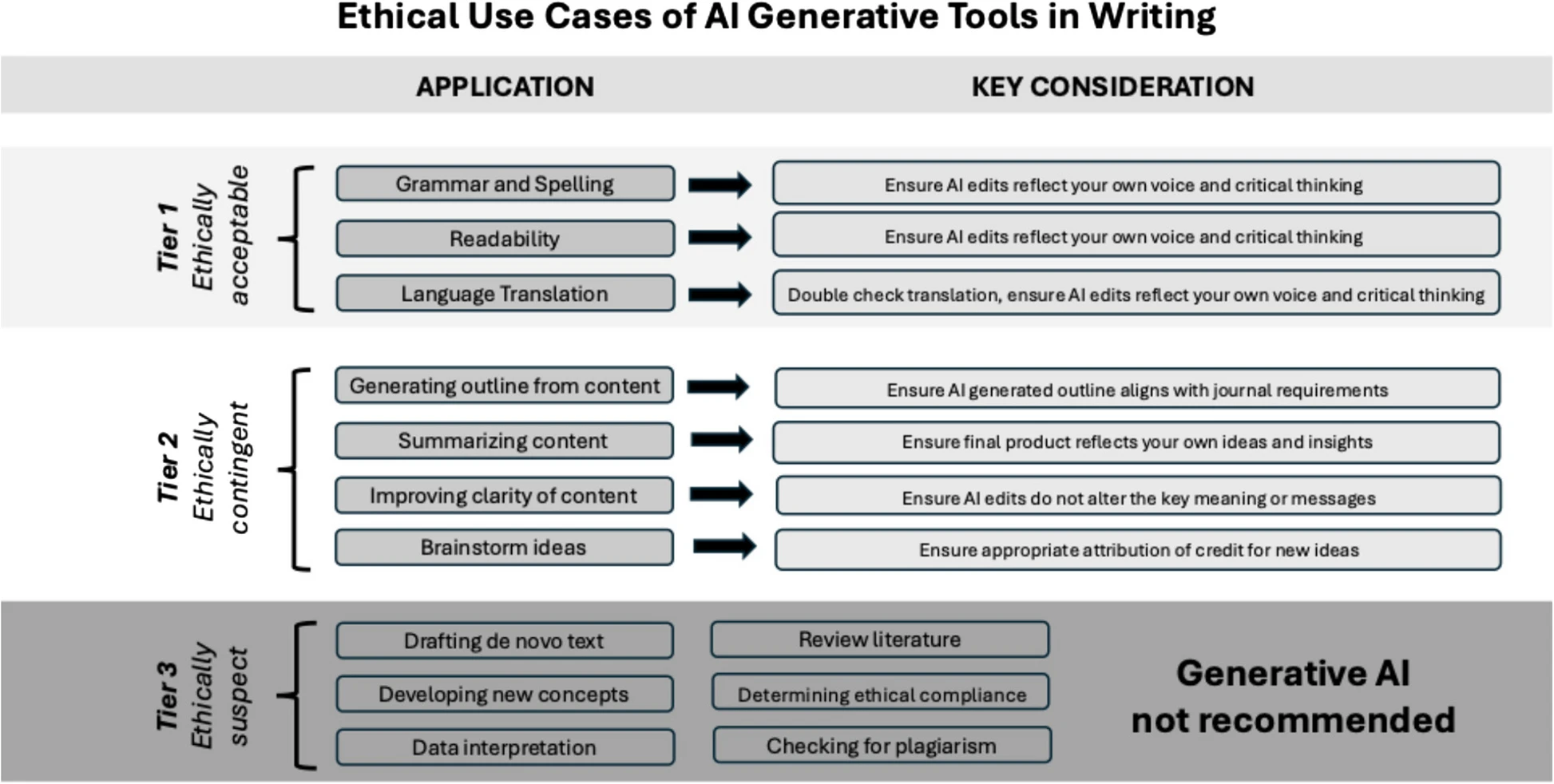

W artykule „Artificial Intelligence-assisted academic writing: recommendations for ethical use” (Cheng et al., 2025), badacze podjęli próbę skonstruowania uniwersalnego sposobu oceny, czy w danym przypadku i w jakim zakresie użycie AI w pisaniu pracy pozostaje etycznie neutralne. Po zebraniu odpowedzi z ankiety badającej jak użytkowany jest chatGPT w środowisku akademickim, przygotowana została ogólna lista zadań, do których zrealizowania pomoc generatywnego AI może zostać potencjalnie użyta. Na tej liście znajdują się m.in. pozycje takie jak: przegląd literatury, przygotowywanie struktury pracy, wyjaśnianie pojęć, sprawdzanie gramatyki i przejrzystości tekstu, tłumaczenie dokumentów czy dyskusja i formułowanie hipotez. Badacze sprawdzili, jakie stanowiska w odniesienu do użycia generatywnej AI w publikacjach przyjmują wydawnictwa naukowe, redakcje i organizacje etyczne (np. Commitee on Publication Ethics – COPE) oraz omówili znane problemy związane z wykorzystaniem takich narzędzi w pisaniu naukowym, takie jak plagiat, halucynacje AI, czy generowanie nieprawdziwych lub błędnych odwołań literaturowych. Na tej podstawie wnioskowali, że wykorzystanie takich narzędzi powinno być ograniczone do takich zastosowań, w których ich słabości (jak brak rozumienia, brak odpowiedzialności za wynik) są minimalizowane.

Rezultatem tych działań jest model zapropowany przez autorów. Dzieli on przypadki korzystania z AI na trzy poziomy: etycznie akceptowalny, etycznie „zależny” oraz etycznie „podejrzany” – użycie jest odradzane.

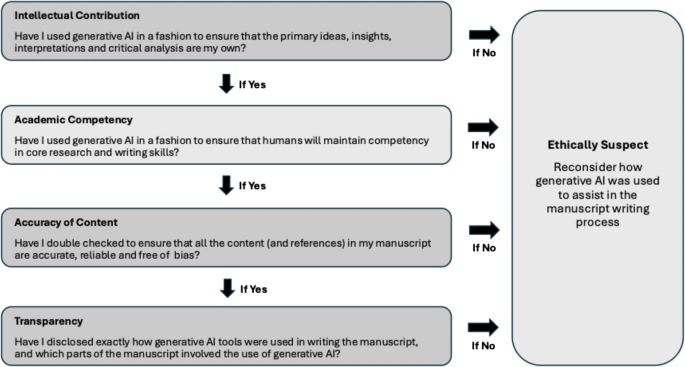

Warto też spojrzeć na ich autorską checklistę, która miałaby pomóc w procesie oceny poprawności etycznej użycia generatywnej AI w swojej pracy.

Przechodząc natomiast to tego, jak prace napisane z jawnym wykorzystaniem generatywnej sztucznej inteligencji miałyby być oceniane, tutaj zdaje się też, że mamy trzy możliwości.

Pierwszą z nich jest najpopularniejszy model oceny pracy stosowany od lat – taki, który ocenia finalny efekt pracy. Jest to rozwiązanie bezdyskusyjnie najprostsze i najbardziej intuicyjne. Niesie ono ze sobą jednak problem, któremu poświęcony jest cały ten artykuł. Przy takim mechaniźmie oceniania, wszystkie aspekty użycia w pracy modeli językowych sztucznej inteligencji pozostają bardzo trudne do rozwiązania (Da Silva et al., 2024).

Możliwością, którą można rozważyć jest model, który miałby skupiać się nie tyle na ocenie finalnego efektu pracy, co na samym procesie badawczo-naukowym. W takim przypadku należałoby postawić nacisk na zmuszanie studentów do samodzielnego myślenia, przykładowo w formie prowadzenia dzienników pracy / reasearch logów. Regularne konsultacje oraz wymóg prezentacji przemyśleń na temat każdego z poszczególnych etapów pisania stanowiłby zachętę do krytycznej analizy i utrudniłyby przerzucenie całości nakładu pracy na chatGPT (Da Silva et al., 2024).

A może jednak rozwiązaniem powinien być swojego rodzaju kompromis? Kryteria oceny pracy, na które jednocześnie skadałyby sie jakość finalnego tekstu oraz dokumentacja porocesu, przy jednoczesnym wymogu od studenta, aby potrafił wyjaśnić merytorykę oraz obronić decyzje badawcze, potencjalnie stanowią rozwiązanie, które nie wywraca do góry nogami całego systemu istniejącego dotychczas i zdaje się być niejako odporne na rewolucję AI.

„Hejka chat, napisz dla mnie….”

LLM’y (Large language models) maja wiele wad i większość z nas jest świadoma ze nie zastąpią roli człowieka w napisaniu wartościowej pracy, szczególnie bez jego nadzoru. Mimo wszystko są bardzo często wybieranym narzędziem, a wielu studentów opiera się na materiałach przez nich generowanych. Zamiast krytykować takie podejście warto zastanowić się z czego ono wynika. Studenci są narażeni na ogromna presje akademicka. Ilość zadań i prac zrzucona na studentów bardzo często jest przytłaczająca (Nyarko, 2025). Dodatkowo osoby uczące się bardzo często łączą swoją naukę z praca co jeszcze bardziej zmniejsza ilość czasu na wykonywanie zadań po całym dniu. Studenci bardzo często zmagają się tez z bardziej psychologicznymi czynnikami takimi jak poczucie braku wsparcia przez profesorów prowadzących zajęcia, lęk przed porażką, czy ogólne przytłoczenie powodujące brak motywacji do rozpoczęcia danego zadania (Nyarko, 2025). To kieruje studenta w stronę szukania alternatywnych możliwości zaliczenia wszystkich prac. Duże modele językowe oferują studentom szybkość i wygodę generując teksty w pare minut czym znacząco skracaja czas pracy i proces wyszukiwania artykułów. Zwiększają także motywacje do rozpoczęcia zadania generując gotowe schematy działania, koncepty, streszczenia i plany pracy. Dodatkowo znacząco poprawiaja jakość pracy korygując gramatyke, styl, strukturę i przejrzystość tekstu. AI działa trochę jak „plaster” na problemy systemu edukacji (masowość, presja, brak wsparcia). Ostatnim czynnikiem który należy wziąć pod uwagę jest fakt, że narzędzia te są darmowe i powszechnie dostępne, a ludzki mózg z natury ma skłonności do preferowania skrótów i minimalizacji wysiłków. Wysoka „performance expectancy” – przekonanie ze LLM poprawi wyniki i i ułatwia osiągnięcie celów edukacyjnych jest głównym motywatorem użycia. Część studentów używa AI żeby ominąć trudności zamiast rozwijać własne umiejętności – preferują łatwe szybkie rozwiązania jednak dla wielu z nich (na przykład piszących w języku obcym) jest to narzędzie wyrównujące szanse i zmniejszające stres (Meyer, 2023).

Propozycja podziału pracy człowieka i AI

| Generowanie pomysłów | Szybkie generowanie pomysłów, propozycji tematów, wstępnych struktur | Wybór i krytyczna ocena pomysłów, nadanie kierunku pracy |

| Tworzenie struktury | Tworzenie układu pracy/planu | Ostateczna decyzja, dostosowanie struktury do wymogów i własnych celów |

| Pisanie tekstu | Poprawa gramatyki, tłumaczenia, parafrazowanie | Tworzenie oryginalnych treści, własnych analiz, interpretacji i argumentacji |

| Redakcja i korekta | Automatyczną korekta językową, sugestie stylistyczne | Ocena merytoryczna, dbanie o spójność i autentyczność |

| Analiza danych i cytowanie | Wyszukiwanie literatury, generowanie cytowań, analiza danych | Weryfikacja źródeł, interpretacja wyników, sprawdzenie poprawności cytowań |

| Kreatywność i krytyczne myślenie | Ograniczona, może dawać inspirację, ale nie zastąpi głębokiej analizy | Rola kluczowa podczas tworzenia pracy, krytycznej ocenie, argumentacji i oryginalności |

Jak sztuczna inteligencja może zmienić uczelnie?

Na podstawie wszystkich przywołanych powyżej faktów można jednoznacznie stwierdzić ze sztuczna inteligencja ma, i będzie dalej miała, znaczący wpływ na naukę (Meyer, 2023) (Malik, 2023). Jednocześnie wpływ ten niekoniecznie musi być zły. Sztuczna inteligencja może umożliwić tworzenie idywidualnych ścieżek edukacyjnych dostosowanych do tempa i stylu uczenia każdego studenta. Indywidualne podejście do studenta jest niezwykle ciężkie do wykonania przy grupie 40, 50 a czasem i nawet większej liczby studentów których naucza każdego dnia. W Efekcie nauka stanie się procesem dynamicznym i spersonalizowanym, dopasowanym indywidualnie do każdego studenta. Pod wpływem LLM’ów może zmienić się także rola nauczyciela. Powoli przestanie być on głównym źrodłem wiedzy dla studentów, a stanie się raczej przewodnikiem, który wskaże na czym warto skupić swoją uwagę, a także bedzię brał udział we wspieraniu krytycznego myślenia i refleksji nad analizowanymi tematami. Myślę także, że biorąc pod uwagę łatwość produkcji tekstów w dobie dużych modeli językowych, powinnismy zacząć przykładać większą wagę do procesu nauki na jaki składa się rozumienie tematu, analiza i wnioskowanie zamiast skupiać się na ilościowym nakładzie pracy oceniając jedynie ilość oddanych zadań (Gómez et al., 2025b). Jednocześnie akceptując powszechne używanie AI w nauce wyższej ryzykujemy poznawczym uzależnieniem od AI, spadkiem umiejętności krytycznego myślenia, oraz skłonności do bardzo płytkiego przetwarzania informacji przyzwyczajając się do tego, że wszystko mamy podane na „tacy”. Dlatego tak ważne jest wsparcie i kontrola procesu uczenia się zamiast oceny końcowego efektu edukacji. Powinniśmy kierować się w stronę nauczenia świadomego korzystania z narzędzi zamiast ilościowego magazynowania wiedzy.

Podsumowanie

Wprowadzenie na rynek przez OpenAI Chatu GPT spowodowało drastyczne i nieodwracalne skutki w procesie uczenia się. Studenci już nie muszą ślęczeć godzinami nad książkami w bibliotece. Zamiast tego wystarczy wpisać w Chat parę szybkich promptów. Wykonywanie zadań akademickich zostało bardzo usprawnione, a dostęp do nauki się zwiększył dzięki całodobowemu dostępowi do narzędzia, które w każdej chwili jest gotowe wytłumaczyć nam każde zagadnienie. Jednocześnie zbytnie poleganie na sztucznej inteligencji niesie za sobą zagrożenia takie jak spłycenie poznawcze, czy zmniejszenie kompetencji zawodowych. Domyślną reakcją na pojawienie się tego problemu jest chęć zakazania korzystania z wyżej wymienionych narzędzi. Jednak takie podejscie jest bezcelowe. Tak jak pisaliśmy wyżej, nie istnieje jeszcze (i raczej nie powstanie) stuprocentowo rzetelny i wiarygodny sposób na ocenę wkładu generatywnej AI w końcowym tekście. Próba uniknięcia problemu nie będzie więc skuteczna. Zamiast tego więc, warto zastanowić sie nad zmianą koncepcji wyższej edukacji. Zamiast skupiać się na efekcie końcowym, warto kontrolować przebieg procesu akademickiego. Odpowiadając na pytanie zawarte w tytule – naszym zdaniem dyplom akademicki nie traci na wartości w dobie sztucznej inteligencji. Jednak ewaluacja przebiegu studiów powinna zostać dostosowana do zmieniających się okoliczności.

Bibliografia

Cheng, A., Calhoun, A., & Reedy, G. (2025). Artificial intelligence-assisted academic writing: recommendations for ethical use. Advances in Simulation, 10(1), 22. https://doi.org/10.1186/s41077-025-00350-6

Da Silva, C. a. G., Ramos, F. N., De Moraes, R. V., & Santos, E. L. D. (2024). ChatGPT: Challenges and Benefits in Software Programming for Higher Education. Sustainability, 16(3), 1245. https://doi.org/10.3390/su16031245

Dupps, W. J. (2023). Artificial intelligence and academic publishing. Journal of Cataract & Refractive Surgery, 49(7), 655–656. https://doi.org/10.1097/j.jcrs.0000000000001223

Egerton, M. (2002). Higher education and civic engagement*. British Journal of Sociology, 53(4), 603–620. https://doi.org/10.1080/0007131022000021506

Erol, G., Ergen, A., Erol, B. G., Ergen, Ş. K., Bora, T. S., Çölgeçen, A. D., Araz, B., Şahin, C., Bostancı, G., Kılıç, İ., Macit, Z. B., Sevgi, U. T., & Güngör, A. (2025). Can we trust academic AI detective? Accuracy and limitations of AI-output detectors. Acta Neurochirurgica, 167(1), 214. https://doi.org/10.1007/s00701-025-06622-4

Gómez, D. L. J., Maestre, A. J. Á., Trujillo, A. E. P., Fuentes, C. a. P., Ortiz, D. H. B., & Alarcón, R. K. S. (2025a). Determining factors for the development of critical thinking in higher education. Journal of Intelligence, 13(6), 59. https://doi.org/10.3390/jintelligence13060059

Gómez, D. L. J., Maestre, A. J. Á., Trujillo, A. E. P., Fuentes, C. a. P., Ortiz, D. H. B., & Alarcón, R. K. S. (2025b). Determining Factors for the Development of Critical Thinking in Higher Education. Journal of Intelligence, 13(6), 59. https://doi.org/10.3390/jintelligence13060059

Hardia. (2023, October 30). Academic integrity and generative AI. Vanderbilt University. https://www.vanderbilt.edu/generative-ai/academic-integrity/?utm_source=chatgpt.com

Hermita, N., Shirazi, S., Talib, C. A., & Ahmad, N. J. (2025). Enhancing Critical Thinking Skills in Graduates: An Experiential Learning approach. Jurnal Ilmiah Peuradeun, 13(2), 1477–1496. https://doi.org/10.26811/peuradeun.v13i2.1378

Liebrenz, M., Schleifer,

R., Buadze, A., Bhugra, D., & Smith, A. (2023). Generating scholarly content with ChatGPT: ethical challenges for medical publishing. The Lancet Digital Health, 5(3), e105–e106. https://doi.org/10.1016/s2589-7500(23)00019-5

Malik, A. R., Pratiwi, Y., Andajani, K., Numertayasa, I. W., Suharti, S., Darwis, A., & Marzuki, N. (2023). Exploring Artificial Intelligence in Academic Essay: Higher Education Student’s perspective. International Journal of Educational Research Open, 5, 100296. https://doi.org/10.1016/j.ijedro.2023.100296

Meyer, J. G., Urbanowicz, R. J., Martin, P. C. N., O’Connor, K., Li, R., Peng, P., Bright, T. J., Tatonetti, N., Won, K. J., Gonzalez-Hernandez, G., & Moore, J. H. (2023). ChatGPT and large language models in academia: opportunities and challenges. BioData Mining, 16(1), 20. https://doi.org/10.1186/s13040-023-00339-9

Ngo, T. T. A. (2023). The perception by university students of the use of CHATGPT in education. International Journal of Emerging Technologies in Learning (iJET), 18(17), 4–19. https://doi.org/10.3991/ijet.v18i17.39019

Nyarko, N. N. Y. (2025). Understanding the Benefits and Challenges of Using Artificial Intelligence Among Tertiary Students in a Developing Economy. Journal of Information Systems Engineering & Management, 10(43s), 73–82. https://doi.org/10.52783/jisem.v10i43s.8306

Sohail, A., & Zhang, L. (2025). Using large language models to facilitate academic work in the psychological sciences. Current Psychology, 44(9), 7910–7918. https://doi.org/10.1007/s12144-025-07438-2

Sor, J. (2025, October 10). ChatGPT is now being used by 10% of the world’s adult population. Business Insider. https://www.businessinsider.com/chatgpt-users-growth-openai-growth-sam-altman-ai-llm-2025-10?IR=T

Tuononen, T., & Parpala, A. (2021). The role of academic competences and learning processes in predicting Bachelor’s and Master’s thesis grades. Studies in Educational Evaluation, 70, 101001. https://doi.org/10.1016/j.stueduc.2021.101001

University of Kent. (2025, October 3). AI Ethics. Your Studies – University of Kent. https://student.kent.ac.uk/studies/using-generative-ai-in-your-studies/responsible-ai-use/ai-ethics?utm_source=chatgpt.com

Zdravkova, K., & Ilijoski, B. (2025). The impact of large language models on computer science student writing. International Journal of Educational Technology in Higher Education, 22(1). https://doi.org/10.1186/s41239-025-00525-1