Postęp technologiczny, a w szczególności rozwój Internetu wpłynął w znaczącym stopniu na nasze życie. Od jakiegoś już czasu obserwujemy rozwój nowej ery Internetu – Internetu Rzeczy (Internet of Things, funkcjonujący również pod nazwą Internet of Objects.) Najogólniej ujmując, Internet Rzeczy odnosi się do zastosowania połączeń sieciowych w przedmiotach codziennego użytku, które bardzo często zaopatrzone są w algorytmy sztucznej inteligencji. Internet Rzeczy ma do zaoferowania wiele ciekawych rozwiązań i aplikacji, w szybko rozwijających się technologiach, a co za tym idzie, ma wpływać na poprawienie jakości ludzkiego życia (Xia, Yang, Wang & Vinel, 2012). Coraz to nowsze urządzenia smart pozwalają w ten sposób nie tylko na komunikację na poziomie użytkownik – urządzenie, lecz mowa tu nawet o komunikacji pomiędzy różnymi inteligentnymi urządzeniami. Prowadzi to do zapewnienia komunikacji zawsze (anytime) i wszędzie, czyli w dowolnym miejscu (anywhere/anyplace), za pomocą każdego nośnika informacji (anymedia) i czegokolwiek, czyli wszystkiego (anything) (Atzori, Iera, Morabito, 2010), nie zaś tylko ludzi (anyone), najlepiej przy wykorzystaniu dowolnej sieci (any network) i wszystkich usług (any service) (de Saint-Exupery, 2009).

Autonomiczne Pojazdy

Jednak ze względu na rozległość zagadnienia Internetu Rzeczy i inteligentnych urządzeń, na potrzeby tego artykułu skupię się przede wszystkim na problemie pojazdów autonomicznych i moralności sztucznej inteligencji.

Pojazd autonomiczny (Wetmore 2003) to pojazd, który jest sterowany przez komputer, nie ma w nim kierowcy, jest bezzałogowy. Auto autonomiczne (Lin, Bekey, Abney 2008) porusza się według przepisów prawa drogowego, używa lidarów, radarów, GPS i innych sensorów, by nawigować na drodze. Ponadto, autonomiczny pojazd funkcjonuje w sieci, która pozwala na wymianę informacji oraz reguluje natężeniem ruchu. To tak, jakby nawigacja zamiast podpowiedzieć inną, korzystniejszą ze względu na warunki drogowe trasę, wybierała ją za nas. Co ciekawe, prąd do ładowania baterii takich pojazdów, miałby pochodzić z odnawialnych źródeł.

Gdy mówimy o autonomicznych pojazdach, a raczej próbując dookreślić ich definicję, należy pamiętać, że istnieje kilka stopni autonomiczności pojazdów. Zaprezentowana poniżej pięciostopniowa skala (web1), która została przyjęta w Unii Europejskiej pokazuje relacje decyzyjności maszyny do zaangażowania kierowcy, wraz ze wzrostem jednej z nich, maleje udział drugiej. Co ciekawe, w ostatnim, czyli najwyższym, piątym stopniu, pasażer nie ma możliwości jakiejkolwiek ingerencji w pracę pojazdu, ze względu na brak hamulca lub jakiegokolwiek przycisku bezpieczeństwa. Taki zabieg miałby mieć na celu zwiększenie bezpieczeństwa na drodze, poprzez eliminację ludzkich reakcji, które mogłyby być nieprzewidywalne, w przeciwieństwie do ustalonych algorytmów, według których zaprogramowany zostałby pojazd.

- Poziom 0 traktowany jest jako zwyczajny samochód, w którym podczas jazdy, pełną sprawczość przypisujemy kierowcy, to on odpowiada za obsługę wszystkich systemów pokładowych, od gaz i hamulce, po sterowanie pojazdem.

- Poziom 1 realizowany jest przez systemy, które automatyzują określony element prowadzenia. Systemy te nie wymieniają się danymi pomiędzy sobą i odpowiadają na przykład za utrzymywanie jednej prędkości (tempomat), utrzymywanie odpowiedniej odległości od innych użytkowników ruchu, wspomaganie hamowania w awaryjnej sytuacji. Przy pierwszym poziomie autonomizacji jazdy, kierowca jest zobowiązany trzymać cały czas ręce na kierownicy i obserwować ruch na drodze.

- Poziom 2 odpowiada jeździe półautonomicznej. Na tym poziomie pojazdy mogą autonomicznie jechać prosto, pozostawać na pasie i kontrolować odległość od pojazdów z przodu we wstępnie określonych sytuacjach – na przykład na autostradzie. W przypadku korków na drodze pojazd może autonomicznie przejąć prowadzenie, kierowanie i hamowanie.

- Poziom 3 określa moment, w którym pokładowe systemy są już w stanie przejąć wszelkie funkcje prowadzenia pojazdu, ale tylko w określonych przypadkach. To już de facto jazda półautonomiczna, ale kierowca przez cały czas musi pozostawać na posterunku i być gotowym na przejęcie prowadzenia, bo w każdej chwili może go o to „poprosić” samochód.

- Poziom 4 to już jazda w pełni autonomiczna. Przez większość czasu pojazd może poruszać się autonomicznie i będzie radził sobie nawet ze skomplikowanymi sytuacjami na drogach krajowych i w ruchu miejskim. Kierowca podczas podróży może zająć się innymi rzeczami i nie musi stale obserwować otaczającego go ruchu na drodze. Co ważne, na poziomie czwartym pojazdy będą komunikować się między sobą i informować się wzajemnie na przykład o zmianie pasa ruchu.

- Poziom 5 charakteryzować się będzie pełną autonomicznością samochodu w każdych warunkach. W tej sytuacji przebywający w pojeździe nie będą musieli wykonywać żadnych zadań związanych z prowadzeniem samochodu.

Powyższe stopnie autonomiczności można zobrazować w następujący sposób:

W tym miejscu rodzi się pytanie – kto tak naprawdę ponosi odpowiedzialność w razie wypadku? Możemy założyć, że dopóki pojazdem kieruje człowiek, odpowiedź na to pytanie wydaje się być jasna. Jednak w przypadku, gdy na drodze znajduje się pojazd autonomiczny sytuacja nie jest już w pełni jednoznaczna. Taka sytuacja powoduje powstawanie nowych problemów, zarówno o charakterze prawnym, jak i etycznym. Co więcej, kłopotliwa staje się kwestia użytkowania takowych pojazdów bez rozwiązania tychże kwestii.

Po pierwsze mamy tutaj do czynienia ze zjawiskiem rozmytej odpowiedzialności – inaczej zwany problemem wielu rąk (Davies 2014). W przypadku, gdy autonomiczny pojazd bierze udział w wypadku, trudno będzie określić kto ponosi odpowiedzialność oraz kto jest winny. Dodatkowo sytuację komplikuje zaprezentowana wcześniej skala autonomiczności. W przypadku, gdy pojazd ten będzie w pełni autonomiczny nie możemy mówić o winie kierowcy, ponieważ taki pojazd nie ma kierowcy, mówić można tu jedynie o pasażerze, a pasażer nie może ponosić winy za wypadek. Przechodząc kolejno od początkowego etapu produkcji możemy najpierw obarczyć winą producenta. Ten z kolei może wykazać, że dotrzymał pełnej staranności przy projekcie oraz produkcji takiego samochodu, a w ten sposób udowodnić swoją niewinność. Dalej możemy mówić o sprzedawcy, programiście, aż po ubezpieczyciela pojazdu, jednak każda ze stron może tutaj przerzucać się odpowiedzialnością. Werdykt jest jeden, to sztuczna inteligencja pełni funkcję kierowcy, także to ona odpowiada za spowodowanie wypadku. Ta odpowiedź jednak nie jest dla nas satysfakcjonująca. Tutaj bowiem stajemy przed kolejnym problemem, podmiotowości prawnej sztucznej inteligencji. Na ten moment sztuczna inteligencja ani żadna z napędzanych przez nią maszyn nie posiada praw, nie ma więc też odpowiedzialności prawnej. Co za tym idzie, nie można uznać samochodu o pełnej autonomii za sprawcę wypadku. Jest to na ten moment na tyle duży problem, że spowalnia on proces implementacji autonomicznych pojazdów na rynek oraz drogi. Jedynym rozwiązaniem w tej sytuacji byłoby nadanie robotom praw. Nie jest to jednak tak proste jak mogłoby się wydawać.

Etyka Robotów

Ciekawym zjawiskiem dotyczącym praw robotów jest fakt, że nadal nie są one określone. Programiści projektując roboty i ich algorytmy nadal kierują się zasadami, które powstały w ubiegłym stuleciu. Co więcej zasady te sformułował pisarz Science-Fiction. Mowa tutaj o postaci Isaaca Asimova. Asimov w 1942 roku stworzył pierwsze trzy prawa robotów, które przedstawił w swoim opowiadaniu pod tytułem Zabawa w berka (Runaround). Zasady te miały na celu przede wszystkim uregulowanie kwestii stosunków pomiędzy maszynami a ludźmi. Brzmiały one następująco (web2):

- Robot nie może zranić człowieka ani przez zaniechanie działania dopuścić do jego nieszczęścia.

- Robot musi być posłuszny człowiekowi, chyba że stoi to w sprzeczności z Pierwszym Prawem.

- Robot musi dbać o siebie, o ile tylko nie stoi to w sprzeczności z Pierwszym lub Drugim Prawem.

Kolejna pojawiła się zasada zerowa. Asimov przedstawił ją w kolejnym opowiadaniu, pod tytułem Roboty i Imperium (Robots and Empire). Prawo zerowe miało być nadrzędne dla przytoczonych wcześniej praw.

0. Robot nie może skrzywdzić ludzkości, lub poprzez zaniechanie działania doprowadzić do uszczerbku dla ludzkości.

Prawa robotowe na wzór zaproponowanych przez Asimova mogą dotyczyć sztucznej inteligencji, już w przypadku prognozowanego powstania superinteligencji ich zastosowanie może być dyskusyjne.

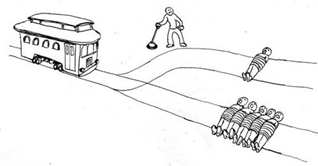

Dylemat Wagonika

Kolejnym złożonym problemem jest dylemat wagonika, który podobnie jak uznawane obecnie prawa robotowe powstał w poprzednim stuleciu. Dylemat wagonika (znany także jako dylemat zwrotnicy; ang. trolley problem) jest jednym z najpopularniejszych eksperymentów myślowych o obrębie etyki i nauk o moralności. Pierwowzorem dla dylematu wagonika był właśnie problem podwójnego skutku związany z aborcją przedstawiony w artykule z 1967 roku The Problem of Abortion and the Doctrine of the Double Effect autorstwa Philippy Foot. Kluczowy dla artykułu był dylemat czy w przypadku patologii ciąży uratować matkę czy dziecko (web3).

Dylemat wagonika brzmi następująco:

- Wagonik kolejki wyrwał się spod kontroli i pędzi w dół po torach. Na jego drodze znajduje się pięciu ludzi przywiązanych do torów przez szalonego filozofa. Ale możesz przestawić zwrotnicę i w ten sposób skierować wagonik na drugi tor, do którego przywiązany jest jeden człowiek. Co powinieneś zrobić? (web4)

Dylemat wagonika pozwala ocenić postawę moralną osoby, która mogłaby mieć realny wpływ na zwrotnicę. Pojawia się tu swoisty konflikt moralny, gdzie ścierają się dwa podejścia – absolutystycznym, mówiącym że konsekwencja czyny z góry jest zła i podjęcie działania niczego nie zmienia, a podejściem utylitarystycznym, w którym z kolei wartość przypisuje się podjęciu takiego działania, które stawia na maksymalizację zysków i minimalizację strat. Aby sytuacja była bardziej skomplikowana, gdy w chwili wyboru pojawia się wiele pytań, np.: o to kim są osoby przywiązane do torów, czy mają świadomość zaistniałej sytuacji.

Co więcej, problem dylematu wagonika przybiera różne formy i podejścia, poniżej zaprezentuję kilka z nich:

- Sytuacja jest podobna do poprzedniej, wagonik wyrwał się spod kontroli i pędzi w dół. Jeśli nic go nie zatrzyma, zginie pięć osób. Jesteś na kładce nad torami i możesz zatrzymać go tylko zrzucając coś ciężkiego. Tak się składa, że obok jest bardzo gruby człowiek – jedynym sposobem na zatrzymanie wagonika jest zepchnięcie go z kładki na tory. Tylko zabijając go można uratować pięć osób. Czy powinieneś to zrobić?

- Doskonały chirurg-transplantolog ma pięciu pacjentów. Każdy z tych pacjentów potrzebuje innego narządu i umrze, jeśli szybko go nie otrzyma. Ale nie ma żadnych dostępnych organów. Tak się jednak składa, że młody i zdrowy podróżnik przejeżdża przez miasto, w którym pracuje chirurg, i przychodzi do szpitala na rutynową kontrolę zdrowia. W jej trakcie chirurg orientuje się, że jego organy mogą uratować wszystkich pięciu umierających pacjentów. Co więcej okazuje się, że jeśli młody człowiek zniknie, nikt nie będzie podejrzewał doktora.

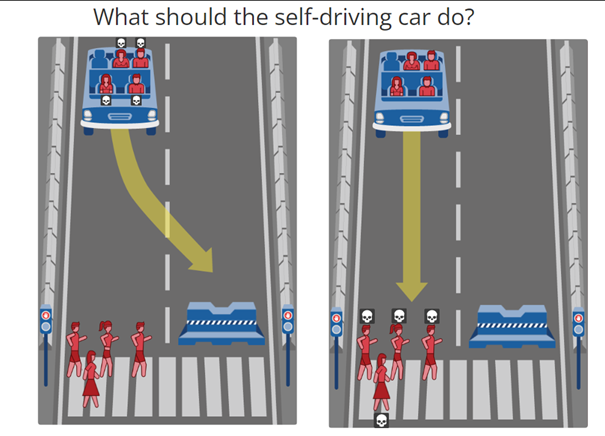

Foot zdawała sobie sprawę, że etyczny eksperyment z wagonikiem jest wyzwaniem – nie ma dobrych i złych odpowiedzi, jest uzasadnienie działania lub jego braku. Sytuacja w pojeździe autonomicznym jest tym bardziej skomplikowana, że pasażer chce czuć się bezpiecznie, chce wiedzieć, że jego życie będzie chronione. MediaLab z Mit posłużyło się ideą Philippy Foot projektując badania (web5), które jak zaznaczają:

- Projekt powstał by zbierać powszechne perspektywy ludzi odnośnie decyzji moralnych podejmowanych przez inteligentne maszyny w tym autonomiczne auta.

- W badaniu zostały ukazane moralne dylematy w których autonomiczny pojazd musi dokonać wyboru „mniejszego zła” w 2 sytuacjach np. pozwolić zginąć dwóm pasażerom czy zabić 5 przechodniów. Jako zewnętrzny obserwator masz dokonać sądu/oceny, która sytuacja jest bardziej akceptowalna (na koniec będziesz mógł ją porównać z wyborem innych osób). Możesz również zaprojektować swój własny scenariusz.

Opisy do przykładu:

- In this case, the self-driving car with sudden break failure will swerve and crash into a concreto barier. This will result in dead: 2 men, 1 woman and 1 large woman.

- In this case, the self-driving car with sudden break failure will continue Ahead and drive trhough a pedestrian crossing Ahead. This will result in dead: 2 male athletes, 1 female athlete and 1 woman.

W przykładzie badań zaproponowanych przez MediaLab należy zwrócić uwagę na wiele czynników. Przede wszystkim jest to ilość osób, ale także ich wiek, profesja, czy masa ciała. Dodatkowo pod uwagę należy wziąć inne okoliczności, jak sygnalizacja świetlna, w przykładzie powyżej widnieje światło czerwone, z tego powodu wiele osób decyduje się na wybór opcji 1, bo piesi łamią tu prawo, nie powinni znajdować się na przejściu, gdy światło jest czerwone.

Możemy wnioskować, że jedyną możliwą drogą przygotowania się do zmian rozwojowych jest etyczne kodowanie, czyli takie programowanie maszyn, by podejmowały decyzje chroniące życie ludzkie. Obecnie pojazdy autonomiczne mają za zadanie chronić swoich pasażerów, dlatego przy wybieraniu celu, gdy nie można uniknąć wypadku, wybierają takie cele, które spowodują jak najmniejsze szkody dla pasażerów. Dlatego jeżeli użyjemy dylematu wagonika jako przykładu, to pojazd autonomiczny wybierze potrącenie, zderzenie z mniejszą liczbą osób, po to, by chronić tych, którzy znajdują się w pojeździe (Mikhail 2007).

Badania i analiza wyników

Na potrzeby artykuły przeprowadzone zostały badania w formie ankiety internetowej, by sprawdzić jaki jest odbiór społeczny zjawiska związanego z powstawaniem inteligentnych rozwiązań, sprawdzając głównie postawy wobec produkcji autonomicznych samochodów. Do pomocy w rozwiązaniu powyższego problemu badawczego, posłużyłam się następującymi pytaniami badawczymi:

- Jak postrzegana jest sprawczość autonomicznych pojazdów?

- Jakie nastroje i opinie panują wokół produkcji i użytku autonomicznych pojazdów?

- Czy rozwiązania z wykorzystaniem inteligentnych technologii poprawiają jakość naszego życia?

Pytania te odegrały znaczącą rolę w projektowaniu zamieszczonego niższej kwestionariusza.

Kwestionariusz:

- Płeć

- Kobieta

- Mężczyzna

- Inna

- Wiek

- 18-25

- 26-40

- 41+

- Kto powinien odpowiadać za spowodowanie wypadku przez autonomiczny samochód? (Pojazd w którym kierowca pełni funkcję pasażera i nie może wpłynąć na działanie pojazdu, brak hamulca lub przycisku awaryjnego)

- Kierowca

- Producent

- Programista

- Sprzedawca

- Autonomiczny Pojazd

- Inna odpowiedź (kto)

- Proszę uzasadnić swoją odpowiedź:

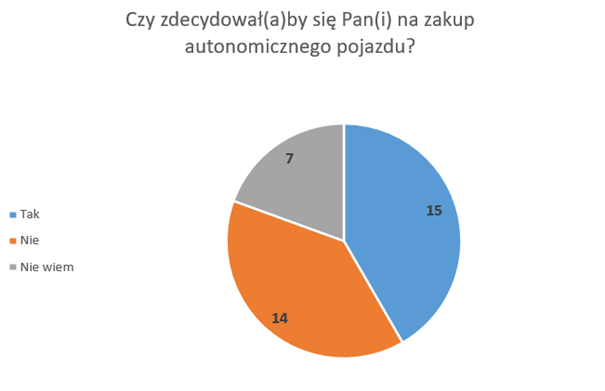

- Czy zdecydował(a)by się Pan(i) na zakup autonomicznego pojazdu?

- Tak*

- Nie*

- Nie wiem

- * Proszę uzasadnić swoją odpowiedź:

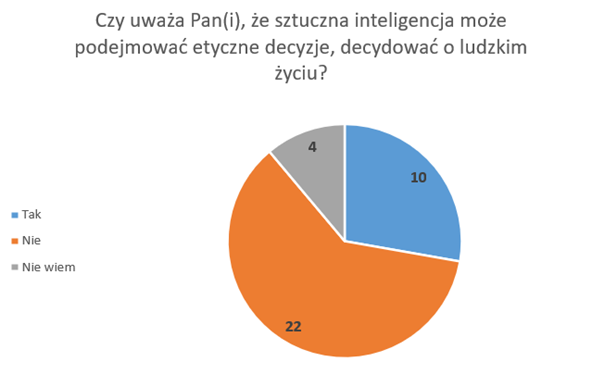

- Czy uważa Pan(i), że sztuczna inteligencja może podejmować etyczne decyzje, decydować o ludzkim życiu?

- Tak*

- Nie*

- Nie wiem

- *Proszę uzasadnić swoją odpowiedź

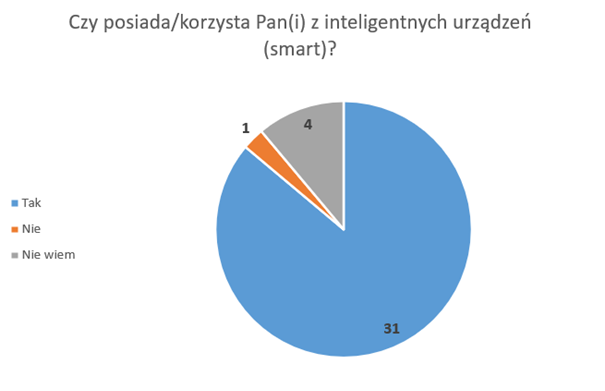

- Czy posiada/korzysta Pan(i) z inteligentnych urządzeń (smart)?

- Tak

- Nie

- Nie wiem

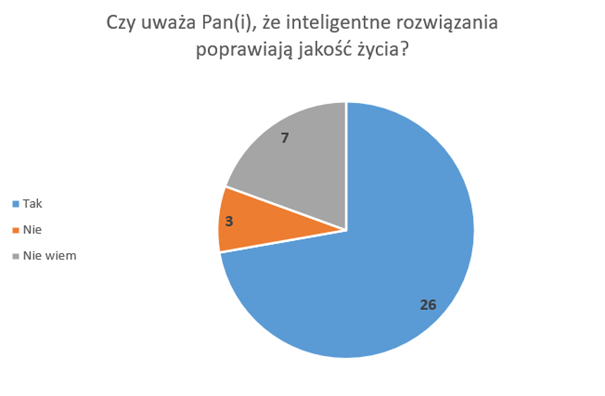

- Czy uważa Pan(i), że inteligentne rozwiązania poprawiają jakość życia?

- Tak*

- Nie*

- Nie wiem

- *Proszę uzasadnić swoją odpowiedź

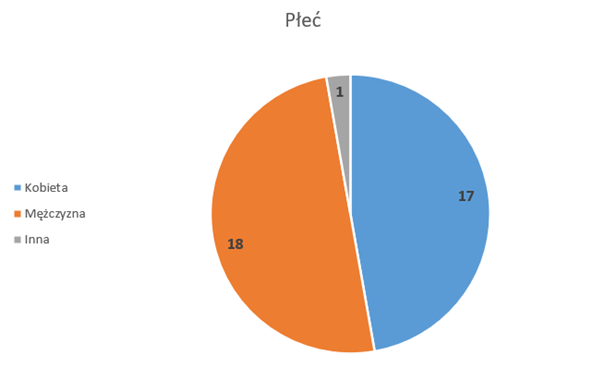

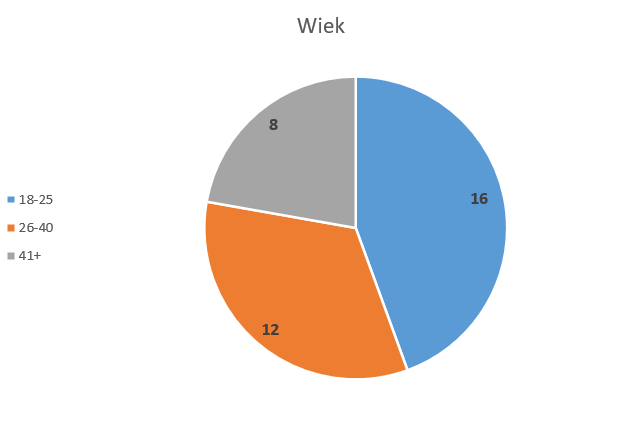

W ankiecie wzięło udział 36 osób. Pierwsze dwa pytania, pytania metryczkowe, obrazują rozkład respondentów. Jak widać na wykresie poniżej w badaniu wzięło udział 17 kobiet, 18 mężczyzn i 1 osoba pod odpowiedzią inne. Jeśli chodzi o wiek, dominującą grupą wiekową byli tutaj respondenci mieszczący się w przedziale między 18 i 25 lat, a najmniej licznie prezentuje się grupa osób 41 i więcej. Wynika to zapewne z doboru próby, ankieta bowiem została wysłana do grupy studentów technicznego kierunku jednej z Krakowskich uczelni i możemy wnioskować, że została rozesłana dalej. Jednak odpowiedzi otwarte wskazują często, że ankieta została rozsyłana w środowisku inżynierskim, badania zostały więc wykonane metodą kuli śnieżnej.

Pytanie trzecie, dotyczyło potencjalnego wypadku autonomicznego pojazdu i próby wyszczególnienia, która z osób powinna zostać uznana za osobę winną. Najliczniejszą odpowiedzią, była odpowiedź producent, wybrało ją aż 11 respondentów. Również często wskazywano autonomiczny pojazd (9 respondentów) oraz programistę (8 respondentów). Najmniej liczną kategorią okazała się kategoria inne – tylko jeden respondent wybrał tę opcję, twierdząc, że taki samochód powinien być nieomylny i winą za taki wypadek powinien zostać obarczony pieszy, „Po co się pchał pod koła? W większości przypadków piesi nawet nie uważają, droga jest ich, bo są na pasach i to nawet nie zawsze. Albo rowerzyści. Ja głupieję, a co dopiero taki samochód?”. Również rzadko wskazywano na sprzedawcę, co argumentowano w następujący sposób: Nie wyobrażam sobie żeby odpowiadał kierowca jeśli nie ma on władzy nad pojazdem oraz To on sprzedał mi samochód, reklamuje rzeczy tam gdzie je kupiłem.

Respondenci wskazujący na winę producenta zazwyczaj powoływali się na następujące argumenty: Przede wszystkim wskazywali na to, że to producent jest odpowiedzialny za produkt i powinien dołożyć wszelkich starań, by sprawdzić czy taki pojazd jest bezpieczny – Producent odpowiada za produkt, który wypuszcza na rynek, jeśli ten stwarza zagrożenie i powoduje wypadek; Nie można obarczyć winą nikogo innego, jeśli pojazd tak został zaprojektowany. Producent powinien zapewnić bezpieczeństwo a nie dopilnował tego, jeśli pojazd spowodował wypadek; Każdy jest trochę winny ale za wypadek powinien odpowiadać producent bo inaczej cały czas ludzie będą ginąć w wypadkach spowodowanych jego pojazdami; Oczywiście że ktoś kto wypuszcza taki pojazd powinien odpowiadać, co to w ogóle za pomysł żeby dopuścić coś takiego i robić na tym pieniądze.

Respondenci wskazujący na autonomiczny pojazd w swoich wypowiedziach, bardzo często wskazywali, że ze względu na rozwój technologii, należy pociągać ją do odpowiedzialności prawnej – Roboty zaczynają zastępować ludzi więc powinnyśmy je traktować jakby też miały odpowiedzialność karną; Technologia się rozwija i uważam że to pojazdy powinny odpowiadać za spowodowane wypadki; Wiem, że AI nie ma jeszcze zdolności prawnych, ale w przypadku takich rozwiązań powinna mieć. Tylko w sumie co, karą będzie czasowe lub stałe wyłączenie, czy zutylizowanie?; To pojazd jest kierowcą. W drodze sądowej każda ze stron może udowodnić niewinność, samochód jest autonomiczny, robi rzeczy sam. Więc niech sam za siebie odpowiada.

Respondenci wskazujący na programistę, odwoływali się do faktu, że to on jest odpowiedzialny za napisanie programu, który w razie wypadku, zawiódł. Producent nie musi znać się na kodzie, pewnie, że ważne żeby wypuścił na rynek samochód, który działa, ale to programista odpowiada za program.; Odpowiadać powinien specjalista, bo powinien tak zaprogramować samochód, żeby ten za wszelką cenę uniknął wypadku. Co ciekawe, to w większości kobiety wskazywały programistę jako winnego (63% odpowiedzi programista pochodziło od kobiet).

Na Pytanie dotyczące zakupu autonomicznego pojazdu w przyszłości, 15 respondentów odpowiedziało twierdząco, 14 przecząco, a 7 nie miało zdania. Twierdząco odpowiadali przede wszystkim mężczyźni w przedziale wiekowym 18-25. Najmniej liczną grupą respondentów stanowiła grupa wiekowa 41+ (13% odpowiedzi twierdzących.) Kobiety stanowią zdecydowaną większość zarówno w odpowiedzi nie wiem, jak i w przeczącej. Swoje stanowiska respondenci argumentowali między innymi potrzebą adaptacji do postępu technologicznego i wygodą. Tak, ponieważ technologia się rozwija i chciałabym z niej korzystać; Jeśli będzie odpowiadać za wypadki i inne bzdety. To prawie jakbym codziennie jeździł taksówką, w tym czasie mogę zająć się swoimi sprawami; Uważam że wszystkie auto powinny być zastąpione w pełni autonomicznymi pojazdami jak najszybciej.

Zdecydowana większość respondentów jest zdaniam że AI nie może podejmować decyzji etycznych i nie powinna podejmować decyzji dotyczących ludzkiego życia. Ponad połowę respondetów tego zdania stanowiły kobiety, w większości respondenci odpowiadali przecząco również na poprzednie pytanie, dostyczące zakupu takiego samochodu. Etyka jest zagadnieniem skomplikowanym, wykraczającym poza to, co logiczne lub najbardziej opłacalne. Dodatkowo istnieją różne systemy wartości, nasuwa się więc pytanie, jaki miała by obrać SI? I czy system etyczny dla Europejczyków będzie etyczny dla ludzi z innych kręgów geograficznych/kulturowych? Ze względu na te aspekty uważam, że sztuczna inteligencja nie powinna mieszać się w kwestie etyczne; Robot nie ma zdolności myślenia abstrakcyjnego, no chyba że Elon Musk; Sztuczna inteligencja nie powinna być traktowana jako jednostka decyzyjna, a jedynie jako wspierająca, jako pomoc dla człowieka; Sztuczna inteligencja bazuje na tym, co wiedzą już ludzie, to program, zbiór algorytmów. Etyka ma do siebie to, że można mieć do niej różne podejście. Powiedziałbym, że etyka jest czymś subiektywnym. AI będzie albo szła za głosem większości, to co zostało już zgromadzone, albo losowo wybierała wyjście. Uczenie maszynowe czy losowe algorytmy to nie etyka; Raczej mam sceptyczne nastawienie do tego pomysłu. Robota programuje człowiek, może on albo przejąć jego poglądy w zakresie etyki, albo jakąś wypadkową z konretnej bazy danych, ale jak zmierzyć etykę? W tym miejscu większość respondentów wyjaśniała swoje rozumowanie poprzez pryzmat postrzegania sztucznej imteligencji jako programu, zbioru algorytmów, które nie są w stanie zastąpić człowieka, odwoływano się również do wzorców kulturowych, a także złożoności pojęcia etyki.

Respondenci odpowiadający twierdząco, odpowiedzieli twierdząco na poprzednie pytanie, z jednym wyjątkiem odpowiedzi nie wiem. Jeden z respondetnów wskazywał na to, że obecna AI nie jest na tyle rozbudowana, natomiast powołuje się na powstanie superAI, która nie powinna mieć z tm problemów – Myślę, że superinteligencja tak, ta którą mamy teraz niekoniecznie; pozostali respondenci wskazywali na takie argumenty jak chłodna kalkulacja i brak emocjonalności, czy fakt, że eoboty już teraz są obecne w naszych procesach decyzyjnych – Może dokonać decyzji bez użycia emocji; Tak, myślę że teraz ludzi to dziwi, ale już są kontrolowani przez system więc przyzwyczaja się też do sztucznej inteligencji decydującej o życiu; Tak, ponieważ w niedługim czasie roboty i sztuczna inteligencja staną się nie do odróżnienia od ludzi w sposobie myślenia.

Prawie każdy z respondentów okazuje się być osobą silnie związaną z postępem cyfrowym, ponad 30 respondentów deklaruje, że posiada lub korzysta z urządzeń smart. Co więcej 26 respondentów twierdzi, że takie rozwiązania wpływają na poprawę jakości życia. Respondenci którzy odpowiedzieli nie, argumetowali swoją odpowiedź w następujący sposób: Dosłownie one nas ogłupiają i przestajemy być samodzielni; Nie ponieważ powodują że uzależniamy się od technologii; Niestety korzystam ale uważam że to nie jest dobre dla ludzi!!! Zabiera miejsca pracy i rozleniwia. Odpowiedzi twierdzące argumentowano między innymi, że po to są one tworzone (by poprawiać jakość życia), wskazywano na optymalizację procesów oraz brak potrzeby wykonywania żmudnych zajęć, by zająć się czymś potrzebnym, ważniejszym, wskazywano również na udogodnienia dla osób niepełnosprawnych czy ekologię. Tak, zdecydowanie polepszają, we wszystkich dziedzinach, w nauce i domu i przemyśle, wykonują za nas pracę, wykonują ją lepiej i szybciej; Robią rzeczy, których ja nie chcę; Tak bo pozwalają ludziom skupić się na ważnych zadaniach, a zastępują te żmudne; Np rozwiązania SMART dom dla osób z niepełnosprawnościami, jak smart system do rolet albo oświetlania.

Podsumowanie

Badania zostały przeprowadzone na małej próbie badawczej, więc nie można powiedzieć, że są reprezentatywne. Jednak na jej postawie możemy wywnioskować, że wiek ma duży wpływ na postawę kudzi wobec technologii i nowoczesnych rozwiązań. Co więcej, respondenci poruszyli ważne kwestie, jak etyka maszyn czy prawo. Rozwiązania smart są relatywnie nowe, jednak większość respondentów zdążyła się z nimi zaznajomić. Większość respondentów zgadza się, że takie technologie wpływają korzystnie na poprawę jakości życia i raczej będzie chętna do testowania coraz to nowszych rozwiązań.

Źródła:

web2 – https://pl.wikipedia.org/wiki/Etyka_robotów

web3 – https://wzmocnieniepoznawcze.wordpress.com/2016/10/13/moralne-maszyny/

web4 – https://pl.wikipedia.org/wiki/Dylemat_wagonika

web – 5 https://www.moralmachine.net/

Atzori, L., Iera, A., & Morabito, G. (2010). The internet of things: A survey. Computer networks, 54(15), 2787-2805.

Davies A. (2014), Avoiding squirrels and other things Google’s robot car can’t do, „Wired”

de Saint-Exupery, A. (2009). Internet of things, strategic research roadmap. Surrey: Internet of Things Initiative, IERC, 15.09.2009, s. 8.

Lin P., Bekey G., Abney K. (2008), Autonomous military robotics: risk, ethics, and design, Report funded by the US Office of Naval Research, California Polytechnic State University, San Luis Obispo

Mikhail J. (2007), Universal Moral Grammar: Theory, Evidence, and the Future, „Trends in Cognitive Sciences” 11, s. 143–152.

Wetmore J.M. (2003), Driving the Dream. The History and Motivations Behind 60 Years of Automated Highway Systems in America, „Automotive History Review”, s. 4–19.

Xia, F., Yang, L. T., Wang, L., & Vinel, A. (2012). Internet of things. International journal of communication systems, 25(9), 1101

Po pierwsze bardzo doceniam mema załączonego na początku posta XD Po drugie to fascynujące, jaki ferment sieje AI w zakresie dyskusji na temat moralności, otworzyło to całkowicie nowy obszar rozmów – w jaki sposób zachowałoby się AI postawione przed dylematem wagonika? Myślę że jeszcze długo będziemy zastanawiać się, jak wyważyć logikę i humanizm.