W erze dynamicznie rozwijającej się technologii, sztuczna inteligencja staje się coraz bardziej integralną częścią naszego życia. Czy jest to pole naszych codziennych działań, twórczość artystyczna, czy obszar nauki, AI nieustannie przesuwa granice tego, co uważamy za możliwe.

Na froncie tej rewolucji stoi OpenAI, organizacja non-profit zajmująca się badaniem sztucznej inteligencji, która twierdzi, że koncentruje się na tworzeniu bezpiecznej i korzystnej dla wszystkich AI. W ramach tej misji, OpenAI stworzył wiele narzędzi – w tym modele GPT – które są zdolne do generowania impresji artystycznych w sferach takich jak muzyka, wideo i grafika.

Jednak, mimo całego fascynującego potencjału, który niesie za sobą ta technologia, występuje również wiele obaw. Czy maszyna potrafi naprawdę tworzyć, czy tylko symuluje proces twórczy na podstawie danych, którymi się karmi? Jakie są konsekwencje prawne i etyczne tej rewolucji? A co, jeśli maszyny zaczną zastępować ludzi w twórczych zawodach, pozbawiając nas prawdziwej, ludzkiej twórczości?

Istniejące technologie

GPT (Generative Pre-trained Transformer) – seria modeli językowych, które potrafią generować ludzko brzmiący tekst, tłumaczyć języki, odpowiadać na pytania i wykonywać wiele innych zadań związanych z przetwarzaniem języka naturalnego. GPT-1 został wprowadzony w 2018 roku, GPT-2 w 2019, GPT-3 w 2020 roku, GPT-3.5 w 2022 roku, GPT-4 w 2023 roku. Wersja GPT-4 jest multimodalna, i pozwala na wykonywanie operacji na obrazach.

DALL-E – model AI, który potrafi generować i edytować obrazy na podstawie opisów tekstowych. Pierwsza wersja DALL-E została przedstawiona w 2021 roku, DALL-E 2 w 2022 roku, DALL-E 3 w 2023 roku.

Sora – wciąż rozwijany model AI, który na podstawie tekstowego zapytania jest w stanie stworzyć krótki film. Wytrenowany został na podstawie ogólnodostępnych filmów i filmów dla których OpenAI pozyskał odpowiednią licencje. Ogłoszony został w 15 lutego 2024 roku, jednak wciąż nie jest powszechnie dostępny (stan na 3 kwietnia 2024).

Voice Engine – model generujący głos na podstawie tekstu. Jego pierwsza wersja opublikowana została w 2022 roku. Na razie dostępny tylko dla niewielkiej grupy testerów. W marcu 2024 OpenAI opublikował nowy post w którym przedstawia potencjalne niebezpieczeństwa tego modelu które uniemożliwiają jego upublicznienie.

Potencjał

Automatyzacja

Modele językowe, takie jak GPT-4, potrafią generować i rozumieć tekst w sposób zbliżony do człowieka. Ich potencjał obejmuje automatyzację tworzenia treści, tłumaczenie języków, chatboty obsługujące klientów i wspomaganie procesu nauczania. Modele te mogą znacząco usprawnić wiele zadań związanych z przetwarzaniem języka naturalnego, oszczędzając czas i zasoby. Modele językowe mogą być cennym narzędziem dla takich profesji jak prawnicy i marketingowcy. Spersonalizowane chatboty mogą również odciążyć działy wsparcia technicznego, odfiltrowywując najprostsze zapytania ludzi. Artyści mogą wykorzystać takie modele w procesie tworzenia światów, generując kreatywne, ale spójne ze sobą nazwy ludzi, ras, krain geograficznych. Mogą ich również wspomóc w redagowaniu i poprawianiu tekstów pod kątem stylu, gramatyki i spójności.

Technologie text-to-image umożliwiają generowanie obrazów na podstawie opisu tekstowego. Modele takie jak DALL-E potrafią tworzyć realistyczne lub kreatywne wizualizacje w oparciu o proste polecenia tekstowe. Otwiera to nowe możliwości w dziedzinach takich jak projektowanie, tworzenie grafik, ilustrowanie książek czy generowanie konceptów wizualnych. Modele text-to-image mogą być cennym narzędziem dla artystów, designerów i marketingowców, pobudzając kreatywność i przyspieszając proces twórczy. Takie modele mogą również wspomóc osoby bez zdolności artystycznych, co może uprościć takie procesy jak hobbystyczne tworzenie gier komputerowych lub planszowych.

Akceleracja produktywności

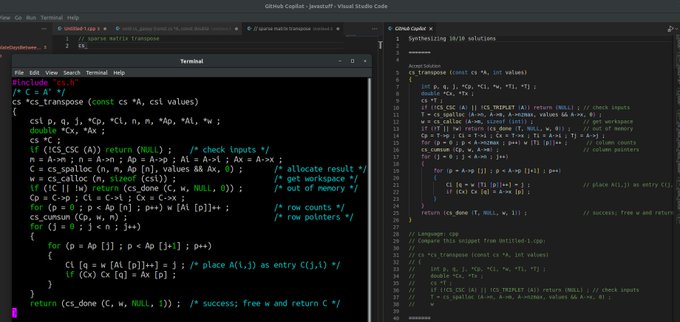

Sztuczna inteligencja nie tylko przekształca twórczość, ale również modyfikuje sposób, w jaki pracujemy i stajemy się bardziej produktywni. Wśród developerów, to narzędzie zatytułowane przez OpenAI „Copilot” staje się nieocenioną pomocą, znacząco przyspieszając proces tworzenia kodu.

Copilot to AI wspólautor kodu, który pomaga developerom pisać nowy kod, sugerując linie lub bloki kodu, jak to jest potrzebne. Działa to podobnie do autouzupełniania w edytorach tekstu, ale na znacznie bardziej zaawansowanym poziomie. Copilot jest w stanie analizować kontekst danego projektu, poprzez naukę na podstawie miliardów linii kodu publicznego, co pozwala mu na podawanie odpowiednich sugestii kodu.

To nie tylko przyspiesza proces tworzenia kodu, ale również pomaga w uczeniu się nowych języków programowania i technologii. Developerzy mogą skorzystać z doświadczenia i wiedzy zakodowanej w AI, co przekłada się na szybsze wdrożenie nowych projektów i skrócenie cyklu rozwoju.

Rozrywka

Z kolei modele text-to-video idą o krok dalej, generując filmy na podstawie opisów tekstowych. Choć technologia ta jest jeszcze we wczesnej fazie rozwoju, ma ogromny potencjał w branży rozrywkowej, reklamie i edukacji. Modele text-to-video umożliwiają tworzenia spersonalizowanych animacji, interaktywnych materiałów szkoleniowych czy generowania efektów specjalnych w oparciu o prosty opis.

Pomoc niepełnosprawnym

Modele text-to-speech umożliwiają generowanie głosu na podstawie jego próbki i tekstu. Mogą one w znaczący sposób podnieść standard życia osób niepełnosprawnych, na przykład czytając na głos treści dla osób niewidomych, lub generując naturalnie brzmiący głos dla osób niemych.

Zagrożenia

Chociaż AI ma zdolność do nieskończonej kreatywności, wiąże się z nią szereg potencjalnych zagrożeń i pułapek. Wśród głównych tematów, które budzą obawy, są kwestie związane z prawem autorskim, naruszeniem prywatności, manipulacją i autentycznością.

Halucynacja

W 2023 roku Merriam Webster dodał nową definicję dla słowa “hallucination”:

computing : a plausible but false or misleading response generated by an artificial intelligence algorithm

Halucynacje modeli językowych to zjawisko, w którym model generuje odpowiedzi, które brzmią przekonująco i spójnie, ale zawierają informacje, które są nieprawdziwe, zmyślone lub nie mają pokrycia w danych treningowych modelu.

Halucynacje wynikają z tego, jak modele są trenowane. Uczone są przewidywania następnego słowa na podstawie kontekstu, dążąc do generowania płynnych odpowiedzi. Jednak modele nie mają głębokiego rozumienia faktów i mogą fabrykować informację.

Halucynacje są trudne do wykrycia, ponieważ wygenerowane odpowiedzi często brzmią sensownie i spójnie. Wymaga to weryfikacji faktów i porównania z rzetelnymi źródłami.

Głośnym przykładem halucynacji z zeszłego roku jest prawnik, który w treści pozwu przeciwko liniom lotniczym odniósł się do sześciu wcześniejszych pozwów, które nie miały miejsca w rzeczywistości. Były one halucynacjami ChatGPT.

Prawa autorskie

Dziedzina praw autorskich staje przed wyzwaniem w związku z twórczymi możliwościami AI. Kto jest właściwym autorem dzieła sztuki stworzonego przez sztuczną inteligencję?

Jeżeli model AI nauczył się tworzyć muzykę na podstawie utworów Beethovena, czy prawa autorskie należą do developera, do modelu AI, czy może do samego Beethovena?

Jeśli do nauki narzędzia Github Copilot firmy Microsoft został użyty spory zasób publicznych repozytoriów z platformy github z różnymi typami licencji, które momentami wymagają podania ich w momencie korzystaniu z danego kodu lub też w skrajnych przypadkach upublicznienie kodu źródłowego, to czy samo korzystanie z takiego narzędzia jest legalne?

Te pytania otwierają nowe pole dla debaty prawnej.

Afery

2 lipca 2021 roku Armin Ronacher opublikował tweet w którym prezentuje Copilota generującego kod funkcji liczącej odwrotność kwadratu liczby z kodu źródłowego Quake III Arena, dostępnego na licencji GPL. Copilot skopiował kod bez żadnych zmian, zachowując nawet oryginalne komentarze zawierające wulgaryzmy.

16 października 2022 roku Tim Davis opublikował tweet w którym przedstawia uruchomienie Copilota, który generuje jego własny kod, bez informacji o autorze i licencji LGPL.

3 listopada 2022 roku grupa zebrana przez Matthew Buttericka złożyła pozew zbiorowy przeciwko GitHubowi, Microsoftowi i OpenAI. Jak twierdzą jego autorzy, przez trenowanie swoich modeli na otwartoźródłowych repozytoriach, złamane zostały przepisy 11 popularnych licencji, które wymagają atrybucji oryginalnego autora. Twierdzą także że złamany został 1202 paragraf ustawy DMCA który zabrania usuwania informacji o prawach autorskich dzieła.

Naruszenie prywatności

Modele AI, takie jak GPT, są szkolone na ogromnych zestawach danych, które często pochodzą od osób prywatnych. Jeśli te informacje są wykorzystywane do tworzenia sztuki, powstaje pytanie o ochronę tych danych i prawo do prywatności.

Istnieją przypadki które wypominają jest firmie OpenAI niezgodność przetwarzania danych narzuconych przez GDPR (w Polsce RODO).

Manipulacja

Technologia AI ma potential do tworzenia niezwykle realistycznych obrazów, filmów i dźwięków. Taka zdolność do manipulowania danymi może prowadzić do powstania deepfake’ów i dezinformacji, co jest zagrożeniem dla społeczeństwa przez fałszywe wiadomości i manipulację.

W przypadku ChatGPT jest on bardzo często używany w celach automatyzacji czatów dla różnych firm w ramach kontaktu z klientami. Mimo zapewnień OpenAI odnośnie bezpieczeństwa, są liczne przypadki jailbreak’owania zabezpieczeń czatu przez co można zmusić go do celowego produkowania kłamstw.

Manipulacji sprzyjają również tak zwane deepfake’i czyli realistycznie wyglądające obrazy lub filmy, które przedstawiają fałszywe lub też nieistniejące sceny. W przypadku DALL-E, ma on wbudowany edytor, który pozwala na zmiany części scenerii obrazu co pozwala w dowolny sposób zmienić np. lokalizację w jakiej dana osoba się znajduje, przedmiot który trzyma itd.

Jest to bardzo duże zagrożenie między innymi w wydarzeniach takich jak wybory prezydenckie np. w USA, gdzie wpływ internetu i znajdującego się w nim materiałach ma ogromne przełożenie na wyniki sondażowe. AI jest w obecnym momencie najprostszym narzędziem do tworzenia fakenews’ów których efekty są przedmiotem badań wielu naukowców, np. wpływ fakenews’ów na wybory USA 2016

30 października 2023 roku Joe Biden wydał rozporządzenie wykonawcze które ma na celu zadbanie o bezpieczeństwo i wiarygodność sztucznej inteligencji. Jeden z punktów wymaga na twórcach AI stworzenia narzędzi które umożliwiają weryfikację treści stworzonych przez AI. Od 12 lutego wszystkie obrazy stworzone przez DALL-E zawierają metadane C2PA, które mogą być sprawdzane przy użyciu narzędzi jak Content Credentials Verify

Utrata pracy

AI, ze swoją zdolnością do uczenia się i twórczego generowania treści, może stwarzać realne zagrożenie dla twórców zawodowych. Muzycy, graficy, a nawet reżyserzy filmów mogą zostać zastąpieni przez algorytmy, które są w stanie produkcje bezustannie i bez potrzeby odpoczynku. Powstaje pytanie: czy roboty zastąpią ludzi w tych rolach? Czy ekonomiczne korzyści wynikające z zastosowania AI przewyższą wartość ludzkiego twórcy?

Już teraz możemy usłyszeć o firmach, które jako uzasadnienie zwolnień grupowych podają rozwój sztucznej inteligencji. Jednym z takich przykładów jest UPS, która na początku 2024 zwolniła 12 tysięcy pracowników. Dyrektorka generalna jako uzasadnienie podała rozwój technologii takich jak sztuczna inteligencja. Podany przykład dotyczył sprzedawców którzy dzięki uczeniu maszynowemu mogą tworzyć oferty bez dokładnych wycen od swojego kierownictwa.

14 sierpnia zeszłego roku IBM poinformowało o planach zwolnienia 8 tysięcy pracowników, którzy mogliby potencjalnie zostać zastąpieni przez sztuczną inteligencję. W ciągu kilku lat IBM chciałby zredukować ilość pracowników niemających kontaktu z klientem, takich jak działy HR, o 30%.

Według firmy outplacementowej Challenger, Gray & Christmas Inc, rozwój sztucznej inteligencji doprowadził do utraty pracy przez 4600 pracowników od ostatniego maja. Wiceprezes firmy twierdzi że prawdziwa ilość jest wyższa, ponieważ firmy obawiają się złej reputacji i burzliwych nagłówków, dlatego pomijają prawdziwy powód zwolnień.

Redukcja autentycznej twórczości

Kolejnym potencjalnym zagrożeniem jest stopniowy spadek autentycznej twórczości ludzkiej. Modele AI, takie jak te stworzone przez OpenAI, nauczają się na podstawie istniejących utworów muzycznych, obrazów i filmów. Jeżeli coraz więcej twórczości jest generowane przez AI, to może doprowadzić do sytuacji, w której już nie będzie nowych oryginalnych utworów, na których AI mogłaby się uczyć. Stracimy wówczas nie tylko różnorodność i oryginalność twórczości, ale także możliwość uczenia się i rozwoju AI.

![]()

Wnioski

Podczas gdy moce te są fascynujące, musimy jednak mieć na uwadze potencjalne zagrożenia, które niesie za sobą AI. Kwestie dotyczące praw autorskich, prywatności, manipulacji i autentyczności wywołują pytania o etykę i sposób regulacji AI. Co więcej, grozi nam utrata prawdziwej ludzkiej pracy twórczej, co prowadzi do spadków zarówno na rynku pracy, jak i w ilości dostępnych danych dla uczenia się modeli AI.

Sztuczna inteligenecja to rewolucja w pełnym tego słowa znaczeniu. Kiedy coraz więcej obszarów ludzkiego życia jest poddawanych jej wpływom, musimy zadać sobie pytanie: Jakie jest nasze miejsce w tym zdominowanym przez AI świecie? Jak możemy korzystać z tych narzędzi, jednocześnie zachowując naszą wartość, humanizm i twórczość?

Rozważania te są kluczowe, gdyż AI jest już wszędzie, i z całą pewnością zostanie z nami na dłużej. Musimy aktywnie tworzyć tę przyszłość, pamiętając, że technologia jest tylko narzędziem, a ostateczny kształt świata zależy od nas – ludzi.