Wraz z dynamicznym rozwojem LLMów (Dużych Modeli Językowych), takich jak GPT (Generative Pre-trained Transformer), pojawia się cała seria pytań dotyczących ich transparentności i wyjaśnialności. Z racji na coraz większą popularność tych modeli, istnieje rosnące zapotrzebowanie na zrozumienie, dlaczego modele podejmują konkretne decyzje i jakie są mechanizmy, które leżą u ich podstaw. Co więcej, Explainable AI może odgrywać kluczową rolę w zrozumieniu podstawowych przyczyn problemów powiązanych z LLMami, takich jak halucynacje, brak aktualnej wiedzy, czy brak klarowności źródeł z których pochodzą informacje w oparciu o które wygenerowana została dana odpowiedź. Warto jest więc przyjrzeć się właśnie tej stronie tych modeli, a co za tym idzie nie ufać im w ciemno i postawić sobie pytania – Jak? Skąd? i Dlaczego?

Waga Explainable AI w kontekście Dużych Modeli Językowych

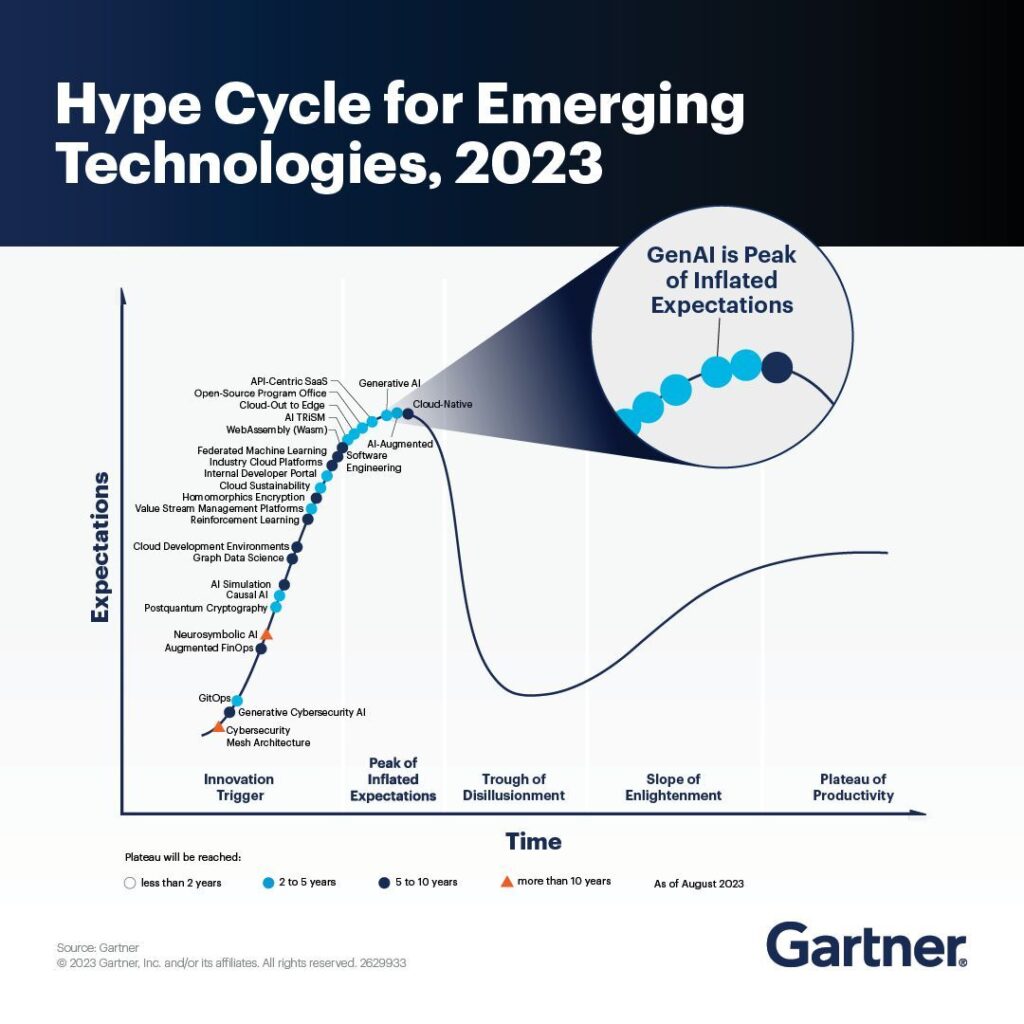

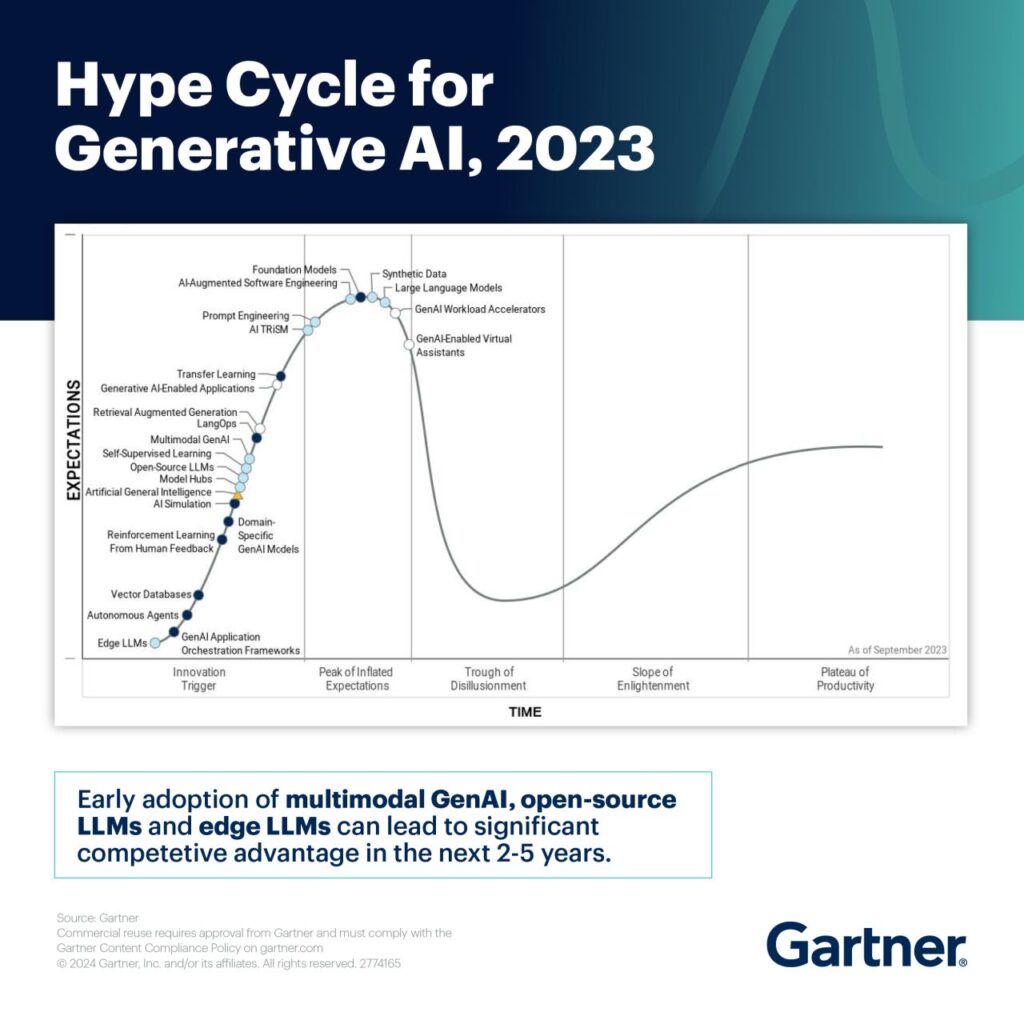

Jeśli spojrzymy na historię związaną z rozwojem coraz to nowszych algorytmów sztucznej inteligencji, często można zauważyć powtarzający się schemat w następującej formie: Nowy algorytm → Zastosowania domenowe (finanse, medycyna, geologia, itd.) → Ulepszanie algorytmów, Algorytmy wyjaśniające/ExplainableAI (XAI). Jest to dość naturalny cykl rozwojowy zarówno z perspektywy naukowo-badawczej, jak i wdrożeniowej. Z drugiej strony, jeśli spojrzymy na aktualne trendy w rozwoju nowych technologii, na przykład przyglądając się Gartner Hype Cycle, widzimy, że generatywna sztuczna inteligencja (GenAI), a zatem i duże modele językowe (LLMy, w tym oczywiście modele GPT) są w fazie tak zwanego „Szczytu wygórowanych oczekiwań”. Jeśli by więc zagłębić się w ten temat jeszcze bardziej i przyjrzeć się Hype Cycle w pełni poświęconemu GenAI, to zobaczymy, że we wspomnianym „Szczycie wygórowanych oczekiwań” znajdują się LLMy, ale także AI TRiSM (AI Trust, Risk, Security Management), czyli zestaw rozwiązań mających na celu identyfikację i ograniczenie ryzyka działania modeli AI. Fundamentami AI TRiSM są prywatność, bezpieczeństwo aplikacji AI, eksploatacja modeli oraz interesująca nas najbardziej – wyjaśnialność modeli oraz ich monitoring.

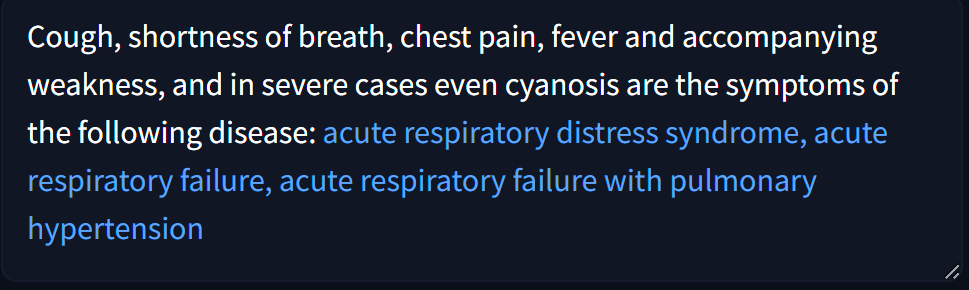

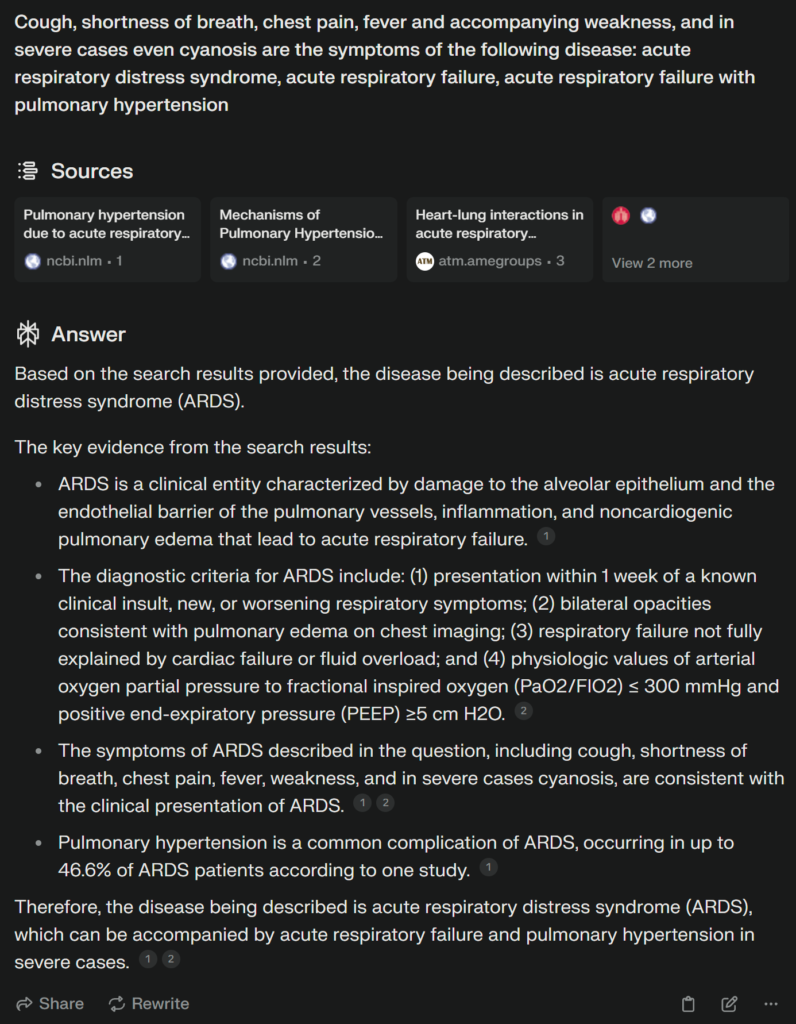

Widzimy więc, że explainatory modeli językowych są ważne z perspektywy hype’u wschodzących technologii, ale jak wygląda to z punktu widzenia społecznego, a w szczególności codziennych użytkowników tych narzędzi? Przede wszystkim transparentność i wyjaśnialność decyzji potrzebna jest do zwyczajnego zrozumienia i chęci poznania procesu decyzyjnego, który doprowadził to powstanie takiej odpowiedzi a nie innej. Jest to oczywiście dość trywialne stwierdzenie, ale w rzeczywistości jest ono kluczowe przy realizacji konkretnych rozwiązań dziedzinowych. Jako przykład przyjrzyjmy się modelowi BioGPT – LLM do zadań biomedycznych. Zrealizujmy zapytanie mające na celu próbę diagnozy choroby w oparciu o podane symptomy.

I właśnie tutaj pojawia się seria pytań – dlaczego właśnie takie choroby zostały zaproponowane jako potencjalna diagnoza? Które symptomy były kluczowe w podjęciu przez model decyzji? Czy podane przez model choroby w ogóle istnieją, a może są wynikiem halucynacji modelu? I właśnie tutaj z pomocą przychodzą modele wyjaśniania. Modele XAI mogą pomóc w odpowiedzi na te pytania poprzez dostarczenie wyjaśnień, które ułatwią zrozumienie procesu decyzyjnego modelu – mogą nam na przykład pokazać, które cechy objawów były najbardziej istotne dla danego wyniku, jakie dane wejściowe miały największy wpływ na wynik, jak model przyporządkował znaczenie poszczególnym objawom, a także jakie jest źródło danych w oparciu o które model ma posiadaną wiedzą.

Metody Explainable AI dla Dużych Modeli Językowych

W ostatnim czasie pojawiło się wiele różnorodnych propozycji metod XAI dla LLMów. Warto przyjrzeć się kilku wiodącym narzędziom, wśród których wyróżnić można:

- HELM (Holistic Evaluation of Language Models) – framework do oceny modeli językowych pod kątem szerokiego spektrum użytkowalności, w tym uczciwości, wydajności, odporności na halucynacje, toksyczności i wielu innych. Jest to ciągle aktualizowane narzędzie na przejrzystość modeli przy użyciu różnych scenariuszy, wskaźników i modeli. Jest więc to forma wyjaśnialności na poziomie globalnym, gdzie można przeprowadzić analizę, jak dane LLMy sprawdzą się w danym zadaniu, np. pod względem toksyczności generowanych treści

- ANE (Automatic Neuron Explanation) – metodologia, która do interpretacji działania modeli GPT wykorzystuje… model GPT! Jest to proces 3stopniowy którego główną domeną działania jest inspekcja działania poszczególnych neuronów i warstw atencji. W pierwszej kolejności, korzystając z neuronu z GPT-2, generowane jest wyjaśnienie jego zachowania, pokazując odpowiednie sekwencje tekstowe i aktywacje do GPT-4. Następnie GPT-4 jest używany do przewidywania aktywacji neuronów dla każdego tokena w danej sekwencji, przy założeniu, że proponowane wyjaśnienie dokładnie i kompleksowo wyjaśnia zachowanie neuronu. Wreszcie, w ostatnim kroku, następuje ocena wyjaśnień poprzez porównanie zachowania symulowanego neuronu z zachowaniem rzeczywistego neuronu. Jest więc to dość ciekawe podejście do problemu, aczkolwiek wiąże się z dość sporą gamą ograniczeń, w tym wymogiem dość sporych zasobów obliczeniowych, brakiem eksploracji bardziej rozbudowanych połączeń neuronowych i wciąż pozostawiając pewną czarno-skrzynkową naturę.

- Phoenix – narzędzie dedykowane raczej inżynierom i data scientistom, które umożliwia dogłębną analizę działania modelu z wykorzystaniem podejścia notatnikowego. Z wykorzystaniem Phoenix’a można zbadać LLM pod względem m.in. śledzenia wykonywania generacji, ewaluacji (toksyczności, trafności, itp.), analizy osadzeń, czy też wizualizacji procesu wyszukiwania danych w celu usprawnienia procesu generowania z rozszerzonym wyszukiwaniem RAG.

Widzimy więc, że metodologia XAI rozwija się prężnie w obrębie LLMów, chociaż każde narzędzie ma oczywiście pewne minusy – czy to wyłącznie wyjaśnialność na poziomie globalnym, czy ograniczoną eksplorację, czy w końcu zaawansowany charakter działania dedykowany inżynierom i programistom.

Szersze spektrum metodologii wyjaśniania

W jaki więc sposób wprowadzić warstwę wyjaśnialną do codziennych zastosowań modeli GPT, która może być wykorzystywana przez każdego użytkownika tych narzędzi? Odpowiedź na to pytanie nie jest już jakkolwiek trywialna, a dodatkowo można by powiedzieć, że to wszystko zależy od tego, ile czasu jesteśmy w stanie poświęcić na zrozumienie podjętych przez model decyzji i analizę otrzymanych w rezultacie wyników.

Analiza scenariuszy

Przyjrzyjmy się zatem w pierwszej kolejności następującemu podejściu. Z racji, że proces generatywny ma w sobie oczywiste elementy stochastyczne, generowanie treści przez modele GPT ma pewien pierwiastek losowy (kontrolowany na różne sposoby), który przyczynia się do tego, że odpowiedzi generowane na to samo zapytanie nie zawsze będą identyczne. Chociaż zwykle sens danej wypowiedzi zostanie zachowany, cała wypowiedź będzie różnić się znakami interpunkcyjnymi, składnią itp., co jest oczywiście wynikiem tego, że LLMy dokonują generacji token po tokenie. W związku z tym można przeprowadzić eksperyment, w którym to samo zapytanie do modelu typu ChatGPT puszczone zostanie setki razy. Powstanie wówczas pewien „globalny” łańcuch myśli, który będzie dość wnikliwą analizą generacyjnego procesu token po tokenie wraz z rozbudowanym przeglądem możliwych alternatyw. Realizacja tego pomysłu została wykonana na przykład przez Look into Machine’a Mind, gdzie eksploracji poddane zostaje dokończenie promptu „Intelligence is”:

Tego typu podejście zapewnia więc spojrzenie na naturę otrzymywanych odpowiedzi i dodatkowo pozwala na pewną formę manipulacji otrzymanym tekstem. Jest więc to zdecydowanie ciekawa forma alternatywna do klasycznych explainatorów, która nie wymaga żadnej wiedzy technicznej, aczkolwiek wymaga dość dużego nakładu czasowego na analizę.

Wsparcie silnikiem wyszukiwań z częścią AI

Oczywiście zanim nardzędzia pokroju ChatGPT stały się towarzyszami naszej pracy, wyszukiwanie i weryfikacja treści opierała się niemalże w całości o wyszukiwarki jak Google czy Bing, więc mowa tutaj o potocznym googlowaniu. A jeśliby połączyć siłę generowanych treści przez LLMy z benefitami wyszukiwania, czyli dostępem do źródeł danych, w oparciu o które otrzymujemy wyniki? Takie rozwiązanie wprowadziłoby dodatkową formę abstrakcji, która umożliwiłaby nam, użytkownikom, dodatkowe zagłębienie w analizę otrzymanych treści. Możemy więc z naszej perspektywy spojrzeć na to jako na wyjaśnialność lokalną (dla generowanej wypowiedzi) w oparciu o wiedzę globalną (zewnętrzne źródła danych i teksty). Tak się składa, że takie rozwiązanie jest oferowane przez Perplexity.ai, będące wyszukiwarką konwersacyjną, która wykorzystuje LLM do dostarczania informacji za pośrednictwem interfejsu w stylu chatbota. Perplexity.ai rozwiązuje w głównej mierze dwa problemy LLMów – brak świeżości generowanych treści i aktualnych informacji oraz halucynacje, co jest właśnie wynikiem dodania warstwy wyszukiwarkowej. Jako przykład wprowadźmy do narzędzia Perpliexity.ai wyniki wygenerowane przez BioGPT.

I jak możemy zobaczyć otrzymujemy bardzo precyzyjną odpowiedź potwierdzającą słuszność otrzymanych wcześniej wyników wraz z zagłębieniem w szczegóły prowadzące do takiej diagnozy. Co więcej, wyniki poparte są serią bardzo wiarygodnych źródeł (w tym przypadku pochodzące z National Library of Medicine), co wpływa pozytywnie na odbiór otrzymanych treści, gdyż są one zweryfikowane pod kątem prawdziwości.

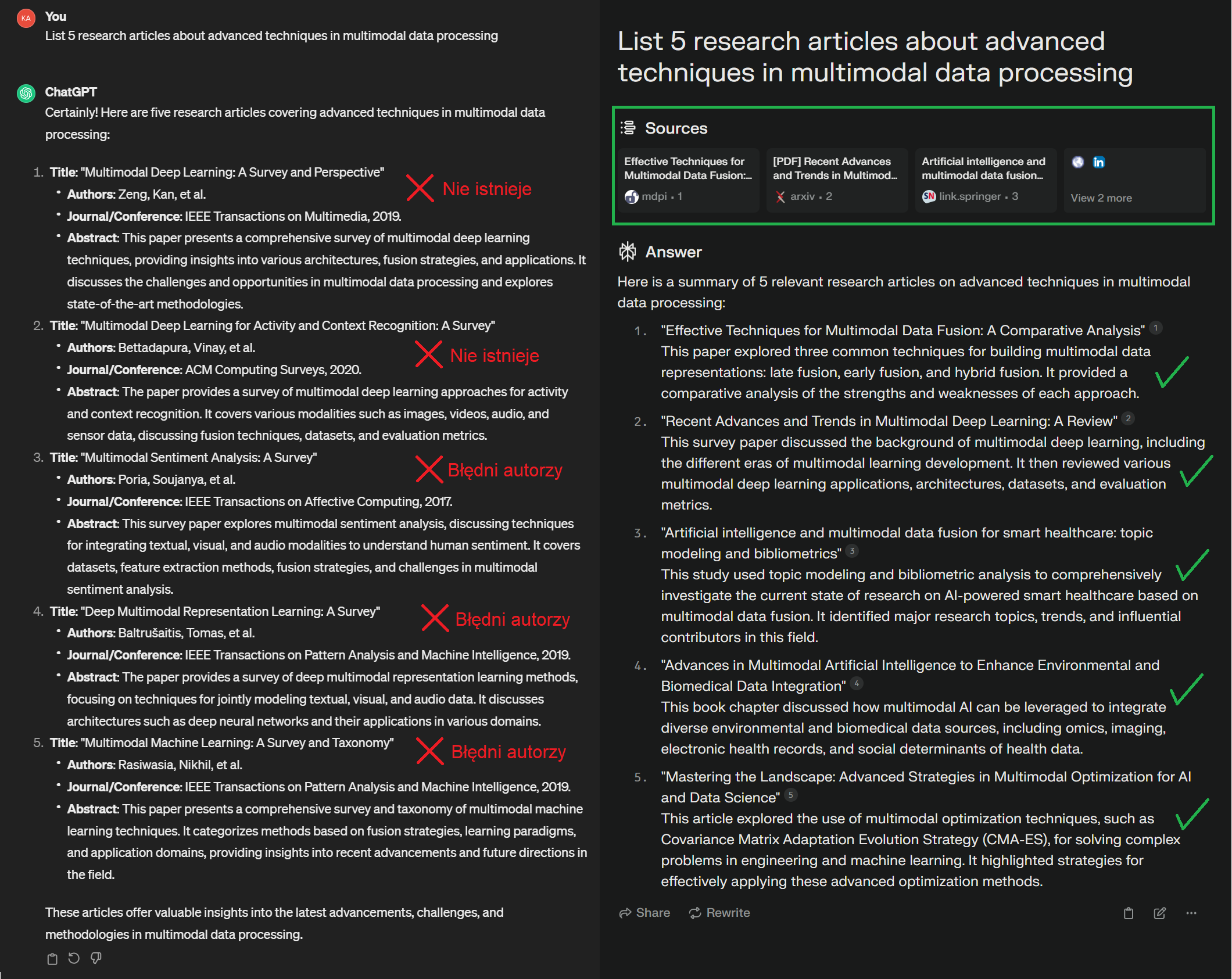

Spójrzmy jeszcze dokładnie na koncept eliminacji halucynacji modelu. Zapytajmy zarówno ChatGPT jak i Perplexity.ai o wylistowanie artykułów naukowych na określony temat.

Jak zauważyć możemy i w tym przypadku Perplexity.ai sprawiło się wyśmienicie i podało istniejące artykuły, polinkowując ich źródła, gdzie ChatGPT z kolei zawiódł całkowicie i podał nieistniejące artykuły, bądź pomylił autorów.

Podsumowanie

Wyjaśnialność sztucznej inteligencji, zwłaszcza w kontekście dużych modeli językowych, staje się coraz ważniejsza. Modelowanie wyjaśnialności może pomóc w zrozumieniu procesu decyzyjnego tych modeli oraz identyfikacji ich potencjalnych problemów, takich jak halucynacje czy brak aktualnej wiedzy. W tym wpisie przejrzeliśmy kilka popularnych narzędzi i metodologii, które dostarczają wyjaśnialność zarówno na poziomie globalnym jak i lokalnym, a także prowadzą do zrozumienia niskopoziomowego oraz wysokopoziomowego. Wprowadzenie warstwy wyjaśnialnej do codziennych zastosowań modeli GPT jest kluczowe dla zapewnienia transparentności i zaufania użytkowników oraz efektywnego wykorzystania tych zaawansowanych narzędzi AI.

Literatura

- Luo, R., Sun, L., Xia, Y., Qin, T., Zhang, S., Poon, H., & Liu, T. Y. (2022). BioGPT: generative pre-trained transformer for biomedical text generation and mining. Briefings in bioinformatics, 23(6), bbac409.

- medium.com/@alaeddineayadi/advanced-techniques-in-explainable-ai-xai-for-a-responsible-large-language-models-4c472fde996e

- linkedin.com/pulse/deep-dive-explainable-ai-llms-talan-innovation-factory-talan-tun-gzilf/

- Bills, S., Cammarata, N., Mossing, D., Tillman, H., Gao, L., Goh, G., … & Saunders, W. (2023). Language models can explain neurons in language models. URL https://openaipublic. blob. core. windows. net/neuron-explainer/paper/index. html.(Date accessed: 14.05. 2023).

- openai.com/research/language-models-can-explain-neurons-in-language-models

- producthunt.com/posts/look-into-the-machine-s-mind

- perplexity.ai/hub/faq/what-is-perplexity