W dobie postępującej cyfryzacji wymiaru sprawiedliwości coraz częściej mówi się o wykorzystaniu sztucznej inteligencji (SI) w sądownictwie. Jednym z najbardziej obiecujących kierunków rozwoju jest automatyzacja analizy akt spraw sądowych. Technologia ta ma potencjał, by zrewolucjonizować funkcjonowanie sądów – przyspieszyć pracę sędziów, zredukować zaległości oraz zwiększyć dostępność prawa. Z drugiej strony jednak, jej wdrożenie budzi poważne obawy – przede wszystkim w kontekście ochrony danych osobowych, prawa do prywatności oraz tajemnicy adwokackiej. Gdzie zatem leży granica między technologicznym postępem a poszanowaniem praw podstawowych?

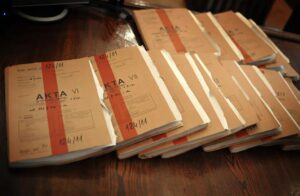

Systemy sądownicze na całym świecie zmagają się z narastającym problemem przewlekłości postępowań, a jednym z głównych czynników tego stanu rzeczy jest konieczność ręcznego przeglądania i analizy ogromnej ilości dokumentacji procesowej. W sprawach sądowych codziennie przetwarzane są setki tysięcy stron dokumentów – od pism procesowych, poprzez załączniki, aż po orzeczenia. Sędziowie, prokuratorzy i adwokaci poświęcają ogromne ilości czasu na ręczne zapoznanie się z aktami sprawy. Według danych Ministerstwa Sprawiedliwości w Polsce tylko w 2022 roku do sądów wpłynęło ok. 15 milionów spraw (WEB1), a czas oczekiwania na rozstrzygnięcie wynosił średnio od kilku miesięcy do nawet kilku lat. W tym kontekście sztuczna inteligencja jawi się jako potencjalny ratunek dla wymiaru sprawiedliwości. Nowoczesne narzędzia przetwarzania języka naturalnego (Natural Language Processing, NLP) oraz eksploracji danych (Data Mining) potrafią analizować teksty prawne w sposób szybki, precyzyjny i kontekstowy, co może wspomóc sędziów i asystentów w przygotowaniu do rozpraw, optymalizując ich czas pracy i podnosząc efektywność całego systemu.

Potencjał SI w analizie dokumentów prawnych

Sztuczna inteligencja – zwłaszcza modele przetwarzania języka naturalnego, takie jak GPT, BERT, RoBERTa, BigBird – potrafi analizować ogromne zbiory dokumentów prawnych nie tylko szybko, ale również z dużą precyzją i uwzględnieniem kontekstu semantycznego, co czyni je szczególnie przydatnymi w środowiskach, gdzie liczy się efektywność i rzetelność analizy tekstu. W praktyce oznacza to, że możliwe staje się:

- automatyczne streszczanie akt sprawy, pozwalające sędziom i prawnikom na szybkie zapoznanie się z kluczowymi informacjami bez przeglądania setek stron dokumentów,

- identyfikacja najważniejszych wątków, stron sporu, głównych roszczeń i powołanych przepisów prawa,

- rozpoznawanie powiązań między dokumentami, umożliwiające szybkie odnajdywanie powiązanych spraw, wcześniejszych orzeczeń lub istotnych dowodów, które mogłyby zostać przeoczone podczas tradycyjnej analizy,

- wyszukiwanie precedensów i przepisów powiązanych z daną sprawą – system może błyskawicznie przeszukać tysiące orzeczeń, wykrywając podobieństwa i różnice, a nawet sugerować możliwe kierunki rozstrzygnięcia na podstawie analizy wcześniejszych wyroków w podobnych sprawach,

- automatyczna klasyfikacja typów pism procesowych i orzeczeń – np. rozróżnianie postanowień od wyroków czy wniosków od zażaleń – umożliwiająca szybsze katalogowanie i organizację dokumentów.

W rezultacie analiza akt, która w tradycyjnym ujęciu mogła zajmować dni lub nawet tygodnie, dzięki wsparciu SI może zostać przeprowadzona w ciągu kilku godzin – bez obniżenia jakości, a często nawet z wyższą dokładnością dzięki eliminacji ludzkich błędów i przeoczeń. Wymiar sprawiedliwości zyskuje zatem potężne narzędzie, które nie tylko usprawnia pracę, ale może również przyczynić się do zwiększenia dostępności do sprawiedliwości i skrócenia czasu oczekiwania na rozstrzygnięcie.

Automatyzacja sprawiedliwości na świecie

W niektórych państwach technologie wspomagające wymiar sprawiedliwości nie są już jedynie koncepcją, ale stają się elementem codziennej praktyki. Służą nie tylko do porządkowania dokumentów, ale coraz częściej pełnią rolę asystentów decyzyjnych, wspierając prawników, prokuratorów i sędziów. Różne kraje stosują własne podejście do integracji SI z systemem prawnym, każde nacechowane lokalnym kontekstem instytucjonalnym i kulturowym.

Chiny: prokurator wspomagany przez algorytm

Chiny należą do światowych liderów w zakresie wdrażania technologii sztucznej inteligencji w sektorze publicznym, w tym również w wymiarze sprawiedliwości. Jednym z najciekawszych, ale też budzących kontrowersje przykładów jest zastosowanie SI w prokuraturze. W 2021 roku chińscy naukowcy z Shanghai Pudong People’s Procuratorate ogłosili wytworzenie systemu, który potrafi automatycznie klasyfikować przestępstwa i rekomendować akt oskarżenia z dokładnością sięgającą 97% (Wu 2025). System został przeszkolony na setkach tysięcy przypadków z przeszłości i potrafi zidentyfikować osiem najczęściej występujących kategorii przestępstw, m.in. kradzież, oszustwo, prowadzenie nielegalnego hazardu, napaść czy zakłócanie porządku publicznego.

Choć decyzje podejmowane przez system nie są jeszcze wiążące – ostatnie słowo zawsze należy do człowieka – to w praktyce rekomendacje algorytmu mają realny wpływ na przebieg postępowania przygotowawczego. Prokuratorzy z jednostek pilotażowych, zwłaszcza w sprawach gospodarczych, cyberprzestępczości czy drobnych wykroczeń, mogą w szybki sposób uzyskać podpowiedź co do kwalifikacji czynu i niezbędnych kroków procesowych. Dzięki temu rola prokuratora ulega stopniowej ewolucji: z klasycznego analityka akt w stronę nadzorcy i korektora decyzji generowanych przez SI.

USA: algorytmy predykcyjne w służbie kancelarii i sądów

W Stanach Zjednoczonych rozwój technologii prawnych, znanych jako LegalTech, przybrał imponujące tempo – zarówno w sektorze prywatnym, jak i publicznym. Kancelarie prawne coraz chętniej sięgają po narzędzia oparte na SI, które wspomagają ich pracę na wielu poziomach: od przeszukiwania baz orzeczeń, przez analizę kontraktów, aż po tworzenie strategii argumentacyjnych w sprawach sądowych. Przykładem są takie rozwiązania jak Casetext (wykorzystujący GPT do automatyzacji analiz prawnych), ROSS Intelligence (bazujący na IBM Watson, zamknięty po sporze prawnym z LexisNexis w 2021 roku) czy DoNotPay – bot prawny oferujący pomoc w prostych sprawach administracyjnych, np. odwołaniach od mandatów czy sporach z korporacjami.

Najbardziej kontrowersyjne zastosowania SI w systemie sprawiedliwości USA dotyczą algorytmów predykcyjnych wykorzystywanych przez sądy. Jednym z najgłośniejszych przypadków jest system COMPAS (Correctional Offender Management Profiling for Alternative Sanctions), stosowany w wielu stanach do oceny ryzyka recydywy. COMPAS analizuje dane demograficzne, historię przestępstw oraz odpowiedzi oskarżonego na zestandaryzowany kwestionariusz, a jego wynik wpływa na decyzje sędziego – np. o warunkowym zwolnieniu, wysokości kaucji czy długości kary.

W 2016 roku dziennikarze śledczy z ProPublica opublikowali raport, w którym stwierdzili, że COMPAS wykazuje systemowe uprzedzenia rasowe (Larson 2016). Algorytm przewidywał znacznie wyższe ryzyko recydywy dla osób czarnoskórych niż białych, nawet jeśli ich przeszłość kryminalna była identyczna. Osoby czarnoskóre były znacznie częściej błędnie klasyfikowane jako „wysokiego ryzyka”, mimo że w rzeczywistości nie wracały na drogę przestępstwa. Odwrotnie – osoby białe częściej były oceniane jako „niskiego ryzyka”, mimo że popełniały kolejne przestępstwa. To ujawnienie pokazało, jak głęboko nieprzejrzyste i niedostatecznie kontrolowane algorytmy mogą wpływać na realne życie ludzi, podejmując decyzje powielające i potęgujące istniejące nierówności społeczne.

Estonia: robot-sędzia dla drobnych spraw cywilnych?

W przestrzeni medialnej pojawiało się wiele doniesień na temat rzekomego projektu „sędziego-robota” w Estonii, jednak informacje te są mylące. Jak wyjaśnia estońskie Ministerstwo Sprawiedliwości, nigdy nie istniał projekt ani nawet ambicja stworzenia systemu SI, który zastępowałby sędziów w postępowaniach sądowych. Celem działań resortu jest poszukiwanie technologicznych rozwiązań, które pozwolą odciążyć sądy poprzez automatyzację i optymalizację wybranych etapów postępowań – zarówno cywilnych, jak i administracyjnych. Jednym z takich kierunków jest przekształcenie tradycyjnych postępowań opartych na papierowej lub elektronicznej dokumentacji w postępowania oparte na danych, w których informacje mają określone znaczenie prawne, a dokumenty służą jedynie powiadamianiu uczestników procesu (WEB2). Przykładem konkretnego zastosowania może być estońska procedura nakazu zapłaty – uproszczone postępowanie, które obecnie stanowi około 50% wszystkich spraw cywilnych w kraju. Jest ona już w dużej mierze zautomatyzowana i prowadzona wyłącznie elektronicznie, bez konieczności podpisywania dokumentów czy tworzenia papierowych akt. W przyszłości rozważa się jej pełną automatyzację. Jednocześnie estońskie Ministerstwo Sprawiedliwości prowadzi projekty wykorzystujące uczenie maszynowe w bardziej wspomagających zastosowaniach, takich jak automatyczna transkrypcja rozpraw sądowych czy anonimizacja orzeczeń.

Wrażliwe dane pod lupą algorytmu

Choć korzyści z wykorzystania SI w sądownictwie wydają się oczywiste, należy postawić pytania: jakie dane będą analizowane przez systemy sztucznej inteligencji, kto będzie miał do nich dostęp oraz kiedy przetwarzanie danych w aktach spraw przez algorytmy narusza prawo do prywatności obywateli?

Akta spraw sądowych zawierają niezwykle wrażliwe informacje: dane osobowe, dane medyczne, detale życia prywatnego, finanse, informacje o dzieciach, przeszłości kryminalnej, zdrowiu psychicznym i wiele więcej. Przetwarzanie tych danych przez algorytmy niesie ze sobą ryzyko naruszenia tajemnicy zawodowej – adwokackiej, lekarskiej, czy dziennikarskiej – a także potencjalnego wycieku informacji.

Zgodnie z europejskim Rozporządzeniem o Ochronie Danych Osobowych (RODO, GDPR) każda operacja przetwarzania danych musi być uzasadniona i prowadzona zgodnie z zasadami minimalizacji, przejrzystości i bezpieczeństwa. Oznacza to, że system SI analizujący akta sprawy musi być odpowiednio zabezpieczony, a dane przetwarzane powinny być – jeśli to możliwe – zanonimizowane.

Czy anonimizacja wystarczy?

Jednym z najczęściej proponowanych rozwiązań jest anonimizacja danych – usunięcie lub zaszyfrowanie wszelkich informacji pozwalających zidentyfikować konkretne osoby. W kontekście spraw sądowych to zadanie jest jednak trudniejsze, niż się wydaje. Jak pokazuje badanie Sweeney z 2000 roku, w 87% przypadków mieszkańców USA wystarczyła kombinacja kodu pocztowego, płci i daty urodzenia, by jednoznacznie zidentyfikować daną osobę. Nawet po usunięciu imion, nazwisk czy numerów PESEL, kontekst sprawy (np. nazwa firmy, lokalizacja, charakter przedsiębiorstwa, konkretne okoliczności) może wystarczyć do zidentyfikowania uczestników procesu. Co więcej, automatyczna anonimizacja tekstów prawniczych wymaga zaawansowanych modeli NLP wyszkolonych na specjalistycznych korpusach językowych, co w wielu krajach, w tym w Polsce, dopiero raczkuje.

Dodatkowo jeśli dane są używane do trenowania modeli SI, ich późniejsze usunięcie z systemu jest często technicznie niemożliwe. Modele językowe uczą się wzorców i treści w sposób nieodwracalny – co oznacza, że nawet po usunięciu oryginalnego dokumentu, jego zawartość może wciąż „pozostać” w modelu w formie statystycznej reprezentacji. Prowadzi to do dylematu znanego jako problem „zapominania” w SI – wciąż nierozwiązanego w pełni w praktyce.

Tajemnica adwokacka a sztuczna inteligencja

Tajemnica adwokacka jest jednym z filarów systemu prawnego – gwarantuje stronom prawo do swobodnej komunikacji ze swoim pełnomocnikiem i budowania linii obrony bez obawy, że ich rozmowy zostaną ujawnione. Jest to nie tylko etyczny obowiązek, ale także fundament zaufania w relacji klient–pełnomocnik oraz konstytucyjna gwarancja prawa do obrony. Przekazanie takich dokumentów do analizy SI może rodzić pewne obawy co do potencjalnego naruszenia tajemnicy adwokackiej. Szczególnie kontrowersyjne staje się korzystanie z rozwiązań oferowanych przez podmioty trzecie – np. usług analitycznych w chmurze lub modeli AI rozwijanych przez zewnętrzne firmy technologiczne. W takich przypadkach ryzyko nieautoryzowanego dostępu do wrażliwych danych, ich utraty lub niezgodnego z prawem wykorzystania staje się realne i trudne do zignorowania.

Aby uniknąć naruszenia tajemnicy zawodowej, konieczne jest wdrożenie najwyższych standardów bezpieczeństwa obejmujących:

- szyfrowanie danych,

- certyfikowane środowiska przetwarzania,

- ścisłą kontrolę dostępu,

- pełną audytowalność operacji oraz możliwość ich późniejszego zweryfikowania.

Mimo to wiele kancelarii i instytucji publicznych decyduje się na bardziej konserwatywne podejście – wykorzystując rozwiązania AI wyłącznie w ramach środowisk on-premise, czyli instalowanych lokalnie na własnej infrastrukturze serwerowej, bez udziału chmury publicznej. Takie podejście nie tylko znacząco ogranicza ryzyko naruszenia poufności, ale także zapewnia pełną kontrolę nad danymi wrażliwymi i przetwarzanymi modelami. W przypadku organów wymiaru sprawiedliwości lub większych kancelarii może to oznaczać konieczność tworzenia dedykowanych narzędzi AI, przeszkolonych na własnych, ściśle chronionych zbiorach danych. W rezultacie możliwe jest korzystanie z dobrodziejstw SI bez rezygnowania z fundamentalnych zasad tajemnicy zawodowej i prawa do prywatności.

Sędzia algorytmiczny a sprawiedliwość proceduralna

Transparentność działania algorytmów to jedna z kluczowych wartości, bez której nie sposób mówić o odpowiedzialnym wykorzystaniu sztucznej inteligencji w systemie wymiaru sprawiedliwości. W sądownictwie każda decyzja ma bezpośredni wpływ na prawa, wolności i obowiązki obywateli. W teorii prawa mówi się o sprawiedliwości proceduralnej – uczciwości i transparentności procesu decyzyjnego, niezależnie od jego wyniku. Nie wystarczy więc, że algorytm „działa” – musi być również zrozumiały i możliwy do skontrolowania. Zarówno sędziowie, jak i strony postępowania powinni mieć dostęp do informacji, na jakiej podstawie system SI sformułował swoje rekomendacje, analizy czy klasyfikacje.

Rozwiązaniem może być implementacja koncepcji explainable AI (XAI), wyjaśnialnej sztucznej inteligencji. W przeciwieństwie do tradycyjnych modeli typu „czarna skrzynka” – które mogą być skuteczne, ale nieprzejrzyste – systemy XAI dostarczają użytkownikowi jasnego uzasadnienia swoich działań. Oznacza to nie tylko wskazanie wyniku, ale również ujawnienie, które dane wejściowe i jakie cechy sprawy miały największy wpływ na wynik, oraz w jaki sposób model je zinterpretował (Ali 2023).

Takie podejście umożliwia krytyczną ocenę działania algorytmu. Sędzia może stwierdzić, czy sugestia systemu faktycznie odnosi się do istotnych aspektów sprawy, czy też została wygenerowana na podstawie błędnych lub niekompletnych danych – np. wskutek ukrytej stronniczości w danych treningowych (bias), które mogą faworyzować jedną grupę społeczną kosztem innej. Transparentność algorytmu pozwala także na jego audytowalność, która jest nieodzowna z punktu widzenia odpowiedzialności instytucjonalnej i praw obywatelskich.

Brak wyjaśnialności niesie ryzyko naruszenia fundamentalnych zasad sprawiedliwości proceduralnej, takich jak prawo do obrony, prawo do poznania podstaw decyzji sądu czy prawo do odwołania się od decyzji na podstawie jej treści. Nawet najbardziej zaawansowany technologicznie system może wówczas prowadzić do rozstrzygnięć, których nikt nie będzie w stanie zweryfikować ani zakwestionować. Dlatego też transparentność i audytowalność powinny być traktowane nie jako opcjonalne dodatki do systemów SI w sądownictwie, ale jako ich nieodłączne komponenty – warunki konieczne dla zachowania zaufania społecznego, legalności i legitymizacji nowoczesnego wymiaru sprawiedliwości.

Zautomatyzowana stronniczość: uprzedzenia danych i dyskryminacja

Jednym z najpoważniejszych zagrożeń związanych z wykorzystaniem sztucznej inteligencji w wymiarze sprawiedliwości jest zautomatyzowana stronniczość – czyli sytuacja, w której algorytm nie tylko powiela uprzedzenia obecne w danych, na których był trenowany, ale wręcz je utrwala i wzmacnia. Modele SI nie funkcjonują w próżni, uczą się na historycznych danych, które odzwierciedlają realne działania, decyzje i – co za tym idzie – także błędy oraz niesprawiedliwości przeszłości. Jeśli dane źródłowe zawierają ślady systemowych uprzedzeń – na przykład surowszego traktowania przedstawicieli określonych grup etnicznych, społecznych czy ekonomicznych – model może nieświadomie te wzorce reprodukować.

Taka sytuacja może być szczególnie niebezpieczna w kontekście transnarodowego transferu technologii. Przeniesienie algorytmu stworzonego w jednym kontekście kulturowo-prawnym do innego kraju – bez lokalnej walidacji, analizy różnic systemowych czy zaadaptowania modelu do lokalnych realiów – grozi nie tylko błędnymi rozstrzygnięciami, ale także legalizacją nierówności społecznych.

Aby temu przeciwdziałać, niezbędne są środki zaradcze: różnorodność danych treningowych, mechanizmy audytujące dane wejściowe i wyjściowe, narzędzia do detekcji uprzedzeń oraz testowanie modeli pod kątem sprawiedliwości (fairness testing) przed ich wdrożeniem. Równie istotne jest zaangażowanie interdyscyplinarnych zespołów – prawników, etyków, informatyków i socjologów – w proces projektowania i wdrażania algorytmów, które mają funkcjonować w obszarze wymiaru sprawiedliwości.

Czy sztuczna inteligencja może zrozumieć człowieka?

Automatyzacja analizy akt sądowych to bez wątpienia krok ku sprawniejszemu wymiarowi sprawiedliwości. Nie może to być jednak krok stawiany na ślepo, bez refleksji nad konsekwencjami społecznymi, etycznymi i prawnymi. Sztuczna inteligencja w sądach to nie tylko narzędzie – to nowy uczestnik procesu prawnego, który musi podlegać tym samym zasadom przejrzystości i odpowiedzialności, co ludzie. Na poziomie filozoficznym warto się zastanowić, czy algorytm może rozpoznać niuanse ludzkiego doświadczenia, emocji i kontekstu społecznego. Prawnicy często podkreślają, że prawo nie jest czystą logiką – to także interpretacja, współczucie oraz świadomość skutków społecznych decyzji. Zautomatyzowana analiza może wspomagać proces decyzyjny, ale nie zastąpi ludzkiego osądu, zwłaszcza tam, gdzie rozstrzygnięcia wymagają empatii, moralnej odwagi lub elastyczności prawa. Temida powinna pozostać ludzka, w przeciwnym razie zamiast sprawiedliwości dostaniemy tylko jej imitację.

Źródła

- Ministerstwo Sprawiedliwości, Podsumowanie pracy sądów w 2022 roku

https://www.gov.pl/web/sprawiedliwosc/sady-pracuja-sprawniej - Wu, W., & Lin, X. (2025). Access to technology, access to justice: China’s artificial intelligence application in criminal proceedings. International Journal of Law, Crime and Justice, 81, 100741.

https://www.sciencedirect.com/science/article/pii/S1756061625000175 - Larson, J., Angwin, J., Kirchner, L., & Mattu, S. (2016, May 23). How we analyzed the compas recidivism algorithm. ProPublica.

https://www.propublica.org/article/how-we-analyzed-the-compas-recidivism-algorithm - Republic of Estonia, Ministry of Justice and Digital Affairs, Estonia does not develop AI Judge

https://www.justdigi.ee/en/news/estonia-does-not-develop-ai-judge - Ali, S., Abuhmed, T., El-Sappagh, S., Muhammad, K., Alonso-Moral, J. M., Confalonieri, R., … & Herrera, F. (2023). Explainable Artificial Intelligence (XAI): What we know and what is left to attain Trustworthy Artificial Intelligence. Information fusion, 99, 101805.

https://www.sciencedirect.com/science/article/pii/S1566253523001148