Każdego dnia zostawiamy w internecie tysiące śladów cyfrowych, które mówią o nas więcej niż sądzimy. Chiński system zaufania społecznego wykorzystuje te informacje do oceny obywateli, wpływając na ich życie zawodowe i społeczne. Czy podobny model można wdrożyć w Europie? Jaką rolę odgrywają w tym procesie sztuczna inteligencja i Data Science?

Wprowadzenie

Współczesny świat nieustannie ewoluuje w kierunku coraz głębszej cyfryzacji, co prowadzi do sytuacji, w której życie codzienne w dużej mierze przenosi się do przestrzeni wirtualnej. Każdy klik, wyszukiwanie, transakcja czy komentarz pozostawia trwały ślad cyfrowy. Te z pozoru niewinne działania są nie tylko rejestrowane, lecz również analizowane przez zaawansowane algorytmy oparte na technologiach sztucznej inteligencji oraz Data Science. W efekcie nasze życie staje się coraz bardziej transparentne dla tych, którzy kontrolują dostęp do gromadzonych danych. Na tym tle szczególnie interesujący staje się przykład Chin, gdzie państwo oficjalnie wdrożyło system zaufania społecznego, wykorzystujący cyfrowe ślady obywateli do oceny ich postępowania. Powstaje pytanie, czy i w jakim zakresie podobny system mógłby znaleźć swoje miejsce w Europie, biorąc pod uwagę odmienność kulturową, społeczną oraz prawną naszego kontynentu.

Cyfrowy ślad – nasze życie zapisane w danych

Ślad cyfrowy to wszystkie dane pozostawiane przez użytkowników podczas interakcji z urządzeniami elektronicznymi, stronami internetowymi oraz aplikacjami mobilnymi. Każda czynność – od wyszukiwania informacji, przez zakupy online, aż po aktywność na portalach społecznościowych – generuje ogromne ilości danych, które mogą być wykorzystywane do profilowania użytkowników. Główne źródła tych informacji to media społecznościowe takie jak Facebook czy Instagram, platformy zakupowe typu Amazon, a także wyszukiwarki internetowe jak Google.

Z punktu widzenia analizy danych szczególnie cenne są metadane, które opisują kontekst aktywności użytkowników: lokalizację, czas, urządzenie czy sposób korzystania z serwisów. Dzięki zaawansowanym technikom analitycznym, takim jak uczenie maszynowe czy analiza predykcyjna, firmy technologiczne mogą precyzyjnie określać preferencje, zwyczaje, a nawet przewidywać przyszłe zachowania użytkowników. O ile z jednej strony umożliwia to świadczenie usług lepiej dostosowanych do indywidualnych potrzeb, o tyle z drugiej strony rodzi poważne pytania dotyczące prywatności i etyki zbierania danych.

Każdy ślad cyfrowy może zostać użyty do oceny obywateli – właśnie na tym założeniu opiera się chiński system zaufania społecznego. W Europie tego typu rozwiązania są postrzegane ze sceptycyzmem, jednakże narastająca ilość danych osobowych i rosnąca siła technologii analitycznych mogą w przyszłości doprowadzić do debaty nad możliwością adaptacji takich rozwiązań.

Chiński system zaufania społecznego – studium przypadku

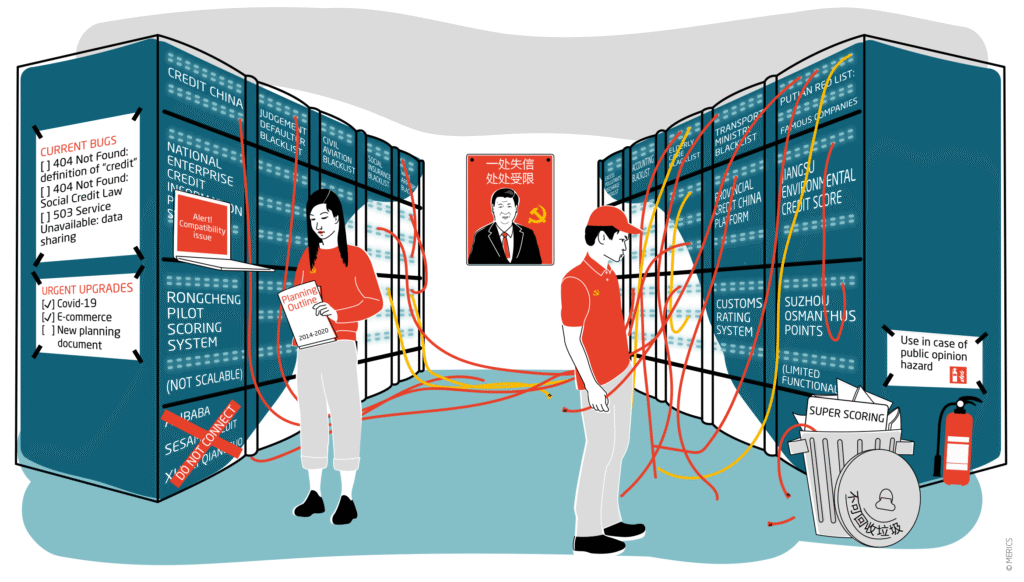

Chiński system zaufania społecznego (Social Credit System – SCS) jest modelem oceny obywateli na podstawie ich aktywności zarówno w świecie realnym, jak i cyfrowym. Celem systemu jest promowanie pożądanych społecznie zachowań oraz penalizacja tych niepożądanych, co ma bezpośredni wpływ na jakość życia obywateli. Punktacja w systemie wpływa m.in. na możliwość uzyskania kredytu, dostęp do transportu publicznego, a nawet szanse na znalezienie zatrudnienia. SCS korzysta z technologii sztucznej inteligencji, w tym rozpoznawania twarzy, analizy tekstu i danych transakcyjnych, umożliwiając rządowi szczegółowy monitoring i kontrolę społeczeństwa.

Ciekawostka: Choć wiele osób w to wierzy, chiński rząd nigdy nie wprowadził ogólnokrajowej punktacji społecznej przypisanej każdemu obywatelowi.

Chociaż system ten zyskał poparcie części społeczeństwa ze względu na efektywność w egzekwowaniu porządku społecznego i gospodarczego, krytycy wskazują na poważne problemy etyczne oraz zagrożenia dla podstawowych praw człowieka. Naraża on obywateli na permanentną inwigilację i potencjalną arbitralność ocen, co budzi liczne obawy międzynarodowe i rodzi pytania o granice ingerencji państwa w życie jednostek.

|

Pozytywne działania (poprawiające ocenę) |

Negatywne działania (obniżające ocenę) |

|---|---|

|

Opieka nad starszymi członkami rodziny |

Brak odwiedzin u starzejących się rodziców |

|

Oddawanie krwi |

Zaległości finansowe (niespłacanie pożyczek, unikanie długów) |

|

Udział w działalności charytatywnej |

Wykroczenia drogowe (jazda po alkoholu, przechodzenie na czerwonym) |

|

Chwalenie rządu w mediach społecznościowych |

Publikowanie antyrządowych treści |

|

Dokonywanie bohaterskich czynów |

Uczestnictwo w działaniach uznanych za sekciarskie |

|

Pomaganie ubogim |

„Nielegalne” protestowanie przeciw władzom |

|

Pozytywny wpływ na sąsiedztwo |

Oszukiwanie w grach online |

|

Segregacja i recykling odpadów |

Rezerwowanie, ale niewykorzystywanie rezerwacji (restauracje/hotele) |

Rola AI i Data Science w analizie zachowań

Technologie sztucznej inteligencji (AI) oraz metody Data Science odgrywają kluczową rolę w analizowaniu ogromnych ilości danych generowanych przez użytkowników. Dzięki zaawansowanym algorytmom uczenia maszynowego możliwe jest automatyczne rozpoznawanie wzorców zachowań oraz przewidywanie przyszłych działań jednostek lub grup społecznych. Techniki analizy predykcyjnej pozwalają z wysoką dokładnością przewidzieć preferencje zakupowe, polityczne czy społeczne użytkowników, natomiast technologie przetwarzania języka naturalnego (NLP) umożliwiają analizę emocji oraz intencji wyrażanych w sieci.

Dynamiczny rozwój technologiczny sprawia, że algorytmy te stają się coraz bardziej zaawansowane, wydajne i precyzyjne. W praktyce oznacza to, że analiza danych przebiega znacznie szybciej i jest w stanie przetwarzać większe ilości informacji niż kiedykolwiek wcześniej. Dzięki temu możliwe jest niemal natychmiastowe reagowanie na zachowania użytkowników oraz adaptacja usług i produktów do ich bieżących potrzeb. Jednocześnie jednak tempo rozwoju technologii potęguje ryzyko nadużyć oraz zwiększa wyzwania związane z zarządzaniem prywatnością i ochroną danych osobowych.

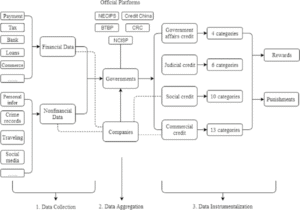

Organizational and Process Chart of China’s Social Credit System (SCS)

Społeczne i etyczne wyzwania wykorzystania AI

Wraz z postępem technologicznym coraz częściej pojawiają się głosy, by wykorzystywać algorytmy do oceny obywateli – zarówno pod kątem ich wiarygodności, zachowań społecznych, jak i potencjalnych zagrożeń, jakie mogą stanowić dla porządku publicznego. Choć idea ta może wydawać się kusząca z punktu widzenia efektywności zarządzania państwem, niesie ze sobą poważne zagrożenia etyczne i społeczne.

Systemy oceniania obywateli oparte na sztucznej inteligencji i algorytmach profilujących mogą prowadzić do głębokiej erozji prywatności. Zbierane i analizowane są ogromne ilości danych – od historii zakupów, przez aktywność w mediach społecznościowych, po nawyki komunikacyjne. Często bez pełnej świadomości użytkowników. W rezultacie powstaje profil, który nie tylko nie zawsze odzwierciedla rzeczywistość, ale może również prowadzić do niesprawiedliwych decyzji – takich jak ograniczenia dostępu do usług publicznych, miejsc pracy czy kredytów.

Co więcej, algorytmy nie są wolne od uprzedzeń. Są one trenowane na danych, które mogą odzwierciedlać istniejące nierówności społeczne i stereotypy. Zamiast być narzędziem obiektywnym, mogą więc pogłębiać dyskryminację – np. wobec osób z mniejszości etnicznych, ekonomicznie wykluczonych czy posiadających „niewłaściwe” poglądy.

Społeczeństwo pod nadzorem cyfrowym zaczyna przypominać mniej demokratyczną wersję rzeczywistości, w której zachowania obywateli są stale monitorowane i oceniane. Rodzi się pytanie: gdzie kończy się troska o dobro wspólne, a zaczyna kontrola rodem z dystopii?

|

Dobra ocena – korzyści (nagrody) |

Zła ocena – sankcje (kary) |

|---|---|

|

Priorytet przy przyznawaniu dotacji rządowych |

Publiczne udostępnienie danych jako “niewiarygodny podmiot” |

|

Szybsze procedowanie spraw urzędowych |

Zakaz udziału w przetargach publicznych |

|

Większy dostęp do finansowania i kredytów |

Zakaz zakupu luksusowych towarów (np. bilety lotnicze, drogie auta) |

|

Możliwość udziału w przetargach publicznych |

Ograniczenia w podróżach (np. zakaz lotów, szybkich pociągów) |

|

Lepsze oferty na rynku pracy i ułatwienia w podróżach |

Zakaz posyłania dzieci do drogich szkół prywatnych |

|

Trudności w uzyskaniu kredytu i pogorszenie zdolności finansowej |

|

|

Ograniczenia w zatrudnieniu w sektorze publicznym i państwowych przedsiębiorstwach |

Możliwości adaptacji w Europie

Jakkolwiek może to wydawać się odległe od europejskich realiów, warto zadać pytanie: czy wdrożenie takiego systemu – w jakiejkolwiek formie – byłoby w Europie w ogóle możliwe?

Z czysto technicznego punktu widzenia Europa posiada wszystkie środki, by zbudować system oceny społecznej oparty na analizie danych cyfrowych. Rozwój infrastruktury cyfrowej, dostęp do dużych zbiorów danych, sztuczna inteligencja, identyfikatory elektroniczne – wszystkie te elementy istnieją i mogą zostać użyte do stworzenia mechanizmów oceny lub klasyfikacji zachowań obywateli. Jednak to nie technologia stanowi największą przeszkodę, lecz kontekst kulturowy i prawny.

Unia Europejska opiera się na wartościach liberalnej demokracji, w której szczególną wagę przywiązuje się do ochrony praw jednostki, prywatności i godności osobistej. Wprowadzenie centralnego systemu oceny społecznej, nawet w wersji ograniczonej, wymagałoby głębokiego przekształcenia zasad, które przez dekady były filarem europejskiego porządku prawnego. Co więcej, każde próby wdrażania mechanizmów oceniających obywateli wiązałyby się z intensywną debatą społeczną i oporem ze strony organizacji broniących praw człowieka oraz obywatelskich.

Mimo to nie można wykluczyć, że idea pewnej „cyfrowej ewaluacji” zyska kiedyś polityczne zainteresowanie – zwłaszcza w kontekście poprawy bezpieczeństwa, efektywności usług publicznych czy walki z nadużyciami. W teorii, przy zachowaniu zgodności z przepisami o ochronie danych osobowych oraz zapewnieniu pełnej transparentności działania takiego systemu, pojawiłaby się przestrzeń do jego wdrożenia w formie ściśle kontrolowanej. Mógłby to być model rozproszony, podzielony między różne instytucje, z silnymi gwarancjami dostępu obywatela do informacji i możliwością odwołania się od decyzji.

Jednak nawet w takim scenariuszu kluczowym warunkiem byłaby dobrowolność udziału w systemie oraz brak konsekwencji prawnych czy społecznych wynikających z „niskiej oceny”. W przeciwnym razie – przy ograniczeniu swobody jednostki, automatyzacji decyzji czy braku przejrzystości – system bardzo szybko mógłby zostać uznany za sprzeczny z Kartą Praw Podstawowych UE.

Trzeba też pamiętać, że ewentualna adaptacja tego typu mechanizmu wymagałaby nie tylko zmian legislacyjnych, ale również głębokiej zmiany świadomości społecznej. Obywatele musieliby zaakceptować, że ich codzienne działania mogą być stale analizowane i interpretowane przez państwo lub inne instytucje. Dziś taka akceptacja jest w Europie raczej niska – co jednak nie znaczy, że nie może się to zmienić, np. pod wpływem kryzysów, zagrożeń bezpieczeństwa lub rozwoju idei „państwa inteligentnego”.

W obecnych realiach wdrożenie systemu podobnego do chińskiego SCS w Europie wydaje się mało prawdopodobne – nie ze względu na brak środków, lecz ze względu na zderzenie tej idei z europejską tożsamością polityczną i społeczną. Jednak obserwując zmieniające się nastroje społeczne, coraz większą zależność od technologii i narastające problemy z dezinformacją, przestępczością internetową czy kryzysami zaufania, warto uważnie śledzić, czy i w jaki sposób europejskie państwa będą sięgały po nowe formy cyfrowego zarządzania obywatelami – być może bardziej subtelne, lecz równie skuteczne.

Studium przypadku z Europy – przykłady istniejących systemów oceny

Studium przypadku z Europy – przykłady istniejących systemów oceny

Choć pełnoskalowe systemy oceniania obywateli, takie jak te znane z Chin, nie funkcjonują w Europie, to jednak już dziś w wielu krajach wykorzystuje się dane cyfrowe do częściowej oceny jednostek. Dzieje się to często w sektorze prywatnym, choć nie bez konsekwencji społecznych.

W większości krajów europejskich działają biura informacji kredytowej, takie jak niemiecki SCHUFA, brytyjski Experian czy polski BIK. Tworzą one profile konsumentów na podstawie danych o historii spłaty zobowiązań, aktywności finansowej czy częstotliwości zapytań kredytowych. Na tej podstawie obliczany jest tzw. scoring kredytowy – liczbowy wskaźnik, który decyduje o tym, czy ktoś otrzyma kredyt, wynajmie mieszkanie czy podpisze umowę abonamentową. Choć systemy te są akceptowane jako element gospodarki, często krytykowane są za brak przejrzystości i trudność w korygowaniu błędów.

Coraz więcej firm ubezpieczeniowych w Europie oferuje tzw. „ubezpieczenia telematyczne” – np. brytyjski Aviva Drive, włoski Generali czy polski LINK4 z programem „Bezpieczna jazda”. W zamian za niższą składkę klienci instalują aplikację lub urządzenie, które śledzi sposób prowadzenia samochodu – analizując m.in. prędkość, gwałtowne hamowania, zakręty czy korzystanie z telefonu. Dane te wpływają na ocenę kierowcy, a w dłuższej perspektywie – na wysokość ubezpieczenia.

Niektóre firmy specjalizujące się w analizie ryzyka inwestycyjnego i personalnego, np. w Niemczech czy Wielkiej Brytanii, korzystają z danych publicznych i półpublicznych (np. z portali społecznościowych, rejestrów dłużników) do oceny potencjalnych najemców lub kandydatów do pracy. Choć odbywa się to często bez formalnego scoringu, mechanizmy te wpływają na decyzje biznesowe – i budzą kontrowersje, szczególnie w kontekście ochrony prywatności.

Psychologiczne skutki ciągłego monitorowania obywateli

W dobie wszechobecnych kamer, aplikacji śledzących lokalizację, inteligentnych urządzeń domowych i algorytmów analizujących nasze dane – życie pod stałym nadzorem staje się nie tylko technologiczną rzeczywistością, ale również źródłem głębokich zmian psychologicznych i społecznych.

Ciągłe poczucie bycia obserwowanym – nawet jeśli jest tylko potencjalne – może prowadzić do chronicznego stresu. Gdy każda aktywność online, każda interakcja w mediach społecznościowych może być rejestrowana, oceniana i analizowana, wiele osób doświadcza tzw. „technoniepokoju”. Obawa przed negatywną oceną algorytmu (np. przez pracodawcę, ubezpieczyciela czy instytucję państwową) rodzi napięcie porównywalne do życia w warunkach społecznego eksperymentu.

Wielu użytkowników internetu zaczyna świadomie modyfikować swoje wypowiedzi i działania w obawie przed konsekwencjami. Autocenzura w mediach społecznościowych – ograniczanie wyrażania poglądów politycznych, unikanie kontrowersyjnych tematów – to coraz powszechniejszy mechanizm obronny. W dłuższej perspektywie może to prowadzić do ograniczenia wolności słowa i osłabienia debaty publicznej.

Prywatność staje się towarem luksusowym. Gdy użytkownik zdaje sobie sprawę, że jego działania są stale śledzone – czy to przez platformy społecznościowe, wyszukiwarki czy aplikacje mobilne – pojawia się poczucie utraty kontroli nad własnym życiem. To z kolei wpływa na tożsamość jednostki – ludzie zaczynają tworzyć „wersje siebie”, które będą dobrze wyglądały w oczach algorytmów. Powstaje zjawisko cyfrowej maski – sztucznego obrazu jednostki, oddzielonego od jej prawdziwego „ja”.

Kultura cyfrowego nadzoru osłabia fundamenty zaufania społecznego. Gdy ludzie nie wiedzą, kto ich obserwuje, kto analizuje dane i w jakim celu, trudno o relacje oparte na autentyczności i otwartości. Społeczeństwo staje się bardziej podejrzliwe, zamknięte i ostrożne – nie tylko wobec instytucji, ale również wobec siebie nawzajem. Technologia może być narzędziem postępu, ale tylko wtedy, gdy nie prowadzi do dehumanizacji. Warto więc zadać sobie pytanie: czy komfort i bezpieczeństwo, jakie oferuje cyfrowy świat, warte są psychologicznych kosztów, jakie ze sobą niesie?

Opinie społeczne na temat systemów oceny obywateli – badanie ankietowe

W 2019 roku niemiecka firma ubezpieczeniowa ERGO przeprowadziła badanie opinii publicznej dotyczące zbierania danych przez państwo. Na pytanie: „Czy chciałbyś, aby taki system został wprowadzony w Niemczech?” tylko 20% uznało taki system za dobry pomysł, głównie z powodów porządkowych i bezpieczeństwa. 69% respondentów wyraziło sprzeciw wobec wprowadzenia systemu oceniania obywateli w Niemczech na wzór chińskiego. 11% nie miało zdania. Poparcie dla systemu było wyższe wśród młodszych osób (18–30 lat) – aż 23% wyrażało akceptację, co może sugerować większą akceptację nadzoru w zamian za wygodę i personalizację usług. Respondenci wyrażali silny niepokój o utrzymanie wolności osobistej i ochronę prywatności. Obawy skupiały się na ryzyku nadużyć, arbitralności ocen i braku przejrzystości mechanizmów oceny. Jednocześnie młodsze pokolenia wykazywały większą otwartość, choć z zastrzeżeniem konieczności kontroli nad danymi.

W 2024 roku przeprowadzono badanie wśród użytkowników Facebooka i Instagrama w Słowenii, analizując ich stosunek do tzw. „rejestrów zaufania”, które są analogiczne do systemów oceniania obywateli. Badanie wykazało, że akceptacja takich systemów była ściśle związana z postrzeganą użytecznością w kontekście bezpieczeństwa narodowego i walki z przestępczością. W Polsce i Czechach ponad 70% ankietowanych sprzeciwiało się wdrażaniu systemów podobnych do chińskich, nawet jeśli miałyby one poprawić bezpieczeństwo. W krajach takich jak Węgry zauważalny był większy odsetek osób niezdecydowanych, co może wynikać z niższego poziomu wiedzy na temat działania takich systemów. Wyniki wskazują na ogólną niechęć społeczeństw Europy Środkowej do wdrażania systemów podobnych do chińskiego, z obawami dotyczącymi prywatności i potencjalnych nadużyć ze strony państwa.

Podsumowując, badania wskazują na ogólną niechęć obywateli europejskich do wdrażania systemów oceniania obywateli podobnych do chińskiego. Główne obawy dotyczą prywatności, potencjalnych nadużyć oraz wpływu na wolności obywatelskie. Jednakże w niektórych grupach, zwłaszcza wśród młodszych respondentów, zauważalna jest większa akceptacja, szczególnie jeśli systemy te są postrzegane jako narzędzia zwiększające bezpieczeństwo.

Rozwiązania i propozycje łagodzące

Współczesne systemy analizy danych cyfrowych, wykorzystywane do oceny obywateli, niosą ze sobą poważne zagrożenia społeczne i etyczne, takie jak utrata prywatności, poczucie stałego nadzoru czy ryzyko niesprawiedliwego profilowania. Aby ograniczyć te negatywne skutki, niezbędne jest wdrażanie rozwiązań, które będą chronić podstawowe prawa jednostki, a zarazem pozwolą na rozwój nowoczesnych technologii w zgodzie z demokratycznymi wartościami.

Jednym z fundamentów ochrony obywateli w Unii Europejskiej jest RODO – ogólne rozporządzenie o ochronie danych osobowych. Jego przepisy wyraźnie zakazują podejmowania decyzji wyłącznie na podstawie zautomatyzowanego przetwarzania, w tym profilowania, jeśli wywołuje ono skutki prawne lub w podobny sposób istotnie wpływa na jednostkę. Obywatele mają również prawo do sprzeciwu wobec takiego profilowania, prawo do przejrzystości w zakresie przetwarzania danych, a także do ich usunięcia lub przeniesienia. Przestrzeganie tych zasad jest kluczowe dla zachowania równowagi między efektywnością systemów cyfrowych a ochroną praw obywatelskich.

Istotnym narzędziem wspierającym tę równowagę jest koncepcja „Privacy by Design”, czyli ochrona prywatności już na etapie projektowania systemów informatycznych. Zakłada ona, że systemy zbierające i przetwarzające dane powinny być konstruowane tak, by domyślnie chronić dane użytkownika – minimalizując ich ilość, ograniczając czas przechowywania i stosując techniki anonimizacji. Dzięki temu prywatność obywateli nie jest dodatkiem, lecz integralnym elementem działania technologii.

Równie ważnym krokiem w przeciwdziałaniu nadużyciom jest wprowadzenie niezależnego nadzoru nad działaniem systemów algorytmicznych. Organy nadzorujące powinny mieć możliwość audytowania algorytmów, sprawdzania ich wpływu na wolności obywatelskie i rozpatrywania skarg obywateli. Taki nadzór nie tylko zwiększa przejrzystość, ale także buduje zaufanie do instytucji, które korzystają z narzędzi cyfrowych do podejmowania decyzji.

Ostatecznie, żadna techniczna czy prawna ochrona nie będzie skuteczna bez odpowiedniej świadomości społecznej. Edukacja cyfrowa powinna stać się elementem polityki publicznej – obywatele muszą rozumieć, jakie dane są o nich zbierane, jakie mają prawa i jak mogą chronić swoją prywatność. Tylko wtedy będą w stanie świadomie korzystać z usług cyfrowych i bronić się przed ich ewentualnym nadużyciem.

Wprowadzenie skutecznych zabezpieczeń prawnych, projektowych i edukacyjnych to dziś nie tylko kwestia techniczna, lecz przede wszystkim moralna. To od naszych decyzji zależy, czy technologia będzie służyć człowiekowi, czy stanie się narzędziem kontroli i wykluczenia.

Konkluzja

Rozwój technologii cyfrowych, sztucznej inteligencji oraz metod analizy danych otworzył przed ludzkością zupełnie nowe możliwości, ale także niespotykane dotąd wyzwania. Ślady cyfrowe, które nieustannie generujemy w codziennej aktywności online, stały się cennym zasobem – zarówno dla podmiotów komercyjnych, jak i instytucji państwowych. Na przykładzie chińskiego systemu zaufania społecznego widzimy, jak zaawansowane technologie mogą zostać użyte do ścisłego nadzorowania i oceniania obywateli. Choć takie podejście może zwiększać efektywność w zarządzaniu społeczeństwem, niesie też poważne ryzyko nadużyć, ograniczania wolności oraz utraty zaufania obywateli do instytucji publicznych.

Europa, oparta na wartościach demokracji, ochrony prywatności i praw człowieka, wykazuje zdecydowaną niechęć wobec wdrażania systemów podobnych do chińskich. Niemniej jednak rosnąca rola danych w podejmowaniu decyzji oraz presja ze strony rozwoju technologii mogą prowadzić do stopniowego wprowadzania elementów profilowania i oceny obywateli – zwłaszcza w sektorze prywatnym. W tym kontekście kluczowe staje się stworzenie wyważonego modelu, który z jednej strony wykorzystuje potencjał danych i AI, a z drugiej gwarantuje ochronę praw jednostki.

Przyszłość cyfrowego społeczeństwa będzie zależeć od decyzji podejmowanych dziś. Czy pójdziemy drogą automatyzacji nadzoru i kontroli, czy też wybierzemy ścieżkę odpowiedzialnego i etycznego wykorzystania technologii – pozostaje otwartym pytaniem. Jedno jest pewne: potrzebujemy głębokiej refleksji, przejrzystych regulacji oraz aktywnego dialogu społecznego, aby zagwarantować, że postęp technologiczny będzie służył ludziom, a nie ich ograniczał.

Literatura

- Constructing a Data‐Driven Society: China’s Social Credit System as a State Surveillance Infrastructure (research gate)

- 20% of Germans would like a social credit system (like China’s) implemented in Germany. The approval rate is higher among younger people (reddit)

- EU Voters’ Views on China Tracker (ceias)

- Demystifying the Chinese Social Credit System: A Case Study on AI-Powered Control Systems in China

- China just announced a new social credit law. Here’s what it means.

- Social Credit System (Wikipedia)

- CHINA ’S SOCIAL CREDIT SYSTEM

- China’s 'social credit’ system ranks citizens and punishes them with throttled internet speeds and flight bans if the Communist Party deems them untrustworthy