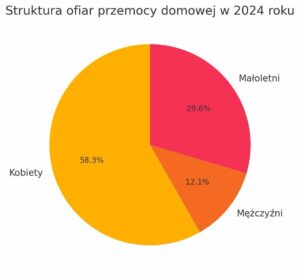

Przemoc domowa pozostaje poważnym problemem społecznym, często ukrytym za zamkniętymi drzwiami. Według danych polskiej policji, w 2023 roku ofiarami przemocy domowej w Polsce było ponad 77,8 tys. osób, a liczba zidentyfikowanych sprawców przekroczyła 63 tys. – przy czym aż 74% ofiar stanowiły kobiety. Statystyki te pokazują skalę zjawiska i pilną potrzebę skutecznego przeciwdziałania. Jednym z innowacyjnych kierunków jest wykorzystanie nowych technologii – w szczególności powszechnie dostępnych smartfonów, inteligentnych głośników i innych urządzeń mobilnych – do automatycznej identyfikacji sytuacji zagrożenia przemocą domową. Urządzenia te, wyposażone w mikrofony oraz różnorodne czujniki, mogą pełnić rolę „cichych świadków” zdarzeń, wychwytując dźwięki przemocy (np. krzyki, odgłosy uderzeń) i dane kontekstowe (np. gwałtowne przyspieszenia, nietypową lokalizację czy porę zdarzenia) mogące wskazywać na akt przemocy.

Technologiczne podstawy: rozpoznawanie dźwięku i dane kontekstowe

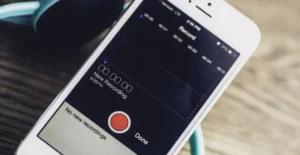

Sercem większości projektowanych systemów wykrywania przemocy domowej jest analiza dźwięku z otoczenia. W sytuacjach przemocy często pojawiają się charakterystyczne odgłosy – krzyki, podniesione głosy, wołanie o pomoc, odgłosy uderzeń – które mogą zostać rozpoznane przez algorytmy sztucznej inteligencji. Współczesne smartfony i inteligentne głośniki są wyposażone w czułe mikrofony, które mogą rejestrować dźwięki przez całą dobę. Rozpoznawanie dźwięku opiera się najczęściej na metodach uczenia maszynowego. Nowsze rozwiązania stosują głębokie sieci neuronowe, które uczą się rozpoznawać wzorce akustyczne przemocy. Badania wskazują, że metody deep learning przewyższają tradycyjne algorytmy w skuteczności identyfikacji przemocy na podstawie nagrań audio. W jednym z projektów zaproponowano model CNN, który rozpoznaje dźwięki fizycznej szamotaniny z wysoką czułością – może on wychwytywać sygnały takie jak krzyk ofiary czy gniewne krzyki sprawcy i odróżniać je od odgłosów normalnej rozmowy. W innym podejściu naukowcy wyspecjalizowali model AI do rozpoznawania obelg i wyzwisk w mowie; ustalono bowiem, że agresja słowna często poprzedza eskalację do przemocy fizycznej. Przykładem jest aplikacja UNDERCOVER opracowana w Hongkongu – wykrywa obraźliwe słowa (po angielsku i kantońsku), a gdy usłyszy przekleństwo lub groźbę o natężeniu powyżej 90 dB, dyskretnie zaczyna nagrywać incydent i analizuje, czy sytuacja eskaluje do stanu zagrożenia życia. W przypadku wykrycia poważnego niebezpieczeństwa, aplikacja może automatycznie wysłać alarmującą wiadomość SMS do zaufanej osoby wskazanej przez użytkownika.

Obok dźwięku, istotną rolę odgrywają dane kontekstowe z czujników urządzeń mobilnych. Smartfony są dziś naszpikowane sensorami: akcelerometr i żyroskop wykrywają ruch i wstrząsy, GPS wskazuje lokalizację, a coraz częściej także czujniki noszone (np. smartwatche) monitorują tętno czy inne parametry. Wszystkie te dane mogą dostarczać wskazówek na temat nietypowych zdarzeń. Przykładowo, gwałtowne szarpnięcia czy upadki mogą zostać zarejestrowane jako nagłe przyspieszenia telefonu – analogicznie do funkcji wykrywania upadku, znanej z zegarków dla seniorów. Jeśli ofiara nosi przy sobie telefon, silne uderzenie (np. przewrócenie na podłogę) może wygenerować sygnał akcelerometru. Takie dane same w sobie nie dowodzą przemocy, ale w połączeniu z dźwiękiem tworzą pełniejszy obraz. Podejście multimodalne, łączące analizę audio z analizą ruchu czy lokalizacji, pozwala zwiększyć wiarygodność detekcji i ograniczyć fałszywe alarmy. Przykładem może być prototyp czujnika montowanego na drzwiach: wykorzystano w nim mały moduł IoT z akcelerometrem i mikrofonem, który wykrywa trzaśnięcia drzwiami – akcelerometr najpierw rejestruje mocne szarpnięcie drzwi, co uruchamia rejestrację krótkiego klipu audio, a następnie sieć neuronowa ocenia, czy drzwi zostały trzaśnięte agresywnie czy normalnie. W testach to rozwiązanie osiągnęło skuteczność ~89% w cichym otoczeniu, wykrywając gwałtowne trzaskanie drzwi. To pokazuje, że czujniki kontekstowe mogą pełnić rolę „wyzwalaczy” (np. wykrycie uderzenia rozpoczyna nasłuchiwanie dźwięku) lub dodatkowych dowodów, potwierdzających zdarzenie akustyczne.

Zastosowania i potencjał w zapobieganiu przemocy domowej

Technologie wykrywające przemoc domową mają na celu wczesną identyfikację zagrożenia, aby umożliwić szybką interwencję bądź powstrzymać eskalację. Rozważmy potencjalny scenariusz: smartfon leżący w mieszkaniu lub inteligentny głośnik (np. Amazon Echo, Google Home) nasłuchuje odgłosów w tle. Jeśli system AI rozpozna dźwięk przypominający krzyk: „Ratunku, przestań!” albo odgłos uderzenia i tłuczonego szkła, może automatycznie podjąć działanie. Możliwości są różne, np.: wyemitowanie głośnego sygnału alarmowego, który może spłoszyć sprawcę lub zaalarmować sąsiadów; wysłanie powiadomienia do zaufanej osoby (np. członka rodziny, przyjaciela) z prośbą o kontakt lub wezwanie policji; a w najbardziej krytycznych przypadkach – bezpośrednie zawiadomienie służb ratunkowych wraz z podaniem lokalizacji. Pewnym rozwiązaniem jest także dyskretne nagranie dowodu zajścia przemocy, który mógłby posłużyć ofierze w dochodzeniu prawnym. Wspomniana aplikacja UNDERCOVER właśnie tak działa: zabezpiecza nagranie incydentu w zaszyfrowanej formie, aby mogło posłużyć jako legalny dowód w sądzie, jednocześnie chroniąc je przed dostępem osoby postronnej (dostęp do aplikacji zabezpieczony jest biometrycznie – odciskiem palca lub twarzą właścicielki, co ma zapobiec skasowaniu dowodów przez sprawcę).

Ogromną zaletą korzystania ze smartfonów i urządzeń mobilnych jest ich powszechność i dyskrecja. Telefon komórkowy jest zwykle pod ręką ofiary – może zatem działać jako osobisty strażnik. Już dziś istnieje wiele aplikacji bezpieczeństwa dla osób zagrożonych przemocą, oferujących np. szybkie ukryte wybieranie numeru alarmowego, powiadamianie wcześniej wybranych kontaktów za pomocą jednego przycisku czy fałszywe „wyciszone” alarmy (udające np. aplikację pogodową, aby nie wzbudzać podejrzeń sprawcy). Jednak jak wykazał przegląd blisko 136 aplikacji związanych z przemocą domową, większość dostępnych rozwiązań wymaga ręcznego działania ze strony ofiary – to znaczy, to poszkodowany/poszkodowana musi nacisnąć przycisk alarmowy lub samodzielnie wysłać sygnał. Obecnie brak jest automatycznego wykrywania przemocy w komercyjnych aplikacjach – żadna z przeanalizowanych aplikacji nie wykorzystywała sztucznej inteligencji do aktywnego monitorowania sytuacji. To istotna luka, ponieważ w realnym zagrożeniu ofiara często nie ma możliwości sięgnąć po telefon lub zrobić tego niezauważenie. Technologia automatycznej detekcji dźwięków przemocy ma więc potencjał, by wypełnić tę lukę, działając bez udziału użytkownika w krytycznych momentach.

Badania naukowe i prototypy techniczne pokazują, że taki automatyczny system jest wykonalny. Przykładem jest projekt zrealizowany na Uniwersytecie Monash w Australii, gdzie wykorzystano sieć tysięcy inteligentnych głośników zainstalowanych w domach do wykrywania przemocy – według autorów, powszechna obecność smart-głośników stwarza szansę włączenia ich w system przeciwdziałania przemocy domowej. Firmy technologiczne już teraz sygnalizują prace nad takimi funkcjami: np. Google i Amazon patentują metody rozpoznawania „podwyższonych emocji” użytkowników po głosie, a badacze z USA stworzyli wstępne systemy AI do detekcji krzyków, syren alarmowych, wystrzałów czy trzasku tłuczonego szkła za pomocą domowych czujników dźwięku.

Innym obiecującym zastosowaniem jest wykorzystanie systemów detekcji przemocy do stałego monitoringu w miejscach szczególnego ryzyka – np. w mieszkaniach chronionych, schroniskach dla ofiar przemocy czy w mieszkaniach objętych nadzorem kuratorskim. Dyskretne czujniki mogłyby ostrzegać pracowników socjalnych, że w danym domu ponownie dzieje się coś niepokojącego (np. częste awantury). W Wielkiej Brytanii rozważano zastosowanie tanich czujników IoT w mieszkaniach komunalnych, by wyłapywać wczesne oznaki agresywnych zachowań (takich jak właśnie trzaskanie drzwiami czy częste krzyki) i w ten sposób zapobiegać eskalacji przemocy zanim dojdzie do poważnego przestępstwa. Wizja ta jest zgodna z filozofią „prewencji zamiast reagowania” – lepiej zainterweniować wcześnie, niż czekać na tragiczne skutki.

Ograniczenia techniczne i społeczne

Technologia wykorzystująca dane kontekstowe i dźwięk z urządzeń mobilnych do wykrywania przemocy domowej stwarza nowe możliwości, ale jednocześnie napotyka na istotne ograniczenia techniczne i społeczne.

Wyzwania technologiczne systemów detekcji przemocy

Już na etapie projektowania ujawniają się liczne wyzwania związane z niezawodnością i dokładnością takich systemów. Algorytmy uczące się rozpoznawania sygnałów przemocy (np. krzyków, odgłosów uderzeń czy wołania o pomoc) wymagają olbrzymich zbiorów danych do treningu, które trudno pozyskać ze względu na wrażliwość i prywatność sytuacji przemocy (Bensakhria 2023). Dostępne publicznie dane audio przemocy są bardzo ograniczone, co utrudnia stworzenie modeli o wysokiej skuteczności. Ponadto nawet zaawansowane systemy rozpoznawania dźwięku mogą generować fałszywe alarmy, np. głośna kłótnia sąsiadów lub odgłosy z telewizora mogą zostać błędnie zinterpretowane jako akt przemocy. Trzeba wyważyć czułość systemu tak, aby nie przeoczyć realnego zagrożenia, a zarazem nie wywoływać niepotrzebnych interwencji.

Ograniczenia urządzeń i infrastruktury technicznej

Zastosowanie smartfonów i czujników IoT rodzi także problemy natury technicznej, takie jak ograniczona żywotność baterii przy ciągłym nasłuchiwaniu czy zmienne warunki akustyczne (szumy tła, hałas uliczny) wpływające na jakość nagrania. Urządzenie może nie być obecne w miejscu incydentu, ofiara może je odłożyć lub sprawca je zniszczy, co czyni system zawodnym w kluczowych momentach. Dodatkowo, analiza dźwięku w czasie rzeczywistym wymaga mocy obliczeniowej, a decyzja, czy przetwarzanie odbywa się lokalnie na urządzeniu czy w chmurze, pociąga za sobą kompromisy. Przetwarzanie lokalne chroni prywatność, ale bywa mniej efektywne na słabszych telefonach, natomiast przetwarzanie w chmurze pozwala na użycie potężnych algorytmów, lecz wymaga stałego dostępu do Internetu i budzi wątpliwości co do bezpieczeństwa danych.

Ryzyka związane z bezpieczeństwem i bariery społeczne

Wyzwania pojawiają się także na poziomie społecznego odbioru technologii. Osoby doświadczające przemocy mogą obawiać się zaufać aplikacji lub urządzeniu nasłuchującemu otoczenie. Istnieje ryzyko, że sprawca przemocy odkryje obecność takiego systemu, np. znajdzie aplikację w telefonie, co może eskalować konflikt zamiast mu zapobiec. Dlatego projektanci starają się, aby rozwiązania były maksymalnie dyskretne. Wspomniana wcześniej aplikacja UNDERCOVER działa w ukryciu. Jej interfejs jest minimalistyczny, a dostęp zabezpieczony biometrycznie (odciskiem palca lub twarzą), tak by utrudnić osobie agresywnej wykrycie i zablokowanie działania programu (Verticurl 2023). Tego typu zabiegi zwiększają bezpieczeństwo ofiary, ale wciąż nie rozwiązują wszystkich barier społecznych. W wielu przypadkach ofiary przemocy doświadczają izolacji cyfrowej – sprawcy kontrolują ich telefony, blokują dostęp do Internetu lub śledzą ich aktywność, co w wielu przypadkach niweczy zaawansowane zabezpieczenia, tworząc nierównowagę między możliwościami ochrony a zagrożeniem ze strony agresora (Novitzky et al. 2023).

Sam rozwój dostępnych aplikacji to nie wszystko. Potrzebna jest infrastruktura wsparcia, jak szybkie reagowanie policji czy służb społecznych na alert z systemu. Jeśli nawet technologia zadziała i powiadomi odpowiednie osoby, musi zaistnieć gotowość do interwencji, inaczej cała inicjatywa traci sens.

Dylematy etyczne i kwestie prywatności

Wykorzystanie danych z naszych prywatnych urządzeń do monitorowania przemocy rodzi szereg fundamentalnych dylematów etycznych. Z jednej strony stoi imperatyw ratowania zdrowia i życia ofiar, a szybka detekcja aktów przemocy może pozwolić na interwencję zanim dojdzie do poważnych szkód. Z drugiej strony, mamy prawo do prywatności i autonomii w zaciszu domowym. System nasłuchujący otoczenie przez smartfon niemal nieuchronnie rejestruje fragmenty życia rodzinnego, rozmów i dźwięków, które nie są związane z przemocą. Pojawia się pytanie: czy cel uświęca środki? Czy w imię bezpieczeństwa możemy poświęcić prywatność naszej domowej przestrzeni? Ten klasyczny konflikt między bezpieczeństwem a prywatnością wymaga wyważenia i jasno określonych reguł.

Etyczne napięcia między prywatnością a ochroną życia

Zgoda i świadome uczestnictwo to kolejna kwestia. Idealnie, każda osoba objęta monitoringiem powinna wyrazić na niego zgodę, jednak w realiach przemocy domowej trudno oczekiwać, by sprawca przyznał się do nadużyć i dobrowolnie zgodził na monitorowanie. Systemy detekcji przemocy często działają więc bez wiedzy agresora. Etycznie rodzi to wątpliwości: naruszamy prywatność jednej osoby (sprawcy) bez jej zgody, aby chronić inną osobę (ofiarę). Czy takie działanie jest usprawiedliwione? Większość kodeksów etycznych i prawnych dopuszcza ograniczenie prywatności, gdy w grę wchodzi zapobieganie poważnemu przestępstwu lub krzywdzie, jednak granica jest dosyć płynna. Co więcej, nagrania audio z incydentów przemocy mogą stać się dowodem w sprawie, co rodzi pytanie, jak je legalnie pozyskać i przechowywać, by były dopuszczalne w sądzie, nie naruszając przy tym prawa (np. zakaz nagrywania rozmów bez zgody rozmówcy, obowiązujący w niektórych jurysdykcjach).

Prywatność danych i odpowiedzialność za ich bezpieczeństwo

Kwestie prywatności danych i bezpieczeństwa informacji są niezmiernie ważne przy projektowaniu takich systemów. Dane zbierane przez aplikację (nagrania, lokalizacja, czas zdarzenia) są wyjątkowo wrażliwe. W niepowołanych rękach mogłyby posłużyć do dalszego skrzywdzenia ofiary lub narazić ją na wstyd, jeśli prywatne nagrania wyciekną do Internetu.

Dlatego twórcy muszą stosować zasady privacy by design – wbudować ochronę prywatności od podstaw. Przykładowo, aplikacja VictimsVoice gromadzi materiały dowodowe (zdjęcia obrażeń, notatki z zajść) w zaszyfrowanej formie na bezpiecznych serwerach, tak aby nawet przejęcie telefonu przez sprawcę nie umożliwiło dostępu do tych danych (New Tactics). Podobnie UNDERCOVER zabezpiecza zarejestrowane dowody biometrycznie, aby tylko ofiara mogła je odtworzyć. Niemniej, każde rozwiązanie polegające na chmurze obliczeniowej czy zewnętrznej bazie danych rodzi ryzyko, że dane mogą zostać zhakowane lub wykorzystane niezgodnie z pierwotnym celem. Pojawia się też problem anonimizacji – czy da się przekazywać służbom alarm o przemocy bez udostępniania pełnego nagrania? Być może przyszłe systemy będą analizować dźwięk lokalnie i wysyłać jedynie sygnał alarmowy, nie ujawniając szczegółów rozmów.

Stronniczość algorytmów i brak reprezentatywności danych

Bezstronność i unikanie biasów w algorytmach to kolejny dylemat etyczny. Sztuczna inteligencja jest tak dobra, jak dane, na których ją nauczono. Jeśli dostępne nagrania przemocy pochodziły głównie z określonych środowisk kulturowych, algorytm może lepiej rozpoznawać przemoc w tych kontekstach, a gorzej w innych. Może się okazać, że np. model świetnie wykrywa krzyk męskim głosem (bo taki dominował w danych), a słabiej radzi sobie z agresją słowną kobiety jako sprawczyni. To rodzi ryzyko dyskryminacji lub błędnej klasyfikacji – ofiary pewnych grup mogą być mniej chronione przez system, jeśli ten nie „nauczył się” ich sytuacji. Etyczne wdrożenie wymaga więc dbałości o reprezentatywność danych treningowych i ciągłe monitorowanie działania algorytmu pod kątem stronniczości.

Psychologiczne skutki bycia monitorowanym

Nie można też zapomnieć o aspektach psychologicznych i społecznych: stałe poczucie bycia podsłuchiwanym we własnym domu może wywoływać dyskomfort, nawet u osoby, którą chcemy chronić. Ofiara może czuć, że traci resztki prywatności i kontroli nad swoim życiem, co może paradoksalnie pogłębiać jej stres. Dlatego ważne jest, by system był wdrażany w porozumieniu z osobą pokrzywdzoną, jako element szerszego planu pomocy (np. wraz z terapią, planem bezpieczeństwa, kontaktami do służb). Technologia nie może zastąpić ludzkiego wsparcia, lecz powinna je uzupełniać. Co więcej, jeśli AI popełni błąd, np. nie wykryje realnej przemocy albo, przeciwnie, fałszywie oskarży kogoś o przemoc, pojawia się kwestia odpowiedzialności. Kto odpowiada za konsekwencje automatycznej decyzji? Projektanci systemu, dostawca aplikacji, a może służby, które zareagowały na błędny alarm? Te pytania pokazują, że wdrożenie AI w tak delikatnym obszarze wymaga nie tylko dopracowania techniki, ale i stworzenia ram etyczno-prawnych zapewniających transparentność i rozliczalność działania systemu.

W literaturze podkreśla się, że sztuczna inteligencja w kontekście przemocy ze względu na płeć to „miecz obosieczny”, który może zarówno pomagać, jak i nieść nowe zagrożenia. Jak ujęli to Imran i Tariq (2025): „z jednej strony [AI] może przynieść innowacyjne rozwiązania pomagające identyfikować i zapobiegać przemocy, z drugiej niesie ryzyko utrwalania szkodliwych uprzedzeń”. Świadomość tych pułapek jest kluczowa dla twórców technologii, ustawodawców oraz organizacji wspierających ofiary przemocy – tak, aby technologia była używana odpowiedzialnie. W przeciwnym razie dobre intencje mogą przerodzić się w kolejny system masowej inwigilacji lub narzędzie wykorzystywane przeciw tym, których miał chronić.

Propozycje rozwiązań

Choć temat wykrywania przemocy domowej przez urządzenia mobilne i czujniki jest coraz częściej poruszany w kontekście badań akademickich, brakuje dziś spójnych, praktycznych rozwiązań, które można by wdrożyć w realiach codziennego życia, zwłaszcza w sytuacjach, gdy ofiara przemocy nie ma możliwości samodzielnie wezwać pomocy. W odpowiedzi na tę lukę warto zaproponować zintegrowany system, którego działanie opierałoby się na analizie dźwięków otoczenia i danych kontekstowych z urządzeń, a następnie podejmowaniu adekwatnej reakcji, zależnie od poziomu zagrożenia. Taki system mógłby funkcjonować w formie aplikacji mobilnej powiązanej z prostymi modułami sprzętowymi, które w dyskretny sposób zbierałyby dane i analizowały je lokalnie, bez potrzeby przesyłania treści do zewnętrznych serwerów.

Kluczowym elementem systemu byłoby połączenie danych dźwiękowych i kontekstowych. Wykrycie potencjalnego zagrożenia nie prowadziłoby automatycznie do interwencji służb, lecz to użytkownik wcześniej określałby możliwe scenariusze reakcji: od cichego powiadomienia zaufanej osoby, przez uruchomienie alarmu, aż po automatyczne wezwanie pomocy.

Aplikacja mogłaby działać w trybie ukrytym, tak aby nie wzbudzała podejrzeń sprawcy. Jej ikonka przyjmowałaby formę zwykłej aplikacji pogodowej lub zdrowotnej, a dostęp do ustawień zabezpieczony byłby biometrycznie. Dodatkową funkcją byłaby możliwość „odwołania” zgłoszenia w ciągu kilkunastu minut, co redukuje lęk użytkownika przed przypadkowym uruchomieniem interwencji.

System mógłby zostać wdrożony pilotażowo w mieszkaniach objętych procedurą „Niebieskiej Karty”, jako forma stałego, ale nienachalnego monitorowania sytuacji rodzinnej. W takich przypadkach urządzenia analizujące dźwięk i ruch mogłyby być instalowane w porozumieniu z pracownikiem socjalnym, a dostęp do danych miałby wyłącznie zespół interwencyjny. Pozwalałoby to na wczesne wykrycie wznowienia przemocy, zanim dojdzie do poważniejszych incydentów. Analogiczne zastosowanie można by rozważyć w schroniskach dla ofiar przemocy czy w lokalach chronionych.

Aby tego typu system mógł rzeczywiście funkcjonować w praktyce, niezbędna jest nie tylko jego dostępność techniczna, ale również przygotowanie odpowiednich procedur obsługi, przeszkolenie personelu oraz zapewnienie zgodności z przepisami prawa. Kluczowe znaczenie miałoby opracowanie wytycznych określających, kiedy dane mogą być przetwarzane, jak długo przechowywane i kto może mieć do nich dostęp. Szczególnie istotne byłoby też zapewnienie użytkownikom pełnej kontroli nad systemem, w tym możliwości wglądu, edycji i usunięcia zgromadzonych informacji.

Na poziomie społecznym warto połączyć wdrażanie takich technologii z kampaniami edukacyjnymi, które zwiększałyby świadomość na temat ich działania i celu. Dobrze zaprojektowane rozwiązanie powinno być nie tylko bezpieczne i skuteczne, ale też zrozumiałe i dostępne, również dla osób z ograniczonym dostępem do technologii. Dlatego też rekomenduje się, aby aplikacja była dostępna bezpłatnie, w wersji offline, i nie wymagała stałego dostępu do internetu ani nowoczesnego sprzętu. Równocześnie warto byłoby przewidzieć możliwość finansowania urządzeń wspomagających ze środków publicznych lub przez organizacje pozarządowe wspierające ofiary przemocy.

Tak zintegrowane podejście, które łączy analizę technologii, organizację pomocy oraz działania edukacyjne, ma szansę stać się realnym wsparciem dla osób narażonych na przemoc. Zamiast skupiać się wyłącznie na interwencji po fakcie, warto stworzyć system, który będzie uczył się rozpoznawać niebezpieczne sytuacje wcześniej i dawał ofiarom poczucie sprawczości oraz bezpieczeństwa w momentach, gdy kontakt ze światem zewnętrznym może być ograniczony lub wręcz niemożliwy.

Podsumowanie

Podsumowując, wykorzystanie dźwięków i danych kontekstowych z urządzeń mobilnych w prewencji przemocy domowej to obiecujący, lecz złożony obszar. Wdrażając te rozwiązania, musimy kierować się zasadą „primum non nocere” – po pierwsze nie szkodzić. Technologia ma służyć wsparciu i ochronie najsłabszych, a nie stawać się kolejnym źródłem ryzyka. Osiągnięcie tego celu jest możliwe tylko poprzez krytyczną analizę etycznych i społecznych konsekwencji już na etapie projektowania systemów, a także ciągłe doskonalenie ich w dialogu z ekspertami i społecznością. Tylko wtedy innowacje AI realnie przełożą się na bezpieczniejszą przyszłość, w której ofiary przemocy będą szybciej otaczane opieką, a ich oprawcy – pociągani do odpowiedzialności.

Bibliografia

- Bensakhria, A. (2023). Detecting Domestic Violence Incidents Using Audio Monitoring and Deep Learning Techniques. https://doi.org/10.13140/RG.2.2.36128.97280/1

- Imran, N., & Tariq, K. (2025). Artificial Intelligence and Gender-Based Violence: A Double-Edged Sword in the Fight for Justice and Equality. Annals of King Edward Medical University, 31(1). https://doi.org/10.21649/akemu.v31i1.6079

- Muraleedharan, A., & Garcia-Constantino, M. (2022). Domestic Violence Detection Using Smart Microphones. W J. Bravo i in. (red.), Ubiquitous Computing and Ambient Intelligence – UCAmI 2022, Lecture Notes in Networks and Systems (t. 594, s. 357-368). Springer. https://doi.org/10.1007/978-3-031-21333-5_36

- New Tactics. (n.d.). Using Mobile Phone Technology to End Domestic Violence. https://www.newtactics.org/tactics/using-mobile-phone-technology-end-domestic-violence/

- Novitzky, P., Janssen, J., & Kokkeler, B. (2023). A systematic review of ethical challenges and opportunities of addressing domestic violence with AI-technologies and online tools. Heliyon, 9(6), e17140. https://doi.org/10.1016/j.heliyon.2023.e17140

- Rodríguez, D. A., Díaz-Ramírez, A., Miranda-Vega, J. E., Trujillo, L., & Mejía-Álvarez, P. (2021). A systematic review of computer science solutions for addressing violence against women and children. IEEE Access, 9, 114622-114639. https://doi.org/10.1109/ACCESS.2021.3103459

- Sumra, M., Asghar, S., Khan, K. S., Fernández-Luna, J. M., Huete, J. F., & Bueno-Cavanillas, A. (2023). Smartphone Apps for Domestic Violence Prevention: A Systematic Review. International Journal of Environmental Research and Public Health, 20(7), 5246. https://doi.org/10.3390/ijerph20075246

- Verticurl. (2023). Eradicating Domestic Violence with Award-Winning UNDERCOVER App Powered by Artificial Intelligence (AI) https://www.verticurl.com/insights/eradicating-domestic-violence-with-undercover-app-powered-by-artificial-intelligence/