Wprowadzenie

Technologia rozpoznawania twarzy to system zdolny nie tylko do wykrywania charakterystycznych cech twarzy na obrazie lub wideo, ale także do dopasowania badanego obiektu do bazy danych wcześniej zgromadzonych zdjęć. Sprawia to, że jest ona szeroko wykorzystywana w monitoringu oraz śledzeniu przestępców, dając możliwość zwiększenia porządku i bezpieczeństwa społecznego.

Niestety, istnieje druga strona medalu. Narzędzie to może być używane do inwigilacji oraz nadmiernej kontroli tłumów, co stanowi zagrożenie dla ludzkiej prywatności. W miejscach objętych monitoringiem nie tylko jesteśmy nagrywani, ale także automatycznie rozpoznawani i dokumentowani. Z tego powodu rozpoznawanie twarzy pozostaje tematem debaty publicznej – czy wprowadzenie tej technologii przyniesie więcej korzyści niż zagrożeń?

Rozwój technologii

Wykrywanie i rozpoznawanie twarzy za pomocą algorytmów nie jest zadaniem łatwym. W przeciwieństwie do człowieka, maszyna nie rozumie, czym jest twarz, ani tym bardziej, do kogo należy. Opracowanie algorytmów wykorzystywanych obecnie zajęło wiele lat i wymagało przeprowadzenia licznych badań, które stopniowo przybliżały technologię do celu.

Pierwszym krokiem było półautomatyczne rozwiązanie opracowane przez matematyka i informatyka Woodrowa Bledsoe. System wymagał od użytkownika zaznaczenia oraz zmierzenia odległości między elementami twarzy, takimi jak nos, oczy i usta. Następnie dane te były wprowadzane do komputera, który porównywał odległości na zdjęciu podejrzanego ze zdjęciem referencyjnym, określając, czy istnieje dopasowanie.

W latach 70. technologia została rozszerzona o kolejne cechy, takie jak kolor włosów czy grubość ust, dzięki pracom Goldsteina, Harmona i Leska.

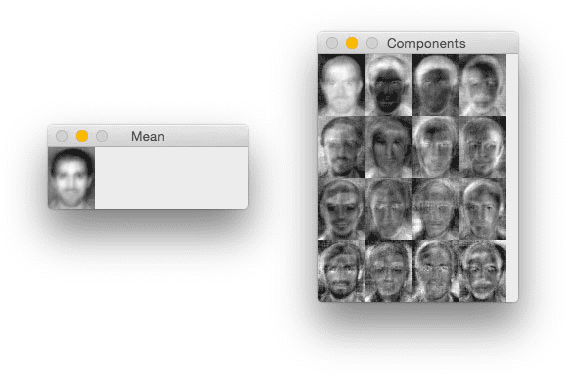

Następnym krokiem było zastosowanie przez Matthew’a Turka oraz Alexa Pentlanda metody zwanej eigenFace. Polegała ona na przekształceniu całego zbioru danych w macierze eigenFace. Każda z tych macierzy była wyspecjalizowana w wykrywaniu określonych cech – jedna analizowała zmiany w ustach, druga w kształcie twarzy itd. Porównywanie twarzy odbywało się poprzez przemnożenie obrazu referencyjnego i badanego przez zbiór twarzy eigenFace, a następnie analizę odległości między nimi.

Następnie pojawiły się rozwiązania skupiające się na szybkości detekcji, umożliwiające działanie systemu w czasie rzeczywistym. Paul Viola i Michael Jones zaproponowali rozwiązanie oparte na cechach Haara. Podczas procesu uczenia zmodyfikowany algorytm AdaBoost wyszukiwał odpowiednie cechy. W trakcie działania system korzystał z tych cech, zwracając wartość 1, jeśli wszystkie cechy pasowały do zdjęcia, oraz 0, jeśli choć jedna cecha nie pasowała.

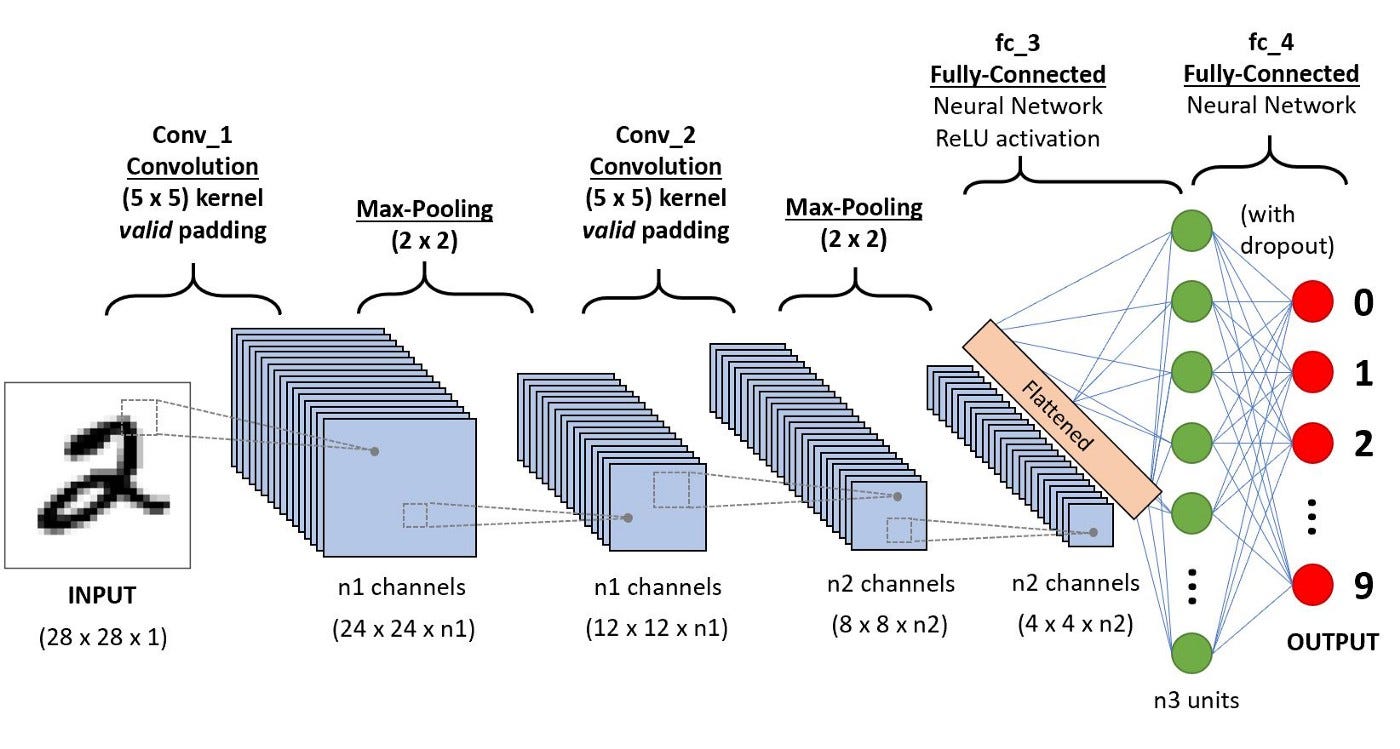

Kolejne lata przyniosły rozwiązania oparte na głębokich sieciach neuronowych, a dokładniej na architekturze CNN (Convolutional Neural Network). Sieć składała się z wielu warstw, z których każda zawierała filtry uczone na podstawie danych. Te filtry składały się z neuronów, które uczyły się wykrywania poszczególnych cech. Im wyższa była warstwa, tym bardziej abstrakcyjne cechy były przez nią rozpoznawane.

Przykładami rozwiązań opartych na tej architekturze są system DeepFace, opracowany przez Facebook w 2014 roku, oraz FaceNet, stworzony przez Google rok później. DeepFace osiągnął 97,53% skuteczności na zbiorze danych Labeled Faces in the Wild (LFW), podczas gdy ludzie osiągali około 95%. Rok później wynik ten został pobity przez FaceNet, który osiągnął 99,63% dokładności. Zastosowanie sieci neuronowych przyniosło niezwykły wzrost wydajności w dziedzinie rozpoznawania twarzy, co znacząco przyczyniło się do dalszego rozwoju technologii w tym kierunku.

Najnowsze systemy

Clearview AI (Stany Zjednoczone)

Jednym z najnowszych systemów używanych przez amerykańską policję jest rozwiązanie firmy Clearview AI. Jest to ogromna baza danych stworzona na podstawie zdjęć zamieszczonych w internecie. Obecnie szacuje się, że firma posiada około 50 miliardów fotografii. System został opracowany, aby wspierać organy ścigania w namierzaniu przestępców na podstawie zdjęć uchwyconych przez systemy monitoringu lub inne źródła nadzoru znajdujące się w okolicy. Zdjęcie wprowadza się do systemu, który następnie wyszukuje najbardziej pasujące twarze. Jest to więc wyszukiwarka zaprojektowana specjalnie do identyfikacji twarzy.

GES (Niemcy)

System GES został opracowany w 2008 roku dla niemieckiej policji w celu identyfikacji osób na zdjęciach. Opiera się na bazie danych zawierającej 7 milionów obrazów zgromadzonych przez policję. Rozpoznawanie twarzy odbywa się na podstawie zdjęć lub nagrań wideo wprowadzanych przez organy ścigania. W 2024 roku wprowadzono udoskonaloną wersję systemu GES, która zmniejszyła liczbę błędnych identyfikacji do mniej niż jednego procenta. Policja korzysta z tego rozwiązania zarówno w celu poszukiwania przestępców, jak i identyfikowania nielegalnych imigrantów. Nadal jednak wspiera się pracą 50 ekspertów od tradycyjnego porównywania twarzy, co wynika z europejskich regulacji dotyczących sztucznej inteligencji.

Środki Policji Wielkiej Brytanii

Wielka Brytania dysponuje zaawansowanymi technologiami dopasowywania twarzy. Jedną z nich jest rozpoznawanie na podstawie wcześniej wykonanych zdjęć. Siły specjalne mają możliwość porównania uzyskanego zdjęcia z bazą danych, aby określić tożsamość osoby na nim przedstawionej.

Jeśli chodzi o technologię monitorującą w czasie rzeczywistym, służby mundurowe posiadają specjalne furgonetki wyposażone w kamery z oprogramowaniem do identyfikacji twarzy na żywo. Umożliwia to monitorowanie i namierzanie celów w rejonach, gdzie istnieje podejrzenie popełnienia przestępstwa. Dodatkowo Policja Południowej Walii ma zainstalowaną na telefonach aplikację, która umożliwia dokładnie to samo. Policjant uruchamia kamerę, a twarz zostaje automatycznie wykryta.

Największym dotychczasowym przedsięwzięciem w zakresie identyfikacji twarzy są na stałe zainstalowane kamery w dzielnicach miasta Croydon. Oczekuje się, że rozwiązanie będzie identyfikować kilka tysięcy twarzy dziennie. Jest to pierwsza taka instalacja, a w przypadku sukcesu zostanie rozszerzona na inne miasta Wielkiej Brytanii.

Skynet (Chiny)

Jednym z najbardziej rozbudowanych systemów monitoringu na świecie jest chiński SkyNet. Początkowo był to jedynie zbiór kamer zainstalowanych na obrzeżach obszarów o najwyższej częstotliwości popełniania przestępstw. Jednak wraz z rozwojem uczenia maszynowego oraz wzrostem mocy obliczeniowej w chmurze, system rozrósł się do 570 milionów kamer w 2023 roku.

System nie tylko wykorzystuje modele wykrywania i porównywania twarzy z bazą danych na podstawie materiałów z monitoringu, ale również zawiera moduł detekcji podejrzanych zachowań. Dzięki potężnej infrastrukturze serwerowej jest w stanie przetwarzać dziennie petabajty danych z wszystkich kamer.

Rozwiązanie nie tylko wspiera organy bezpieczeństwa, ale także zostało zintegrowane z systemami IoT w miastach, co pozwala na optymalizację ruchu ulicznego oraz wykrywanie wypadków drogowych.

Chiński rząd chwali się, że wdrożenie systemu SkyNet nie tylko przyczyniło się do wykrywania przestępców oraz odnajdywania zaginionych osób, ale także pomogło w ograniczeniu pandemii COVID-19. System umożliwił detekcję interakcji między osobami zakażonymi a zdrowymi, co pozwoliło na skuteczniejsze monitorowanie rozprzestrzeniania się wirusa.

Zagrożenia wynikające z zastosowania technologii rozpoznawania twarzy

Błędna identyfikacja i niesłuszne ukaranie

Jednym z największych problemów technologii rozpoznawania twarzy jest jej niedoskonałość w zakresie dokładności, zwłaszcza w przypadku określonych grup demograficznych. Pomyłki tego typu mogą prowadzić do niesłusznych zatrzymań, oskarżeń, a nawet wyroków.

Przykłady:

USA: Organizacja ACLU (American Civil Liberties Union) przeprowadziła test w 2018 roku, w którym system rozpoznawania twarzy Amazon Rekognition błędnie dopasował 28 kongresmenów do zdjęć przestępców. Najczęściej mylone były osoby o ciemniejszym kolorze skóry.

W 2020 roku media nagłośniły przypadek Roberta Williamsa, czarnoskórego obywatela stanu Michigan, który został niesłusznie aresztowany po tym, jak system błędnie dopasował jego twarz do nagrania z monitoringu. Był to pierwszy znany przypadek aresztu na podstawie błędnej identyfikacji twarzy.

Polaryzacja rasowa i dyskryminacja

Algorytmy rozpoznawania twarzy uczą się na podstawie ogromnych zbiorów danych. Jeżeli zbiory te nie są wystarczająco różnorodne, systemy mogą faworyzować jedne grupy społeczne kosztem innych.

Historyczne przykłady dyskryminacji:

- Systemy często gorzej rozpoznają kobiety, osoby o ciemniejszym kolorze skóry oraz osoby starsze, co prowadzi do ich częstszych fałszywych oskarżeń.

- Według badań NIST (National Institute of Standards and Technology) z 2019 roku:

- Algorytmy rozpoznawania twarzy wykazywały do 100 razy więcej fałszywych dopasowań dla osób czarnoskórych, azjatyckich i rdzennych Amerykanów niż dla osób białych.

- Niektóre systemy miały ponad 10% wskaźnik fałszywego odrzucenia dla osób z niektórych krajów afrykańskich.

- Wyniki błędnej identyfikacji płci z badania Gender Shades autorstwa Joy Buolamwini i Timnit Gebru (MIT Media Lab, 2018), które testowało komercyjne systemy rozpoznawania twarzy (Microsoft, IBM, Face++). Analiza dotyczyła klasyfikacji płci i koloru skóry:

Grupa Średni błąd klasyfikacji (%) Biali mężczyźni 0,8% Białe kobiety 7,0% Czarni mężczyźni 12,0% Czarne kobiety 34,7%

Niska skuteczność w warunkach rzeczywistych

Choć współczesne systemy osiągają bardzo niski poziom błędów (FNMR rzędu 0,01%) w kontrolowanych warunkach testowych (np. dobre oświetlenie, zdjęcia z baz danych), ich skuteczność drastycznie spada w warunkach rzeczywistych, takich jak nagrania z monitoringu, słabe oświetlenie, niska rozdzielczość czy dynamiczne tło.

Według raportu NIST z 2022 roku oraz badań akademicznych z 2023 (np. Terhörst et al.), wskaźnik błędów identyfikacji może wzrosnąć nawet do 20% w takich warunkach – co oznacza co piątą błędną decyzję.

Dodatkowo, niektóre badania wskazują, że algorytmy lepiej rozpoznają twarze wyrażające neutralne emocje niż te, które okazują złość, radość czy strach – co ma istotne znaczenie przy analizie nagrań z protestów czy zamieszek.

Narzędzie do masowej inwigilacji i kontroli społecznej

W rękach autorytarnych władz, technologia rozpoznawania twarzy może służyć nie do zapewnienia bezpieczeństwa, lecz do totalnej kontroli społeczeństwa. Systemy te mogą być wykorzystywane do śledzenia obywateli, tłumienia protestów, ograniczania swobód obywatelskich oraz manipulacji opinią publiczną.

Przykłady:

- Chiny – system SkyNet:

- Sieć ponad 570 milionów kamer oraz zaawansowane AI umożliwiają niemal całkowity nadzór nad ruchem społecznym.

- Technologia wykorzystywana do identyfikowania uczestników protestów, np. w Hongkongu.

- W połączeniu z systemem „Social Credit Score”, rozpoznawanie twarzy może wpływać na codzienne życie obywateli – np. ograniczać możliwość podróżowania lub dostępu do kredytów.

- Rosja: Technologia była używana do identyfikacji i represjonowania osób biorących udział w protestach społecznych, np. poprzez rozpoznawanie demonstrantów na podstawie zdjęć i nagrań.

Brak przejrzystości i odpowiedzialności

Wiele systemów wykorzystywanych obecnie nie działa w sposób transparentny. Brakuje mechanizmów kontroli, audytu, oraz dostępu obywateli do informacji, czy i kiedy ich dane były przetwarzane. Obywatele często nie są informowani, że są poddawani rozpoznaniu twarzy, a same dane są przechowywane bez ich zgody.

Przykład:

- Clearview AI zebrał miliardy zdjęć z mediów społecznościowych bez zgody użytkowników. WYnikiem byl pozew m.in od Francji na 20 mln EUR.

- W Unii Europejskiej organizacje zajmujące się ochroną danych osobowych (np. CNIL we Francji) wskazują na nielegalność niektórych metod zbierania i przechowywania danych twarzy w systemach takich jak Clearview.

Regulacje prawne

- Unia Europejska (projekt AI Act, 2024) zakłada ograniczenie stosowania FRT w przestrzeni publicznej do sytuacji wyjątkowych (np. poszukiwania zaginionych dzieci lub zapobieganie zamachom).

- USA (2024): nowe przepisy federalne zakazują aresztowań wyłącznie na podstawie dopasowania przez system FRT – wymagają manualnej weryfikacji przez człowieka i dodatkowych dowodów

Źródła:

- https://www.linkedin.com/pulse/decoding-origins-facial-recognition-who-first-3divi-company/

- https://pyimagesearch.com/2021/05/10/opencv-eigenfaces-for-face-recognition/

- Viola–Jones object detection framework – Wikipedia

- https://engineering.jhu.edu/vpatel36/wp-content/uploads/2018/08/janus_sps_magazine.pdf

- https://digit.site36.net/2024/12/16/new-police-technology-in-germany-unleashed-facial-recognition-takes-off/

- https://www.libertyhumanrights.org.uk/fundamental/facial-recognition/

- https://medium.com/@davidsehyeonbaek/skynet-project-in-china-the-rise-of-ubiquitous-surveillance-33fee53c350e

- https://www.bbc.com/news/technology-65057011