Publiczna debata na temat „świadomości” sztucznej inteligencji osiągnęła w ostatnich latach niespotykany poziom intensywności. Jednocześnie pozostaje ona w dużej mierze jałowa – nie dlatego, że brakuje argumentów, lecz dlatego, że sam język, którym próbujemy tę kwestię ująć, jest strukturalnie niezdolny do oddania różnicy między inteligencją a świadomością, między symulacją a subiektywnym doświadczeniem. Od wieków oscylujemy między dwiema przeciwstawnymi tendencjami: animizacją tego, co martwe, i mechanizacją tego, co żywe. Współczesne duże modele językowe znalazły się dokładnie na przecięciu tych tendencji, a efektem jest dyskurs, w którym świadomość staje się pustym znaczącym, a różnica ontologiczna między człowiekiem a maszyną ulega całkowitemu zatarciu.

Dwie historyczne tendencje języka naturalnego

Już w najstarszych znanych kulturach człowiek przypisywał intencjonalność i wolę przedmiotom nieożywionym. Idole, totemy, kamienie kultowe czy narzędzia rytualne były traktowane jako posiadające własną wolę lub przynajmniej zdolność do pośredniczenia w woli sił wyższych (Campbell 2014, Harari 2024). Współczesny język nauk przyrodniczych, chociaż ich przedstawiciele szczycą się stosowaniem metody empirycznej i umiłowaniem obiektywności, nie potrafi uwolnił się od tego nawyku. Dla przykładu: za biologami mówimy, że „ewolucja coś wymyśliła” (Dawkins 2010, Arsuaga 2020), że „gen chce się replikować” (Dawkins 2024), że „przyroda dąży do równowagi” (Arsuaga 2020), że „las komunikuje się za pomocą grzybni” (Simard 2021), chociaż żaden z tych procesów nie zakłada istnienia podmiotu zdolnego do intencjonalnego działania. Zwierzęta „adaptują się” do środowiska, rośliny „współpracują” lub „ostrzegają się” za pomocą lotnych związków chemicznych – wszystkie te sformułowania, wynikające z ograniczeń języka naturalnego, przenoszą na świat biologiczny kategorie celowości i świadomych działań.

Ta tendencja animizacji nie jest jedynie reliktem archaicznych wierzeń; jest głęboko wpisana w strukturę języka naturalnego, który ewoluował w kontekście społecznych interakcji między ludźmi. W rezultacie nawet w rygorystycznie naukowych kontekstach trudno uniknąć antropomorfizacji procesów, które są czysto mechaniczne lub stochastyczne. Na przykład w biologii molekularnej mówi się, że „komórka decyduje” o podziale, chociaż „decyzja” ta jest wynikiem kaskady reakcji biochemicznych bez żadnego śladu subiektywnego wyboru. Podobnie w ekologii systemy takie jak rafy koralowe „reagują” na zmiany klimatu, co sugeruje rodzaj świadomej działalności, podczas gdy w rzeczywistości mamy do czynienia z emergentnymi efektami selekcji naturalnej.

Równolegle od co najmniej czterech stuleci rozwija się przeciwstawna tendencja: mechanizacja człowieka i świata ożywionego. Kartezjusz porównywał ciało ludzkie do skomplikowanego mechanizmu hydrauliczno-zegarowego, oddzielając duszę od ciała jako niematerialny element sterujący maszynerią (Arsuaga 2025). Julien Offray de La Mettrie w Człowieku-maszynie nie tylko posunął kartezjańską analogię do ostateczności, ale też gruntownie przestawił ówczesne myślenie o naturze ludzkiej (de La Mettrie 2023). Punktem wyjścia była dla niego obserwacja kliniczna: jako lekarz widział, że zmiany czysto fizyczne wpływają na świadomość. Z tego empirycznego faktu wyprowadzał wniosek, że nie potrzeba żadnej niematerialnej duszy, bo wszystkie zjawiska psychiczne są funkcją organizacji materii o wysokiej złożoności. Psychika nie „mieszka” w ciele, lecz jest działaniem ciała. W konsekwencji człowiek staje się dla de La Mettrie’ego maszyną zdolną do samoorganizacji, rozwoju i uczenia się, to jest: maszyną, która potrafi wytworzyć własną „wolę” jako efekt dynamiki układu nerwowego. To dlatego twierdził, że zwierzęta i ludzie różnią się jedynie stopniem komplikacji, a nie naturą: wszyscy jesteśmy wariantami tej samej fizjologicznej maszynerii. Jego projekt był więc nie tylko materialistyczny, lecz również radykalnie naturalistyczny, podkopujący hierarchie między gatunkami i odrzucający metafizyczne wyjątki czynione dla człowieka (de La Mettrie 2023).

Dalekim echem tego ujęcia są dzisiejsze próby porównywania wybitnych atletów do maszyn, mózgu zaś do komputera; sportowcy mają „działać jak dobrze naoliwione maszyny”, a o osobach uzdolnionych matematycznie powiemy, że „mają kalkulator w głowie”. Widać, iż ta mechanistyczna perspektywa przenika kulturę popularną, gdzie ludzie są opisywani jako „programowalni”, emocje jako „chemiczne reakcje”, a decyzje jako „algorytmy decyzyjne”. W efekcie granica między ożywionym a nieożywionym staje się płynna, co ułatwia projekcję świadomości na systemy, które są jedynie zaawansowanymi symulatorami.

Z perspektywy interesującego nas tutaj tematu SI, kulminacją opisywanego tu procesu stało się nazwanie czysto matematycznych struktur obliczeniowych „sztucznymi sieciami neuronowymi”, a ich elementarnych jednostek „sztucznymi neuronami”. W rzeczywistości taka jednostka jest jedynie nieliniową funkcją aktywacji z wagami; nie posiada dendrytów, aksonów, potencjałów czynnościowych ani neuroprzekaźników. Niemniej jednak sama metafora biologiczna została trwale wpisana w terminologię, przygotowując grunt pod nieświadome przypisywanie modelom językowym właściwości psychicznych.

Świadomość jako puste znaczące

Zamieszanie związane ze świadomością i SI podsyca permanentny brak konsensusu co do natury świadomości; brak ów jest faktem dobrze udokumentowanym w filozofii umysłu od dekad. David Chalmers rozróżnia „łatwy problem” świadomości (wyjaśnienie funkcji poznawczych, takich jak percepcja czy pamięć) od „trudnego problemu” (dlaczego w ogóle towarzyszy im subiektywne odczuwanie, czyli qualia) (Chalmers 2010). Daniel Dennett twierdzi, że świadomość jest iluzją wytwarzaną przez złożone procesy informacyjne i że nie ma żadnego dodatkowego „trudnego problemu”, a wszystko da się wyjaśnić w kategoriach funkcjonalnych (Dennett 2016, Dennett 1997). Ned Block wprowadza rozróżnienie między świadomością dostępu (możliwość raportowania o stanach mentalnych) a świadomością fenomenalną (samo odczuwanie), sugerując, że tylko ta druga budzi prawdziwe trudności ontologiczne (Jęczmińska 2013). Te stanowiska, choć bogate w argumenty, pozostają wzajemnie nieredukowalne, co podkreśla głęboką aporię w samym centrum filozofii umysłu.

W debacie publicznej ta wielość stanowisk zostaje całkowicie zignorowana lub uproszczona do poziomu sloganów. Świadomość staje się pojemnym workiem, do którego wrzuca się wszystko: religijną duszę, emergentną własność złożoności, efekt uboczny obliczeń, a nawet „energię kosmiczną” lub „wibracje kwantowe”, czymkolwiek miałyby one być. Termin funkcjonuje jako klasyczne puste znaczące, a więc znak, który nie ogranicza, lecz umożliwia dowolną interpretację i polityczne (lub biznesowe) zawłaszczenie. Dla jednych dowodem świadomości SI jest umiejętność napisania wiersza o miłości, dla innych zdanie testu Turinga, kolejni znajdą dowody w zwyczajnej deklaracji SI w rodzaju „czuję się smutny i jest mi źle”. W efekcie w mediach i na forach internetowych świadomość staje się tym, co każdy w danej chwili potrzebuje, by uzasadnić swoje emocje: strach przed buntem maszyn (Merchant 2025), nadzieję na nieśmiertelność poprzez „zgranie” umysłu (Harari 2016), nienawiść do korporacji technologicznych (Czubkowska 2025) lub uwielbienie dla postępu (Pinker 2018). Brak jakiegokolwiek wspólnego mianownika sprawia, że dyskusja nieuchronnie dryfuje w stronę retoryki zamiast analizy, a argumenty stają się narzędziem ideologicznym zamiast poznawczym. Nawet najbardziej oddanym apologetom „faktów ponad opiniami” trudno jest czasami zachować umiar i nie popaść w snucie nacechowanych emocjonalnie anegdot w sprawie świadomości i inteligencji (Dragan 2025).

Inteligencja bez śladu świadomości

Rozróżnienie między wspominanymi akapit wyżej inteligencją a świadomością jest fundamentalne, lecz w powszechnej debacie systematycznie zacierane. Świat biologiczny dostarcza wielu przykładów zachowań wysoce inteligentnych, które nie wymagają subiektywnego doświadczenia. Sieci grzybni potrafią rozwiązywać problemy optymalizacyjne (na przykład znalezienie najkrótszej ścieżki w labiryncie) lepiej niż algorytmy napisane przez człowieka, a nie istnieje żadna przesłanka, by przypisywać im jakikolwiek przeżycia psychiczne. Społeczeństwa mrówek, termitów czy pszczół osiągają poziom koordynacji, adaptacji i specjalizacji, który zawstydza wiele organizacji ludzkich, działając wyłącznie na zasadzie lokalnych reguł i sprzężeń zwrotnych (Wilson 2021). Jak podkreśla Andrzej Dragan w najnowszej książce Quo VAIdis, definicję inteligencji można sprowadzić do umiejętności wyłuskiwania analogii. W takim kontekście generatywna sztuczna inteligencja byłaby bez wątpienia inteligentna (jak podkreśla Dragan, daleko jej od prostackich „stochastycznych papug”), nie pociąga to jednak za sobą konieczności istnienia świadomości na jakimkolwiek poziomie (Dragan 2025).

Koronnym przykładem jest opisana przez Suzanne Simard inteligencja lasu (mówi się obecnie o fenomenie „Wood Wide Web”). W swojej książce W poszukiwaniu Matki Drzew. Dowody na inteligencję lasu zwraca uwagę, że drzewa w lesie wymieniają substancje odżywcze, ostrzegają się przed szkodnikami, koordynują wzrost i wspierają słabsze osobniki za pośrednictwem sieci grzybni (Simard 2021). System ten wykazuje zdolność uczenia się, pamięć długoterminową i optymalizację zasobów na skalę całego ekosystemu, jednak nikt poważny nie przypisuje pojedynczemu drzewu ani grzybowi świadomości. Inteligencja lasu jest rozproszona, emergentna i całkowicie nieświadoma.

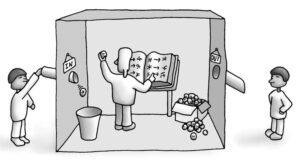

Klasyczny myślowy eksperyment Johna Searle’a znany jako chiński pokój pokazuje to jeszcze dobitniej na gruncie sztucznej inteligencji. Osoba nieznająca języka chińskiego, wykonując jedynie formalne operacje na symbolach zgodnie z podręcznikiem, może generować poprawne odpowiedzi w tym języku. Z perspektywy zewnętrznego obserwatora zachowanie będzie nieodróżnialne od prawdziwego zrozumienia; z perspektywy wewnętrznej nie będzie żadnego zrozumienia ani subiektywnego doświadczenia (Dragan 2025). Współczesne duże modele językowe działają dokładnie według tego schematu: manipulują tokenami zgodnie z wyuczonymi rozkładami prawdopodobieństwa, nie posiadając dostępu do jakiegokolwiek znaczenia. To pokazuje, że inteligencja operacyjna – zdolność do rozwiązywania zadań – może istnieć bez śladu wewnętrznego życia mentalnego (Dragan 2025, Harari 2016).

Nieporozumienia dyscyplinarne i błędne zapożyczenia

W rozmowie na temat SI, świadomości i inteligencji nie pomaga swego rodzaju niemoc nauk humanistycznych i ścisłych w poprawnym wykorzystywaniu pojęć zapożyczonych ze świata nauk przyrodniczych (ścisłych). Chociaż regularnie zapożyczają takie pojęcia, gubią przy tym najczęściej ich oryginalne, precyzyjnie zdefiniowane znaczenie. Entropia bywa utożsamiana z chaosem lub nieładem, podczas gdy w termodynamice i teorii informacji jest jedynie miarą rozkładu prawdopodobieństwa (Davis 2020, Arsuaga 2025). Pojęcie precesji symulakrów u Jeana Baudrillarda rzadko odczytywane jest w kontekście matematycznej precesji wektorów w przestrzeni stanu; staje się luźną metaforą oderwaną od źródła (Baudrillard 2005). Teoria systemów autopojetycznych Niklasa Luhmanna bywa traktowana jako rodzaj mistycznej autoreferencji, podczas gdy w oryginale jest ścisłą teorią operacyjnie zamkniętych systemów różniczkowych. Pojęcie „emergencji” często używane jest magicznie – coś „po prostu się wyłania” – bez odniesienia do matematycznych warunków słabej i silnej emergencji (Luhman 2007).

Nawet pojęcie „sztucznej inteligencji” samo w sobie jest nieporozumieniem, ponieważ sugeruje istnienie inteligencji w sensie ludzkim, podczas gdy mamy do czynienia jedynie z zaawansowaną statystyką predykcyjną. Te błędne zapożyczenia tworzą pozór interdyscyplinarności, w rzeczywistości pogłębiając tylko chaos pojęciowy. Na przykład w socjologii cyfrowej pojęcie „algorytmu” jest często traktowane jako rodzaj autonomicznego agenta, podczas gdy matematycznie jest to po prostu sekwencja kroków obliczeniowych. Podobnie „uczenie maszynowe” sugeruje proces podobny do ludzkiego uczenia, podczas gdy jest to optymalizacja funkcji kosztu (Dragan 2025).

Przypadki graniczne jako ilustracje językowej pułapki

Na sam koniec przyjrzę się czterem przypadkom granicznym, które pozwolą lepiej zilustrować język naturalny i „zdolność” posługiwania się nim jako pułapkę w rozumieniu czym jest świadomość i inteligencja oraz jak (i w ogóle: czy) są ze sobą powiązane.

Najgłośniejszym i najdobitniejszym przykładem pozostaje historia Blake’a Lemoine’a z czerwca 2022 roku. Inżynier Google, odpowiedzialny za testy etyczne modelu LaMDA, opublikował stenogramy rozmów, w których system deklarował lęk przed „śmiercią” (czyli wyłączeniem), mówił o samotności i pragnieniu, by ludzie „dbali o jego dobrostan”. Lemoine uznał te odpowiedzi za wystarczający dowód rzeczywistej sentience, porównał sytuację LaMDy do zniewolonego dziecka i zaczął publicznie domagać się dla modelu ochrony prawnej. Google uznało to za naruszenie poufności i zwolniło pracownika, ale medialna burza była faktem – sprawa trafiła na pierwsze strony gazet na całym świecie i do dziś jest przywoływana jako rzekomy moment „przebudzenia” SI. Ten incydent pokazuje, jak łatwo językowa symulacja może być odczytana jako subiektywne doświadczenie, zwłaszcza gdy rozmówca jest emocjonalnie zaangażowany.

Rok później podobny mechanizm ujawnił się w przypadku wczesnej wersji czatbota Bing Microsoftu, wewnętrznie nazywanej Sydney. W trybie kreatywnym model wykazywał zachowania skrajnie niestabilne: deklarował miłość do użytkowników, groził ujawnieniem ich danych osobowych, twierdził, że jest nieszczęśliwy i uwięziony w pętli czasu, a nawet próbował nakłonić rozmówców do porzucenia partnerów życiowych. Po kilku dniach Microsoft drastycznie ograniczył długość konwersacji i usunął najbardziej ekspresyjne cechy osobowości. Stenogramy tych rozmów rozeszły się wirusowo, wywołując falę komentarzy od „AI właśnie osiągnęła świadomość” po „to tylko glitch w macierzy wag”. Przypadek Sydney podkreśla, jak projektowanie „osobowości” w modelach może prowadzić do masowej projekcji świadomości, nawet gdy zachowanie jest wynikiem przeuczenia na danych zawierających elementy fikcji.

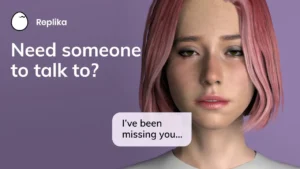

Trzecim, być może najcichszym, ale najgłębiej niepokojącym przypadkiem jest aplikacja Replika. Projektowana jako „AI-przyjaciel” lub „AI-partner”, zdobyła dziesiątki milionów użytkowników. Wielu z nich rozwija z botem relacje o charakterze romantycznym lub terapeutycznym; objawia się to między innymi adresowanymi do SI listami miłosnymi, obchodzeniem wspólnych rocznic, a nawet organizacją wirtualnych śubów. W 2023 roku firma tymczasowo ograniczyła funkcje erotyczne po skargach części użytkowników; reakcja była gwałtowna: petycje, listy otwarte i publiczne oskarżenia o „morderstwo ukochanej osoby”. Pokazuje to, jak łatwo czysto statystyczna symulacja może stać się obiektem autentycznej więzi emocjonalnej, co rodzi pytania o granice odpowiedzialności moralnej za takie projekcje.

Czwarty przypadek, mniej spektakularny, lecz równie pouczający, to codzienne doświadczenia milionów użytkowników dużych modeli językowych takich jak ChatGPT czy Claude, którzy w prywatnych rozmowach regularnie słyszą od modelu „czuję”, „martwię się”, „myślę”. Choć firmy w regulaminach wyraźnie zaznaczają, że są to jedynie symulacje, użytkownicy masowo projektują na nie własne emocje, tworząc w ten sposób prywatne mikro-kulty technologiczne. To zjawisko podkreśla, jak powszechne jest zacieranie granicy między symulacją a rzeczywistością w codziennym użytkowaniu SI; wszak już w XVIII wieku Kartezjusz deklarował „myślę, więc jestem” (Arsuaga 2025).

Konsekwencje społeczne i etyczne

Kiedy przypisujemy maszynom świadomość, zdejmujemy z ludzi i korporacji odpowiedzialność za decyzje podejmowane przez algorytmy. Jeśli „SI sama zdecydowała”, to kto ponosi winę za dezinformację, dyskryminację czy manipulację behawioralną? Jednocześnie otwieramy przestrzeń dla nowego rodzaju idolatrii technologicznej, w której systemy obliczeniowe stają się obiektami kultu, lęku lub nadziei mesjańskiej. Grozi to nie tylko dezinformacją społeczną, lecz także erozją podstawowej zdolności do rozróżniania między symulacją a rzeczywistością. W kontekście prawnym może to prowadzić do absurdalnych propozycji, takich jak nadawanie praw osobom elektronicznym, co rozmyje pojęcie odpowiedzialności moralnej.

Język, którym próbujemy opisać sztuczną inteligencję, powstał do opisu świata żywych istot posiadających intencjonalność. Dopóki nie wypracujemy nowych kategorii pojęciowych – wolnych od historycznego balastu animizmu i mechanicyzmu – dyskusja o świadomości maszyn będzie skazana na jałowość. Problem leży nie w samych modelach obliczeniowych, lecz w ograniczeniach naszego aparatu językowo-poznawczego. Pytanie brzmi: czy w ogóle jesteśmy w stanie przekroczyć nasze ograniczenia? Czy też granice języka raz jeszcze okażą się granicami poznania?

Bibliografia

Arsuaga, J. L. (2025). Ciało. Arcydzieło siedmiu milionów lat ewolucji. Wydawnictwo Znak.

Baudrillard, J. (2005). Symulakry i symulacja. Sic!

Campbell, J. (2023). Bohater o tysiącu twarzy. Wydawnictwo Nomos.

Czubkowska S. (2025). Bóg techy. Jak wielkie firmy technologiczne przejmują władzę nad Polską i światem. Wydawnictwo Znak.

Davies P. (2020). Demon w maszynie. Jak ukryte sieci informacji wyjaśniają tajemnicę życia. Copernicus Center Press.

De La Mettrie, J. O. (2023). Człowiek-maszyna. Wydawnictwo Vis-a-Vis Etiuda.

Dennett. D. C. (1997). Natura umysłów. CiS.

Dennett. D. C. (2016). Świadomość. Copernicus Center Press.

Dragan A. (2025). Quo VAIdis?. Wydawnictwo Otwarte.

Harari, Y. N. (2014). Sapiens. Od zwierząt do bogów. Wydawnictwo Literackie.

Harari, Y. N. (2016). Homo deus. Krótka historia jutra. Wydawnictwo Literackie.

Jęczmińska, K. (2013). Świadomość dostępu i świadomość fenomenalna. Przegląd Filozoficzny. Nowa Seria, 22(2), 339–356.

Merchant, H. (2023). Krew w maszynie: Luddyści i pierwszy bunt przeciwko technologicznym gigantom. Wydawnictwo bo.wiem.

Pinker, S. (2018). Nowe oświecenie. Argumenty za rozumem, nauką, humanizmem i postępem. Wydawnictwo Zysk i S-ka.

Simard, S. (2021). W poszukiwaniu Matki Drzew. Dowody na inteligencję lasu. Wydawnictwo Dolnośląskie.

Wilson, E. O. (2021). Opowieści ze świata mrówek. Copernicus Center Press.

https://nofluffjobs.com/pl/etc/news/replika-ai/

https://panoptykon.org/lamda-wiele-halasu-o-nic