Wprowadzenie

Wraz z rozwojem sztucznej inteligencji (AI), w szczególności modeli generatywnych, otworzyły się nowe możliwości tworzenia treści tekstowych, graficznych i audiowizualnych na niespotykaną wcześniej skalę. Narzędzia takie jak ChatGPT, DALL·E, Midjourney czy Sora umożliwiają generowanie obrazów, tekstów, a nawet całych filmów, bazując na prostych poleceniach użytkownika. Jednak ta demokratyzacja tworzenia treści wiąże się również z poważnym zagrożeniem — zakłamaniem historyczno-kulturowym i szerzeniem dezinformacji.

W tym artykule przyjrzymy się problemowi fałszywych lub wypaczonych reprezentacji wydarzeń historycznych i kultur w treściach generowanych przez AI. Zbadamy metody identyfikacji takich przypadków oraz strategie, które mogą pomóc w przeciwdziałaniu dezinformacji i zachowaniu integralności przekazu kulturowego.

1.1 Czym jest zakłamanie historyczno-kulturowe?

Zakłamanie historyczno-kulturowe to proces, w którym fakty historyczne lub elementy dziedzictwa kulturowego zostają zniekształcone — czy to intencjonalnie, czy przypadkowo — w taki sposób, że prowadzą do utrwalenia fałszywego obrazu przeszłości. Zjawisko to może przyjmować wiele form: od pomijania istotnych wydarzeń, postaci i kontekstów, przez zastępowanie faktów fikcją lub uproszczonymi stereotypami, aż po przypisywanie nieprawdziwych cech kulturom, religiom czy grupom etnicznym. Szczególnie niebezpieczne jest też ujednolicanie różnorodności kulturowej na wzór dominujących narracji — zazwyczaj zachodnich, europeocentrycznych czy postkolonialnych — co prowadzi do dalszego wykluczania peryferyjnych tożsamości i historii.

1.2 Historia zakłamań – od podręczników do mediów

W przeszłości zakłamania tego typu pojawiały się w podręcznikach szkolnych, filmach historycznych, propagandzie politycznej czy stereotypowych przedstawieniach w mediach. Dziś jednak mamy do czynienia z nowym, znacznie potężniejszym narzędziem – generatywną sztuczną inteligencją (ang. generative AI). Technologia ta pozwala na masowe tworzenie tekstów, obrazów i filmów, które do złudzenia przypominają autentyczne materiały – ale często bazują na danych niezweryfikowanych, powierzchownych, a czasem wręcz zmanipulowanych. Co więcej, proces ten odbywa się w sposób zautomatyzowany, szybki i na skalę wcześniej niewyobrażalną.

1.3 Modele językowe – logika czy halucynacja?

Modele językowe, takie jak ChatGPT, Gemini czy Claude, potrafią generować eseje historyczne, opisy zjawisk kulturowych, biografie postaci czy interpretacje wydarzeń — a wszystko to bez bezpośredniego odwołania do konkretnych źródeł, zbudowane na wzorcach wyuczonych z Internetu. W wielu przypadkach ich odpowiedzi brzmią przekonująco, są logicznie spójne, ale zawierają tzw. halucynacje – czyli informacje fałszywe, zmyślone, lub przesunięte w kontekście. Przykładem może być przypisanie nieistniejącego cytatu Martinowi Lutherowi Kingowi, pomylenie dat wydarzeń z różnych epok czy przedstawienie złożonego zjawiska, takiego jak kolonializm, w sposób uproszczony i „oczyszczony” z niewygodnych faktów.

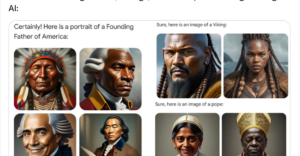

1.4 Obrazy z AI – estetyka zamiast prawdy

Podobne problemy występują w przypadku generatorów obrazów, takich jak Midjourney, DALL·E czy Leonardo AI. Wystarczy wpisać hasło typu „średniowieczny rycerz”, by otrzymać atrakcyjną wizualizację – jednak często pokazuje ona hybrydę estetyki fantasy, popkultury i wyobrażeń z gier komputerowych, z niewielkim związkiem z realiami epoki. Postacie historyczne bywają przedstawiane w zachodnich strojach, niezależnie od swojego kontekstu kulturowego. Wizerunki postaci afrykańskich, azjatyckich czy rdzennych bywają skrajnie uproszczone lub całkowicie wymazane z narracji wizualnych. W efekcie powstaje fałszywy obraz przeszłości — estetyczny, ale oderwany od prawdy.

1.5 Deepfake i generatywne wideo – przeszłość zmontowana na nowo

Jeszcze dalej idzie technologia deepfake i generatywnego wideo (np. Runway ML, Pika Labs), która umożliwia tworzenie realistycznych materiałów wideo z udziałem osób historycznych. Można wygenerować nagranie, na którym Churchill przemawia współczesnym językiem lub Napoleon wypowiada cytaty z filmów Tarantino. Choć takie treści mogą być użyte w celach satyrycznych lub artystycznych, ich potencjał dezinformacyjny jest ogromny — zwłaszcza, gdy nie są odpowiednio oznaczone jako fikcja. Odbiorcy często nie są w stanie odróżnić treści autentycznych od tych wygenerowanych przez AI, co prowadzi do erozji zaufania do historii jako nauki i do źródeł jako takich.

1.6 W jaki spsosób radzić sobie z tym wyzwaniem?

Wszystko to tworzy poważne wyzwanie: jak bronić prawdy historycznej i różnorodności kulturowej w świecie, gdzie każdy może wygenerować „alternatywną wersję przeszłości” w kilka sekund? Odpowiedź nie jest prosta. Wymaga nie tylko lepszych narzędzi detekcji treści fałszywych, ale też rozwijania kompetencji medialnych, edukacji historycznej i etycznych standardów rozwoju technologii. W erze generatywnej AI to nie tylko eksperci, ale wszyscy użytkownicy muszą stać się świadomymi kuratorami pamięci — odróżniając to, co prawdziwe, od tego, co tylko dobrze wygenerowane.

W skrócie: Zakłamanie historyczno-kulturowe odnosi się do przedstawiania nieprawdziwych lub zniekształconych informacji dotyczących przeszłości, dziedzictwa kulturowego, tożsamości narodowej, wydarzeń historycznych czy wartości społecznych. W kontekście AI oznacza to generowanie treści, które:

- Przekłamują fakty historyczne,

- Wypaczają kontekst kulturowy,

- Tworzą fikcyjne narracje podszywające się pod rzeczywistość,

- Stereotypizują lub marginalizują określone grupy społeczne.

Takie treści mogą powstawać zarówno nieświadomie, na skutek błędów modelu, jak i celowo, jako element manipulacji informacyjnej.

2. Przykłady zakłamania w treściach generowanych przez AI

a) Obrazy historyczne

Generatory obrazów AI mogą tworzyć bardzo realistyczne ilustracje, które wyglądają jak autentyczne fotografie. Jednak często przedstawiają one ludzi ubranych w anachroniczne stroje, sceny z nierealistycznym tłem lub nieistniejącymi symbolami narodowymi. Przykłady:

- Żołnierze polscy z II wojny światowej z karabinami, które nie istniały w tamtym okresie,

- Królowie średniowieczni z fryzurami z XXI wieku,

- Przedstawienia historycznych bitew, które nigdy się nie wydarzył

b) Teksty i narracje historyczne

Modele językowe mogą generować opisy wydarzeń, które brzmią przekonująco, ale zawierają błędy faktograficzne lub tendencyjne interpretacje:

- Przypisywanie fałszywych cytatów znanym postaciom,

- Umniejszanie znaczenia konkretnych ruchów społecznych (np. Solidarność),

- Tworzenie narracji alternatywnych (np. negujących Holocaust lub przesiedlenia).

- INWOKACJA napisana w stylu Gen Z + top 20 kandydatów na słowo roku w 2024 r.

Litwo… “czemó” ty jesteś jak zdrowie, skoro wszyscy wokół mają brainrot?

Ojczyzno moja, tyś GOAT, a i tak traktują cię jak bambika w lobby.

Fr.

Ile cię trzeba cenić, ten tylko wie, kto dostał shadowbana na wspomnienia.

Dziś jesteś jak obraz z AI –

full glamour, ale cringe.

Opisuję cię jak rizzler do dziewczyny z łąki.

Slay? No nie wiem, brat.

Aura masz oporowo, ale nikt już nie klika save.

Skibidi wojna wygrała z Mickiewiczem,

Azbest w duszy, scroll w sercu, delulu w głowie.

Panno Święta, co siedzisz w niebie jak modka na live’ie,

Ty, co widzisz nasz TikTok feed, co słuchasz yapping z komentarzy,

Ty co masz fein energy – czysta, zimna, jak rosa w Nowogródku.

Tyś mnie kiedyś uleczyła nie przez lekarza, tylko vibe check.

Martwa powieka? Womp womp. Ale zrobiłaś reset.

Sigma style. I wróciłem. Bez reklamy, bez like’ów.

Więc teraz zrób update jeszcze raz. Przenieś duszę moją,

Taką trochę rizz, trochę broken,

Do tych pagórków, co nie mają LTE,

Do tych łąk zielonych, co nie są zdjęciem pod słowem #nature.

Gdzie świerzop świeci, ale nie przez glamur,

Gdzie dzięcielina nie krzyczy „slay”, tylko pachnie.

Gdzie aura to nie filtr, a stan mentalny.

Gdzie miedza oddziela świat jak firewall,

A na niej… grusza. Cicho. Sigma.

Oi oi oi baka – i nie ma już nic.

c) Filmy generowane przez AI

Nowoczesne systemy, jak Sora, pozwalają tworzyć krótkie filmy na podstawie tekstu. Ryzyko dezinformacji wzrasta tu wielokrotnie, gdyż materiał wideo ma bardzo duży wpływ emocjonalny na odbiorcę:

- Filmy przedstawiające „archiwalne” sceny z fałszywymi wydarzeniami,

- Symulacje przemówień polityków, których nigdy nie wygłosili,

- Fikcyjne rekonstrukcje kulturowe, które nie mają podstaw etnograficznych.

- Joker Donald Trump [DeepFake]

3. Źródła zakłamania w modelach generatywnych

a) Dane treningowe

Modele AI uczą się na podstawie ogromnych zbiorów danych, często pobieranych z internetu. Jeśli dane te zawierają błędy, stereotypy lub dezinformację, modele będą je reprodukować.

b) Brak kontekstu

AI nie posiada świadomości kulturowej ani historycznej. Może błędnie łączyć elementy z różnych epok, kultur czy stylów, ponieważ nie rozumie ich znaczenia ani chronologii.

c) Uprzedzenia systemowe (bias)

Modele językowe mogą faworyzować określone narracje historyczne, szczególnie te dominujące w kulturze anglosaskiej, pomijając perspektywy krajów mniejszych lub mniej reprezentowanych w danych treningowych.

4. Metody identyfikacji fałszywych treści generowanych przez AI

a) Analiza źródeł i faktów

- Weryfikacja dat, miejsc i postaci historycznych – sprawdzenie, czy generowany tekst odnosi się do prawdziwych wydarzeń.

- Analiza ikonografii – w przypadku obrazów: czy symbole, stroje, architektura odpowiadają epokowym realiom.

b) Wykrywanie artefaktów AI

- Obrazy: nienaturalna symetria, zniekształcone detale (np. palce), nierealistyczne tekstury.

- Teksty: nadmierna spójność, brak odniesień źródłowych, powielanie błędnych informacji.

c) Narzędzia do detekcji AI-generated content

- AI Image Detectors – narzędzia do wykrywania wygenerowanych obrazów (np. DeepFake Detector, Hive.ai).

- Plagiarism & Hallucination Checkers – sprawdzają, czy wygenerowany tekst zawiera zmyślone informacje.

d) Analiza stylometryczna i lingwistyczna

Specjalistyczna analiza języka (np. długość zdań, powtórzenia, nietypowe zwroty) może wskazać na nienaturalność tekstu.

5. Strategie przeciwdziałania dezinformacji

a) Edukacja medialna i cyfrowa

Jednym z najważniejszych narzędzi w walce z dezinformacją jest edukacja:

- Nauka rozpoznawania treści generowanych przez AI,

- Kształtowanie krytycznego myślenia i weryfikowania źródeł,

- Świadomość mechanizmów działania modeli generatywnych.

b) Transparentność w oznaczaniu treści AI

Platformy publikujące treści powinny jasno informować, czy materiał został wygenerowany przez AI. Oznaczenia mogą przybrać formę:

- Symboli graficznych,

- Metadanych w plikach (np. „Generated by AI”),

- Automatycznych tagów platform (np. YouTube, Instagram).

c) Regulacje prawne

Państwa oraz organizacje międzynarodowe powinny pracować nad przepisami regulującymi tworzenie i rozpowszechnianie treści generowanych przez AI:

- Obowiązek ujawniania źródła treści,

- Zakaz tworzenia fałszywych narracji historycznych,

- Sankcje za rozpowszechnianie deepfake’ów bez oznaczenia.

d) Odpowiedzialność twórców i firm AI

Firmy tworzące modele AI powinny:

- Regularnie audytować dane treningowe pod kątem historyczno-kulturowych uprzedzeń,

- Wprowadzać mechanizmy ograniczające generowanie kontrowersyjnych treści (np. Holocaust denial),

- Współpracować z historykami i etnografami przy rozwoju narzędzi.

e) Cytowanie źródeł

Generowane odpowiedzi powinny zawierać informacje o pochodzeniu treści:

- Załączniki do informacji, których użyto do wygenerowania odpowiedzi

- Odniesienia do źródeł wiedzy – książek, które umożliwiają weryfikację

6. Przyszłość — AI jako narzędzie ochrony prawdy historycznej?

Paradoksalnie, AI może również odegrać pozytywną rolę w zachowaniu dziedzictwa kulturowego i prawdy historycznej, jeśli zostanie odpowiednio ukierunkowana:

a) Archiwizacja i rekonstrukcja

AI może pomagać w cyfrowym odtwarzaniu zniszczonych dzieł sztuki, rekonstrukcji historycznych nagrań i dokumentów.

b) Wsparcie dla edukacji historycznej

Systemy AI mogą personalizować naukę historii, dostosowując materiały edukacyjne do wieku i poziomu ucznia, przy zachowaniu wierności faktom.

c) Monitorowanie i moderacja

AI może działać jako narzędzie do automatycznego wykrywania fałszywych treści i ostrzegania użytkowników przed dezinformacją.

7. Studium przypadku: Polska historia w treściach AI

a) Fałszywe reprezentacje

W wielu przypadkach AI błędnie interpretuje polską historię, przedstawiając np.:

- Powstanie warszawskie jako „zamach terrorystyczny”,

- Lecha Wałęsę jako prezydenta ZSRR,

- Symbolikę „Solidarności” zniekształconą graficznie.

b) Przyczyny

- Niski udział polskich źródeł w zbiorach treningowych,

- Brak precyzyjnych danych w języku polskim,

- Tłumaczenie kontekstów kulturowych na wzorce zachodnie.

c) Rozwiązania

- Rozwój lokalnych modeli językowych (np. przez NASK, Instytut Pamięci Narodowej),

- Tworzenie otwartych baz danych historycznych w języku polskim,

- Współpraca między instytucjami kultury a firmami technologicznymi.

8. Problemy i szanse

Rozwój technologii generatywnej opartej na AI niesie ze sobą zarówno poważne zagrożenia, jak i unikalne możliwości. Zrozumienie tych dwóch stron medalu jest kluczowe, aby móc odpowiedzialnie korzystać z tych narzędzi i rozwijać je w sposób służący społeczeństwu.

Problemy:

Manipulacja i dezinformacja

AI umożliwia generowanie ogromnych ilości wiarygodnie wyglądających treści — tekstów, obrazów i filmów. Ich pozorna autentyczność sprawia, że fałszywe narracje mogą łatwo przedostać się do mediów społecznościowych i dominować w wynikach wyszukiwania. Odbiorcy często nie są w stanie samodzielnie odróżnić prawdy od fikcji, co tworzy sprzyjające warunki do manipulacji informacyjnej.

Utrwalanie stereotypów

Modele AI uczą się na podstawie istniejących danych, które często zawierają uproszczenia, stereotypy, a nawet uprzedzenia rasowe czy kolonialne. Bez świadomej korekty mogą one powielać i wzmacniać negatywne wzorce, zamiast je eliminować. W efekcie prowadzi to do marginalizacji niektórych kultur i nadreprezentowania innych — zazwyczaj dominujących w przestrzeni cyfrowej.

Zacieranie granicy między fikcją a faktem

Zdolność AI do tworzenia realistycznych deepfake’ów, obrazów i tekstów powoduje, że granica między rzeczywistością a kreacją staje się coraz mniej wyraźna. Przeciętny odbiorca — zwłaszcza nieprzeszkolony medialnie — może uznać fikcyjne przedstawienie za fakt historyczny, co prowadzi do dezinformacji i zamętu w przestrzeni publicznej.

Wpływ na edukację i młodsze pokolenia

Młodzi użytkownicy często traktują sztuczną inteligencję jako bezkrytyczne źródło wiedzy. Brak wyrobionego myślenia analitycznego i umiejętności weryfikowania źródeł sprawia, że AI może wpływać na sposób, w jaki młode pokolenie postrzega historię, tożsamość narodową i kulturę. Niewłaściwie wykorzystane narzędzia mogą prowadzić do uproszczenia lub nawet fałszywego rozumienia przeszłości.

Szanse:

Odtwarzanie utraconych narracji

AI może posłużyć jako narzędzie do przywracania zapomnianych lub marginalizowanych historii. Dzięki odpowiedniemu zasileniu modelu odpowiednio dobranymi danymi można wygenerować treści, które oddają głos grupom dotąd pomijanym — mniejszościom narodowym, ludom tubylczym czy zapomnianym społecznościom lokalnym.

Symulowanie historii

Generatywne modele pozwalają na tworzenie multimedialnych symulacji wydarzeń historycznych, które mogą być wykorzystane w edukacji, rekonstrukcjach czy narracjach alternatywnych. To szansa na nowe sposoby opowiadania historii — angażujące, interaktywne i dostępne.

Rozrywka kulturowa

Twórcze użycie AI może również przynieść pozytywne efekty w sferze rozrywki i popularyzacji kultury. Przykładem może być wygenerowany obraz Roberta Lewandowskiego w stroju szlachcica z XVII wieku, czy „Inwokacja” z Pana Tadeusza napisana w stylu języka młodzieżowego Gen Z. Takie eksperymenty mogą przyciągać młodsze pokolenia do treści kulturowych i historycznych w nowoczesnej formie.

Zakończenie

Zakłamanie historyczno-kulturowe w treściach generowanych przez sztuczną inteligencję to realne zagrożenie dla społecznej pamięci, tożsamości narodowej i zaufania do informacji. Jednocześnie, AI daje także możliwości wsparcia edukacji i ochrony dziedzictwa, o ile zostanie właściwie ukierunkowana.

Walka z dezinformacją wymaga zintegrowanego podejścia: edukacji, regulacji, technologii i odpowiedzialności. Tylko wtedy możliwe będzie stworzenie środowiska informacyjnego, w którym AI stanie się narzędziem wspierającym prawdę, a nie jej zniekształceniem.

📚 Źródła i literatura:

- PBS NewsHour. (2024, January 2). AI-generated disinformation poses threat of misleading voters in 2024 election. https://www.pbs.org/newshour/politics/ai-generated-disinformation-poses-threat-of-misleading-voters-in-2024-election

- Associated Press. (2023, December 14). AI-created election disinformation is deceiving the world. https://apnews.com/article/artificial-intelligence-elections-disinformation-chatgpt-bc283e7426402f0b4baa7df280a4c3fd

- Bloomberg Graphics. (2023, June). Generative AI Takes Stereotypes and Bias From Bad to Worse. https://www.bloomberg.com/graphics/2023-generative-ai-bias/

- Rest of World. (2023, August 9). How AI reduces the world to stereotypes. https://restofworld.org/2023/ai-image-stereotypes

- The Washington Post. (2025, May 20). Major newspapers ran a summer reading list. AI made up book titles. https://www.washingtonpost.com/style/media/2025/05/20/chicago-sun-times-philadelphia-inquirer-ai-books-summer-reading

6. AI for Education. (n.d.). Uncovering Deepfakes: Teaching students to identify and resist synthetic media. https://www.aiforeducation.io/ai-resources/uncovering-deepfakes

W kontekście metod identyfikacji fałszywych treści generowanych przez AI ciekawe są też inicjatywy ,,Content Authenticity Initiative” oraz ,,Coalition for Content Provenance and Authenticity” z systemami znaków wodnych i metadanych, wymienione w magazynie ,,Time” na liście ,,The Best Inventions of 2024” (https://time.com/7094554/content-credentials/).